【用嘴 P 图神器!】一键部署 In-Context Edit,高效完成图像编辑

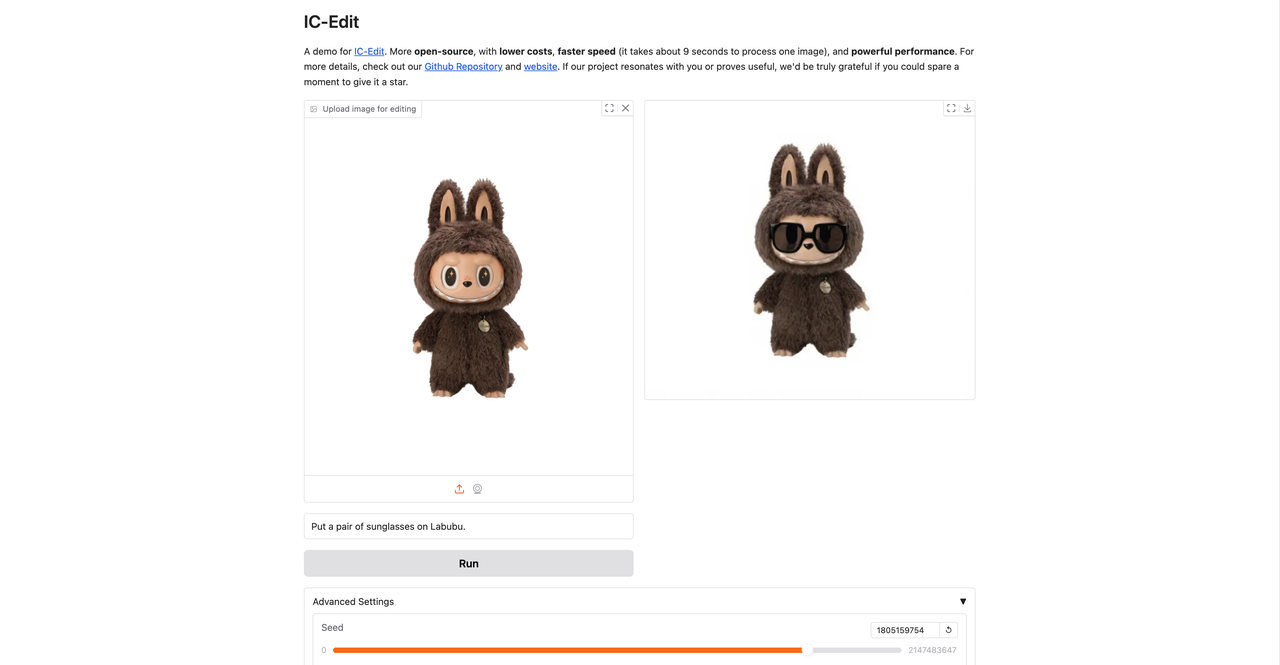

与以前的方法相比,ICEdit 只有 1% 的可训练参数(200 M)和 0.1% 的训练数据(50 k),表现出强大的泛化能力,能够处理各种编辑任务。上传一张 Labubu 首领 Zimomo 的图片,输入 prompt 「put a pair of sunglasses on Labubu」后点击「Run」,可以看到它快速生成了一张带着墨镜的 Labubu。点击「继续执行」,等待分配资源。首先

In-Context Edit 是由浙江大学和哈佛大学于 2025 年 4 月 29 日发布的一款基于指令的图像编辑的高效框架。相关论文成果为「In-Context Edit: Enabling Instructional Image Editing with In-Context Generation in Large Scale Diffusion Transformer」。

与以前的方法相比,ICEdit 只有 1% 的可训练参数(200 M)和 0.1% 的训练数据(50 k),表现出强大的泛化能力,能够处理各种编辑任务。与 Gemini、GPT4o 等商用模型相比,更加开源,成本更低,速度更快,性能强大 。

教程链接:https://go.openbayes.com/W9Om9

使用云平台: OpenBayes

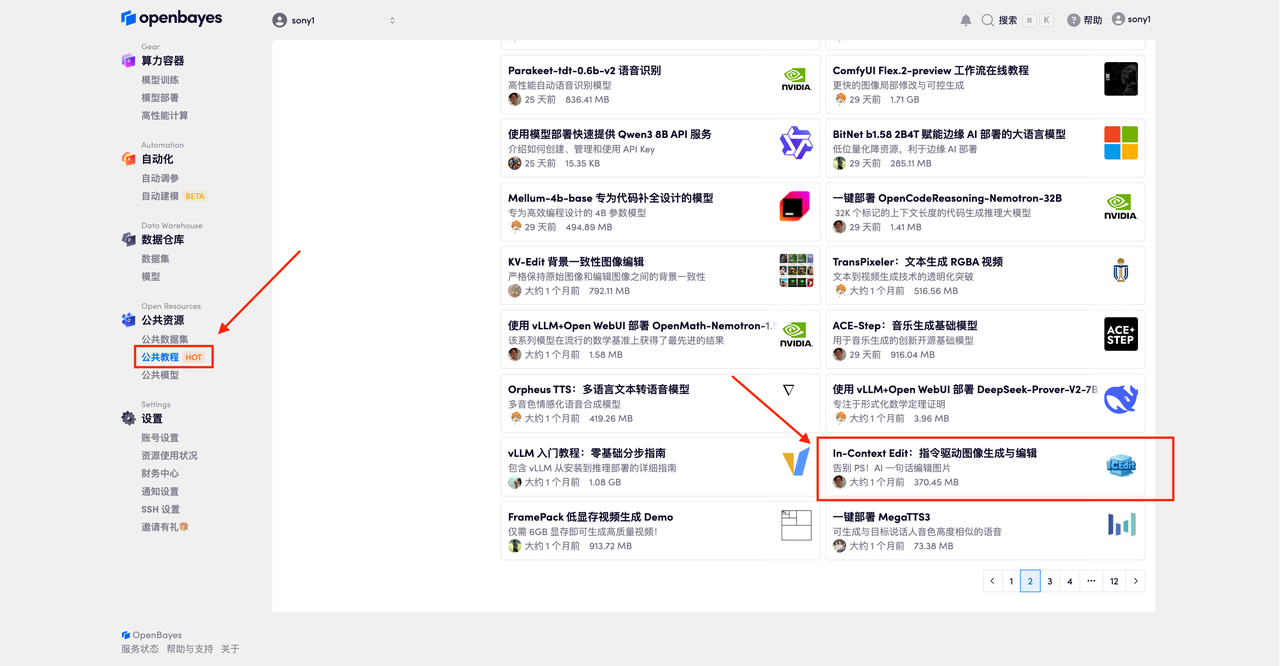

首先点击「公共教程」,在公共教程中找到「In-Context Edit:指令驱动图像生成与编辑」,单击打开。

页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

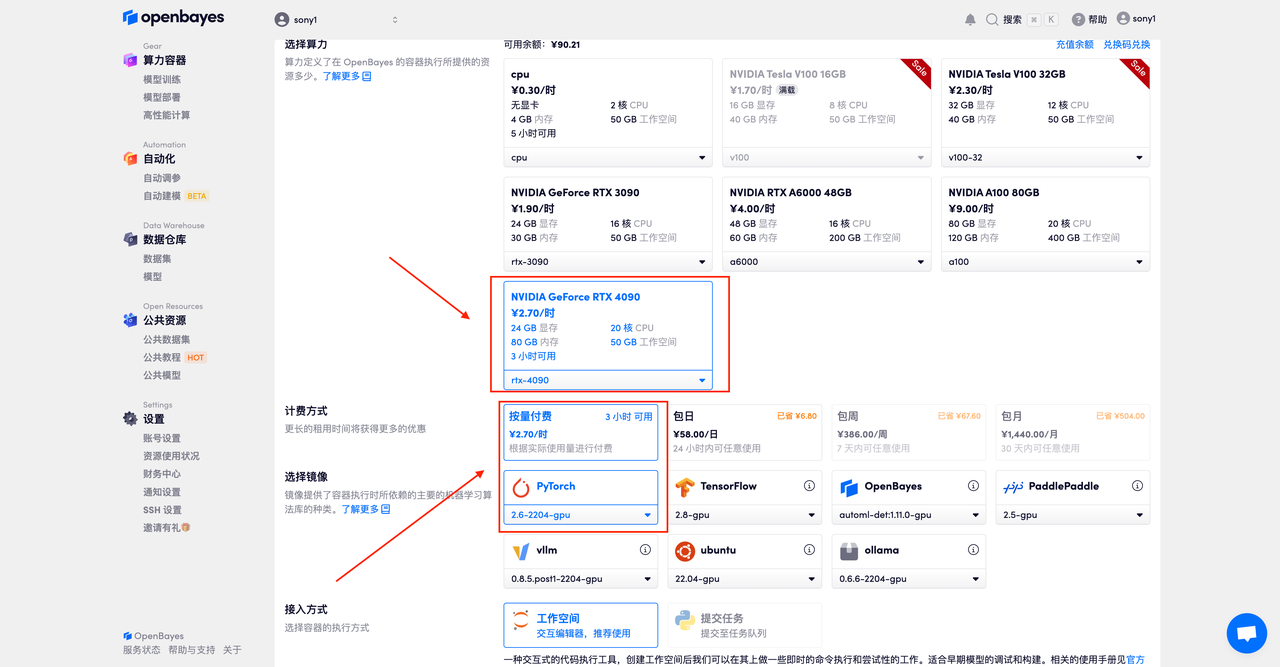

在当前页面中看到的算力资源均可以在平台一键选择使用。平台会默认选配好原教程所所使用的算力资源、镜像版本,不需要再进行手动选择。点击「继续执行」,等待分配资源。

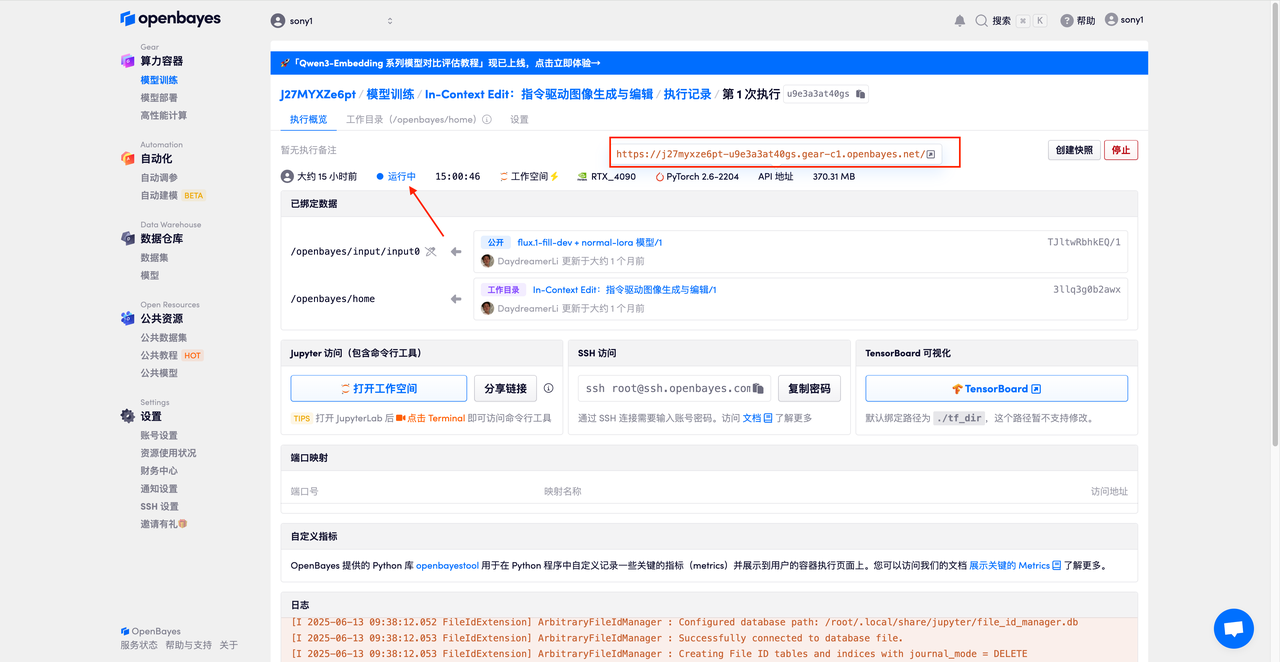

数据和代码都已经同步完成了。容器状态显示为「运行中」后,点击「 API 地址」,即可进入对话界面。

❗️重要的使用技巧:

-

Guidance Scale: 它用于控制生成模型中条件输入(如文本或图像)对生成结果的影响程度。较高的指导值会让生成结果更加 贴近输入条件,而较低的值会保留更多随机性。

-

Number of inference steps: 表示模型的迭代次数或推理过程中的步数,代表模型用于生成结果的优化步数。更高的步数通常会生成更精细的结果,但可能增加计算时间。

-

Seed: 随机数种子,用于控制生成过程中的随机性。相同的 Seed 值可以生成相同的结果(前提是其他参数相同),这在结果复现中非常重要。

上传一张 Labubu 首领 Zimomo 的图片,输入 prompt 「put a pair of sunglasses on Labubu」后点击「Run」,可以看到它快速生成了一张带着墨镜的 Labubu。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)