DeepSeek R1 本地部署 & idea集成,太酷啦

DeepSeek R1 本地部署 & idea集成,太酷啦

·

DeepSeek R1 本地部署 & idea集成,太酷啦

使用DeepSeek本地部署可以避免服务器卡顿的问题,具体操作分两步:

下载olama框架,用于管理LLM大模型

官网下载:在 macOS 上下载 Ollama - Ollama 框架

夸克网盘:

链接:https://pan.quark.cn/s/9acfa6aa257d

提取码:DpMy

下载完成会显示在最小化图标窗口

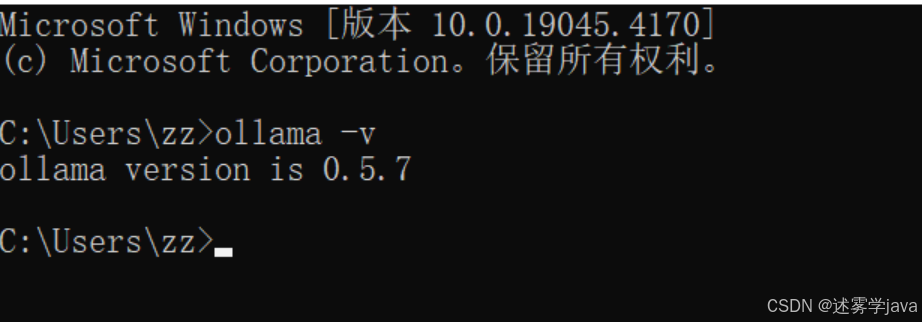

安装完成后打开命令行窗口执行ollama -v,看是否有版本信息,有版本信息则安装成功

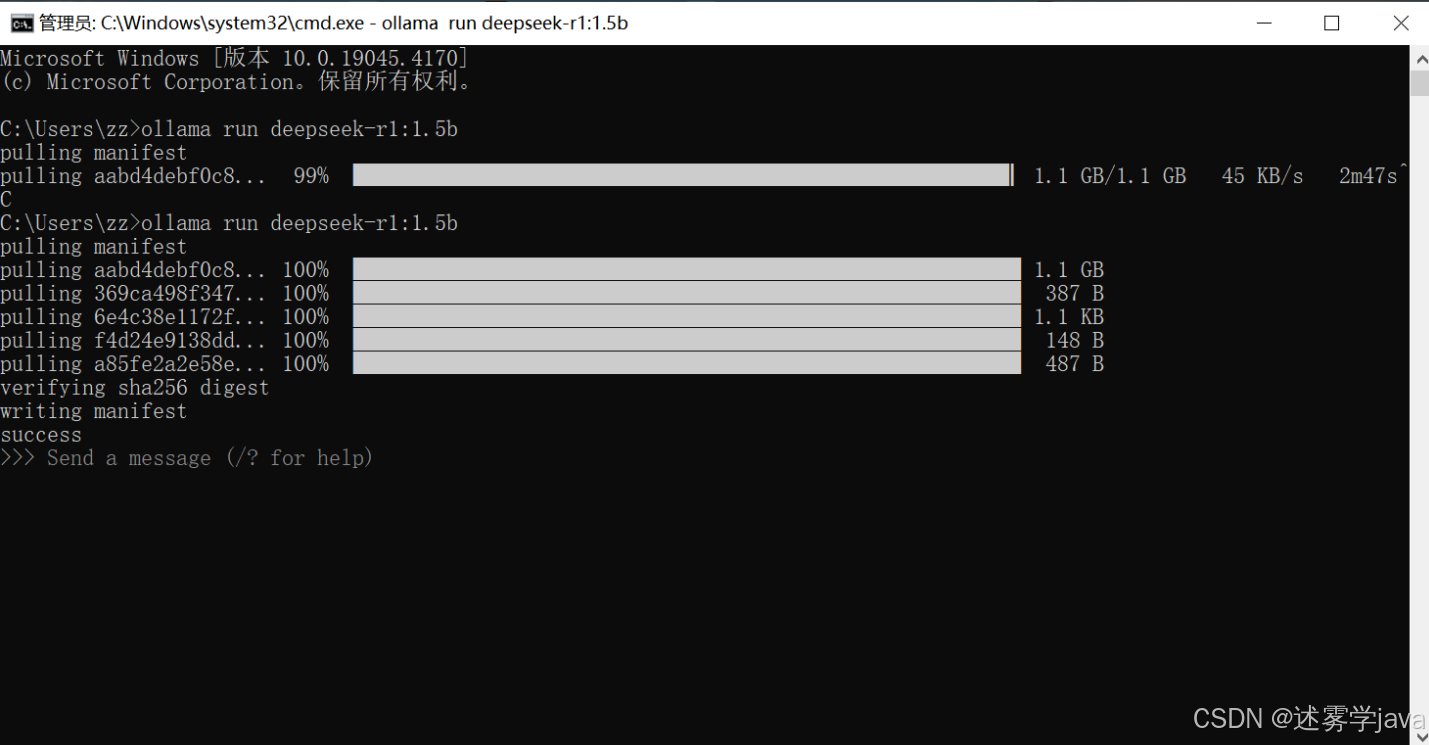

安装DeepSeek,直接在命令窗口输入ollama run deepseek-r1:1.5b运行即可,如下所示。(这边博主配置不够,只能安装丐版R1,如果需要安装更加完美的可以参考下方内容)

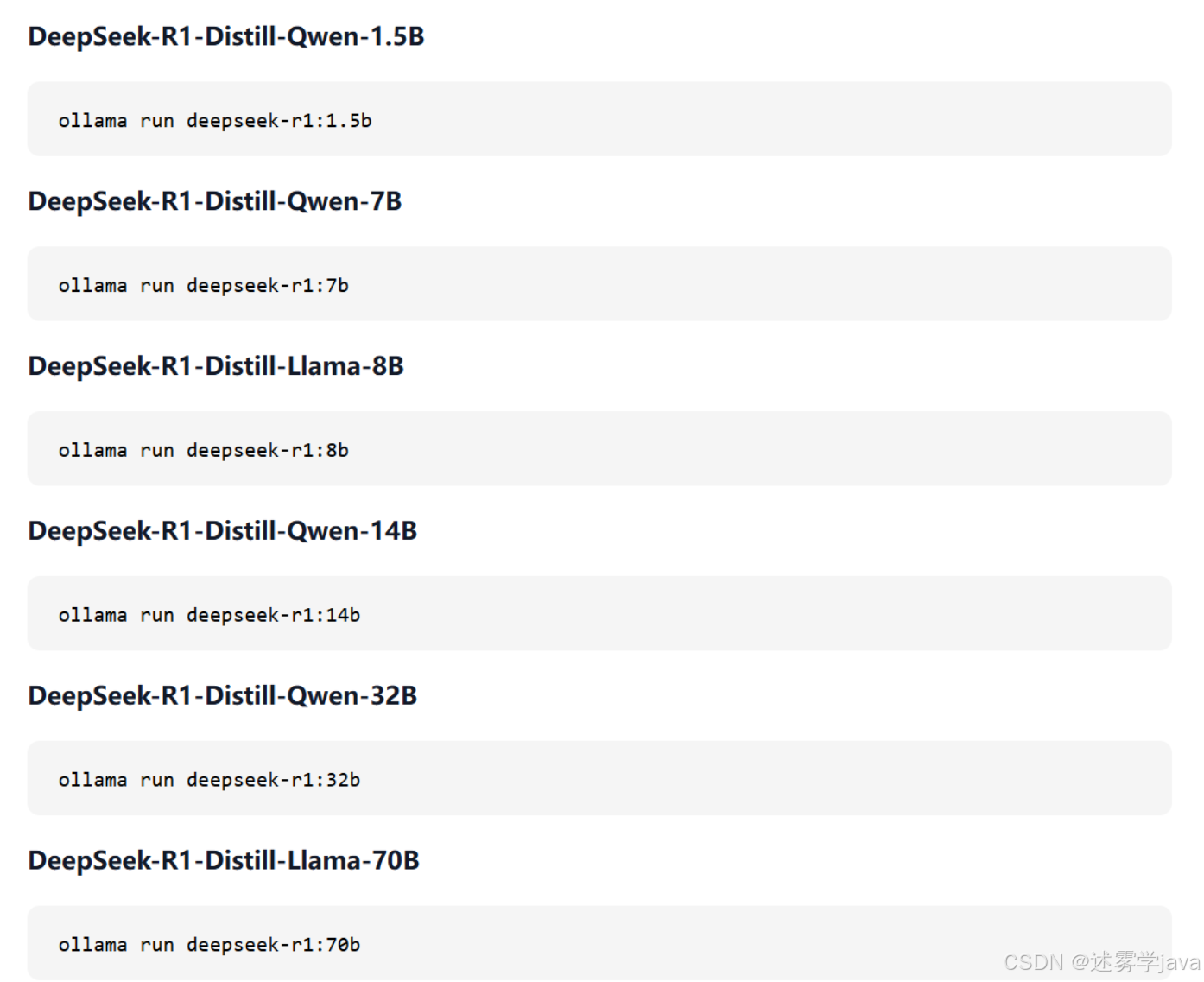

olama官网可以查看各个模型的名字

官网可以查看各个模型的配置

根据电脑不同配置安装适合的版本

下载完成,下载可能会很慢,可以尝试在慢的时候ctrl+C中断,然后等一分钟继续下载

CodeGPT集成DeepSeek本地部署

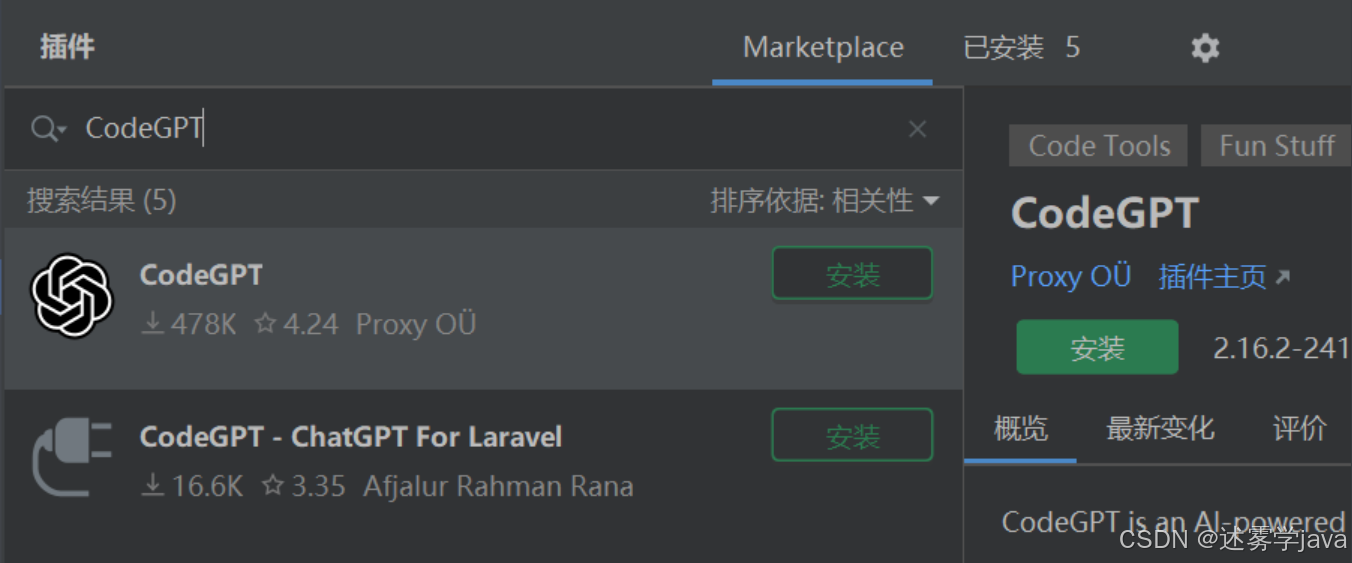

插件市场找到CodeGPT插件安装

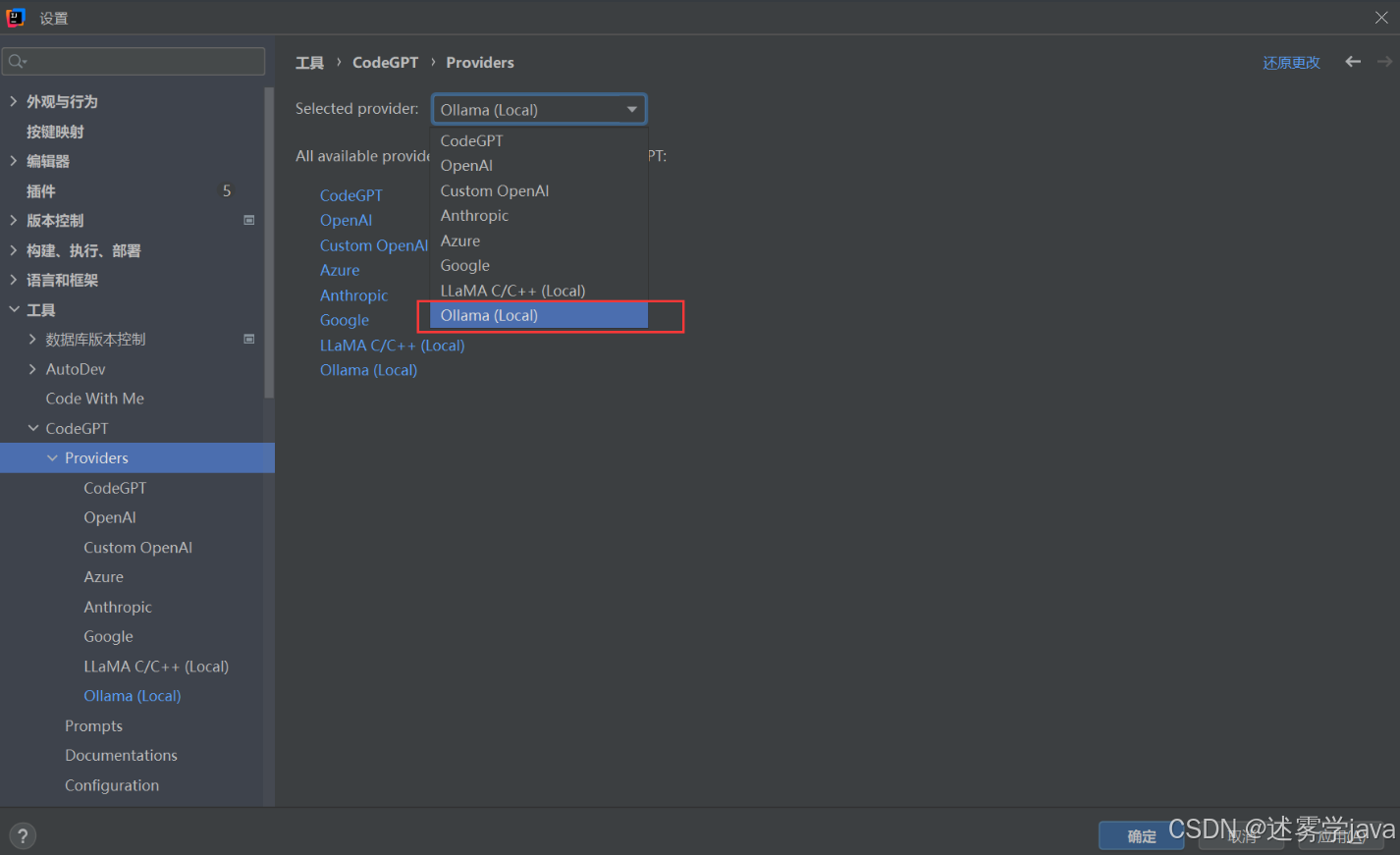

配置Ollama,打开IDEA -》Settings -》Tools -》CodeGPT -》Providers,在Selected provider中选择Ollama(Local)即可,点击【OK】按钮,如下所示。

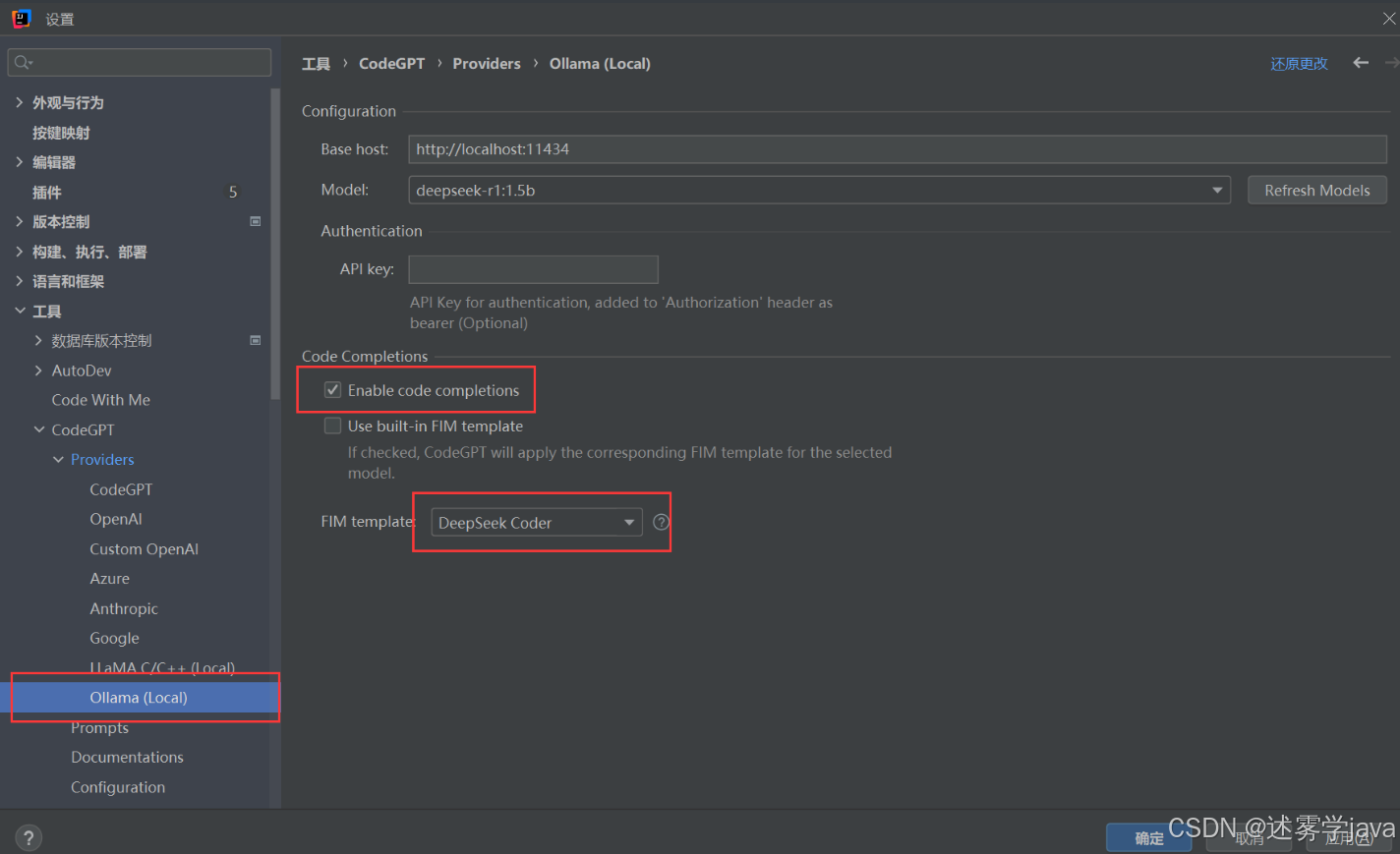

完成后就会在Providers中看到Ollama的配置信息,修改Code Completions以及FIM template的信息,如下所示。

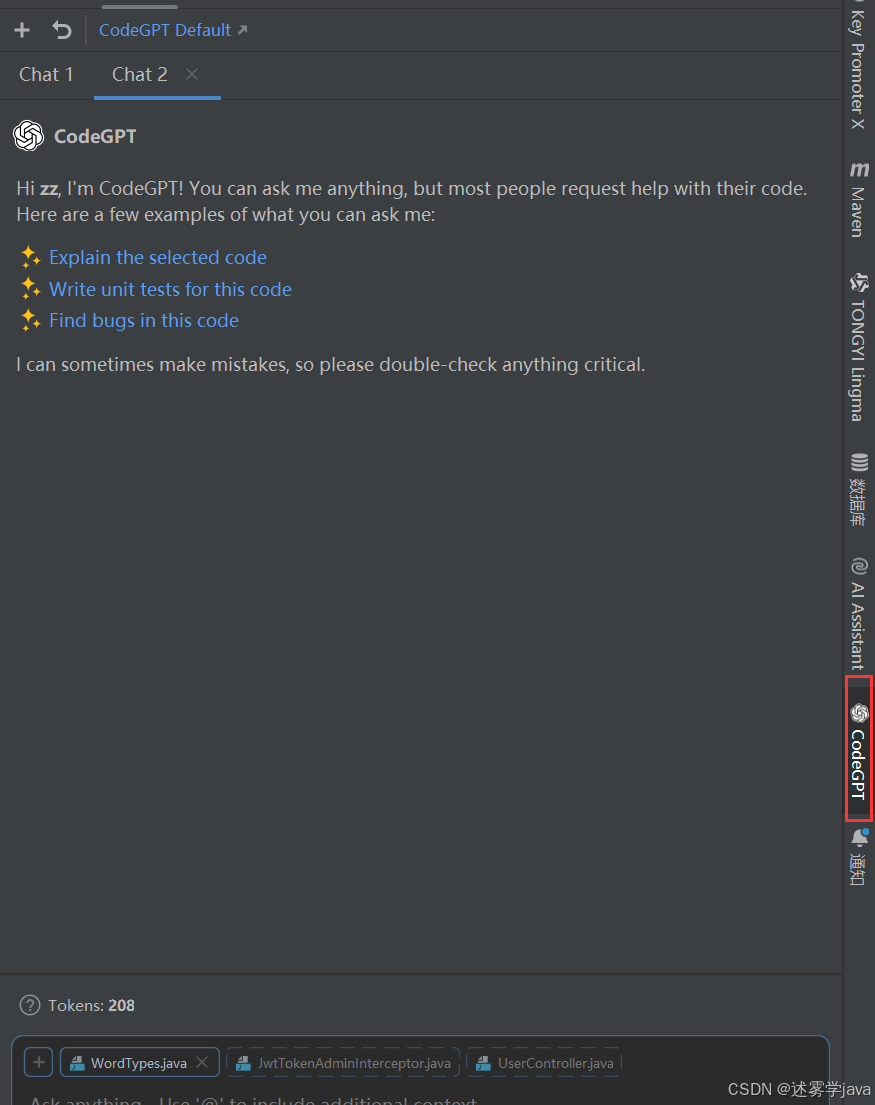

在IDEA右侧点击CodeGPT按钮,即可使用,如下所示。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)