如何打造一个靠谱的AI助手?——高速稳定满血Deepseek R1 + 联网检索 + 知识库 + Artifacts

打造一个“高速、稳定、满血”的AI助手,需要Deepseek R1的强大推理能力、联网检索的实时支持、知识库的深度积累,以及Artifacts的多模态输出。其671亿参数(激活37亿/每token)确保了在复杂任务中的稳定表现,同时支持不同规模的精简版本(如7B、70B),适合各种硬件环境。:通过“链式思考”(Chain-of-Thought)技术,Deepseek R1能够逐步分析问题,并在<t

引言:AI助手的未来已来,你准备好了吗?

在2025年的今天,人工智能(AI)不再是科幻电影中的遥远梦想,而是融入我们日常生活的得力助手。从智能客服到个人效率工具,AI助手正以惊人的速度改变我们的工作和生活方式。然而,打造一个靠谱、稳定、功能强大的AI助手并非易事——它需要强大的模型、实时数据支持、丰富的知识储备以及灵活的输出能力。

今天,我们将深入探讨如何利用Deepseek R1——一款备受瞩目的开源推理模型,结合联网检索、知识库和**artifacts(生成产物)**功能,打造一个“高速、稳定、满血”的AI助手。这篇文章将为你提供清晰的思路、实用的步骤和精美的图示,助你在AI浪潮中脱颖而出!

一、为什么选择Deepseek R1?它的“满血”潜力在哪里?

1.1 Deepseek R1的核心优势

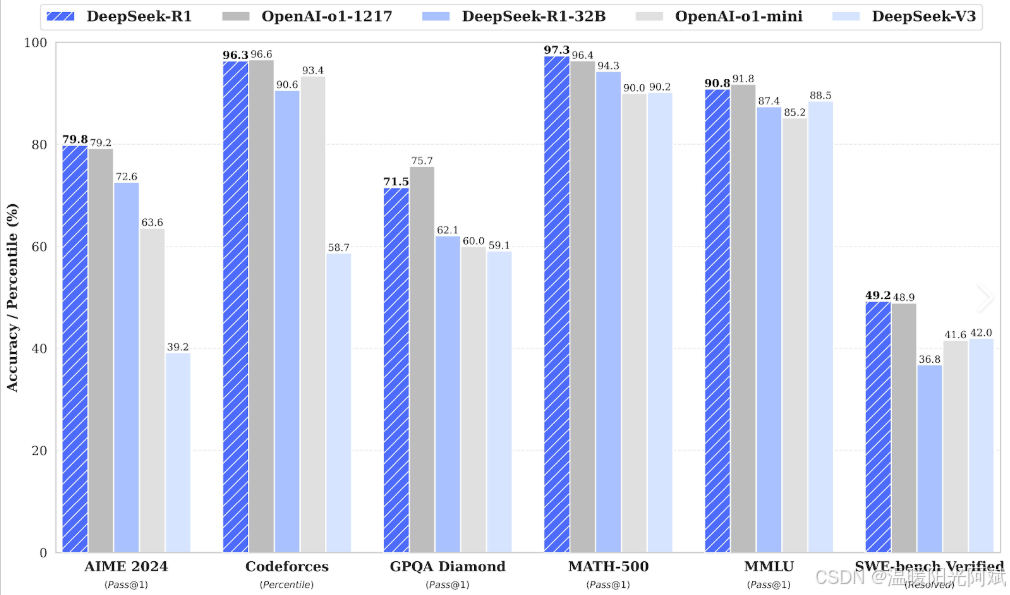

Deepseek R1是Deepseek公司于2025年初推出的旗舰推理模型,专为复杂任务设计,如编程、数学、规划和解谜。它具有以下关键特点:

-

强大的推理能力:通过“链式思考”(Chain-of-Thought)技术,Deepseek R1能够逐步分析问题,并在<think>标签中展示详细的推理过程,最终给出精准答案。

-

高效性能:相比OpenAI的o1模型,Deepseek R1在成本上低至其1/20-1/50,训练成本仅需600万美元,而性能却不相上下。

-

开源与灵活性:Deepseek R1采用MIT许可,开发者可以自由下载、修改并集成到项目中,适合构建定制化AI助手。

1.2 “满血”表现的秘密

Deepseek R1通过多阶段训练(包括大规模强化学习和监督微调)克服了早期模型的局限,如重复输出或语言混杂问题。其671亿参数(激活37亿/每token)确保了在复杂任务中的稳定表现,同时支持不同规模的精简版本(如7B、70B),适合各种硬件环境。

图1:Deepseek R1 vs 其他模型性能对比

二、打造靠谱AI助手的四大支柱

要让AI助手“靠谱”,仅仅依赖Deepseek R1还不够。我们需要结合以下四大核心组件,构建一个高效、实用的系统。

2.1 高速稳定的Deepseek R1核心

-

本地部署:利用Ollama等工具,将Deepseek R1部署在本地设备上,确保零延迟和数据隐私。

-

推荐使用8B或70B版本,适合普通消费级GPU(如RTX 4090)。

-

命令示例:ollama run deepseek-r1:8b

-

-

云端API支持:对于需要高并发场景,可通过Deepseek官方API(兼容OpenAI格式)调用,确保稳定性。

图2:本地部署与云端API架构示意图

2.2 联网检索:实时获取最新信息

一个靠谱的AI助手必须具备获取实时数据的能力。联网检索(Web Search)可以让Deepseek R1访问互联网上的最新内容,回答时效性强的查询。

-

实现方法:

-

集成第三方搜索API(如Google Custom Search、Bing API)或使用Dify平台的Web Search插件。

-

在Deepseek R1的提示中添加“联网检索”指令,确保模型优先调用实时数据。

-

-

应用场景:例如,用户询问“2025年福州最新旅游景点推荐”,AI可通过联网检索提供最新景区信息。

图3:联网检索流程示例

2.3 知识库:为AI注入深度智慧

知识库(Knowledge Base)是AI助手的“大脑”,存储领域特定信息,提升回答的准确性和深度。

-

构建知识库:

-

使用向量数据库(如Pinecone、FAISS)存储文档、PDF或文本文件。

-

通过RAG(检索增强生成)技术,Deepseek R1可根据用户查询检索知识库,生成更精准的回答。

-

-

应用场景:如为医疗、金融行业构建专家知识库,AI可提供专业建议。

图4:知识库与RAG集成示意图

2.4 Artifacts:多模态输出的魔法

Artifacts是Deepseek R1的一大亮点,支持生成代码、图表、文档等“产物”,让AI助手更具实用性。

-

实现方法:

-

在提示中明确要求生成特定格式的Artifacts,如“生成Python代码”或“绘制数据可视化图表”。

-

结合Gradio或Dify界面,展示生成的代码或图表,增强用户体验。

-

-

应用场景:开发者可通过AI生成调试代码,数据分析师可获取可视化图表。

图5:Artifacts生成示例

三、实现步骤:从零开始打造你的AI助手

以下是详细的实现步骤,适合技术爱好者和开发者参考:

3.1 准备环境

在开始之前,需要搭建一个适合运行Deepseek R1的开发环境,并确保所有依赖正常工作。

-

安装Python 3.8+:

-

访问Python官网下载最新版本(推荐3.11或更高),确保安装过程中勾选“Add Python to PATH”。

-

验证安装:打开终端运行 python --version,确认版本号。

-

-

安装Ollama:

-

Ollama是一个轻量级的本地AI运行时工具,适合运行Deepseek R1模型。

-

安装步骤:

-

访问Ollama官网,根据操作系统下载安装包(支持Linux、macOS、Windows)。

-

运行安装后,打开终端输入 ollama 检查是否正常启动。

-

如果使用Docker,可运行 docker run -d -p 11434:11434 --name ollama ollama/ollama 启动容器。

-

安装相关依赖:

-

使用 pip安装必要的Python库:

pip install ollama openai langchain gradio diffusers torch

这些库分别用于模型运行、API调用、知识库构建、界面开发和多模态支持。

下载Deepseek R1模型:

-

打开终端,运行以下命令下载Deepseek R1的8B版本(适合大多数消费级硬件):

ollama pull deepseek-r1:8b-

如果硬件更强大(如具有多GPU),可选择70B版本:ollama pull deepseek-r1:70b。

-

验证模型安装:运行 ollama list 查看已下载模型。

-

硬件要求:

-

推荐至少16GB RAM、8GB VRAM(如NVIDIA RTX 3060或更高)的GPU。

-

如果无GPU,可使用CPU运行,但性能会降低。

-

-

注意事项:

-

确保网络稳定,避免下载模型中断。

-

定期更新Ollama和Python库,保持兼容性。

-

3.2 集成联网检索

联网检索让AI助手能够实时获取互联网上的最新信息,提升回答的时效性和准确性。

-

注册搜索API:

-

选择一个稳定的搜索API,如Google Custom Search、Bing Web Search或SerpAPI。

-

以Google Custom Search为例:

- 访问Google Cloud Console,创建项目并启用Custom Search API。

- 获取API Key和CX(搜索引擎ID)。

- 注意免费额度(通常每月100美元),超额需付费。

-

-

编写Python脚本:

-

使用 google-api-python-client 或 requests 调用API,并将结果注入Deepseek R1的提示。

-

示例代码:

-

import requests

from ollama import Client

# 配置Google Custom Search API

API_KEY = "你的Google API Key"

CX = "你的CX"

query = "2025年xx最新旅游景点"

# 调用搜索API

url = f"https://www.googleapis.com/customsearch/v1?key={API_KEY}&cx={CX}&q={query}"

response = requests.get(url)

search_results = response.json().get("items", [])

# 初始化Ollama客户端

client = Client(host="http://localhost:11434")

prompt = f"根据以下搜索结果回答问题:{search_results}\n用户提问:{query}"

# 调用Deepseek R1生成回答

response = client.generate(model="deepseek-r1:8b", prompt=prompt)

print(response['response'])-

优化提示:

-

在提示中添加指令,如“优先使用联网检索结果,生成简洁回答”。

-

设置超时和重试机制,确保网络稳定性。

-

-

注意事项:

-

遵守API使用条款,避免频繁请求触发限制。

-

考虑使用代理或VPN,绕过地区限制。

-

3.3 构建知识库

知识库为AI注入深度领域知识,通过RAG(检索增强生成)技术提升回答质量。

安装依赖:

-

准备文档:

-

收集领域相关文档(如PDF、Word、TXT),用于构建知识库。

-

示例:为医疗AI收集医学指南,为金融AI收集法规文件。

-

-

使用LangChain或LlamaIndex加载文档:

安装依赖:

pip install langchain langchain-community示例代码(使用LangChain):

from langchain.document_loaders import TextLoader

from langchain.text_splitter import CharacterTextSplitter

from langchain.vectorstores import FAISS

from langchain.embeddings import OllamaEmbeddings

# 加载文档

loader = TextLoader("knowledge.txt")

documents = loader.load()

# 分割文档为块

text_splitter = CharacterTextSplitter(chunk_size=1000, chunk_overlap=200)

chunks = text_splitter.split_documents(documents)

# 创建向量索引

embeddings = OllamaEmbeddings(model="deepseek-r1:8b")

vectorstore = FAISS.from_documents(chunks, embeddings)

# 保存索引

vectorstore.save_local("faiss_index")配置RAG流程:

-

在Deepseek R1提示中集成知识库检索:

from langchain.chains import RetrievalQA

qa_chain = RetrievalQA.from_chain_type(

llm=client, # Deepseek R1客户端

chain_type="stuff",

retriever=vectorstore.as_retriever()

)

response = qa_chain({"query": "xx领域的最新趋势是什么"})

print(response['result'])注意事项:

-

确保文档内容高质量,避免噪音数据影响检索。

-

定期更新知识库,保持信息最新

3.4 启用Artifacts

Artifacts功能让AI生成代码、图表、文档等产物,提升实用性。

-

设计提示模板:

-

在提示中明确要求生成特定格式的Artifacts。例如:

-

任务:生成一个Python脚本,用于计算斐波那契数列的前10个数字。输出格式:完整的Python代码,带注释,使用<artifacts>标签包裹。

使用Gradio或Dify构建交互界面:

-

安装Gradio

pip install gradio示例代码:

import gradio as gr

from ollama import Client

client = Client(host="http://localhost:11434")

def generate_artifact(prompt):

response = client.generate(model="deepseek-r1:8b", prompt=prompt)

return response['response']

interface = gr.Interface(fn=generate_artifact, inputs="text", outputs="text", title="AI Artifact Generator")

interface.launch()-

展示Artifacts:

-

对于代码,使用代码块格式(如Markdown);对于图表,可结合Matplotlib生成图片并显示。

-

-

注意事项:

-

确保提示清晰,避免歧义。

-

测试不同任务,确保Artifacts格式一致。

-

3.5 测试与优化

测试是确保AI助手稳定性和准确性的关键步骤。

-

测试场景:

-

编程问题:输入“写一个排序算法的Python代码”。

-

实时新闻查询:输入“2025年福州房价趋势”。

-

知识库问题:输入“医疗领域的最新研究进展”。

-

-

评估指标:

-

响应速度:目标在3秒内返回结果(本地部署)。

-

准确性:人工评估回答是否符合预期。

-

稳定性:连续测试50次,确保无崩溃或错误。

-

-

优化方法:

-

调整提示模板,减少歧义。

-

优化模型参数(如temperature、top_p),平衡创意与准确性。

-

根据用户反馈更新知识库或联网检索逻辑。

-

-

注意事项:

-

记录日志,追踪错误和性能瓶颈。

-

定期备份模型和数据,避免丢失。

-

四、AI助手的应用场景与未来展望

4.1 应用场景

-

个人助理:帮助用户规划日程、解答问题、生成内容。

-

开发者工具:代码生成、调试、优化。

-

行业解决方案:医疗咨询、金融分析、法律支持。

4.2 未来趋势

-

更高效的推理:Deepseek持续优化R1模型,未来可能在多模态(如图像、视频)任务上突破。

-

更低的成本:开源模式和硬件优化将让AI助手更普及。

-

隐私与安全性:本地部署和数据本地化将成为趋势。

结语:迈向靠谱AI的下一步

打造一个“高速、稳定、满血”的AI助手,需要Deepseek R1的强大推理能力、联网检索的实时支持、知识库的深度积累,以及Artifacts的多模态输出。通过本文的指导,你已掌握了核心思路和实现步骤。无论是个人学习还是企业应用,这套方案都能为你带来高效、智能的AI体验。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)