DeepSeek R1 本地部署并实现联网搜索和本地知识库搭建步骤

DeepSeek R1 本地部署并实现联网搜索步骤,可以实现联网搜索本地知识库搭建

DeepSeek R1 本地部署并实现联网搜索步骤

注意事项

建议使用英伟达独立显卡,速度快,amd显卡未测试,应该也是可以的

所需要的所有文件均打包上传到网盘了(更多模型持续更新中)

哪个快用哪个 东西都一样

deepseek本地模型下载路径(包括LMStudio)

百度网盘:

链接: https://pan.baidu.com/s/1UHNjOWgChh_8-XotvabImw?pwd=68gv提取码: 68gv

夸克:

链接:https://pan.quark.cn/s/a5bc5e9cd6d3

1.下载安装LMStudio

1.下载安装LMStudio

直接下一步下一步就行(可以选择安装到你喜欢的位置)

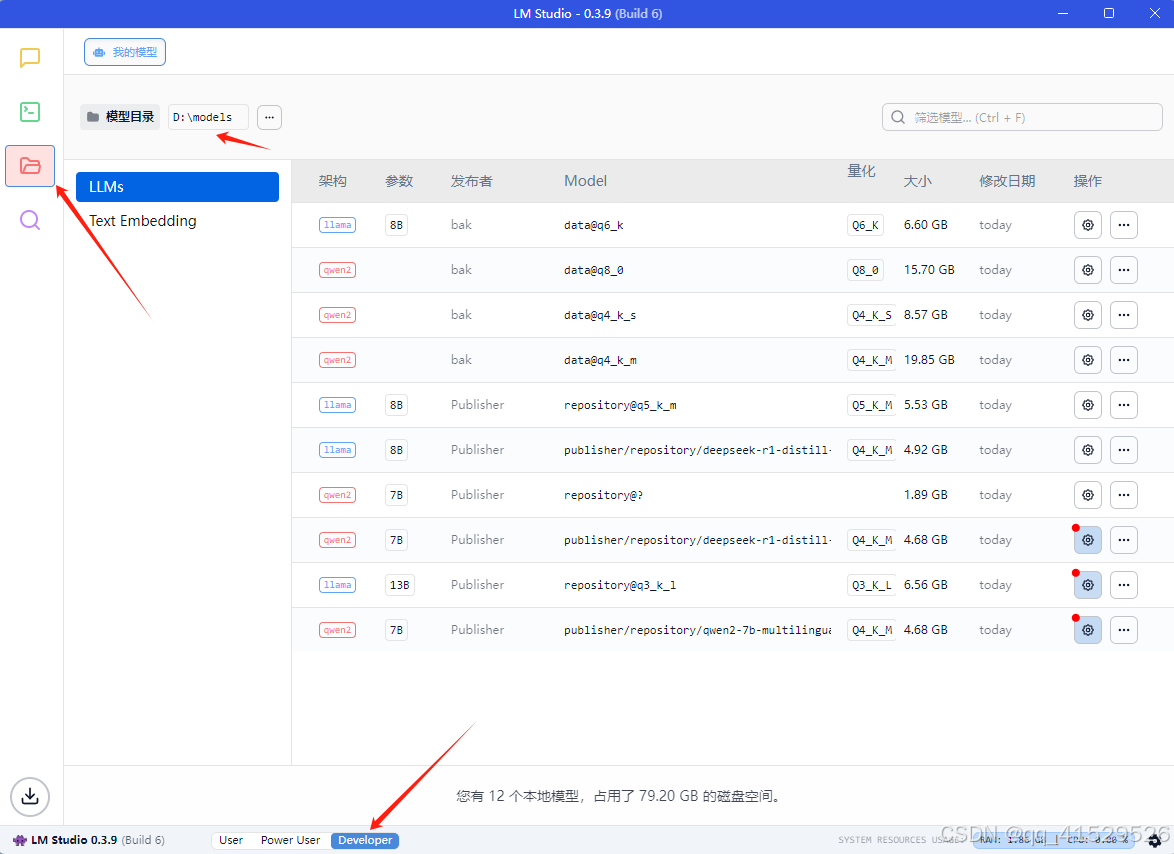

2.下载模型

模型选择根据自己的显卡显存选择模型大小选择对应模型下载,下载后放D盘 models/Publisher/Repository/目录下

无显卡或者4G显存以下的电脑下载1.5B模型

8G显卡可以下载8b模型

16G显卡可以选择下载14B模型

24G以及以上的显卡可以下载32B模型,如果需要更多模型可以发在评论区,后续持续更新

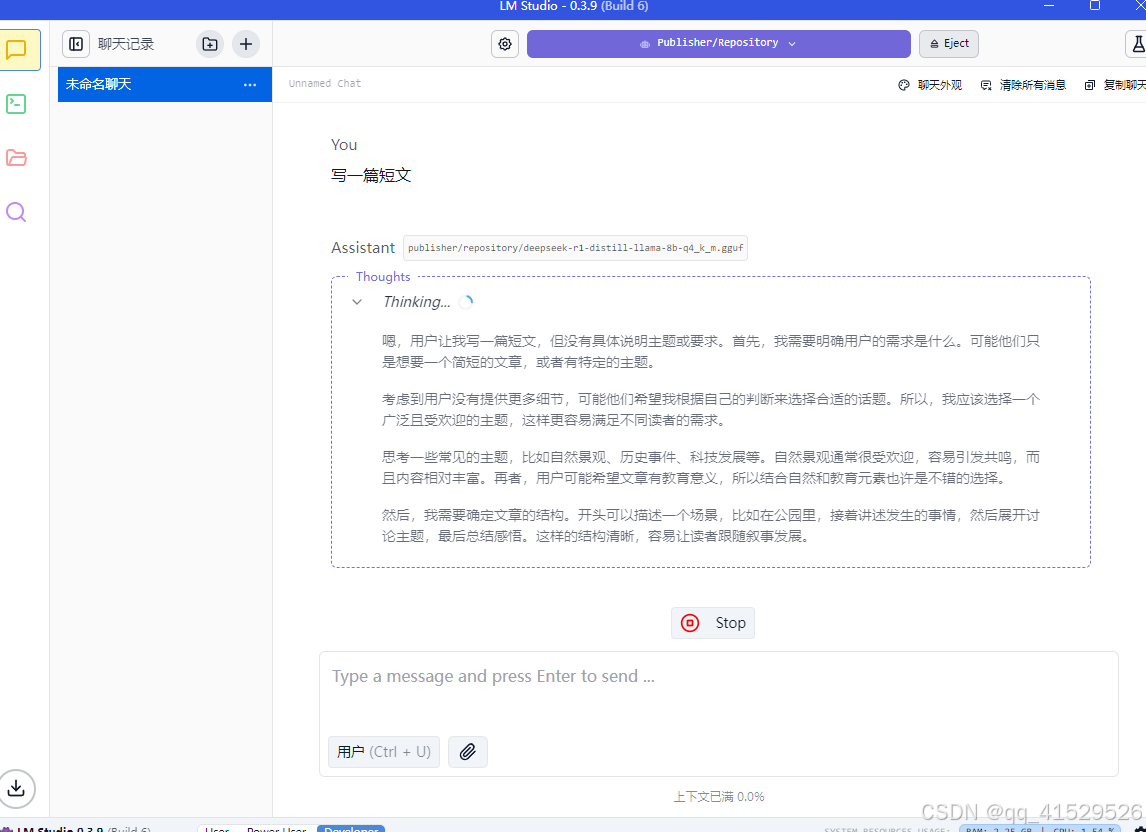

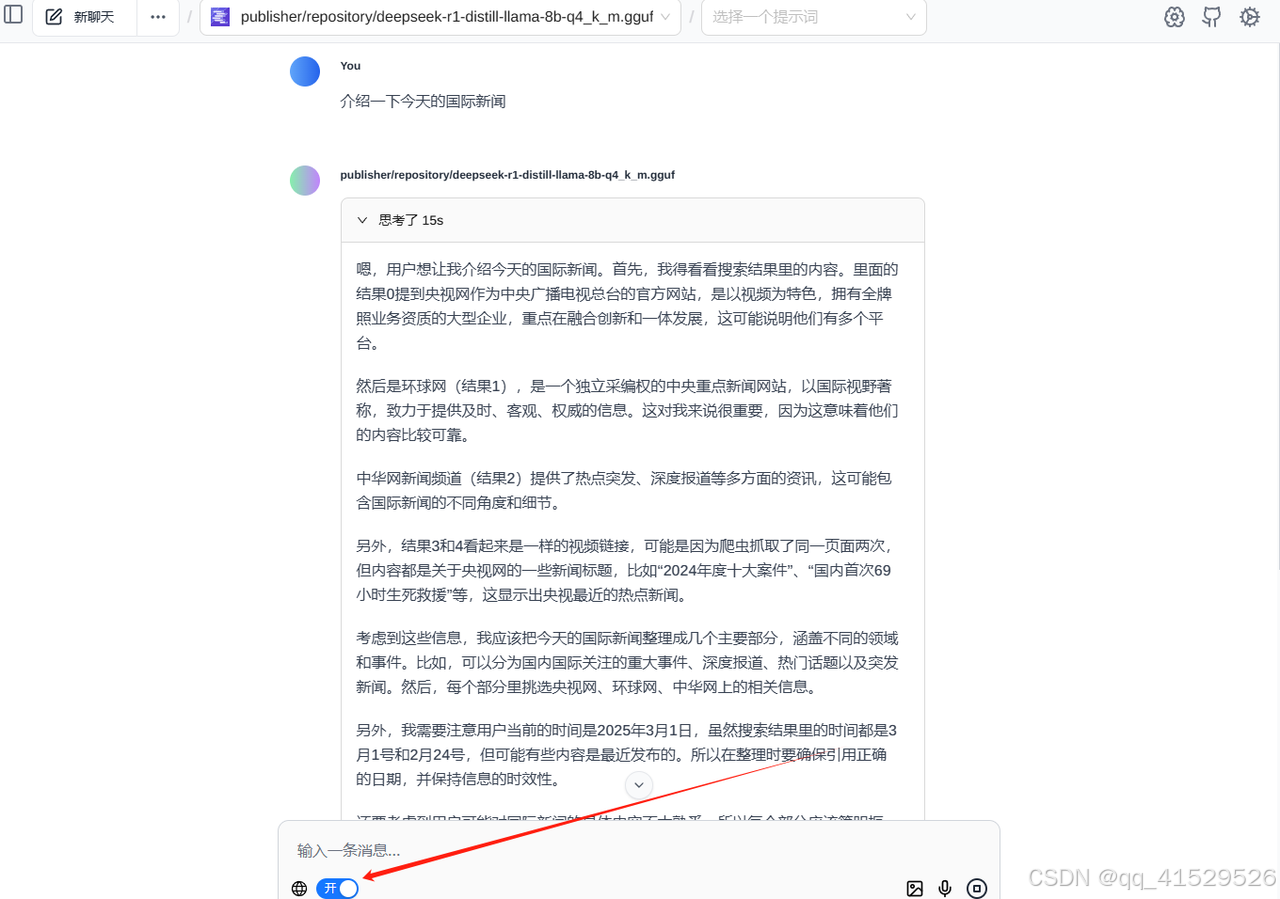

3.加载模型开启对话

提示:这里对文章进行总结:

例如:以上就是今天要讲的内容,本文仅仅简单介绍了pandas的使用,而pandas提供了大量能使我们快速便捷地处理数据的函数和方法。

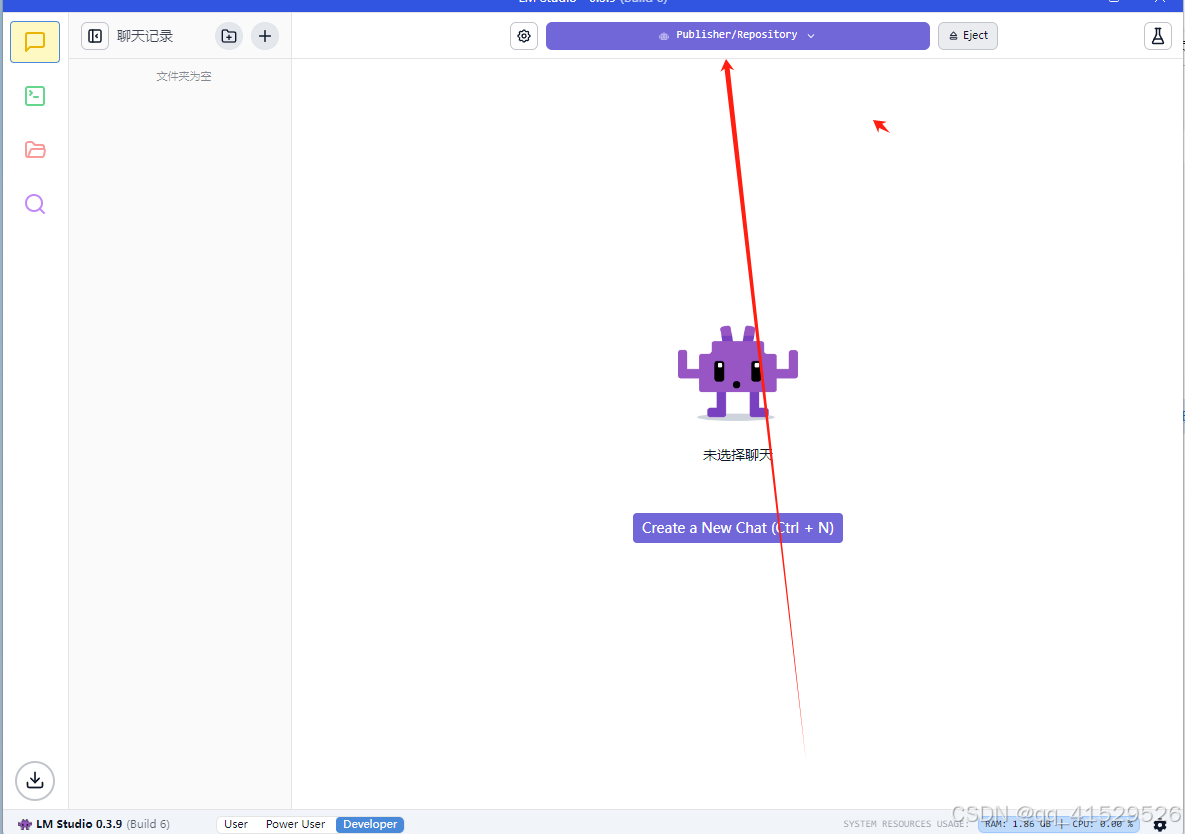

打开lmsutdio 点击我的模型,把模型目录设置到D盘models然后点击聊天加载自己的模型就可以开始对话了

如果不需要联网搜索到此即可正常使用

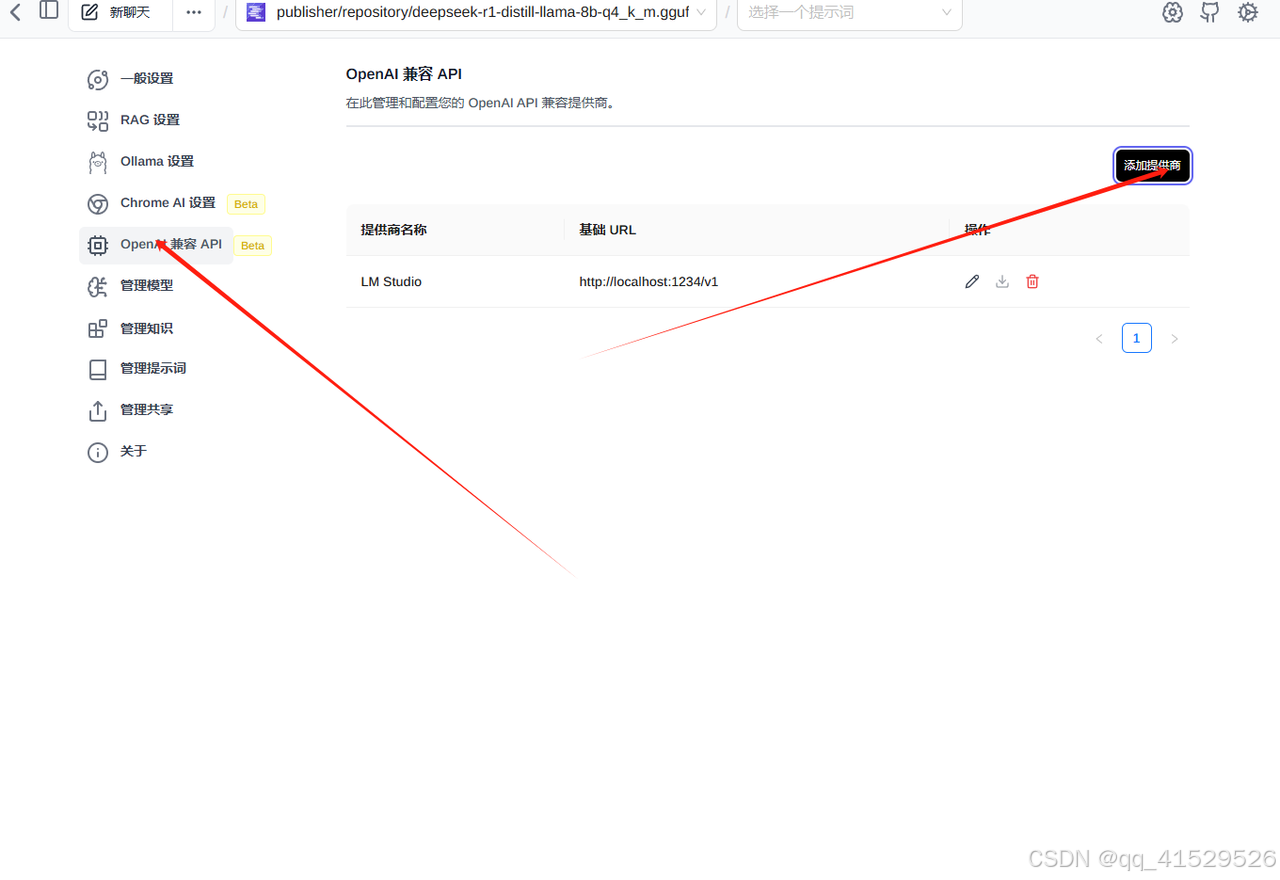

4.联网搜索和本地知识库搭建

进入Page Assist 添加ai提供商选择lmstudio和自己的模型

现在就可以本地联网搜索了

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)