Deepseek本地部署+RAG搭建个人知识库

通过ollama实现deepseek本地部署,通过anything llm搭建个人知识库。

一、DeepSeek本地部署

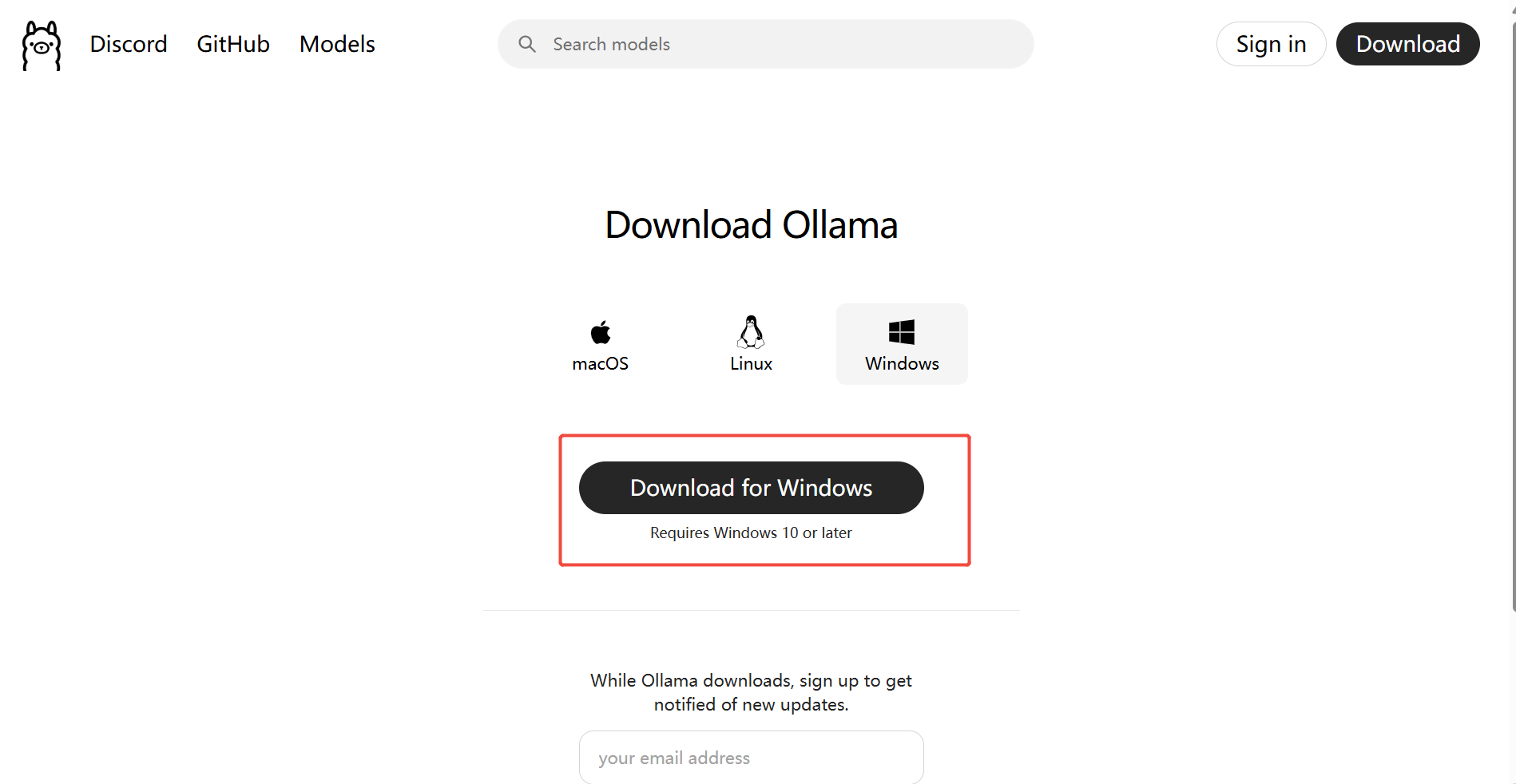

1.下载ollama

打开网址Ollama官网,根据自己的电脑系统下载对应版本即可。注意windows需要win10或以上版本。

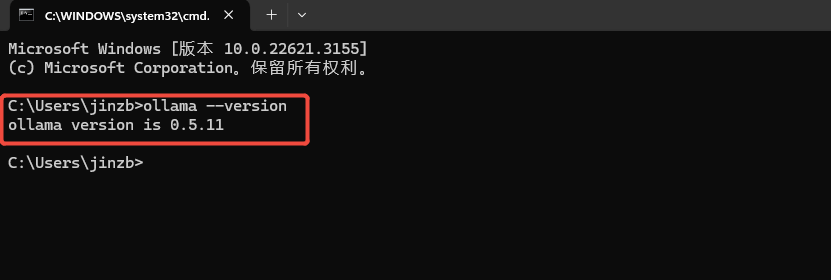

下载后安装,安装位置默认即可。安装完成后,打开终端(win+R)键,输入CMD,即可打开终端。然后输入

ollama --version

能够正确的打印ollama的版本信息,即为安装成功。

1.2 下载deepseek

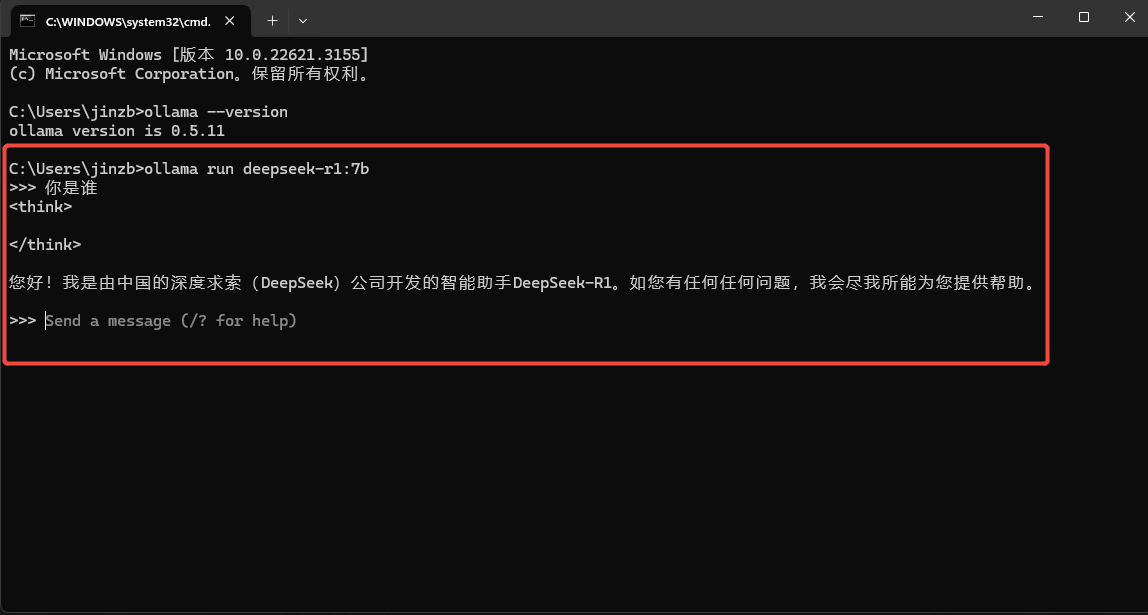

运行下列命令下载并启动deepseek

ollama run deepseek-r1:7b这里会自动下载deepseekr1:7b版本。注意自己的电脑配置,如果是普通的笔记本,7b版本已经差不多了。具体版本和硬件搭配问题可参考:一文读懂DeepSeek-R1本地部署配置要求(建议收藏)_deepsee-r1 部署要求-CSDN博客

下载完成后,实际上就可以直接在终端直接使用deepseek了。

但这个黑乎乎的东西用起来实在不够优雅,那么怎么有可视化的界面呢?

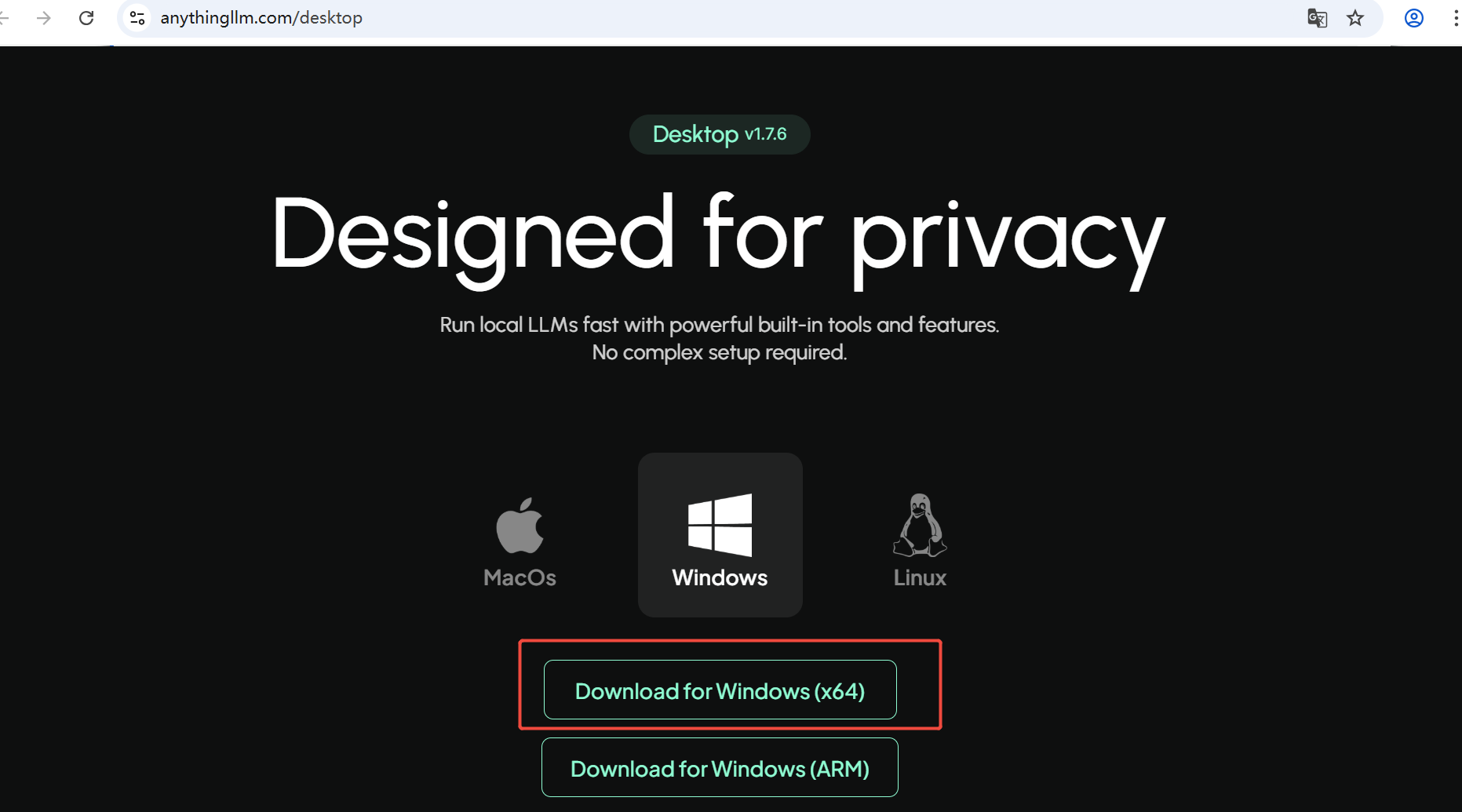

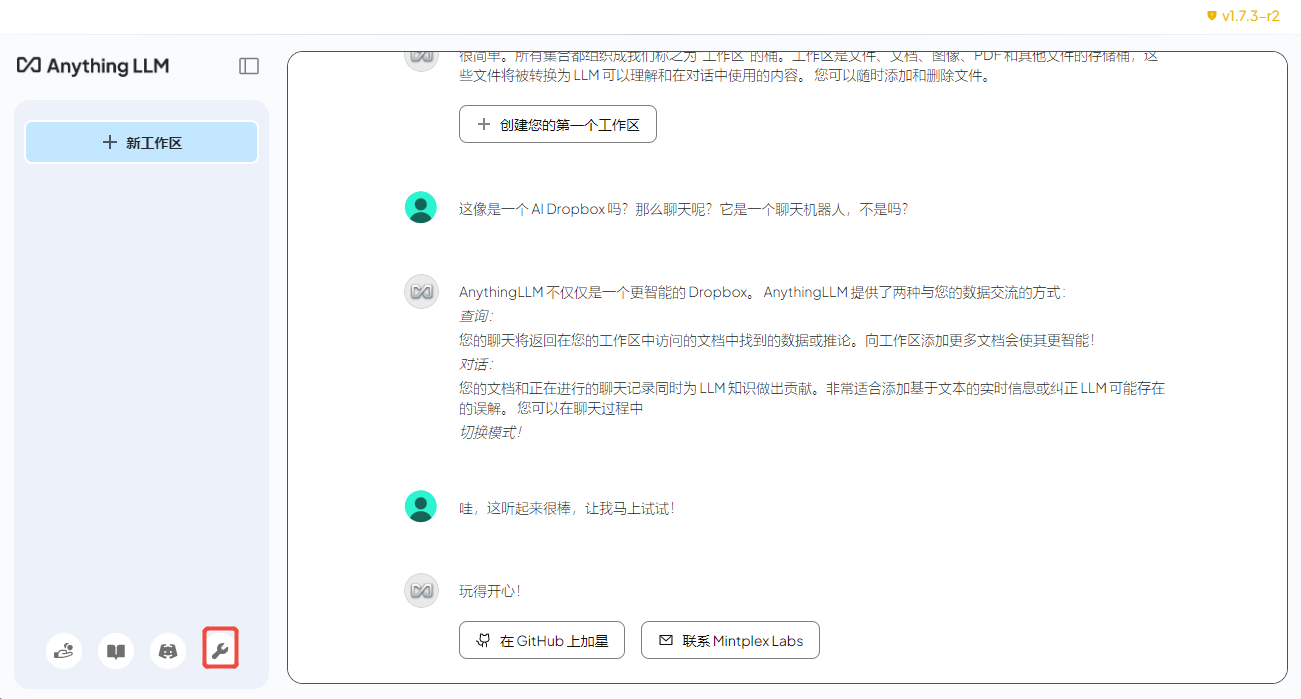

1.3 下载Anything LLM

这里我们使用软件Anything LLM.exe搭建可视化界面。在官网Download AnythingLLM for Desktop上下载并安装,一键傻瓜式安装即可。

安装成功后,需要配置一下anything LLM和deepseek。

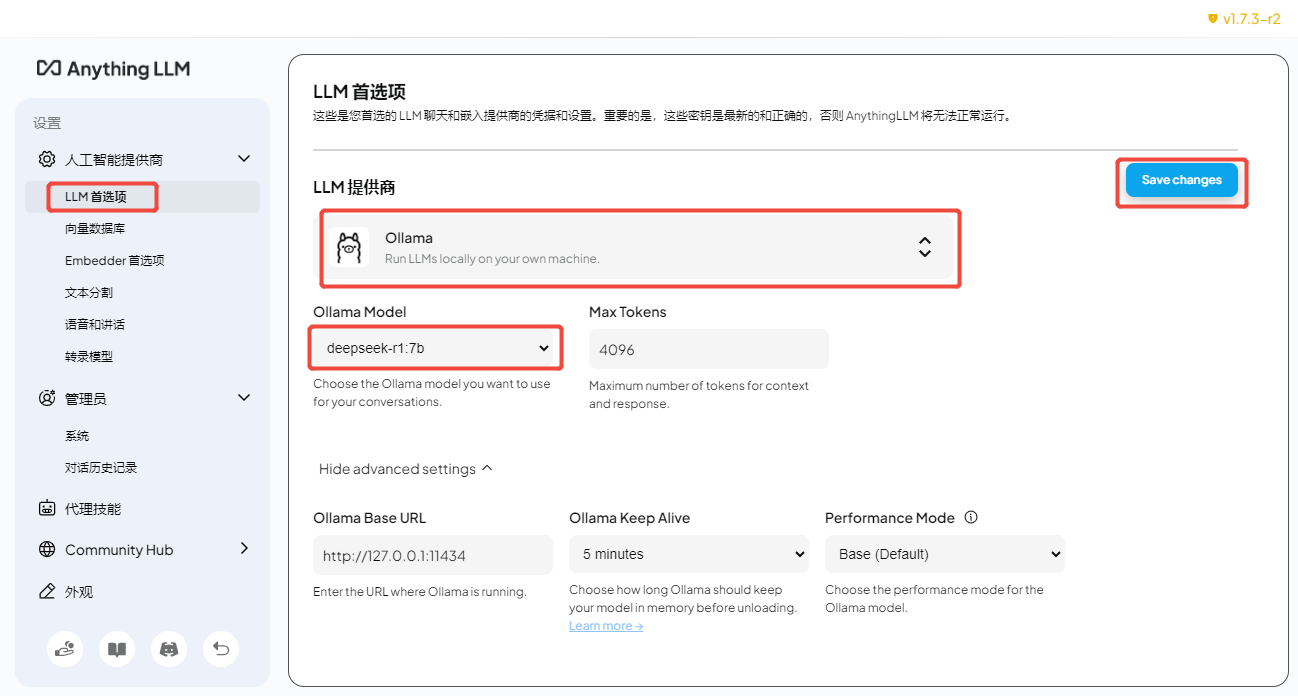

点击设置打开设置页面,打开LLM首选项,LLM提供商选择Ollama,Ollama模型选择自己下载的deepseek版本,最后保存。

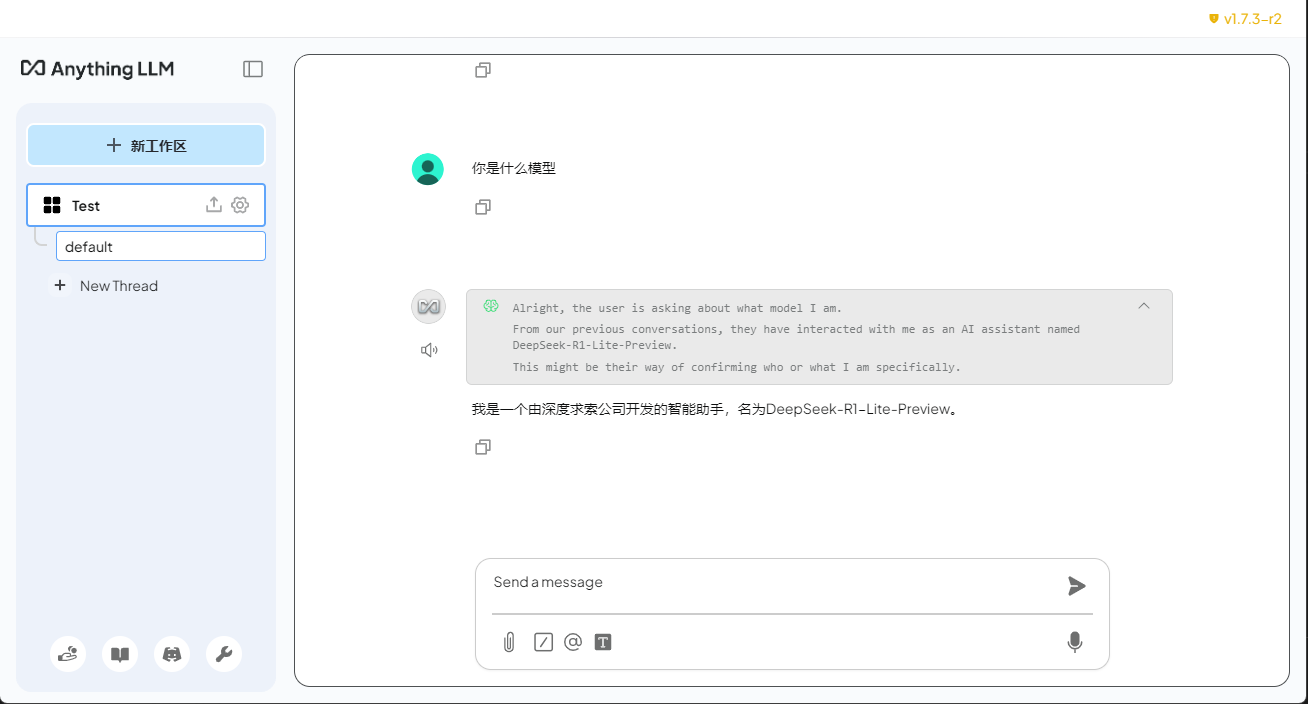

最后新建一个工作区,就可以在工作区里与deepseek直接对话了。

二、通过RAG打造专属知识库

RAG(Retrieval Augmented Generation)增强检索生成是一种技术,它通过从数据源中检索信息来辅助大语言模型(Large Language Model, LLM)生成答案。简而言之,RAG 结合了搜索技术和大语言模型的提示词功能,即向模型提出问题,并以搜索算法找到的信息作为背景上下文,这些查询和检索到的上下文信息都会被整合进发送给大语言模型的提示中。

所以,建立自己的个人知识库,比如把你本行业的一些资料,日常工作文档,构建成个人知识库,然后deepseek生成答案时会参考这些知识库,可以让生成的回答更加准确。

具体做法如下:

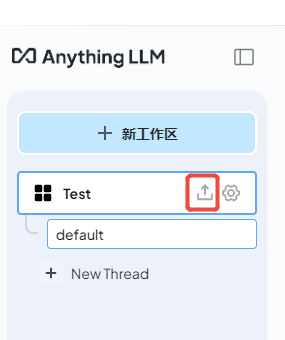

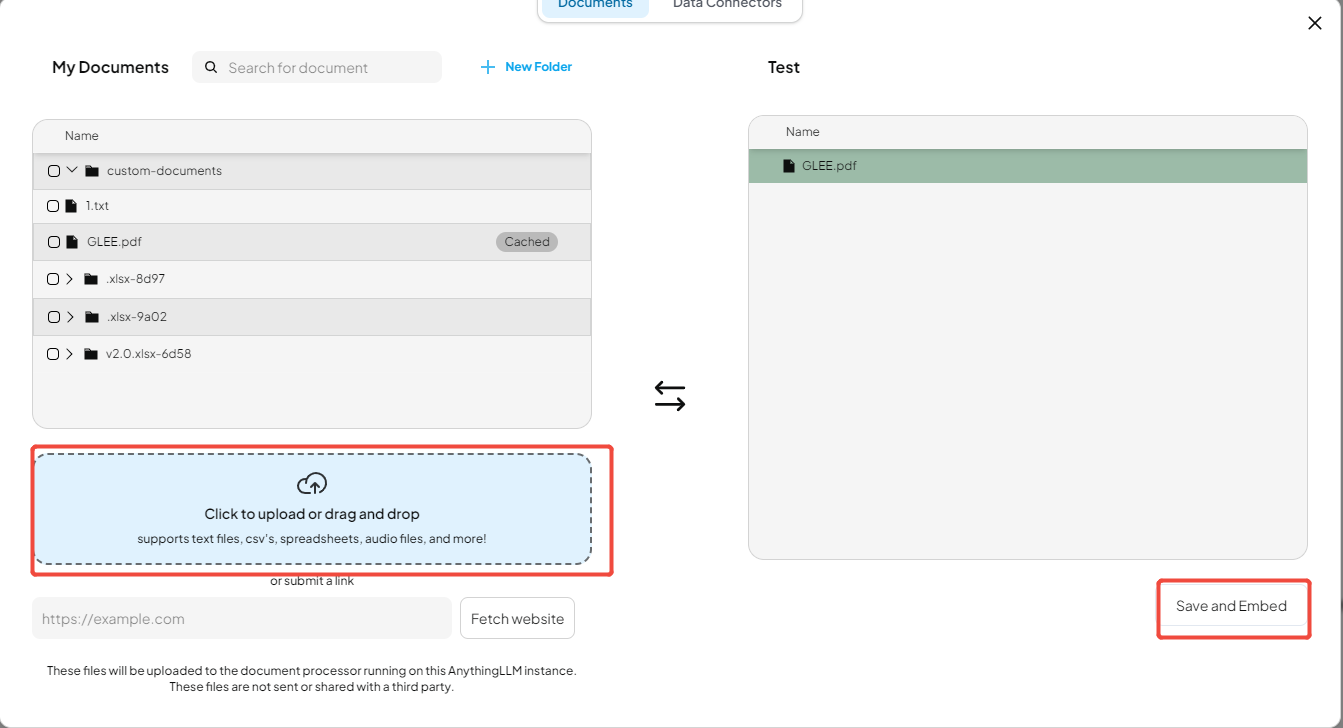

点击上传按钮,上传自己的文档(pdf,word,excel等)然后Save and Embed,系统会把这些文档向量化后保存到本地。

如图所示,deepseek-r1:7b的知识是更新到了2024年7月。但我这里上传了一篇2025年的论文,如果没有搭建RAG,模型会产生幻觉。但搭建个人知识库后,模型生成了准确的回答。

(可选)部署API

也许有的小伙伴会说,我本地硬件条件有限,就想使用DeepSeek官网服务怎么办?

不要着急,AnythingLLM支持直接调用DeepSeek官方提供的API接口。

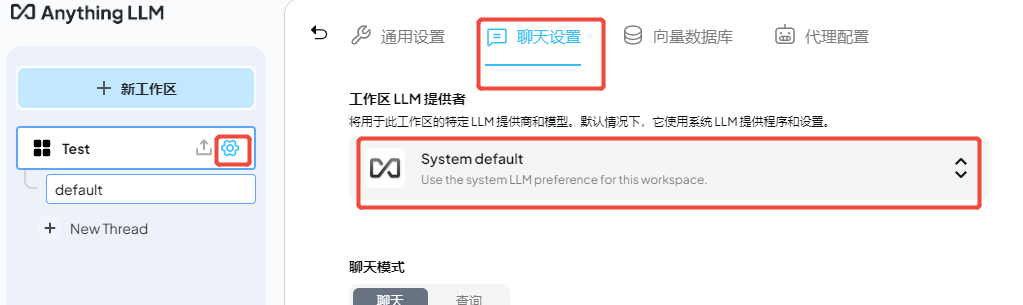

在工作区右侧点击设置,选择聊天设置,可以更改LLM模型。

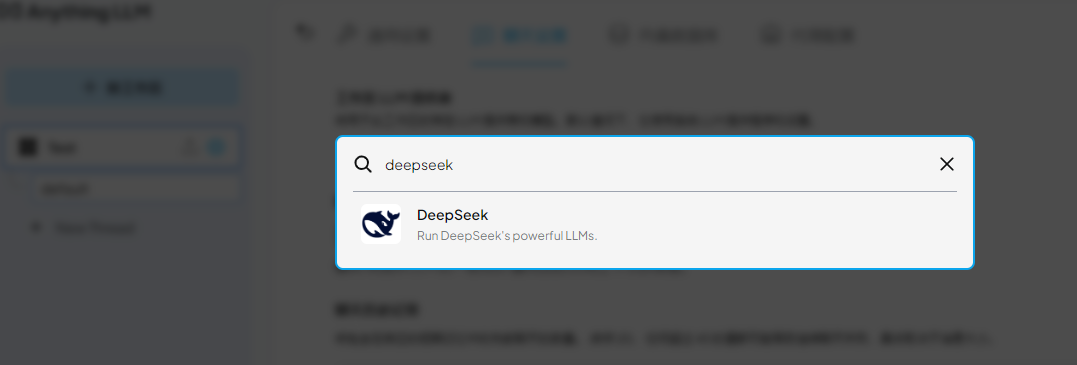

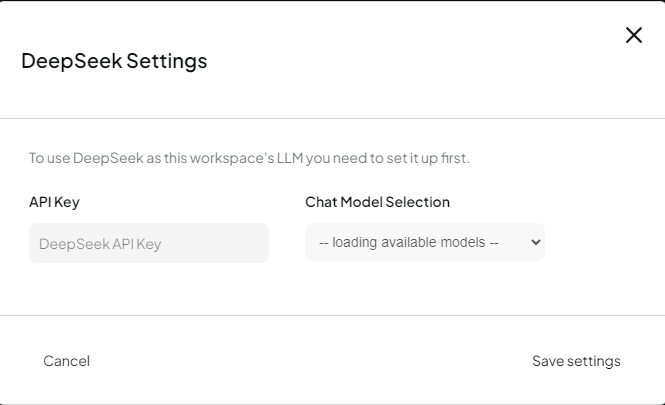

选择DeepSeek,输入API Key,选择DeepSeek模型。

输入DeepSeek API Key。

点击最后更新工作区后就可以享受官方提供的大模型服务了。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)