大模型-使用Ollama+Dify在本地搭建一个专属于自己的聊天助手与知识库

大模型-使用Ollama+Dify在本地搭建一个专属于自己的聊天助手与知识库

·

大模型-使用Ollama+Dify在本地搭建一个专属于自己的知识库

1、本地安装Dify

参考往期博客:https://guoqingru.blog.csdn.net/article/details/144683767

2、本地安装Ollama并解决跨越问题

安装指令:

curl -fsSL https://ollama.com/install.sh | sh

参考往期博文:https://guoqingru.blog.csdn.net/article/details/144708318

安装完毕后,执行指令

ollama run internlm/internlm2.5:20b-chat

我拉取的是书生浦语的20B的大模型,大约需要39G显存,结合自身情况而定。

查看如下所示:

ollama list

测试接口:

python API访问

from ollama import Client

client = Client(

host='http://192.168.4.21:11434',

headers={'Content-Type': 'application/json'}

)

response = client.chat(model='internlm/internlm2.5:20b-chat', messages=[

{

'role': 'user',

'content': '天为什么是蓝色的',

},

])

print(response['message']['content'])

print("---------------------------------------------------------")

import requests,json

url = 'http://192.168.4.21:11434/api/generate'

headers = {

"Content-Type": "application/json"

}

data = {

'prompt': '做一个自我介绍吧?',

'model': 'internlm/internlm2.5:20b-chat',

'stream': False

}

response = requests.post(url, headers=headers, data=json.dumps(data))

print(response.text)

3、使用Dify搭建聊天助手

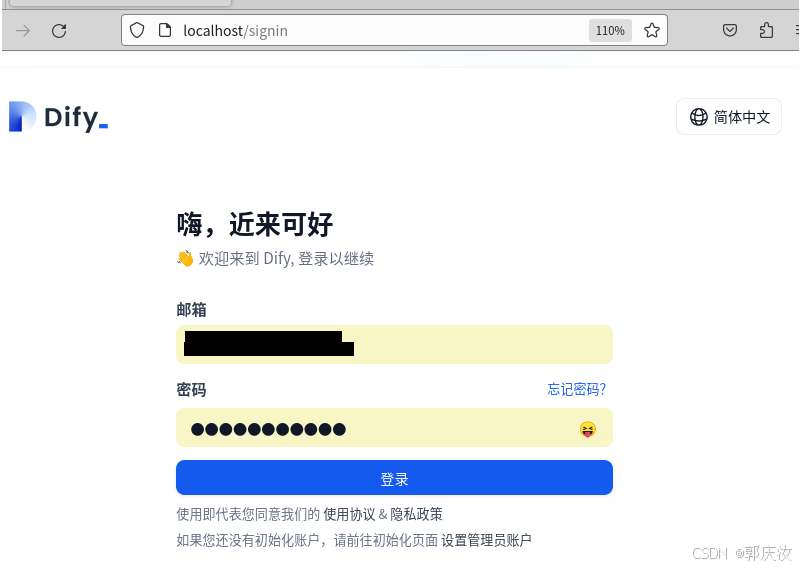

在步骤1安装完毕Dify后,浏览器输入:http://localhost/install即可访问Dify页面

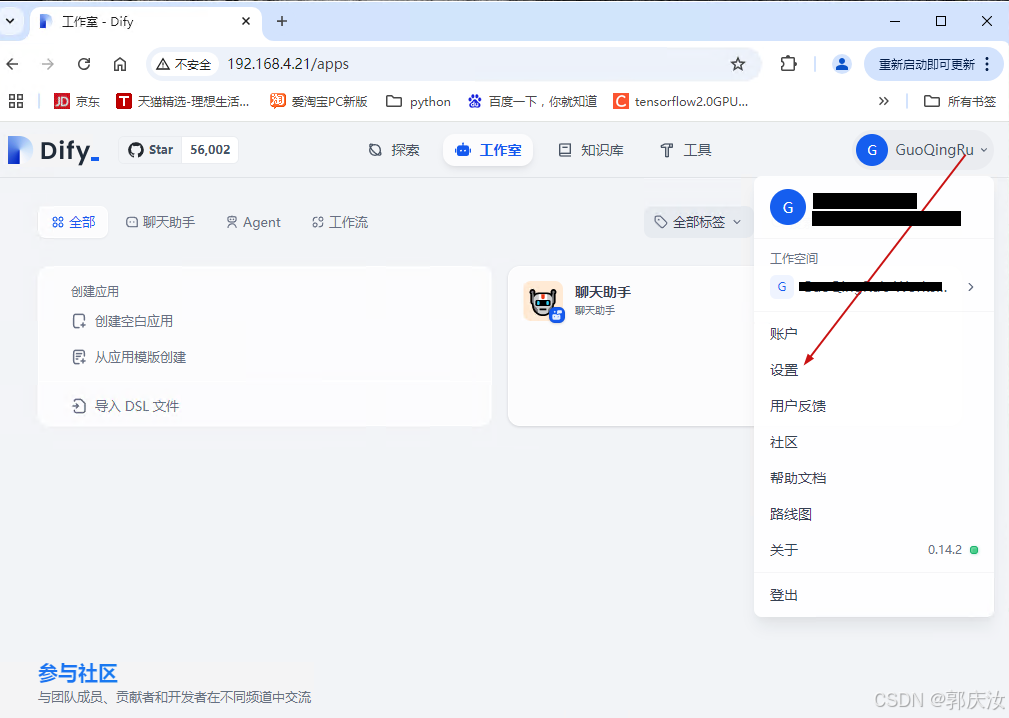

进项如下设置

保存完毕后,回到如下页面

依次点击工作室 →创建空白应用

按照上述设置后,聊天助手边创建完毕,如下所示:

4、使用Dify搭建本地知识库

首先拉取嵌入模型

ollama pull bge-m3

打开Dify

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)