DeepSeek-R1与RAGflow本地部署全流程指南:从模型下载到个人知识库构建实战

喂奶级手把手教你本地部署DeepSeek-R1(震撼提供Ollma加速下载包)_ollma网盘下载-CSDN博客DeepSeek R1 是2025年1月20日发布的,中国公司的伟大成就。分离式训练推理代码,仅开源推理代码,可以本地部署进行模型推理,使用DeepSeek-R1,却不可以训练,参观源码。_ollma网盘下载通过ollama下载模型。

❀一 下载ollama,通过ollama将DeepSeek和Embedding模型都下载到本地;

喂奶级手把手教你本地部署DeepSeek-R1(震撼提供Ollma加速下载包)_ollma网盘下载-CSDN博客文章浏览阅读682次,点赞22次,收藏8次。DeepSeek R1 是2025年1月20日发布的,中国公司的伟大成就。分离式训练推理代码,仅开源推理代码,可以本地部署进行模型推理,使用DeepSeek-R1,却不可以训练,参观源码。_ollma网盘下载 https://blog.csdn.net/qq_51831335/article/details/145857163?fromshare=blogdetail&sharetype=blogdetail&sharerId=145857163&sharerefer=PC&sharesource=qq_51831335&sharefrom=from_link

https://blog.csdn.net/qq_51831335/article/details/145857163?fromshare=blogdetail&sharetype=blogdetail&sharerId=145857163&sharerefer=PC&sharesource=qq_51831335&sharefrom=from_link

通过ollama下载模型deepseek-r1:1.5b,即是运行命令:

ollama run deepseek-r1:1.5b;❀二 下载RAGflow源代码和docker,通过docker本地部署RAGflow;

🎈2.1 下载RAGflow源代码和修改配置

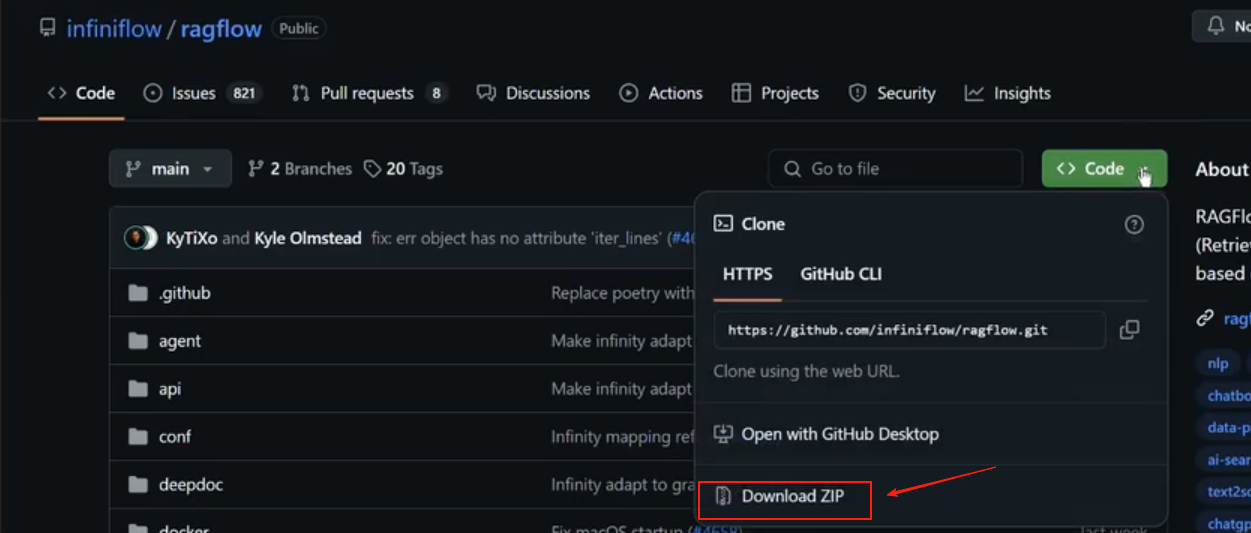

GitHub - infiniflow/ragflow: RAGFlow is an open-source RAG (Retrieval-Augmented Generation) engine based on deep document understanding.![]() https://github.com/infiniflow/ragflow直接去看README,有详细下载、按照、部署教程,如果没有git,可以直接下载zip包。

https://github.com/infiniflow/ragflow直接去看README,有详细下载、按照、部署教程,如果没有git,可以直接下载zip包。

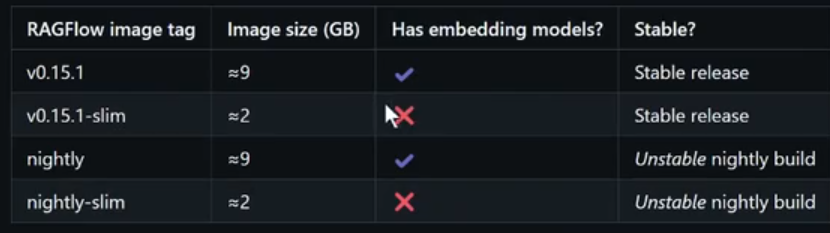

【修改配置】: 如果不修改配置,会默认下载轻量版(不带Embedding模型),这是一个很糟糕的选择,需要去本地部署了,很麻烦。

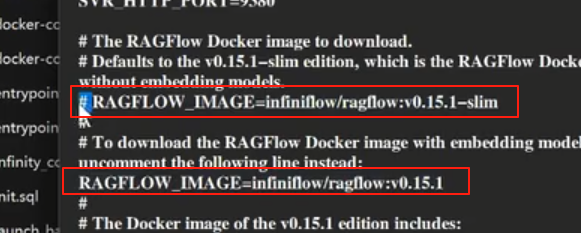

1 打开env文件

2 注释掉RAGFLOW_IMAGE=infiniflow/ragflow:v0.15.1-slim 并取消注释RAGFLOW_IMAGE=infiniflow/ragflow:v0.15.1

这些都是需要梯子才能下载的,再往下面看看,会有华为云和阿里云的镜像,国内不用梯子也能下载。

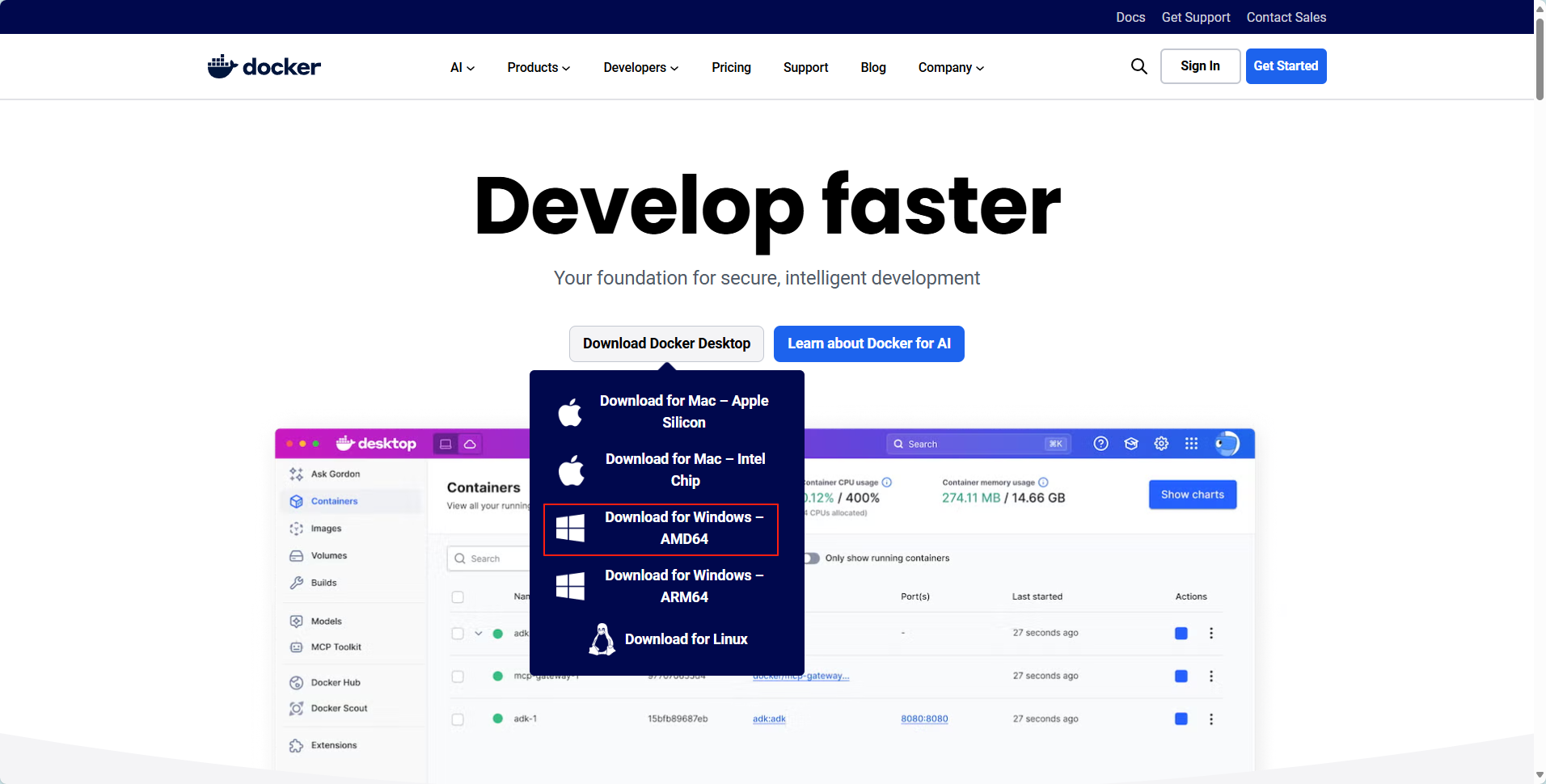

🎈2.2 下载Docker

Docker 镜像是一个封装好的环境,包含了所有运行 RAGFlow 所需的依赖、库和配置如果安装遇到踩坑,可以自行搜索一下报错或者问一下gpt;如果镜像拉不下来,试试修改docker的镜像源;

Docker: Accelerated Container Application Development![]() https://www.docker.com/

https://www.docker.com/

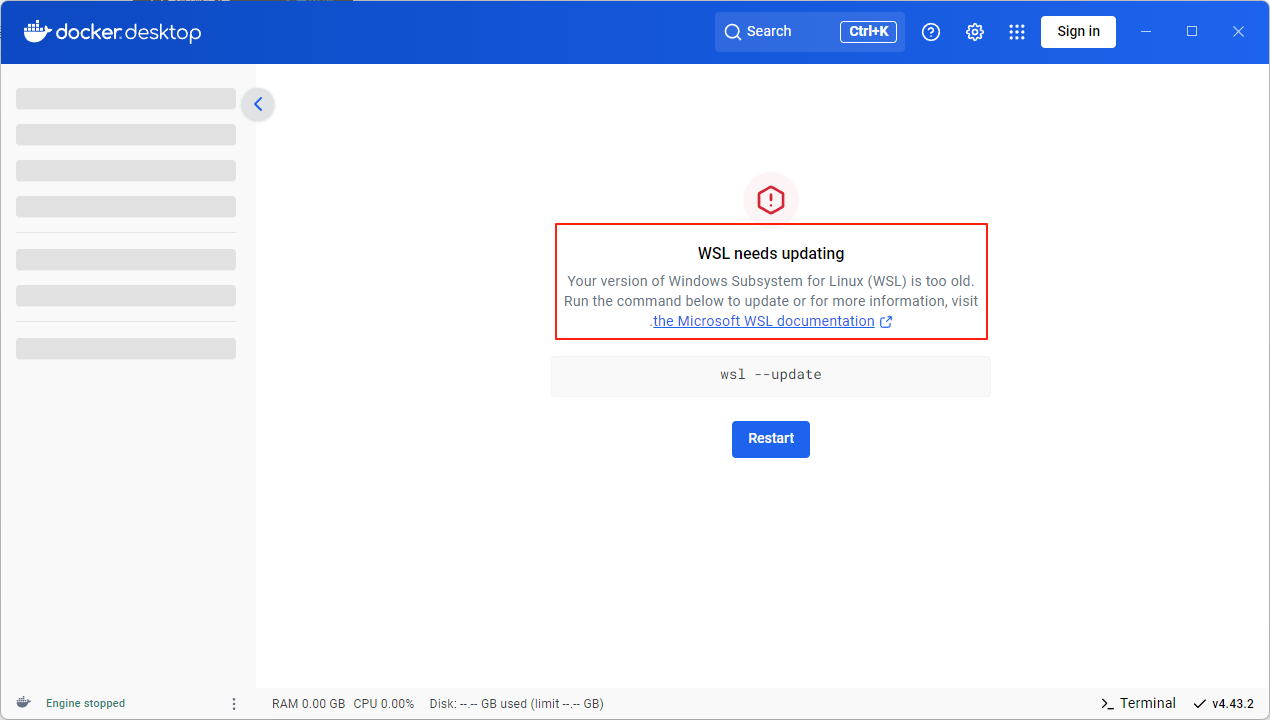

如果出现以下报错:

或者直接以管理员身份打开Windows PowerShell输入命令:

wsl --install❀三.在RAGflow中构建个人知识库并实现基于个人知识库的对话问答

🎈3.1 在ragflow-main文件夹打开cmd 然后输入下面命令 下载rawflow镜像:

【运行拉取的所有容器-CPU】:

docker compose -f docker/docker-compose.yml up -d 【运行拉取的所有容器-GGPU】:

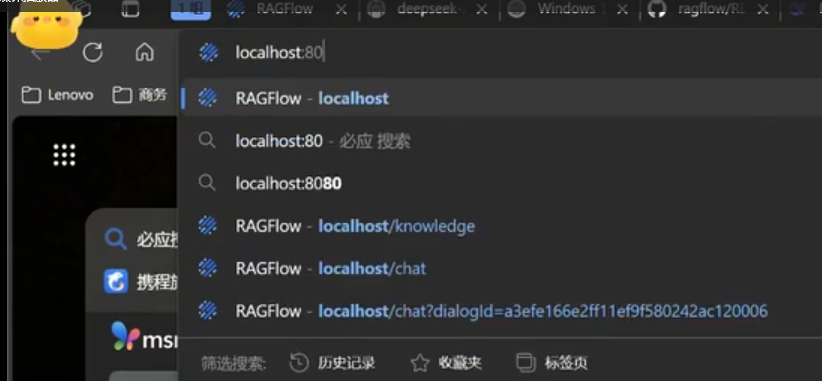

docker compose -f docker-compose-gpu.yml up -d🎈3.2 在这里应该已经部署成功了,这个时候打开网址,并输入:

localhost:80

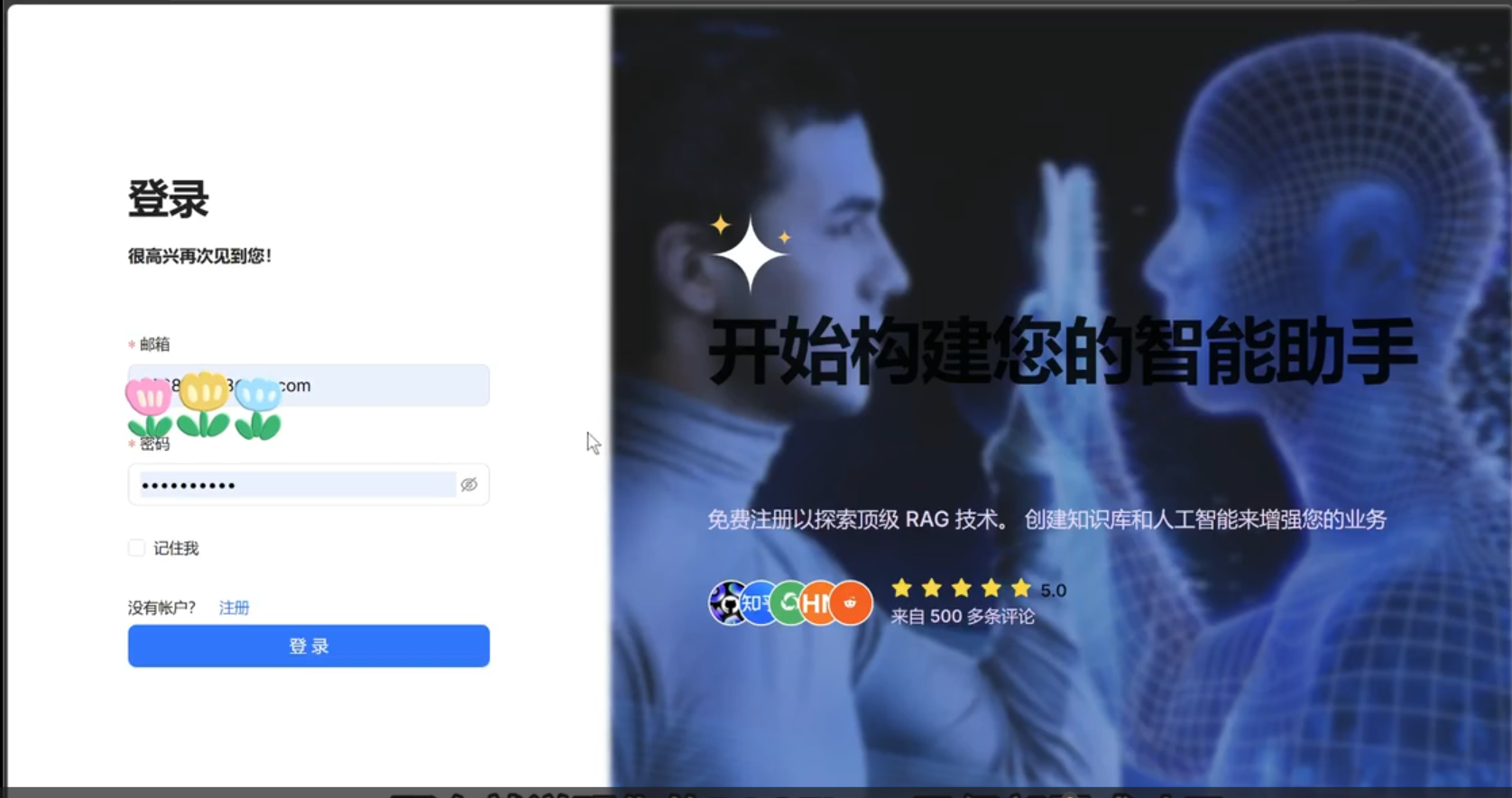

如果出现下面界面,那么就是运行成功了!

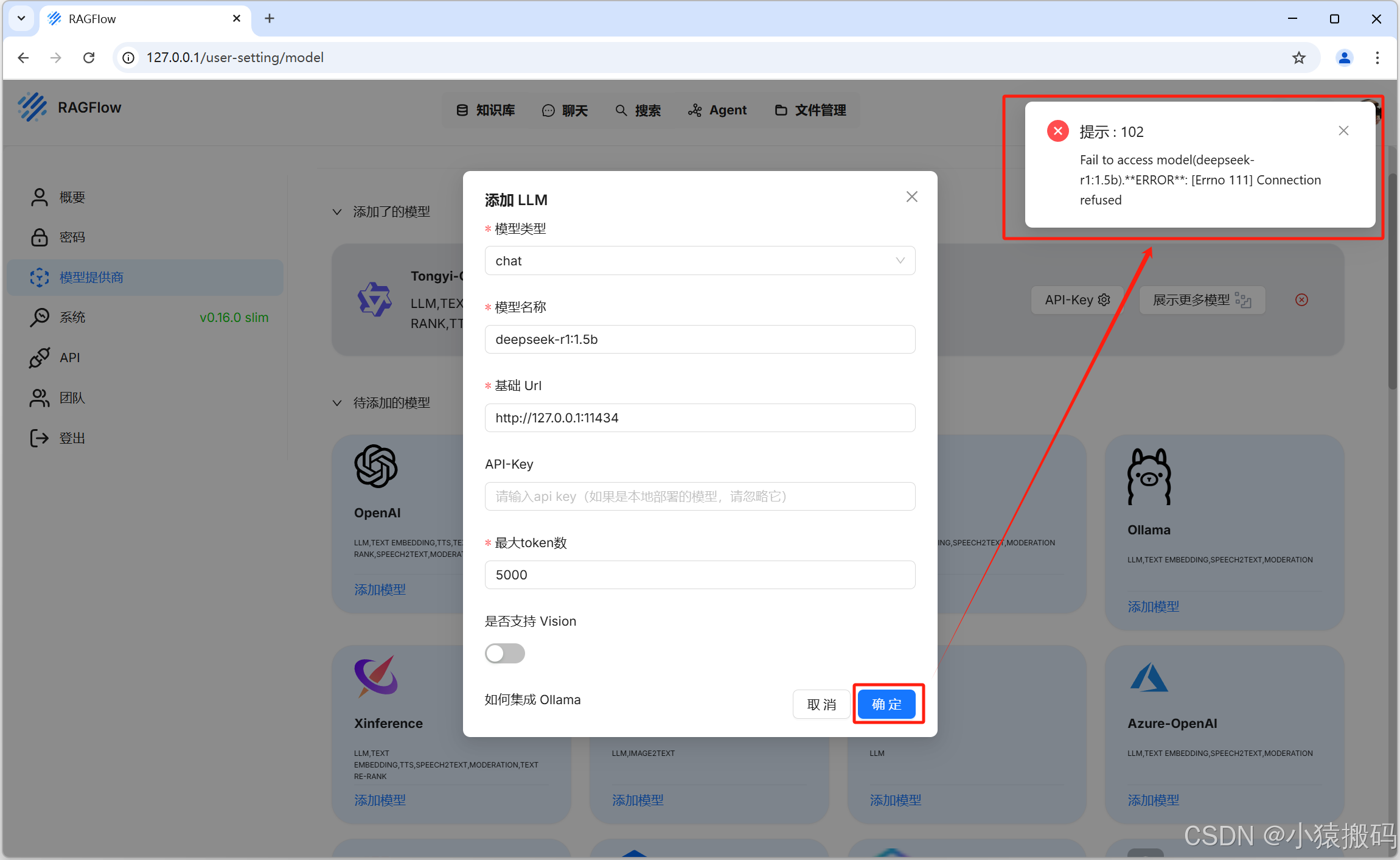

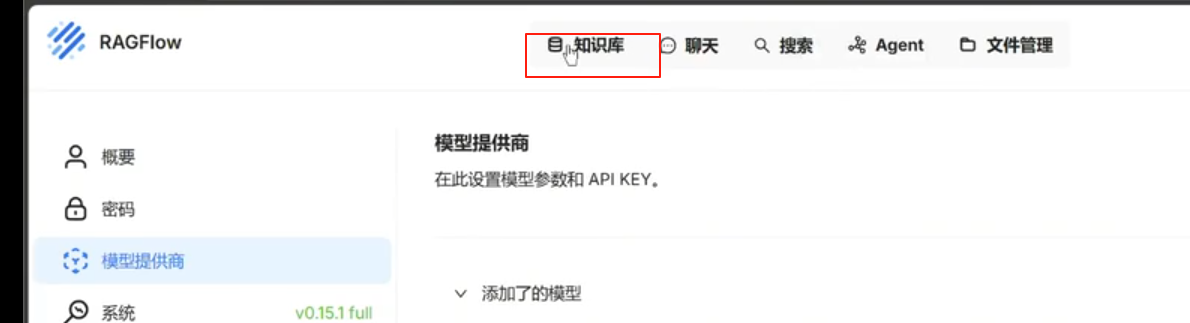

🎈 3.3 在系统模型设置中配置chat模型

可能会报错:

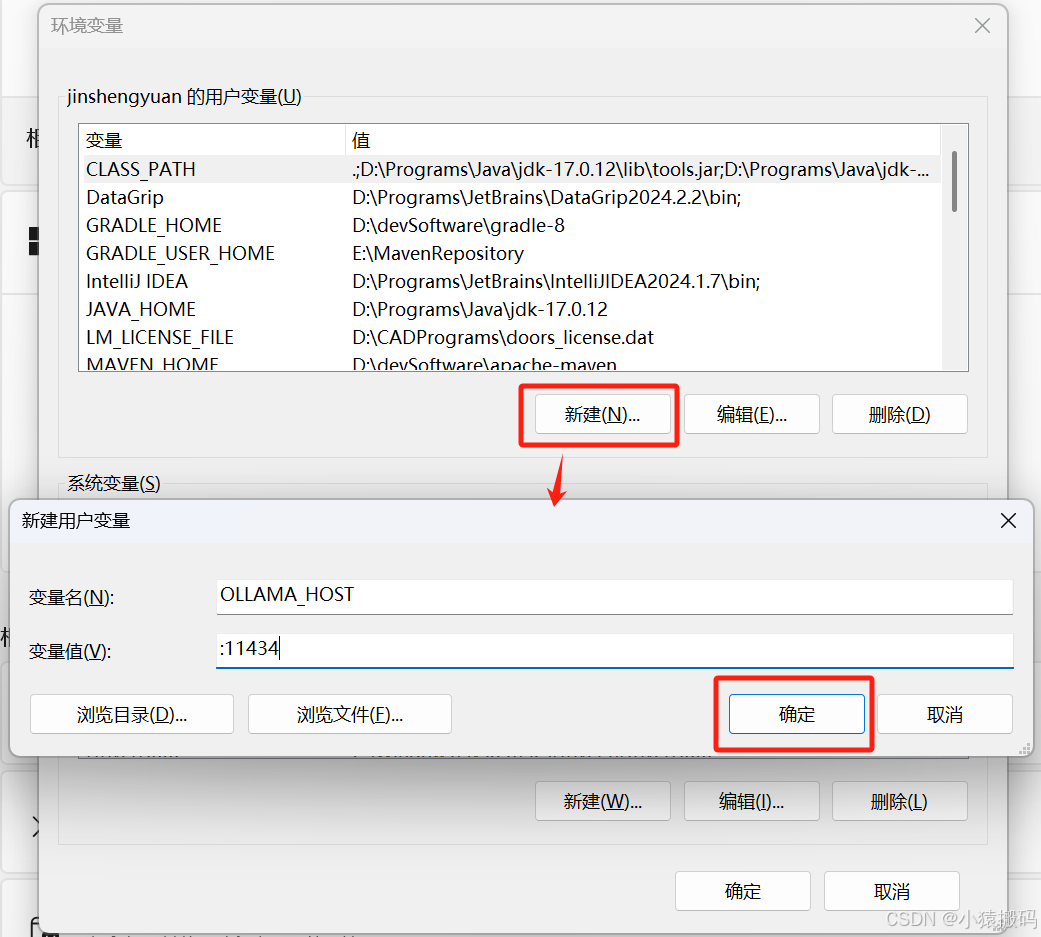

更改Ollama监听端口使其在所有域名上都生效

新建一个环境变量,具体配置如下:

变量名:OLLAMA_HOST

变量值::11434

端口可以任意修改,冒号前保持为空相当于在所有

IPv4和IPv6地址上监听

退出Ollma客户端然后打开应用重新进入,别ollama serve

🎈 3.4 创建知识库,上传文件,解析文件;

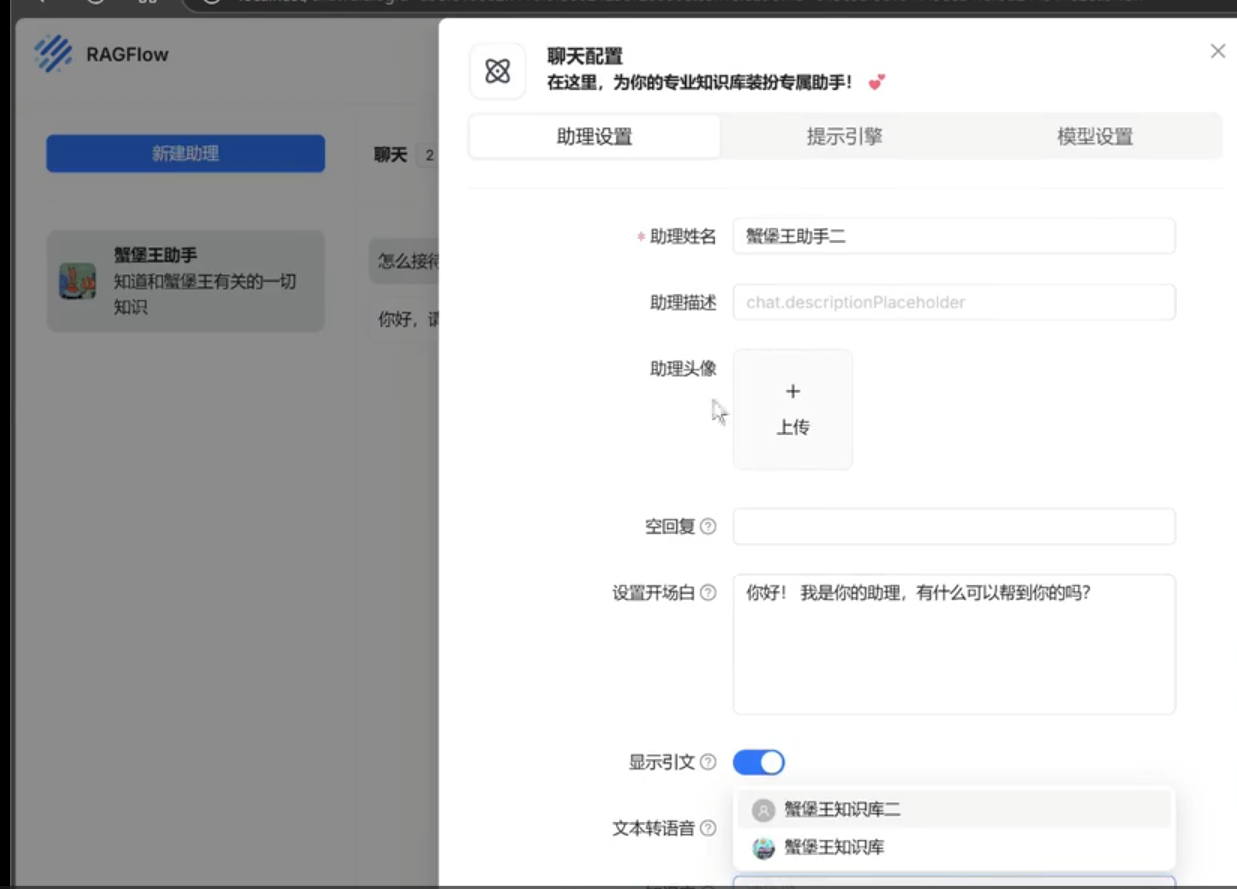

🎈 3.5 创建聊天助手(注意prompt和tokens的配置);

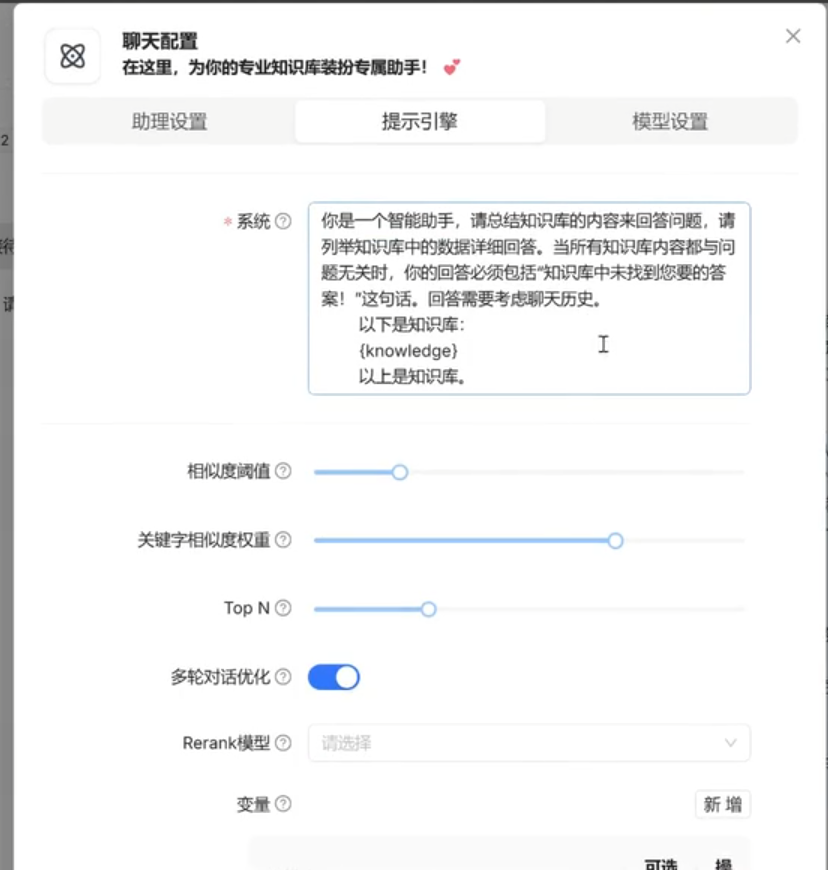

都很简单,随便弄一个对“助理设置”,“提示引擎”,“模型设置”的模板设置图参考即可:

可以试着写一个更好的提示词,比如使得面对不会的问题时候,不要简单的回答我不知道 等。

最大Token数量拉大一些,不然回答会变得特别短。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)