本地知识库工具FASTGPT的安装与搭建

FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,将智能对话与可视化编排完美结合,让 AI 应用开发变得简单自然。无论您是开发者还是业务人员,都能轻松打造专属的 AI 应用。

FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,将智能对话与可视化编排完美结合,让 AI 应用开发变得简单自然。无论您是开发者还是业务人员,都能轻松打造专属的 AI 应用。

今天来试着搭建下,使用docker安装比较简单,推荐使用docker安装。

看下推荐配置,fastgpt还分了不同的版本,一般的电脑配置都可以。

1、首先贴上git地址与文档地址

https://github.com/labring/FastGPT

https://doc.tryfastgpt.ai/docs/intro/

2、docker、docker-compose的安装部署参考Ubuntu上docker、docker-compose的安装,win的wsl也适用。

3、下载代码

git clone https://github.com/labring/FastGPT4、下载config文件,也可直接新建文件将下面代码复制进去。

// 已使用 json5 进行解析,会自动去掉注释,无需手动去除{"feConfigs": {"lafEnv": "https://laf.dev", // laf环境。 https://laf.run (杭州阿里云) ,或者私有化的laf环境。如果使用 Laf openapi 功能,需要最新版的 laf 。"mcpServerProxyEndpoint": "" // mcp server 代理地址,例如: http://localhost:3005},"systemEnv": {"vectorMaxProcess": 10, // 向量处理线程数量"qaMaxProcess": 10, // 问答拆分线程数量"vlmMaxProcess": 10, // 图片理解模型最大处理进程"tokenWorkers": 30, // Token 计算线程保持数,会持续占用内存,不能设置太大。"hnswEfSearch": 100, // 向量搜索参数,仅对 PG 和 OB 生效。越大,搜索越精确,但是速度越慢。设置为100,有99%+精度。"customPdfParse": {"url": "", // 自定义 PDF 解析服务地址"key": "", // 自定义 PDF 解析服务密钥"doc2xKey": "", // doc2x 服务密钥"price": 0 // PDF 解析服务价格}}}

5、接着下载docker-compose.yml文件

curl -o docker-compose.yml https://raw.githubusercontent.com/labring/FastGPT/main/deploy/docker/docker-compose-pgvector.yml也可像上一步一样新建一个yml文件,直接粘贴进去。

6、docker 拉取镜像,启动

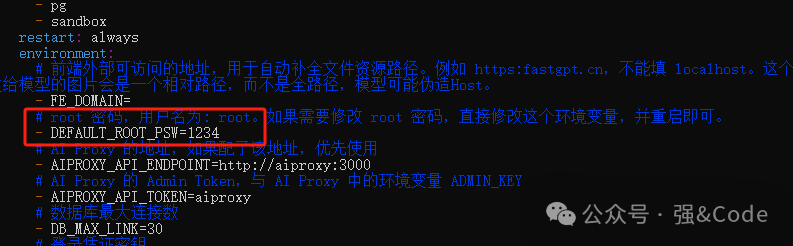

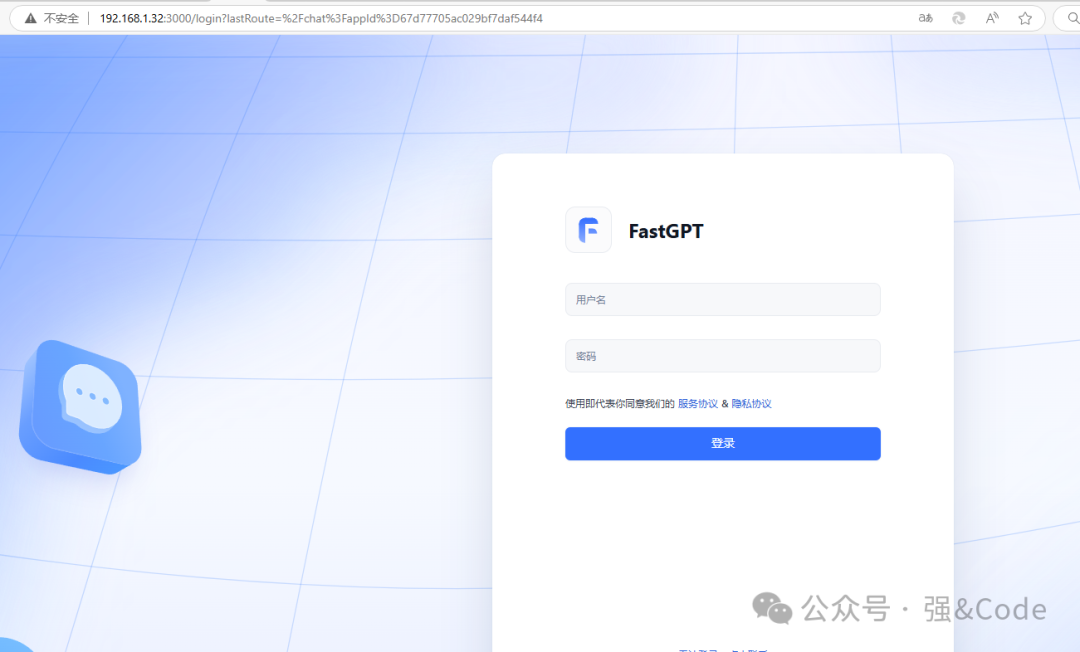

sudo docker-compose up -d7、默认端口3000,默认账号root 密码 1234,密码可在docker-compose.yml文件中修改。记得修改后重启即可。最好将地址映射成https的地址。

8、接着咱们来配置本地部署的大模型工具ollama

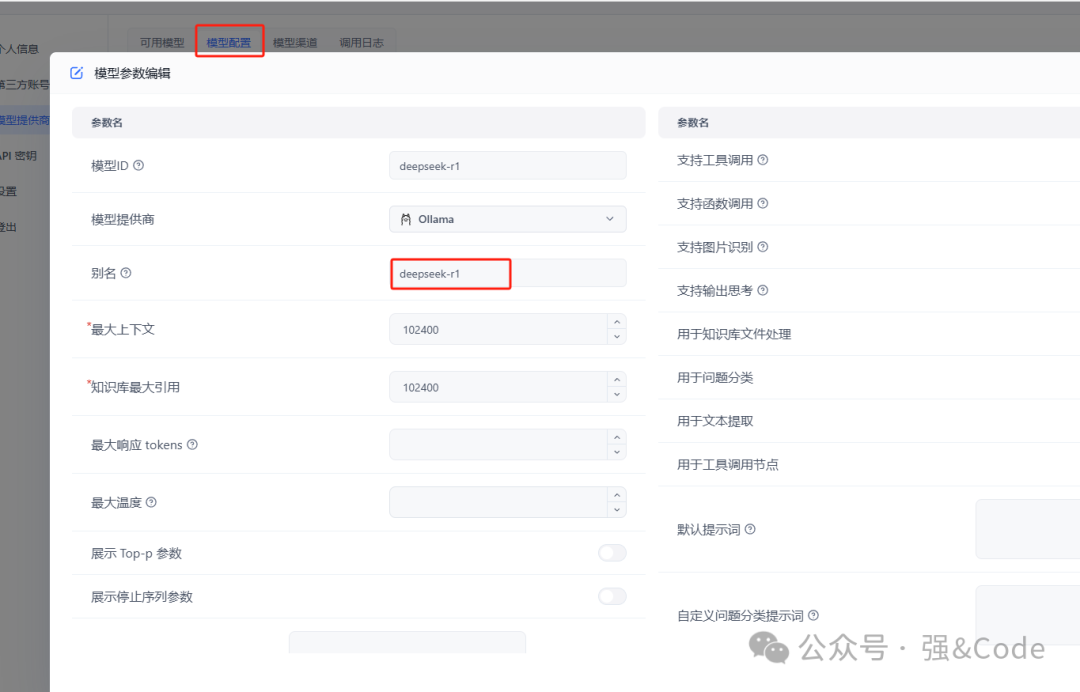

按照如图所示依次填写。

然后再在模型配置页面添加ollama下面安装好的模型即可。

这就是我搭建的整个过程,大家在搭建的过程中有什么问题的话欢迎留言,大家一起讨论学习。

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此,我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包,现在将这份 LLM大模型资料 分享出来: 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

更多推荐

已为社区贡献59条内容

已为社区贡献59条内容

所有评论(0)