RAG 知识库进阶

添加文档到向量库从向量库删除文档基于查询进行相似度搜索获取原生客户端(用于特定实现的高级操作)

1、文档收集和切割 - ETL

文档收集和切割阶段,我们要对自己准备好的知识库文档进行处理,然后保存到向量数据库中。这个过程俗称 ETL(抽取、转换、加载)。官方文档

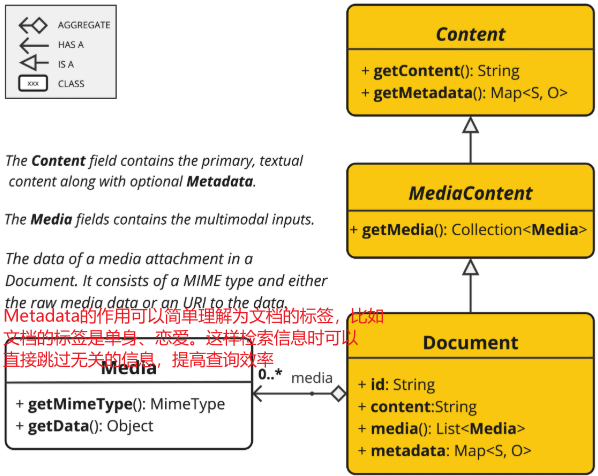

1.1、文档

文档不仅仅包含文本,还可以包含一系列元信息和多媒体附件:

1.2、ETL

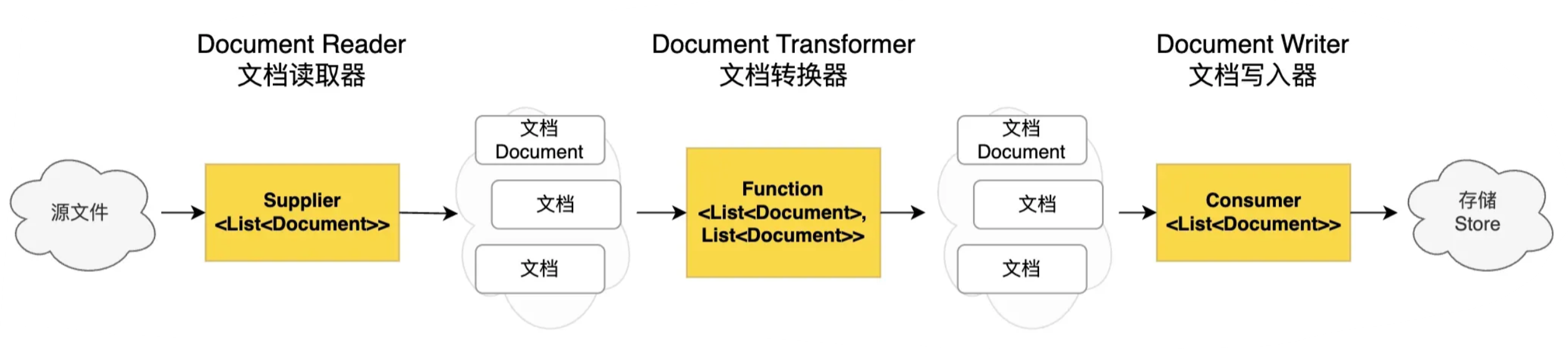

在 Spring AI 中,对 Document 的处理通常遵循以下流程:

- 读取文档:使用 DocumentReader 组件从数据源(如本地文件、网络资源、数据库等)加载文档。

- 转换文档:根据需求将文档转换为适合后续处理的格式,比如去除冗余信息、分词、词性标注等,可以使用 DocumentTransformer组件实现。

- 写入文档:使用 DocumentWriter 将文档以特定格式保存到存储中,比如将文档以嵌入向量的形式写入到向量数据库,或者以键值对字符串的形式保存到 Redis 等 KV 存储中。

1.3、抽取(Extract)

Spring AI 通过 DocumentReader 组件实现文档抽取,也就是把文档加载到内存中。

看下源码,DocumentReader 接口实现了 Supplier<List> 接口,主要负责从各种数据源读取数据并转换为 Document 对象集合。

public interface DocumentReader extends Supplier<List<Document>> {

default List<Document> read() {

return get();

}

}

1.4、转换(Transform)

Spring AI 通过 DocumentTransformer 组件实现文档转换。

看下源码,DocumentTransformer 接口实现了 Function<List, List> 接口,负责将一组文档转换为另一组文档。

public interface DocumentTransformer extends Function<List<Document>, List<Document>> {

default List<Document> transform(List<Document> documents) {

return apply(documents);

}

}

1.4.1 TextSplitter 文本分割器

TextSplitter 是文本分割器的基类,提供了分割单词的流程方法,TokenTextSplitter 是其实现类,基于 Token 的文本分割器。它考虑了语义边界(比如句子结尾)来创建有意义的文本段落,是成本较低的文本切分方式。

@Component

class MyTokenTextSplitter {

public List<Document> splitDocuments(List<Document> documents) {

TokenTextSplitter splitter = new TokenTextSplitter();

return splitter.apply(documents);

}

public List<Document> splitCustomized(List<Document> documents) {

TokenTextSplitter splitter = new TokenTextSplitter(1000, 400, 10, 5000, true);

return splitter.apply(documents);

}

}

TokenTextSplitter 提供了两种构造函数选项:

- TokenTextSplitter():使用默认设置创建分割器。

- TokenTextSplitter(int defaultChunkSize, int minChunkSizeChars, int minChunkLengthToEmbed, int maxNumChunks, boolean keepSeparator):使用自定义参数创建分割器,通过调整参数,可以控制分割的粒度和方式,适应不同的应用场景。

参数说明(无需记忆):

- defaultChunkSize:每个文本块的目标大小(以 token 为单位,默认值:800)。

- minChunkSizeChars:每个文本块的最小大小(以字符为单位,默认值:350)

- minChunkLengthToEmbed:要被包含的块的最小长度(默认值:5)。

- maxNumChunks:从文本中生成的最大块数(默认值:10000)。

- keepSeparator:是否在块中保留分隔符(如换行符)(默认值:true)。

1.4.2 MetadataEnricher 元数据增强器

元数据增强器的作用是为文档补充更多的元信息,便于后续检索,而不是改变文档本身的切分规则。包括:

- KeywordMetadataEnricher:使用 AI 提取关键词并添加到元数据

- SummaryMetadataEnricher:使用 AI 生成文档摘要并添加到元数据。不仅可以为当前文档生成摘要,还能关联前一个和后一个相邻的文档,让摘要更完整。

@Component

class MyDocumentEnricher {

private final ChatModel chatModel;

MyDocumentEnricher(ChatModel chatModel) {

this.chatModel = chatModel;

}

// 关键词元信息增强器

List<Document> enrichDocumentsByKeyword(List<Document> documents) {

KeywordMetadataEnricher enricher = new KeywordMetadataEnricher(this.chatModel, 5);

return enricher.apply(documents);

}

// 摘要元信息增强器

List<Document> enrichDocumentsBySummary(List<Document> documents) {

SummaryMetadataEnricher enricher = new SummaryMetadataEnricher(chatModel,

List.of(SummaryType.PREVIOUS, SummaryType.CURRENT, SummaryType.NEXT));

return enricher.apply(documents);

}

}

1.5、加载(Load)

Spring AI 通过 DocumentWriter 组件实现文档加载(写入)。

DocumentWriter 接口实现了 Consumer<List> 接口,负责将处理后的文档写入到目标存储中:

public interface DocumentWriter extends Consumer<List<Document>> {

default void write(List<Document> documents) {

accept(documents);

}

}

1.5.1、FileDocumentWriter:将文档写入到文件系统

@Component

class MyDocumentWriter {

public void writeDocuments(List<Document> documents) {

FileDocumentWriter writer = new FileDocumentWriter("output.txt", true, MetadataMode.ALL, false);

writer.accept(documents);

}

}

1.5.2、VectorStoreWriter:将文档写入到向量数据库

@Component

class MyVectorStoreWriter {

private final VectorStore vectorStore;

MyVectorStoreWriter(VectorStore vectorStore) {

this.vectorStore = vectorStore;

}

public void storeDocuments(List<Document> documents) {

vectorStore.accept(documents);

}

}

1.6、ETL 流程示例

将上述 3 大组件组合起来,可以实现完整的 ETL 流程:

// 抽取:从 PDF 文件读取文档

PDFReader pdfReader = new PagePdfDocumentReader("knowledge_base.pdf");

List<Document> documents = pdfReader.read();

// 转换:分割文本并添加摘要

TokenTextSplitter splitter = new TokenTextSplitter(500, 50);

List<Document> splitDocuments = splitter.apply(documents);

SummaryMetadataEnricher enricher = new SummaryMetadataEnricher(chatModel,

List.of(SummaryType.CURRENT));

List<Document> enrichedDocuments = enricher.apply(splitDocuments);

// 加载:写入向量数据库

vectorStore.write(enrichedDocuments);

// 或者使用链式调用

vectorStore.write(enricher.apply(splitter.apply(pdfReader.read())));

2、向量转换和存储

向量存储是 RAG 应用中的核心组件,它将文档转换为向量(嵌入)并存储起来,以便后续进行高效的相似性搜索。Spring AI 官方 提供了向量数据库接口 VectorStore 和向量存储整合包,帮助开发者快速集成各种第三方向量存储。

2.1、VectorStore 接口介绍

VectorStore 是 Spring AI 中用于与向量数据库交互的核心接口,它继承自 DocumentWriter,提供的功能简单来说就是 “增删改查”:

- 添加文档到向量库

- 从向量库删除文档

- 基于查询进行相似度搜索

- 获取原生客户端(用于特定实现的高级操作)

2.2、搜索请求构建

Spring AI 提供了 SearchRequest 类,用于构建相似度搜索请求:

SearchRequest request = SearchRequest.builder()

.query("什么是时序逻辑语言")

.topK(5) // 返回最相似的5个结果

.similarityThreshold(0.7) // 相似度阈值,0.0-1.0之间

.filterExpression("category == 'web' AND date > '2025-05-03'") // 过滤表达式

.build();

List<Document> results = vectorStore.similaritySearch(request);

SearchRequest 提供了多种配置选项:

- query:搜索的查询文本 topK:返回的最大结果数,默认为4

- similarityThreshold:相似度阈值,低于此值的结果会被过滤掉

- filterExpression:基于文档元数据的过滤表达式,语法有点类似 SQL 语句,需要用到时查询 官方文档 了解语法即可

2.3、向量存储的工作原理

在向量数据库中,查询与传统关系型数据库有所不同。向量库执行的是相似性搜索,而非精确匹配,具体流程我们在上一节教程中有了解,可以再复习下。

- 嵌入转换:当文档被添加到向量存储时,Spring AI 会使用嵌入模型(如 OpenAI 的text-embedding-ada-002)将文本转换为向量。

- 相似度计算:查询时,查询文本同样被转换为向量,然后系统计算此向量与存储中所有向量的相似度。 相似度度量:常用的相似度计算方法包括:

- 余弦相似度:计算两个向量的夹角余弦值,范围在-1到1之间 欧氏距离:计算两个向量间的直线距离 点积:两个向量的点积值

- 过滤与排序:根据相似度阈值过滤结果,并按相似度排序返回最相关的文档

2.4、支持的向量数据库

对于每种 Vector Store 实现,我们都可以参考对应的官方文档进行整合,开发方法基本上一致:先准备好数据源 => 引入不同的整合包 => 编写对应的配置 => 使用自动注入的 VectorStore 即可。

值得一提的是,Spring AI Alibaba 已经集成了阿里云百炼平台,可以直接使用阿里云百炼平台提供的 VectorStore API,无需自己再搭建向量数据库了,要是提供了 DashScopeCloudStore 类。

2.5、基于 PGVector 实现向量存储

PGVector 是经典数据库 PostgreSQL 的扩展,为 PostgreSQL 提供了存储和检索高维向量数据的能力。

为什么选择它来实现向量存储呢?因为很多传统业务都会把数据存储在这种关系型数据库中,直接给原有的数据库安装扩展就能实现向量相似度搜索、而不需要额外搞一套向量数据库,人力物力成本都很低,所以这种方案很受企业青睐,也是目前实现 RAG 的主流方案之一。

2.6、文档过滤和检索

简单来说,就是把整个文档过滤检索阶段拆分为:检索前、检索时、检索后,分别针对每个阶段提供了可自定义的组件。

- 在预检索阶段,系统接收用户的原始查询,通过查询转换和查询扩展等方法对其进行优化,输出增强的用户查询。

- 在检索阶段,系统使用增强的查询从知识库中搜索相关文档,可能涉及多个检索源的合并,最终输出一组相关文档。

- 在检索后阶段,系统对检索到的文档进行进一步处理,包括排序、选择最相关的子集以及压缩文档内容,输出经过优化的相关文档集。

2.6.1、查询转换 - 查询重写

RewriteQueryTransformer 使用大语言模型对用户的原始查询进行改写,使其更加清晰和详细。当用户查询含糊不清或包含无关信息时,这种方法特别有用。

Query query = new Query("啥是时序逻辑证明啊啊啊啊?");

QueryTransformer queryTransformer = RewriteQueryTransformer.builder()

.chatClientBuilder(chatClientBuilder)

.build();

Query transformedQuery = queryTransformer.transform(query);

2.6.2、查询转换 - 查询翻译

TranslationQueryTransformer 将查询翻译成嵌入模型支持的目标语言。如果查询已经是目标语言,则保持不变。这对于嵌入模型是针对特定语言训练而用户查询使用不同语言的情况非常有用,便于实现国际化应用。

Query query = new Query("hi, who is coder yuAn? please answer me");

QueryTransformer queryTransformer = TranslationQueryTransformer.builder()

.chatClientBuilder(chatClientBuilder)

.targetLanguage("chinese")

.build();

Query transformedQuery = queryTransformer.transform(query);

2.6.3、查询转换 - 查询压缩

CompressionQueryTransformer 使用大语言模型将对话历史和后续查询压缩成一个独立的查询,类似于概括总结。适用于对话历史较长且后续查询与对话上下文相关的场景。

Query query = Query.builder()

.text("时序逻辑语言有啥内容?")

.history(new UserMessage("什么是MSVL语言?"),

new AssistantMessage("MSVL是一种时序逻辑编程语言,它主要用于建模、仿真和形式化验证,适合描述系统随时间演化的行为。简单来说,MSVL 让你可以精准、结构化地描述一个系统在不同状态下的变化过程,并且支持自动验证系统是否满足某些时序逻辑性质。"))

.build();

QueryTransformer queryTransformer = CompressionQueryTransformer.builder()

.chatClientBuilder(chatClientBuilder)

.build();

Query transformedQuery = queryTransformer.transform(query);

2.6.4、查询扩展 - 多查询扩展

MultiQueryExpander 使用大语言模型将一个查询扩展为多个语义上不同的变体,有助于检索额外的上下文信息并增加找到相关结果的机会。就理解为我们在网上搜东西的时候,可能一种关键词搜不到,就会尝试一些不同的关键词。

MultiQueryExpander queryExpander = MultiQueryExpander.builder()

.chatClientBuilder(chatClientBuilder)

.numberOfQueries(3)

.build();

List<Query> queries = queryExpander.expand(new Query("啥是时序逻辑语言?它和 C 语言有什么区别?"));

2.6.5、检索:提高查询相关性——文档搜索

之前我们有了解过 DocumentRetriever 的概念,这是 Spring AI 提供的文档检索器。每种不同的存储方案都可能有自己的文档检索器实现类,比如 VectorStoreDocumentRetriever,从向量存储中检索与输入查询语义相似的文档。它支持基于元数据的过滤、设置相似度阈值、设置返回的结果数。

DocumentRetriever retriever = VectorStoreDocumentRetriever.builder()

.vectorStore(vectorStore)

.similarityThreshold(0.7)

.topK(5)

.filterExpression(new FilterExpressionBuilder()

.eq("type", "web")

.build())

.build();

List<Document> documents = retriever.retrieve(new Query("啥是时序逻辑语言"));

2.6.6、检索:提高查询相关性——文档合并

Spring AI 内置了 ConcatenationDocumentJoiner 文档合并器,通过连接操作,将基于多个查询和来自多个数据源检索到的文档合并成单个文档集合。在遇到重复文档时,会保留首次出现的文档,每个文档的分数保持不变。

Map<Query, List<List<Document>>> documentsForQuery = ...

DocumentJoiner documentJoiner = new ConcatenationDocumentJoiner();

List<Document> documents = documentJoiner.join(documentsForQuery);

3、查询增强和关联

生成阶段是 RAG 流程的最终环节,负责将检索到的文档与用户查询结合起来,为 AI 提供必要的上下文,从而生成更准确、更相关的回答

3.1、QuestionAnswerAdvisor 查询增强

当用户问题发送到 AI 模型时,Advisor 会查询向量数据库来获取与用户问题相关的文档,并将这些文档作为上下文附加到用户查询中。

ChatResponse response = ChatClient.builder(chatModel)

.build().prompt()

.advisors(new QuestionAnswerAdvisor(vectorStore))

.user(userText)

.call()

.chatResponse();

3.2、RetrievalAugmentationAdvisor 查询增强

Spring AI 提供的另一种 RAG 实现方式,它基于 RAG 模块化架构,提供了更多的灵活性和定制选项。

Advisor retrievalAugmentationAdvisor = RetrievalAugmentationAdvisor.builder()

.documentRetriever(VectorStoreDocumentRetriever.builder()

.similarityThreshold(0.50)

.vectorStore(vectorStore)

.build())

.build();

3.3、ContextualQueryAugmenter 空上下文处理

默认情况下,RetrievalAugmentationAdvisor 不允许检索的上下文为空。当没有找到相关文档时,它会指示模型不要回答用户查询。这是一种保守的策略,可以防止模型在没有足够信息的情况下生成不准确的回答。

但在某些场景下,我们可能希望即使在没有相关文档的情况下也能为用户提供回答,比如即使没有特定知识库支持也能回答的通用问题。可以通过配置 ContextualQueryAugmenter 上下文查询增强器来实现。

Advisor retrievalAugmentationAdvisor = RetrievalAugmentationAdvisor.builder()

.documentRetriever(VectorStoreDocumentRetriever.builder()

.similarityThreshold(0.50)

.vectorStore(vectorStore)

.build())

.queryAugmenter(ContextualQueryAugmenter.builder()

.allowEmptyContext(true)

.build())

.build();

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)