人工智能:模型与算法(八)

深度学习基础:前馈神经网络:参数优化早期多层神经网络被提出来时,缺乏对网络参数进行自动学习的有效方法。1986年, Hinton及其合作者发表了论文“Learning Representations by Back-propagating(BP) errors”,描述了利用BP算法自动训练神经网络。后向传播 (back-propagation)算法将神经网络模型预测结果与输入数据实际标签结果之间的

深度学习基础:

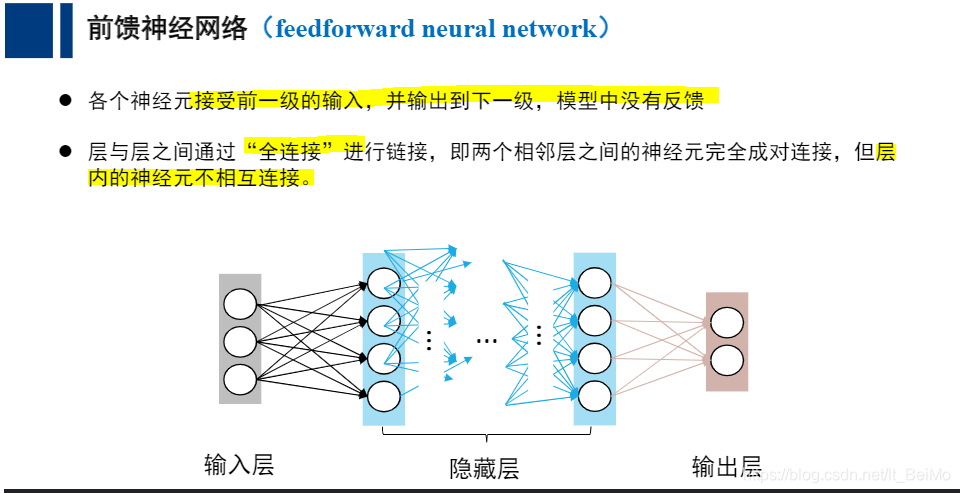

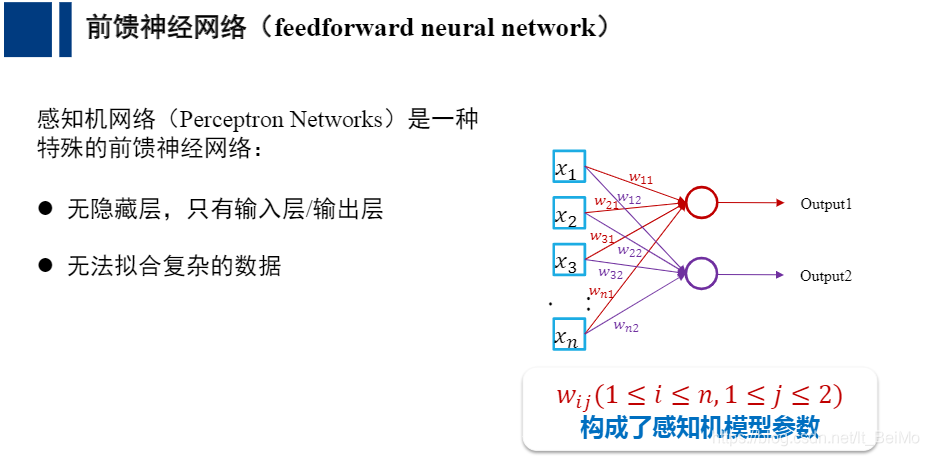

前馈神经网络:

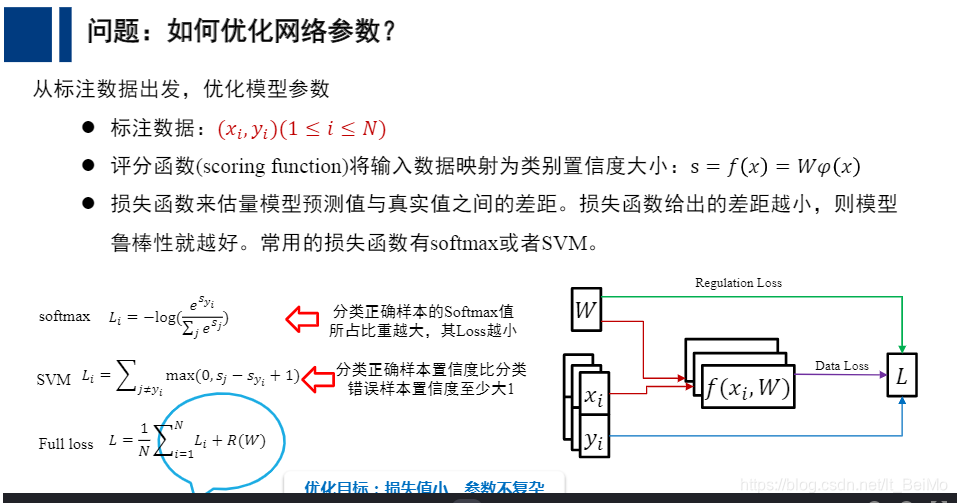

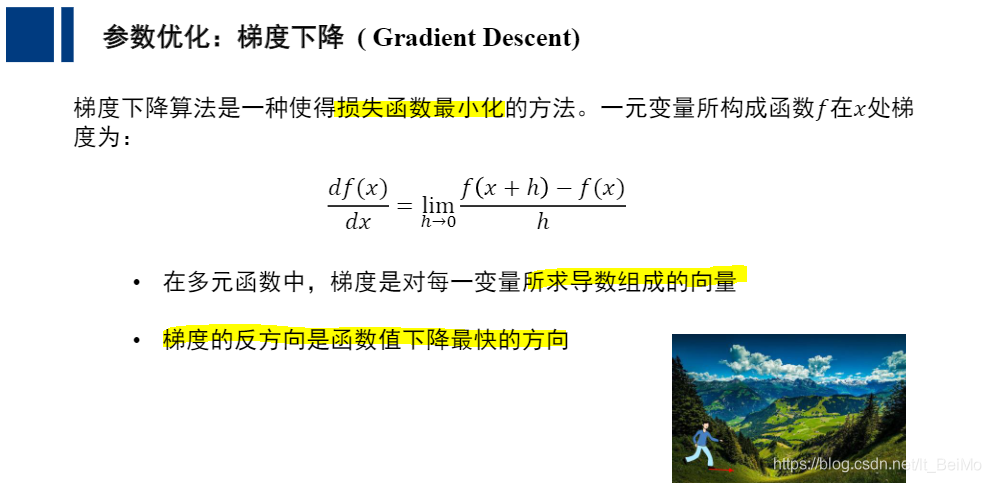

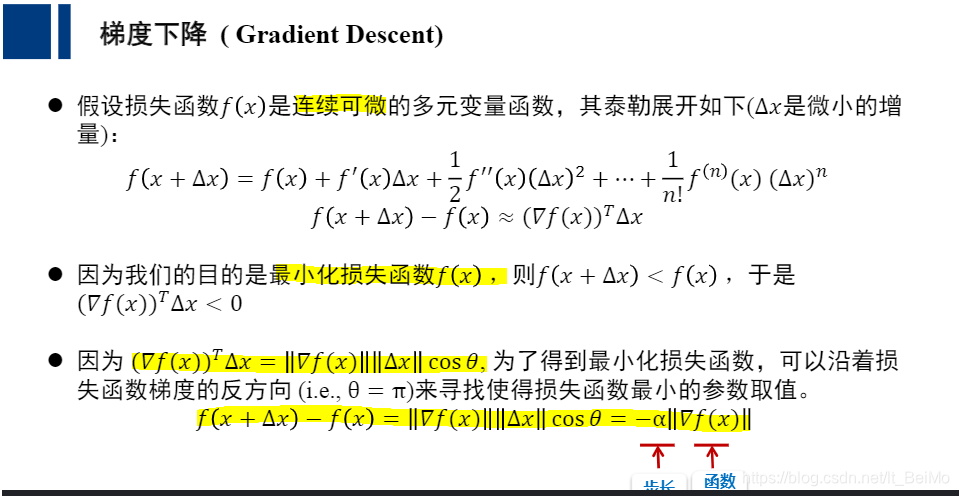

参数优化

早期多层神经网络被提出来时,缺乏对网络参数进行自动学习的有效方法。

1986年, Hinton及其合作者发表了论文“Learning Representations by Back-propagating(BP) errors”,描述了利用BP算法自动训练神经网络。

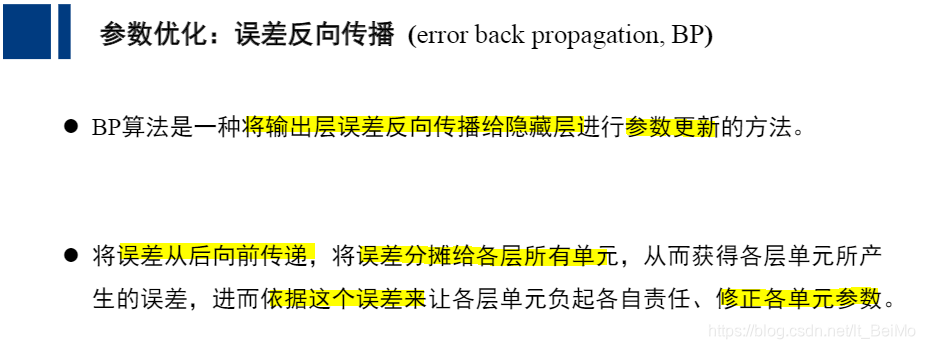

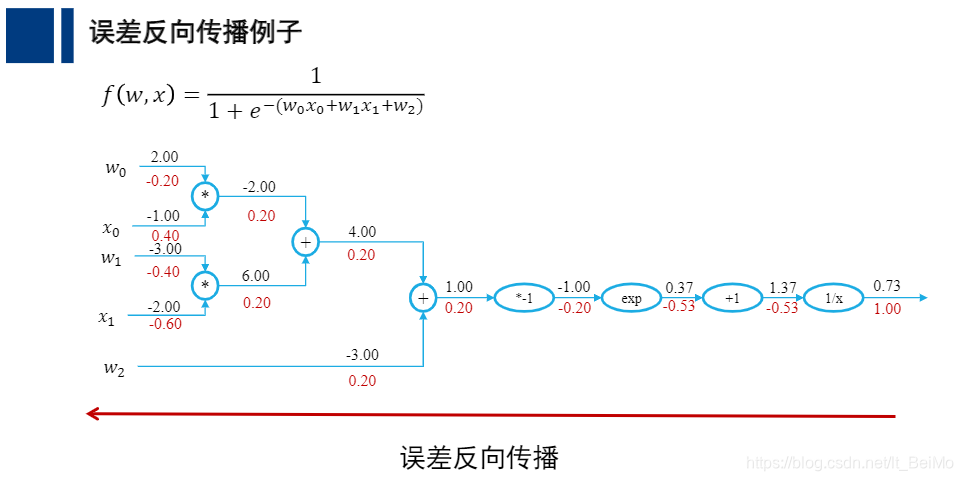

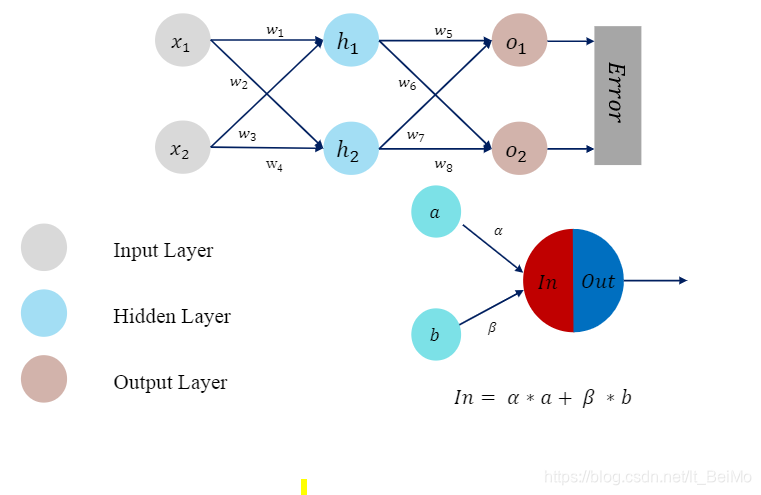

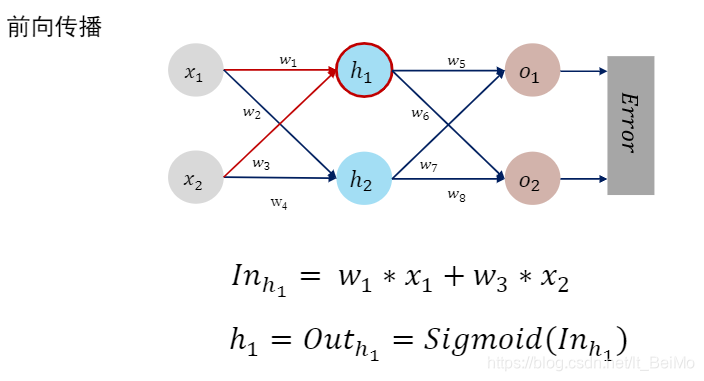

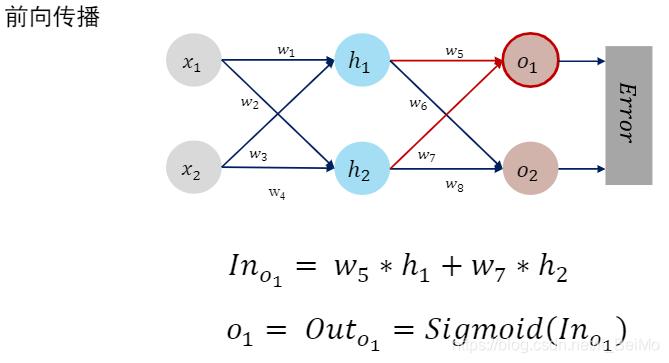

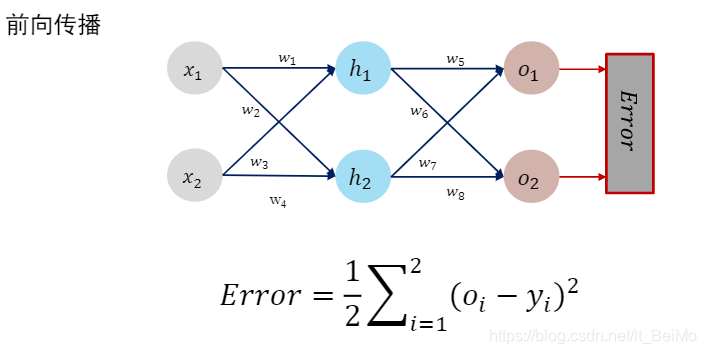

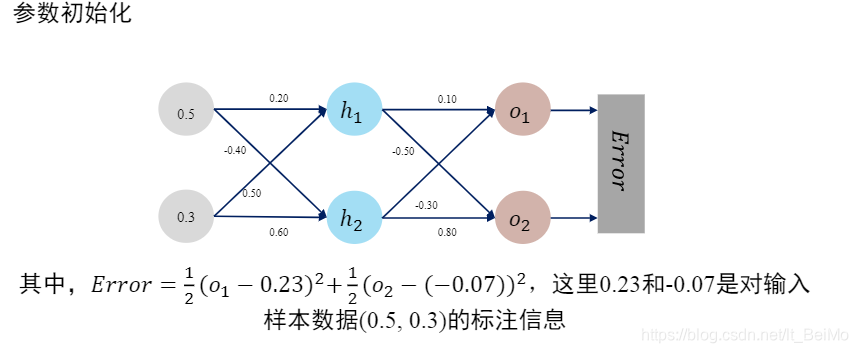

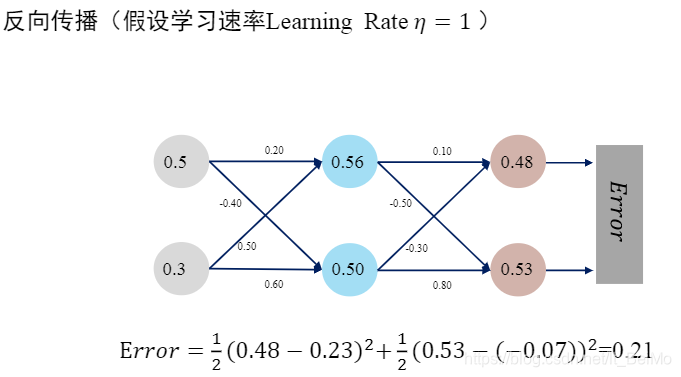

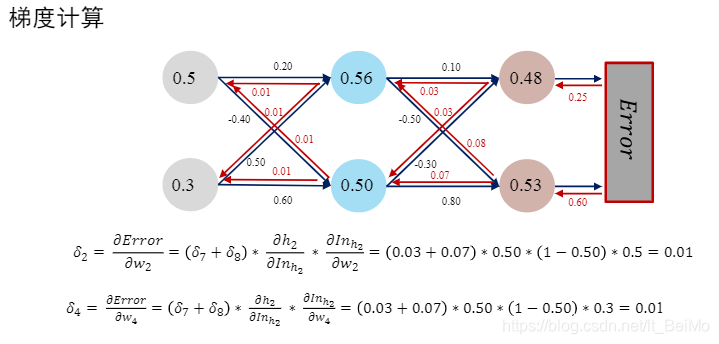

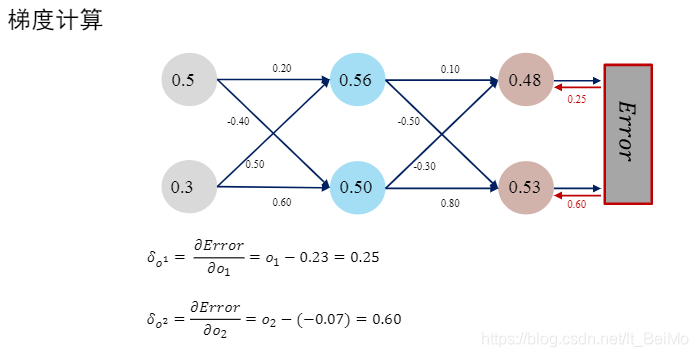

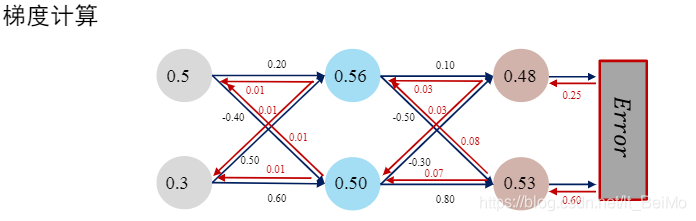

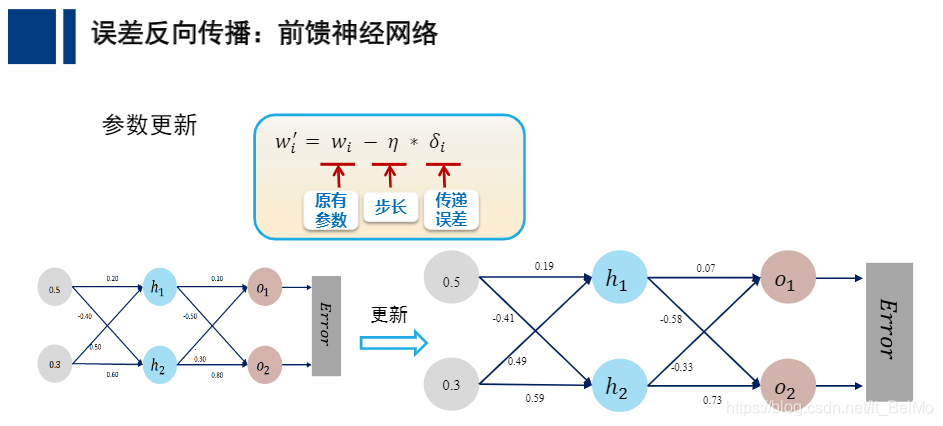

后向传播 (back-propagation)算法将神经网络模型预测结果与输入数据实际标签结果之间的误差向输出端传递过程中,自动调整神经网络模型参数(神经元之间的连接权重)。

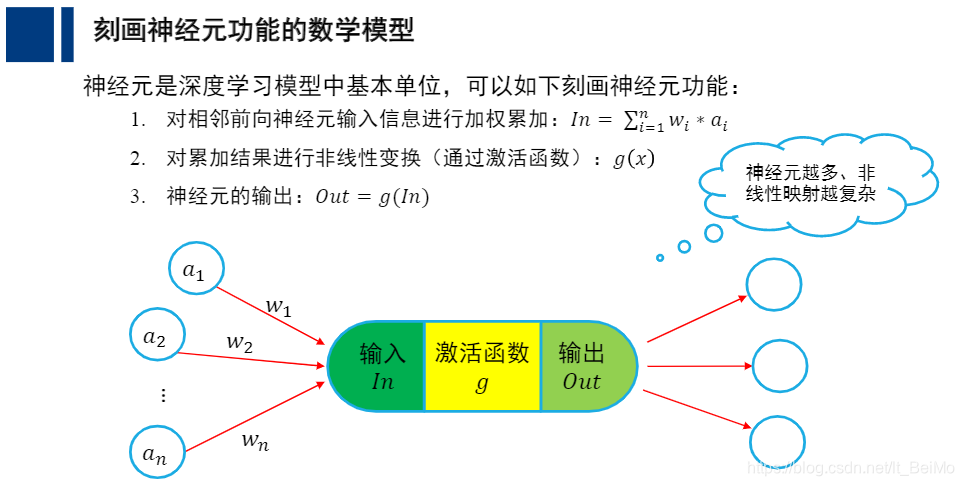

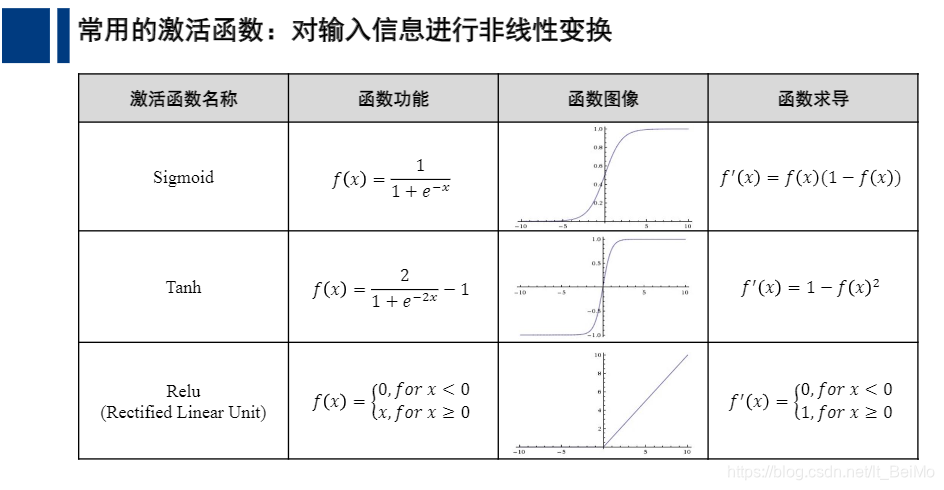

只要设计好模型结构,如网络隐藏层数目、每个隐藏层中包含的神经元数目、激活函数方式(Sigmoid或ReLu等激活函数)等,收集大量标注数据、应用能力强的计算架构,不断优化模型参数,就可以训练得到一个针对特定任务的神经网络

由于每个神经元实现了一种非线性映射,因此,网络隐藏层越多、神经元数目越多,神经网络的非线性映射就可越复杂,越能拟合复杂数据和复杂任务,最终取得良好效果

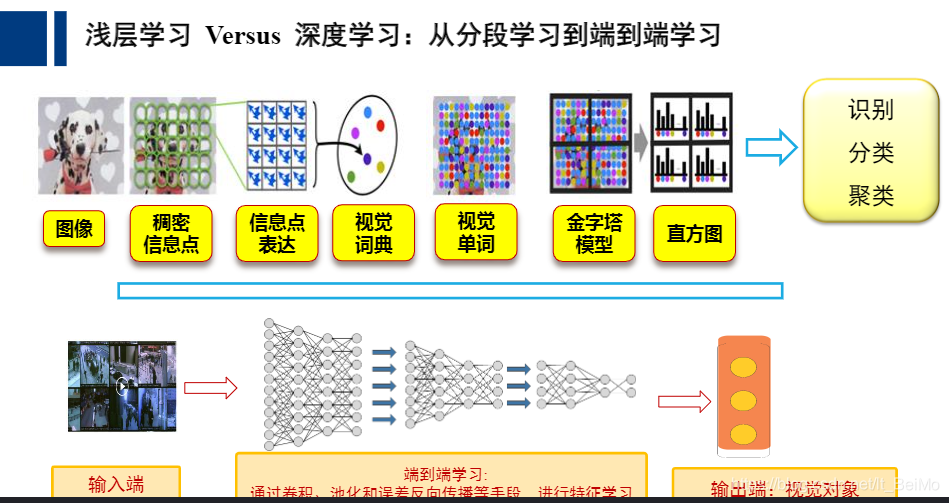

监督学习(回归分析、Ada Boosting)或无监督学习都是一种浅层学习方法。

浅层模型将机器学习算法分成不同阶段,每个阶段设计不同算法来实现。如计算机视觉中,可包含特征点(keypoint)检测、特征点描述、分类或识别等。

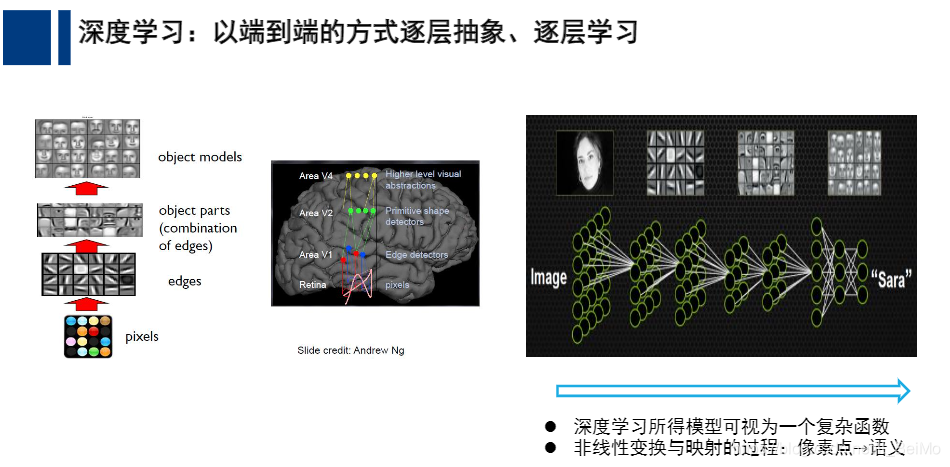

在深度学习中,直接从数据出发来学习数据良好的特征表达。一旦学习出来了特征表达后,再利用分类函数(如softmax函数)进行识别分类。

可见,浅层学习和深度学习除了在模型结构上存在较大区别,后者具有多达数十层、甚至几百层的隐藏层。更为重要的是,深度学习是直接从数据中进行特征学习,而不是利用设计好的特征(如视觉中的SIFT特征)进行学习。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)