3、人工智能相关基础知识点扫盲

通过数据训练模型,使系统自动改进性能分类输入数据与标签对应(如分类、回归)无监督学习:无标签数据(如聚类、降维)半监督学习:结合少量标签与大量无标签数据。强化学习(RL):通过试错与奖励机制学习策略(如AlphaGo)

1、人工智能基本概念

人工智能(Artificial Intelligence,AI)是一门研究如何使计算机能够模拟人类智能行为的科学和技术,目标在于开发能够感知、理解、学习、推理、决策和解决问题的智能机器。人工智能的概念主要包含以下几个方面:

(1)人工智能的目标是模拟人类的智能行为。人工智能致力于使计算机能够像人类一样感知世界、理解信息、进行学习和决策,涵盖视觉、语音、自然语言处理、机器学习等领域的研究和应用。

(2)人工智能的学习能力。人工智能强调计算机能够从数据中学习,并根据学习的结果不断优化自己的性能。机器学习是人工智能的重要分支,涉及到许多算法和模型,如监督学习、无监督学习、强化学习等。

(3)人工智能可以解决问题。人工智能的一个主要目标是使计算机能够解决各种复杂问题,包括图像识别、语音识别、自然语言处理、自动驾驶、医疗诊断等。通过深度学习等技术,计算机可以从大量数据中提取有用的信息,从而实现更高效的问题解决方法。

(4)人工智能的自主性与多样性。理想的人工智能系统应该能够独立地进行学习,决策和行动,而不需要持续的人类干预。人工智能涉及到多个子领域,包括机器学习、计算机视觉、自然语言处理、专家系统、智能控制等。这些子领域有着不同的研究方法和技术,共同构成了人工智能的多样性

2、人工智能核心技术简介

2.1 机械学习:

- 定义:通过数据训练模型,使系统自动改进性能

- 分类:

监督学习:输入数据与标签对应(如分类、回归)

无监督学习:无标签数据(如聚类、降维)

半监督学习:结合少量标签与大量无标签数据。

强化学习(RL):通过试错与奖励机制学习策略(如AlphaGo)

2.3 深度学习(Deep Learning, DL)

- 核心:基于多层神经网络(CNN、RNN、Transformer等)

-

关键技术:

-

卷积神经网络(CNN):擅长图像处理(如ResNet、YOLO)。

-

循环神经网络(RNN):处理序列数据(如LSTM、GRU)。

-

Transformer:并行处理序列,主导NLP领域(如BERT、GPT)。

-

生成对抗网络(GAN):生成逼真数据(如图像生成)。

-

2.4 自然语言处理(NLP)

-

任务:文本分类、机器翻译、问答系统、情感分析等。

-

关键技术:

-

词嵌入:Word2Vec、GloVe、BERT嵌入。

-

预训练模型:GPT系列、T5、PaLM。

-

序列到序列(Seq2Seq):用于翻译和摘要生成。

-

2.5 计算机视觉(CV)

-

任务:图像分类、目标检测、图像分割、人脸识别。

-

经典模型:

-

目标检测:Faster R-CNN、YOLO、SSD。

-

图像分割:U-Net、Mask R-CNN。

-

图像生成:StyleGAN、Stable Diffusion。

-

3、卷积神经网络算法原理

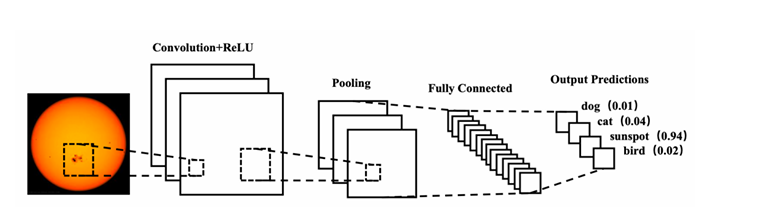

卷积神经网络(Convolutional Neural Networks,CNN)是一类包含卷积计算且具有深度结构的前馈神经网络,是深度学习的代表算法之一。近年来,CNN 在计算机视觉任务中取得了巨大的成功,如图像分类、目标检测、图像分割等。一个卷积神经网络最基本的结构包含卷积层(Convolution)、激活函数(Active Function)、池化层(Pooling)、全连接层(Fully Connected)、输出层(Output)。

如图展示了CNN的基本结构。将图像作为输入,首先经过卷积层,在卷积层中包含了用于提取特定特征的卷积核;之后经过激活函数,激活函数是用来加入非线性因素,提高网络表达能力,卷积神经网络中最常用的是ReLU,Sigmoid 使用较少,因为Sigmoid会出现梯度消失的问题;池化层的作用在于降低网络模型中的参数量,从而遏制过拟合,并且能够提高网络对输入图像的移动、变形、扭曲的处理能力;全连接层的作用在于对卷积层和池化层输出的特征图(二维)进行降维,将学到的特征表示映射到样本标记空间;对于不同的问题,输出会使用不同的函数,softmax 函数用于分类问题,线性函数用于回归问题。

3.1 图像原理

3.1 图像原理

在介绍卷积神经网络之前,首先看一下图像原理。图像在计算机中是一堆按顺序排列的数字,数值为0到255。0表示最暗,255表示最亮。图像按照有无颜色,可以分成两类:灰度图以及彩色图像(RGB图像)。如下图是灰度图。

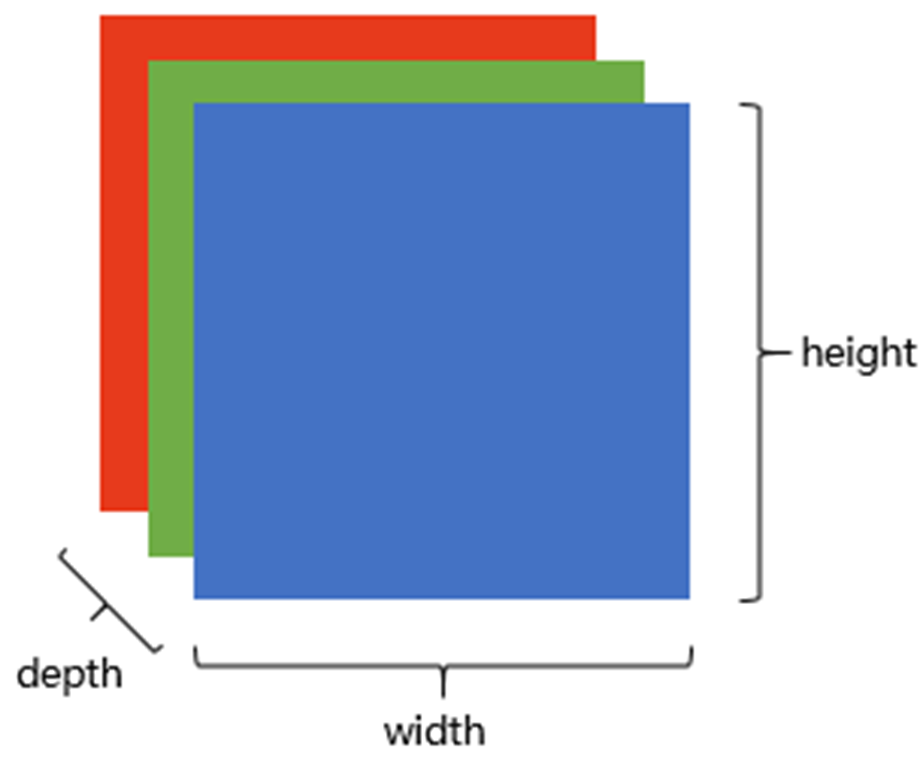

以上图像像素范围在0-255之间,是黑白颜色的灰度图,而更普遍的图片表达方式是RGB颜色模型,即红、绿、蓝三原色的色光以不同的比例相加,以产生多种多样的色光。RGB颜色模型中,单个矩阵就扩展成了有序排列的三个矩阵,也可以用三维张量去理解。其中的每一个矩阵又叫这个图片的一个channel(通道),使用宽, 高, 深来描述。

3.2、卷积层

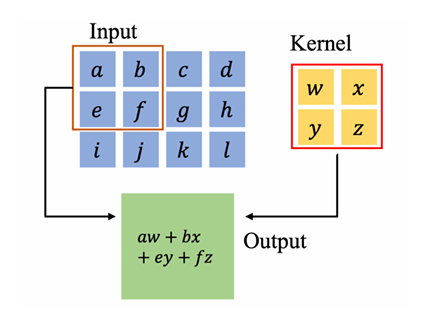

在计算机视觉任务中,卷积神经网络之所以能够展现出如此优异的性能,主要归功于卷积神经网络中的卷积层。卷积层具有强大的特征提取能力,通过从输入图像中捕获的特征信息进而识别图像中的内容。输入图像的空间结构具有高度(Height,H)、宽度(Width,W)、通道数(Chanel,C)三个维度。特征提取是通过卷积层中的卷积核(滤波器)实现的,这些卷积核在高度和宽度维度上都远小于输入图像,但是在通道维度上与输入图像相同。特征提取的过程是通过卷积核在输入图像上滑动并做卷积运算完成的。因此,卷积层具有“参数共享”的特性,可以降低参数量,从而防止因参数过多引起过拟合,也减少了计算开销。如下是一个简单的卷积过程:

Kernel:4x4的卷积核;Input:图像的某一部分像素,大小也是4x4,卷积结果Output = a*w+b*x+e*y+f*z,即加权和。

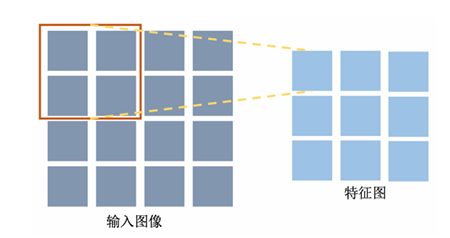

简而言之,卷积操作就是用一个可移动的小窗口来提取图像中的特征,这个小窗口包含了一组特定的权重,通过与图像的不同位置进行卷积操作,网络能够学习并捕捉到不同特征的信息。如下图更能很好的体现出卷积过程:

这张图中蓝色的框就是指一个数据窗口,红色框为卷积核(滤波器),最后得到的绿色方形就是卷积的结果(数据窗口中的数据与卷积核逐个元素相乘再求和)。

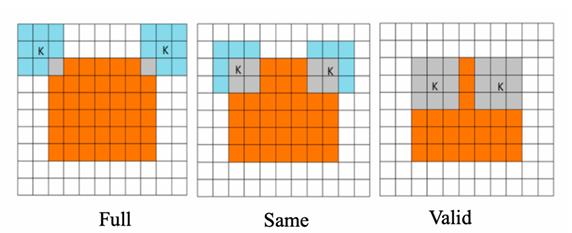

卷积依据卷积核开始做卷积运算时与输入图像重合的位置可分为三种模式,分别是Full、Same、Valid。Full模式表示卷积核与输入图像刚重合时开始做卷积运算;Same 模式表示卷积核的中心与输入图像的边角重合时开始做卷积运算;Valid 模式表示卷积核与输入图像全部重合时开始做卷积运算。三种卷积模式如图所示。

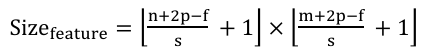

因为卷积神经网络是一个深层结构,输入图像边缘的信息在经过多层卷积后可能会丢失。所以在卷积前对输入图像进行数据填充(Padding)以防止边缘信息丢失。常见的数据填充形式是在图像四周补0,经过填充后的图像可以使用 Full和Same 两种模式进行卷积,以捕获图像边缘的信息。卷积层的输出包含了从输入图像中提取到的特征信息,因此卷积层的输出称为特征图(Feature map)。特征图的大小与卷积核的大小、移动的步长、数据填充的层数有关。设输入图像的大小为nxm,使用的尺度为f的卷积核对其进行卷积操作,在卷积之前对其进行层数据填充p,卷积核移动步长为s,则输出特征图的大小可由如下公式表示:

其中移动步长s : 数据窗口每次滑动的位置步长。特征图上的像素点在输入图像上映射的区域称为感受野(Receptive field)。如下图所示。

3.3 激活函数

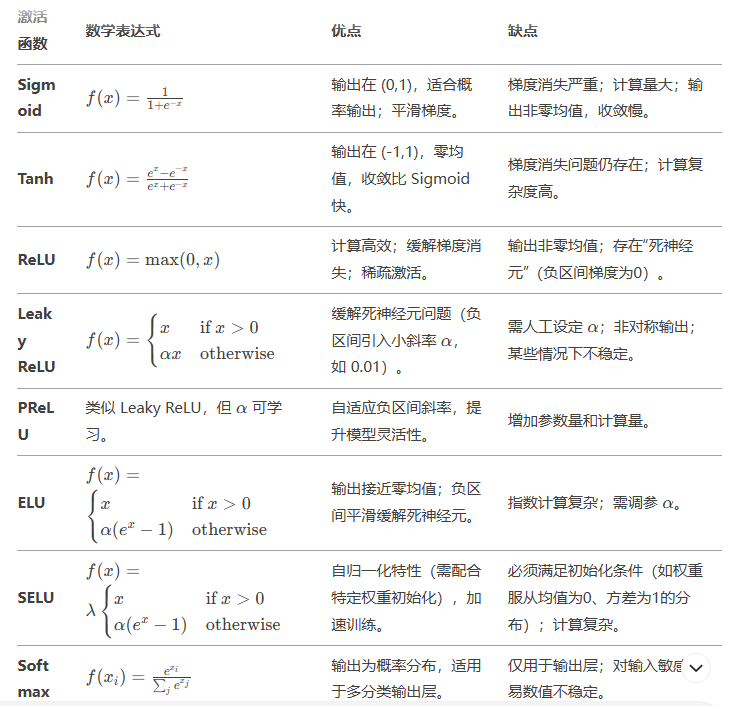

在卷积层之后会加入一个激活函数,通过引入非线性元素来提高网络的表达能力。因为卷积运算本质上是一种加权求和的线性运算。线性运算为基础的网络模型表达能力有限,通过激活函数来引入非线性因素,从而提高网络模型的表达能力。常见的激活函数有Sigmoid、Tanh、ReLU、Leaky ReLU、Parametric ReLU(PReLU)、Exponential Linear Unit(ELU)、Scaled Exponential Linear Unit(SELU)、Softmax等。

浅层的网络模型可以使用sigmoid函数;ReLU函数常用于深层网络模型;递归神经网络网络模型则使用tanh函数。在卷积神经网络中尽量避免使用sigmoid函数和tanh函数,因为会造成梯度消失。首选ReLU函数作为激活函数,相较于sigmoid函数和tanh函数,ReLU函数只有线性关系,计算速度更快。当函数的输入是整数时,不存在梯度消失的问题。但是当输入是负数时,ReLU函数会把负数强制性地置为0,导致特征丢失;同时也无法利用梯度更新权值。因此,当ReLU函数失效时可以选用Leaky ReLU函数。Leaky ReLU 函数避免了特征丢失、权值无法更新等问题。常用激活函数的优缺点如下表所示:

3.4 池化层

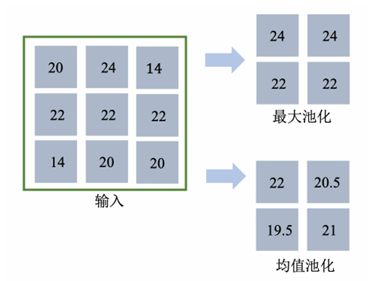

池化操作是将某一位置相邻输出的总体统计特征作为此位置的输出。常见的池化操作有最大池化(Max-Pooling)和均值池化(Mean-Pooling)。池化层没有可训练的参数,但是需要指定池化核的大小、滑动步长以及池化类型。池化核的大小一般为2x2,滑动步长为2,两种池化方式的结果如图所示。池化的过程本质上是一个对特征图采样的过程。在保留特征的同时减少参数计算量,防止过拟合。

3.5 全连接层

全连接(Fully Connected,简称 FC)层是深度学习神经网络中一种基本的层结构。它主要用于神经网络的最后几层,将高层特征映射到输出空间中。全连接层对数据的每个输入节点与每个输出节点进行连接,用于实现输入特征和输出结果之间的映射关系。

在全连接层中,每一个输入节点与每一个输出节点之间都有一条连接线。假设输入层有 n 个神经元,输出层有 m 个神经元,那么全连接层的连接总数为 n×m。这意味着所有的输入神经元都会影响到输出层的每一个神经元。

对于全连接层可应用于以下场景:

- 分类任务:在分类模型的输出层,全连接层的输出维度通常等于类别数。通过 Softmax 激活函数可以得到每个类别的概率分布。

- 特征融合:在卷积神经网络(CNN)中,全连接层用于将提取的特征进行全局融合。CNN 的卷积层和池化层提取了局部特征,而全连接层能整合这些特征,用于更全面的决策。

- 生成输出:在生成模型中(如生成对抗网络的判别器部分),全连接层用于生成图像、文本等数据的最后输出。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)