神经处理单元(NPU)在人工智能加速中的应用

NPU通过专门的指令集和紧凑的电路设计,可以在保持高性能的同时显著降低功耗,延长设备的续航时间。此外,NPU还具有高度可定制化的特点,可以根据具体应用的需求进行定制,提供更大的灵活性和适应性。例如,一些NPU支持神经网络模型的压缩和蒸馏技术,可以减小模型的尺寸和复杂度,提高计算效率和存储效果。另外,NPU的使用还面临着算法和硬件的紧密配合以及软件开发工具的支持等问题。随着人工智能的发展和进一步的技

神经处理单元(NPU)是一种专门设计用于人工智能(AI)计算任务的硬件加速器。它的出现是为了解决传统中央处理器(CPU)和图形处理器(GPU)在执行AI任务时遇到的挑战,并针对神经网络的特定计算模式进行了优化。本文将探讨NPU在人工智能加速中的应用,并重点关注其优势、功能和发展趋势。

首先,NPU在人工智能加速中的应用范围非常广泛。人工智能任务通常涉及大量的矩阵运算和神经网络计算。NPU可以高效地执行这些计算,提供高吞吐量和低延迟,因此在图像识别、语音识别、自然语言处理等应用中得到了广泛应用。例如,智能手机、智能摄像头和自动驾驶汽车等设备都可以使用NPU来加速图像和视频处理,提供实时性能和更好的用户体验。

其次,NPU具有一系列优势,使其成为人工智能加速的理想选择。首先是高效能。NPU采用专门优化的硬件架构和算法,可以更加高效地执行神经网络计算。相比之下,传统的CPU和GPU在处理AI任务时会浪费大量能源和计算资源。其次是低功耗。NPU通过专门的指令集和紧凑的电路设计,可以在保持高性能的同时显著降低功耗,延长设备的续航时间。此外,NPU还具有高度可定制化的特点,可以根据具体应用的需求进行定制,提供更大的灵活性和适应性。

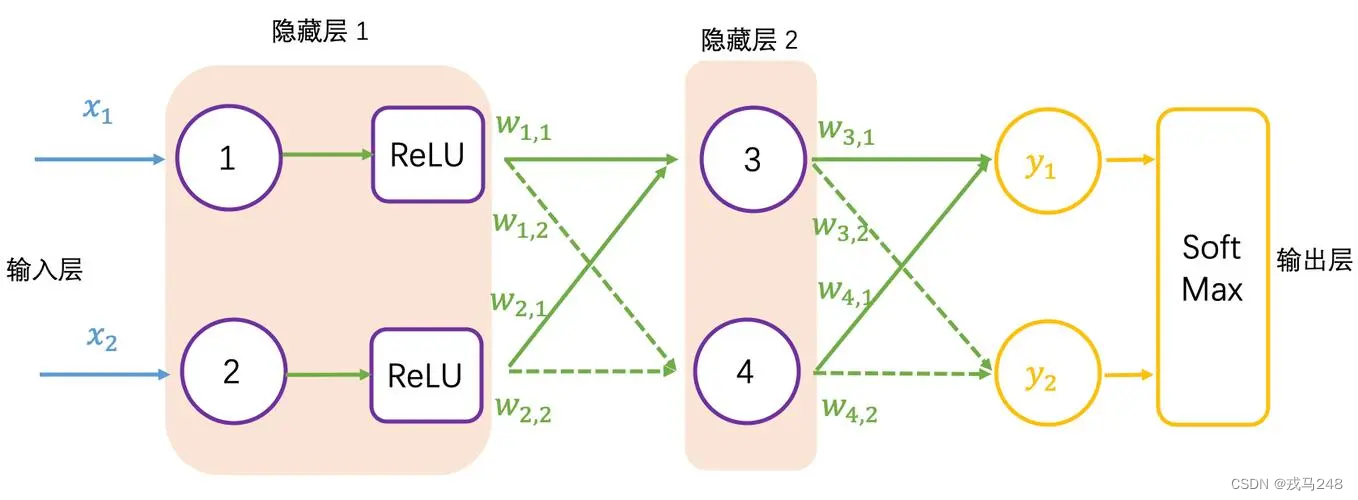

NPU的核心功能是加速神经网络计算。神经网络是人工智能的核心组成部分,包含大量的矩阵运算和张量操作。NPU通过定制的硬件加速器实现了这些计算操作,以提高计算效率和性能。NPU通常包括多个计算核心和高速缓存,以并行执行矩阵乘法、卷积操作和激活函数等神经网络计算任务。此外,NPU还支持混合精度计算、量化计算和稀疏计算等技术,以进一步提高计算效率和减少存储需求。

随着人工智能的快速发展,NPU也在不断演进和创新。目前,越来越多的芯片厂商和科技公司开始研发和推出自己的NPU产品。新一代的NPU不仅在计算性能上有所提升,还引入了更多的功能和特性。例如,一些NPU支持神经网络模型的压缩和蒸馏技术,可以减小模型的尺寸和复杂度,提高计算效率和存储效果。另外,一些NPU还支持端到端的神经网络推理和训练,实现了全面的人工智能计算。

虽然NPU在人工智能加速中有着巨大的潜力和优势,但也面临一些挑战和限制。首先是多样性的神经网络架构。目前,人工智能领域存在许多不同的神经网络结构,每个结构都有不同的计算需求和算法特性。因此,如何设计通用且高效的NPU来适应各种神经网络任务是一个挑战。另外,NPU的使用还面临着算法和硬件的紧密配合以及软件开发工具的支持等问题。

综上所述,神经处理单元(NPU)在人工智能加速中发挥着重要的作用。其高效能、低功耗和定制化的特点使其成为加速神经网络计算的理想选择。随着人工智能的发展和进一步的技术创新,我们可以期待NPU在未来的应用中发挥更大的作用,并推动人工智能技术的进一步进步和应用的扩展。

嵌入式物联网的学习之路非常漫长,不少人因为学习路线不对或者学习内容不够专业而错失高薪offer。不过别担心,我为大家整理了一份150多G的学习资源,基本上涵盖了嵌入式物联网学习的所有内容。点击这里,0元领取学习资源,让你的学习之路更加顺畅!记得点赞、关注、收藏、转发哦。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)