本地部署 DeepSeek 和 RAGFlow,结合 Embedding 模型,构建个人知识库

通过本地部署 DeepSeek 和 RAGFlow,结合 Embedding 模型构建个人知识库。

·

本地知识库配置指南

1. 准备工作

目标

通过本地部署 DeepSeek 和 RAGFlow,结合 Embedding 模型构建个人知识库

工具需求

- ollama(本地运行和管理大语言模型)

- Docker(部署 RAGFlow)

- DeepSeek 模型

- Embedding 模型

- RAGFlow 源代码

2. 下载并配置 ollama

下载 ollama 平台

- 官网地址:ollama

- 支持 Windows/Linux/macOS 系统

配置环境变量

# 设置访问地址

export OLLAMA_HOST=0.0.0.0:11434

# 自定义模型存储路径(可选)

export OLLAMA_MODELS=D:\models

- 需重启系统生效配置

- 防火墙需放行 11434 端口

下载 DeepSeek 模型

ollama run deepseek-r1:32b

3. 下载并部署 RAGFlow

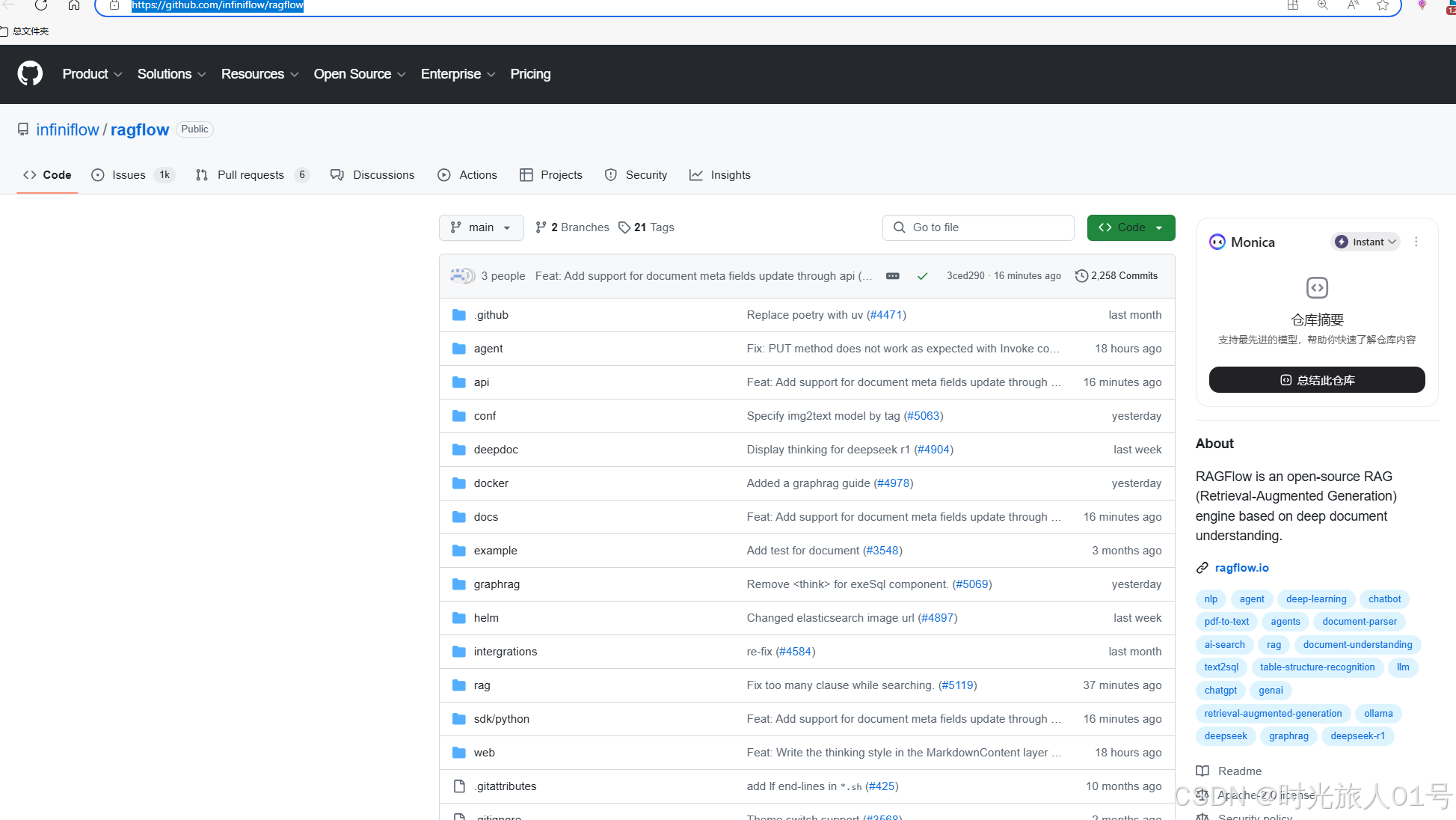

-获取源代码

GitHub 仓库示例:https://github.com/infiniflow/ragflow

- 安装 Docker

官网下载:https://www.docker.com/

- 拉取镜像

docker pull ragflow:latest

- 启动容器

docker run -d -p 8080:8080 --name ragflow-container ragflow:latest

4. 配置知识库

4.1 模型配置

Chat 模型配置

- 在 RAGFlow “模型提供商” 添加 DeepSeek

- 选择

deepseek作为 Chat 模型

Embedding 模型配置

- 使用系统自带或单独部署模型

- 支持多种开源 Embedding 模型

4.2 知识库构建

- 创建新知识库

- 上传文件(支持 PDF/Word/TXT 等格式)

- 文件自动解析流程:

- 文段切分处理

- Embedding 模型生成向量指纹

- 向量索引存储

Prompt 示例:

“根据我的知识库内容回答问题。如果知识库中没有相关信息,请明确告知。”

工作流程:

- 用户输入 → 向量化

- 向量匹配知识库片段

- 上下文扩展 + 问题整合

- DeepSeek 生成最终回答

5. 在线快速搭建方案(可选)

5.1 部署流程

- 使用 Docker 部署 RAGFlow

- 配置在线模型:

- Chat 模型:GPT-4/Claude 等

- Embedding 模型:OpenAI Embedding 等

- 上传文件构建知识库

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)