【小白教程】将本地部署的deepseek模型接入Pycharm、WebStorm、IDEA等JetBrains IDE

这篇文章介绍了将本地部署的deepseek模型接入到JetBrains IDE的方法

·

deepseek模型接入JetBrains IDE

前提

在将deepseek模型接入微信之前首先要先保证本地安装好了ollama并成功部署了deepseek,具体操作方法可以参考我的上一篇博文:在本地部署deepseek模型

准备工作

- 任意一款JetBrains IDE:包括但不限于IDEA、Pycharm、WebStorm、CLion。

- CodeGPT:CodeGPT是JetBrains IDE的一款通用插件,是目前支持开源大模型编程最好的插件之一,操作对小白十分友好。CodeGPT可以在IDE的plugin中搜索到

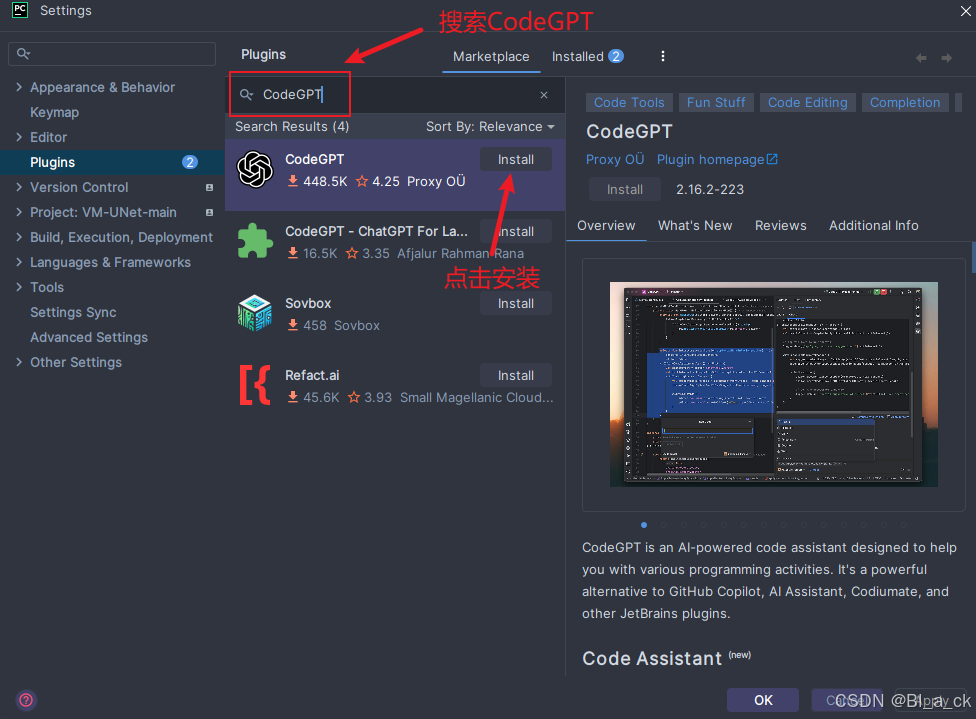

为IDE安装CodeGPT插件

- 打开Pycharm-Settings-Plugins-Marketplace

- 搜索CodeGPT,点击Install

安装成功后重启IDE即可

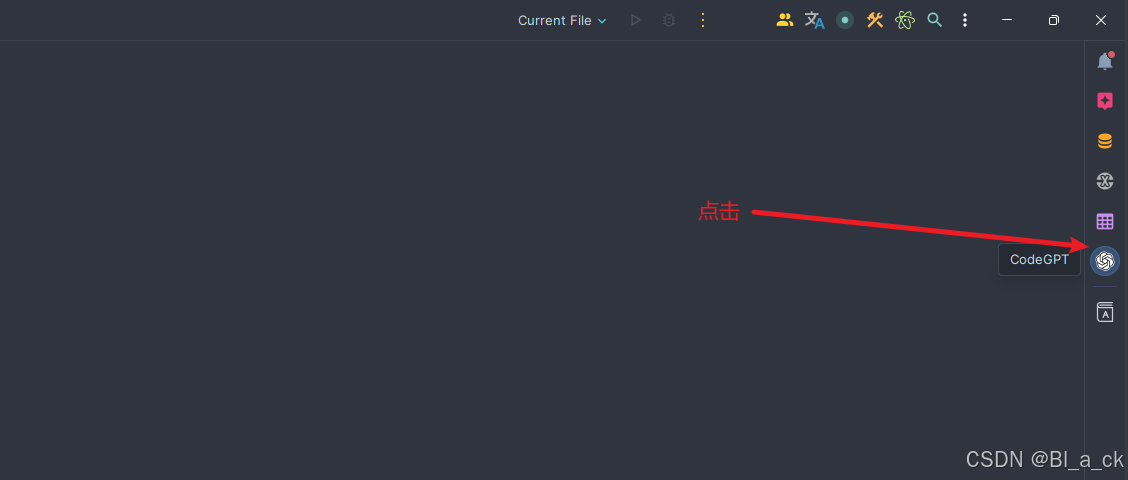

使用CodeGPT插件导入本地deepseek环境

- 再次打开Pycharm后,在最右侧会出现如箭头所示的图标,点击该图标,开始配置CodeGPT

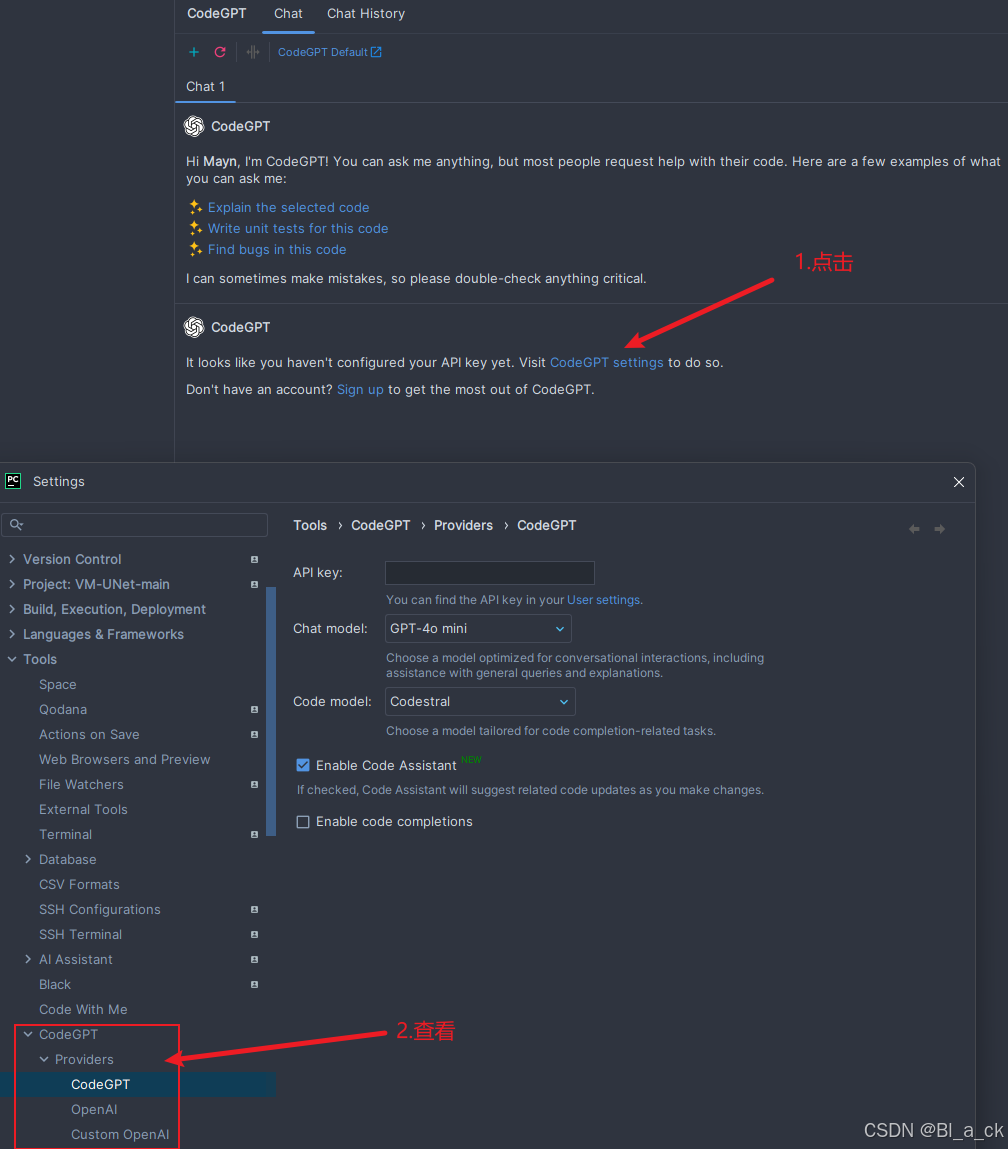

- 点击CodeGPT settings,查看CodeGPT当前的模型配置,将其修改为本地的Ollama。

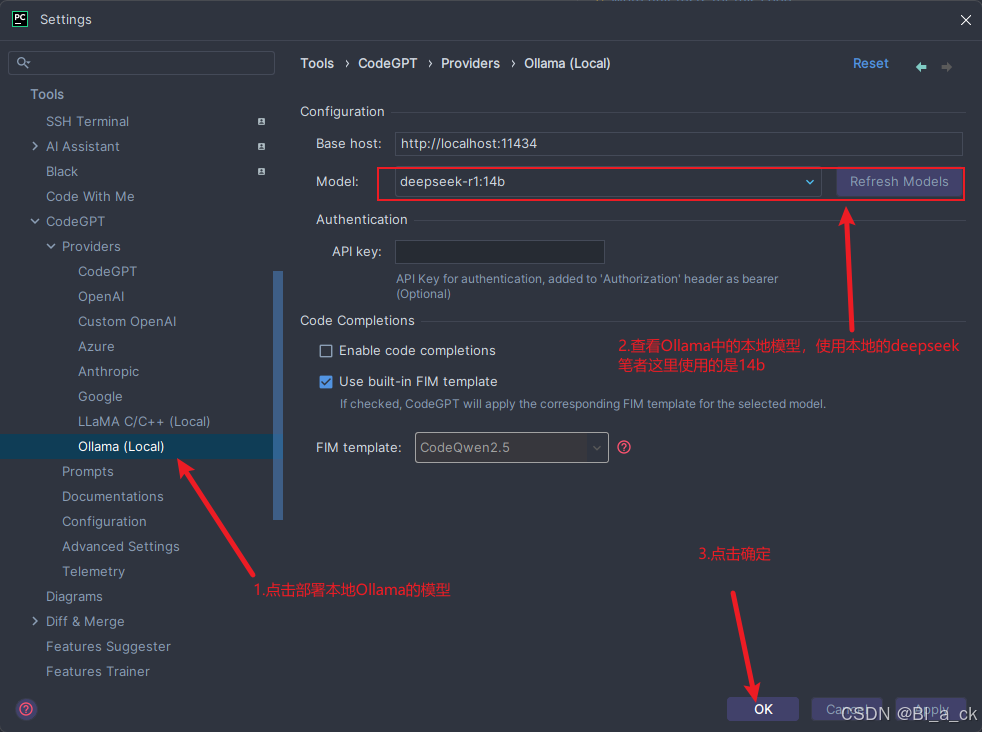

- 点击CodeGPT settings,查看CodeGPT当前的模型配置,将其修改为本地的Ollama,按照下图所示将CodeGPT的模型修改为本地部署过的deepseek-r1

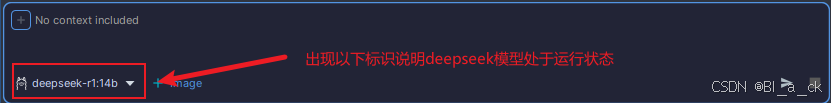

- 当CodeGPT的左下角对话框显示本地模型信息时说明deepseek已经成功接入IDE

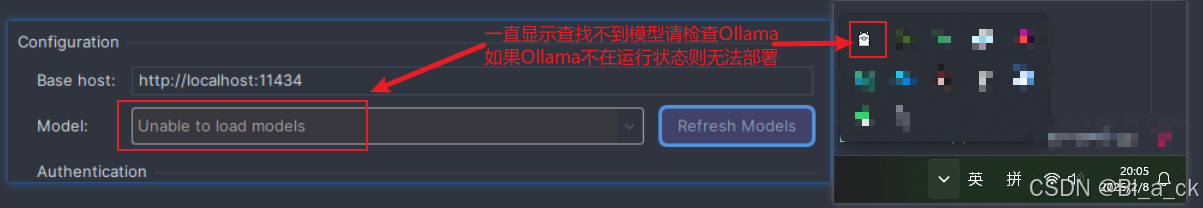

注意:Model选项中没有显示本地的deepseek模型,请点击Refresh Models刷新Ollama的配置,如果依然没有显示,请确定Ollama处于打开状态,只有Ollama模型一直在后台运行才可以使用deepseek

- 开始与deepseek对话

后话

个人还是建议从官网申请一个API key用满血版的deepseek R1部署,本地模型受硬件条件限制往往无法完全发挥deepseek的优势。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)