Kafka运维实战 11 - kafka查看消息的具体内容【实战】

这些文件共同协作,使得 Kafka 能够高效地进行消息的存储、查询和消费,满足高吞吐量、低延迟的消息传递需求。每个分区的这些文件通常存放在同一个目录下,目录以“主题名-分区号”命名。通过上述方法,可以清晰地查看 Kafka 日志文件的内容和结构,帮助排查消息存储相关的问题。我们有时候遇到这样的需求,需要查看下kafka消息的内容。Kafka 按「主题-分区」划分目录,例如。类的封装),可更友好地解

- 📝Kafka运维实战 17 - kafka 分区副本从 1 增加到 3【实战】

- 📝Kafka运维实战 16 - kafka 分区重新分配【实战】

- 📝Kafka运维实战 15 - kafka 重设消费者组位移入门和实战【实战】

- 📝Kafka运维实战 14 - kafka消费者组消费进度(Lag)深入理解【实战】

- 📝Kafka运维实战 13 - kafka 动态调整Broker, Topic的配置【实战】

- 📝Kafka运维实战 12 - kafka主题管理详解【实战】

- 📝Kafka运维实战 11 - kafka查看消息的具体内容【实战】

- 📝Kafka运维实战 10 -kafka 生产和消费 性能测试工具【实战】

- 📝Kafka运维实战 09 - kafka 生产消息和消费消息用法【实战】

- 📝Kafka运维实战 08 - kafka 3.7脚本工具最全整理汇总【建议收藏】

- 📝Kafka运维实战 07 - kafka 三节点集群部署(混合模式)(KRaft 版本3.7.0)

- 📝Kafka运维实战 06 - kafka 单机部署指南(混合模式)(KRaft 版本3.7.0)

- 📝Kafka运维实战 05 - kafka 消费者组和重平衡(Rebalance)

- 📝Kafka运维实战 04 - Kafka 控制器(Controller)详解:架构、原理与实战

- 📝Kafka运维实战 03 - Kafka 配置参数详解:ZooKeeper 模式与 KRaft 模式对比

- 📝Kafka运维实战 02 - 深入理解 Kafka主题、分区与副本的协同机制

- 📝Kafka运维实战 01 - Kafka入门和基础配置

我们有时候遇到这样的需求,需要查看下kafka消息的内容。

kafka 消息查看

查看 Kafka 的日志文件可以通过直接查看文件内容或使用 Kafka 提供的工具来实现,具体方法如下:

1. 直接查看日志文件内容

Kafka 的日志文件(.log、.index、.timeindex 等)默认存储在配置文件 server.properties 中 log.dirs 配置的目录下(默认路径通常为 /tmp/kafka-logs/,生产环境中会自定义路径)。

步骤:

-

找到日志文件存储路径

查看 Kafka 配置文件server.properties中的log.dirs参数,确定日志文件存放目录:grep "log.dirs" /path/to/kafka/config/server.properties # 示例输出:log.dirs=/var/lib/kafka/logs -

进入具体分区的日志目录

Kafka 按「主题-分区」划分目录,例如topic-name-0(主题名-分区号),进入目标分区目录:cd /var/lib/kafka/logs/topic-name-0 -

查看

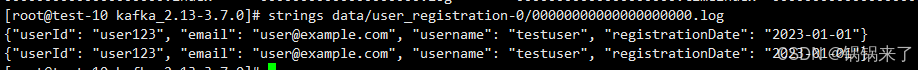

.log文件内容.log文件是二进制格式,但可通过strings或kafka-run-class.sh工具解析:# 简单查看文本内容(可能包含乱码) strings 00000000000000000000.log

2. 使用 Kafka 工具查看日志

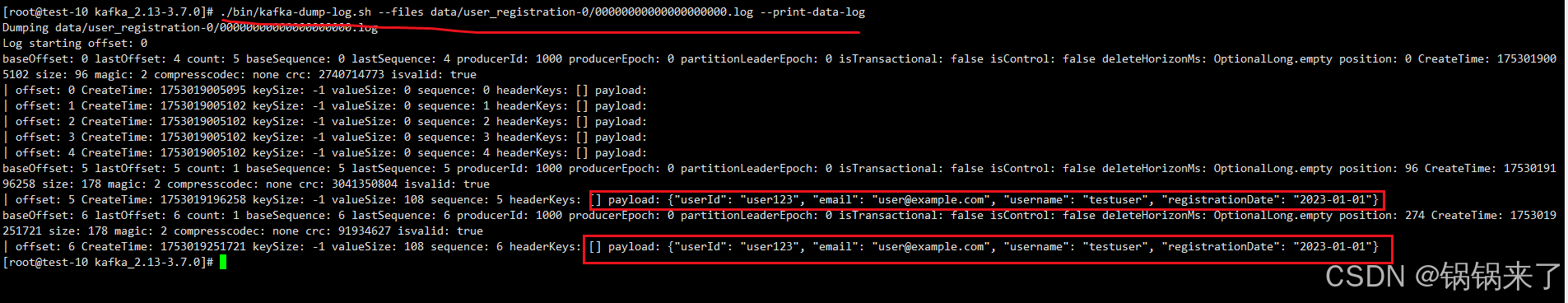

Kafka 提供了专门的工具 kafka-dump-log.sh(本质是 DumpLogSegments 类的封装),可更友好地解析日志文件。

主要参数说明

| 参数 | 说明 |

|---|---|

--files |

指定要解析的日志文件路径(必填) |

--print-data-log |

打印消息的实际内容 |

--deep-iteration |

深入迭代所有消息,包括压缩消息 |

--max-bytes |

Limit the amount of total batches read in bytes avoiding reading the whole .log |

常用命令:

# 查看指定日志文件的详细信息(包括消息内容)

/path/to/kafka/bin/kafka-dump-log.sh \

--files /var/lib/kafka/logs/topic-name-0/00000000000000000000.log \

--print-data-log

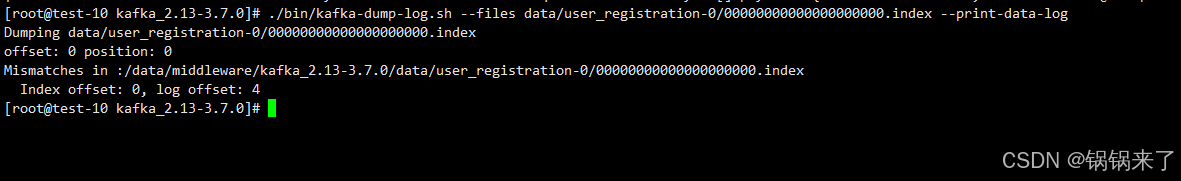

# 查看索引文件(.index)内容

/path/to/kafka/bin/kafka-dump-log.sh \

--files /var/lib/kafka/logs/topic-name-0/00000000000000000000.index

输出说明:

- 包含消息的偏移量(

offset)、时间戳(timestamp)、键(key)、值(value)、消息大小等信息。 - 索引文件(

.index、.timeindex)的输出会显示偏移量与物理位置的映射关系。 - 对于压缩的消息,需要使用 --deep-iteration 才能看到实际内容

3. 注意事项

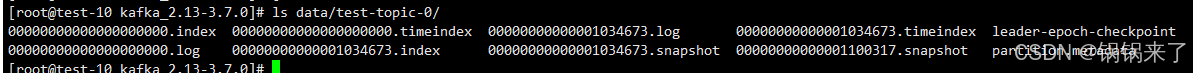

- 日志分段存储:日志文件会按大小(

log.segment.bytes)或时间(log.roll.hours)分段,文件名以起始偏移量命名(如00000000000000000000.log、00000000000000123456.log)。 - 权限问题:日志文件通常由 Kafka 进程所属用户(如

kafka)拥有,可能需要sudo权限才能查看。 - 生产环境谨慎操作:直接查看或修改日志文件可能影响 Kafka 正常运行,建议仅在调试时使用。

通过上述方法,可以清晰地查看 Kafka 日志文件的内容和结构,帮助排查消息存储相关的问题。

kafka 消息日志文件详解

Kafka 中的日志文件(.log、.index、.timeindex 等)是其存储和高效处理消息的核心组件,各自承担不同的功能:

-

.log 文件

- 这是最核心的日志文件,用于存储实际的消息数据。

- 消息以追加的方式写入,保证了写入操作的高效性。

- 每个分区对应一组.log文件,消息按发送顺序持久化存储。

- 文件会根据配置的大小或时间进行分段(segment),避免单个文件过大。

-

.index 文件

- 这是偏移量索引文件,用于加速消息的查找。

- 记录了消息偏移量与消息在.log文件中物理位置的映射关系。

- 当需要查找特定偏移量的消息时,Kafka 可通过.index文件快速定位到该消息在.log文件中的位置,无需遍历整个.log文件。

-

.timeindex 文件

- 这是时间戳索引文件,提供了基于时间戳的消息查找能力。

- 记录了消息时间戳与偏移量的对应关系。

- 支持按时间范围查询消息,例如查找某个时间段内的消息,Kafka 可利用.timeindex快速定位到对应的偏移量范围。

这些文件共同协作,使得 Kafka 能够高效地进行消息的存储、查询和消费,满足高吞吐量、低延迟的消息传递需求。每个分区的这些文件通常存放在同一个目录下,目录以“主题名-分区号”命名。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)