仓颉迁移实战:将 Node.js 微服务移植到 Cangjie 的工程化评测

这次迁移实践让我们对仓颉有了更立体的认识。它已经具备了成为工程化后端语言的关键能力:首先是可交付性。仓颉能够编译为单一原生二进制文件,这意味着在部署时,我们不再需要再目标机器上安装繁重的运行时环境(如 Node.js 或 JVM),极大地简化了运维流程。其次是可控性。静态类型系统和显式的 I/O 控制,虽然在开发初期增加了编码负担,但迫使我们在编码阶段就必须思考边界条件和潜在错误。从长期维护的角度

仓颉迁移实战:将 Node.js 微服务移植到 Cangjie 的工程化评测

写在最前面

版权声明:本文为原创,遵循 CC 4.0 BY-SA 协议。转载请注明出处。

本文记录了一次将小型 Node.js 服务迁移至仓颉(Cangjie)语言的工程实践,试图从工程维度去评估这门新语言:它是否做好了承接实际业务的准备?

在这次实践中,我们不仅关注功能实现的等价性,更深入到了两者 I/O 模型、内存管理及工程依赖的差异腹地。文章将带你经历从环境搭建的“水土不服”,到 I/O 思维的“范式转移”,再到高并发下“连接风暴”的排查过程。

我们发现,仓颉在静态类型带来的早期错误发现、原生二进制部署的简洁性上展现了明显的工程优势;而其当前的 I/O 生态也给我们留下了不少需要手动优化的“工程作业”。

代码可见:https://gitcode.com/WTYuong/Cangjie_test1

一、 为什么要进行这次迁移

评估一门新语言最好的方式,不是写一个 Hello World,而是迁移一个真实(哪怕是微型)的业务场景。我们选择了一个包含典型 I/O 特征的 Node.js 微服务作为移植对象,旨在考察仓颉在实际工程落地时的表现。

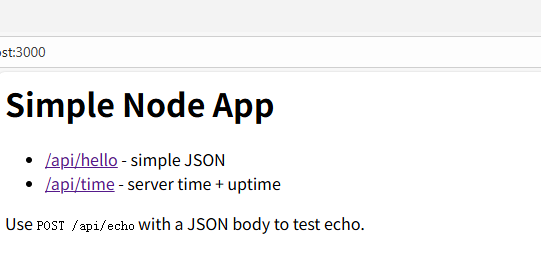

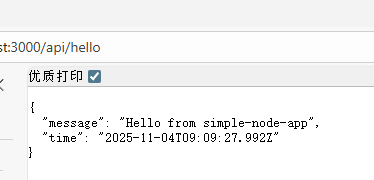

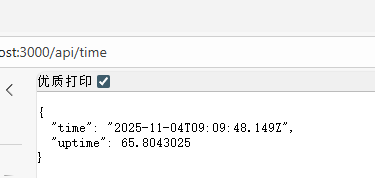

这个目标服务虽然精简,却覆盖了后端开发的核心要素:GET / 用于测试基础的 HTTP 响应能力;GET /api/hello 返回纯文本,用于测试最小负载下的极限吞吐;GET /api/time 涉及 JSON 对象的序列化;而最关键的 POST /api/echo,则需要读取客户端上传的请求体并原样返回,这是测试流式 I/O、内存缓冲策略的绝佳场景。我们希望通过这个组合,全面对比仓颉与 Node.js 在运行时特征上的异同。

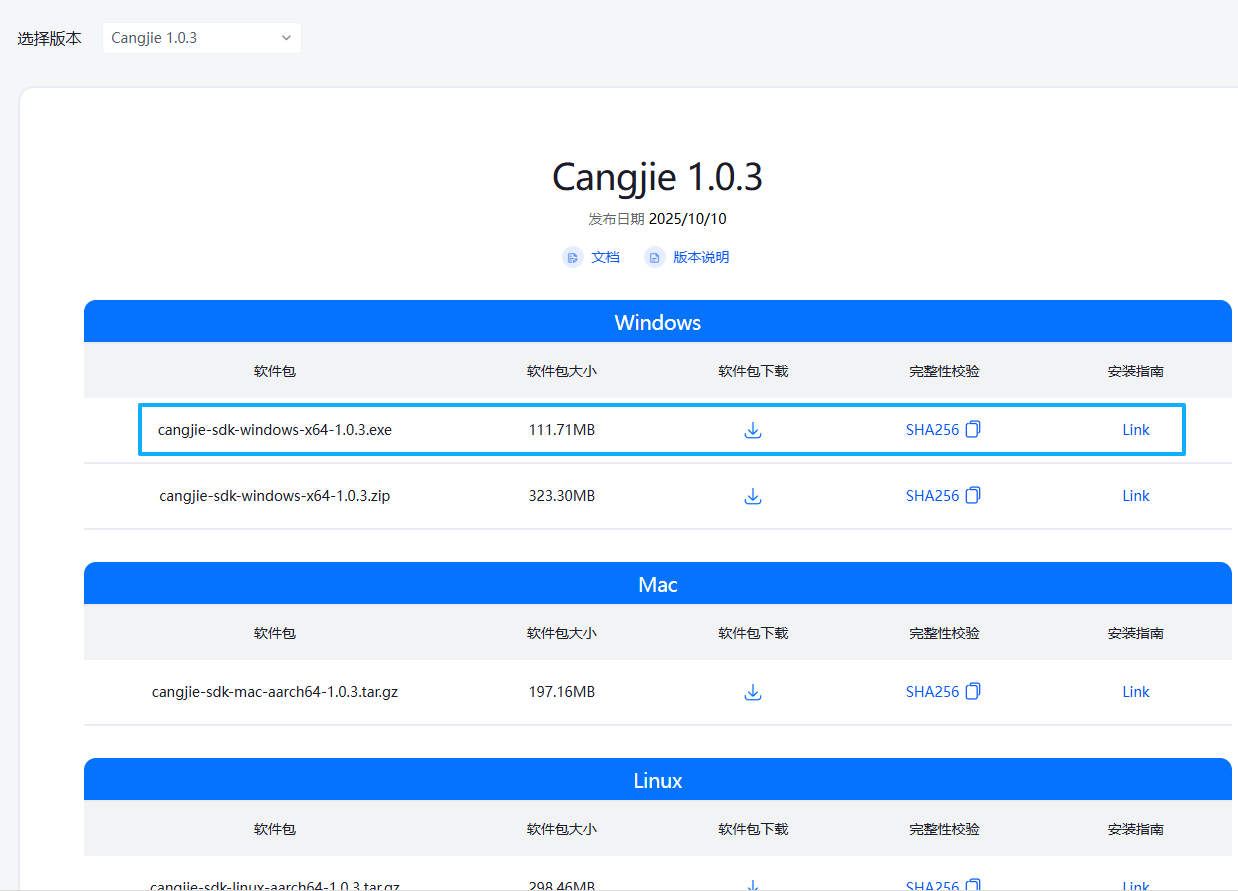

二、仓颉下载下载部署与安装

https://cangjie-lang.cn/download/1.0.3

下载exe文件,然后一路点击就可以

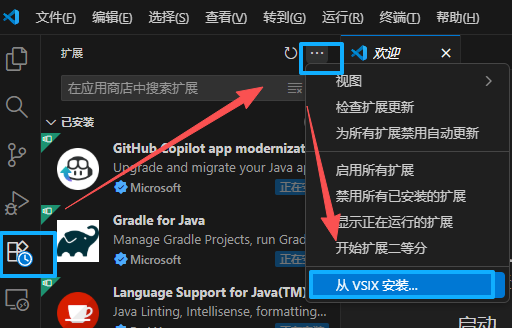

然后下载vscode相关插件

打开VS Code,如图点击左侧Extensions -> Views and More Actions -> Install from VSIX,找到刚才解压出来的Cangjie-0.51.4.vsix文件。安装成功。

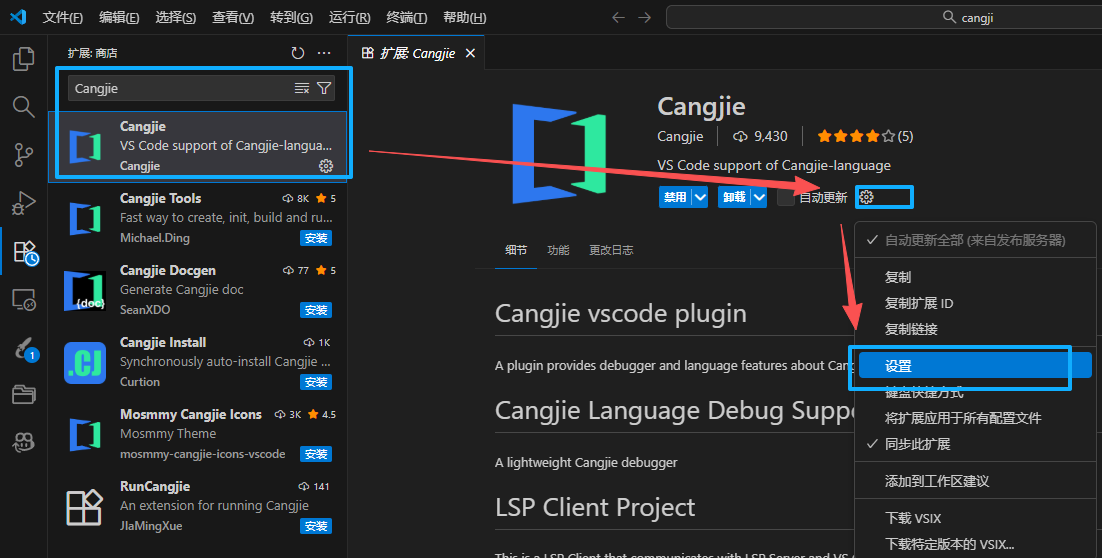

如图点击左侧Extensions -> Cangjie插件 -> 齿轮图标 -> Extension Settings

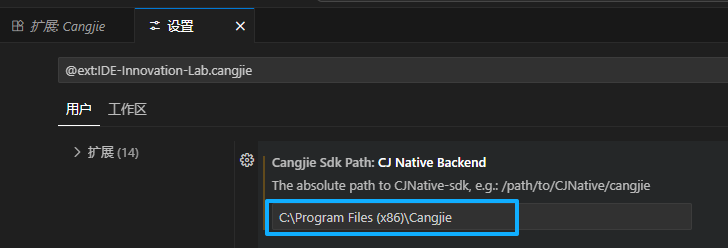

参考下图,在Cangjie Sdk Path: CJNative Backend中填入步骤2中安装的仓颉SDK路径。根据自己实际情况填写。

至此,开发环境搭建完成。

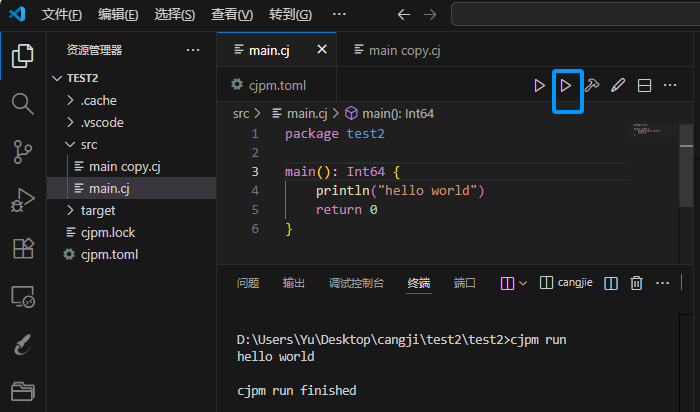

创建Hello World项目

- 在VS Code界面中使用快捷键

ctrl + shift + p - 在搜索框里输入关键字搜索

Create Cangjie Project并选择 - 下一步选择

Create CJNative Cangjie Project - 选择

Create Executable Output Cangjie Project - 在弹出的文件夹选择窗里选择工程存放的目录

- 回到之前界面,在上方输入框中输入工程的名称,并回车

- 在左侧目录结构中找到

src -> main.cj可以看到默认创建的一段helloworld代码 - 点击右上方三角按钮运行项目

- 在下方TERMINAL页签中可以看到运行的结果,打印了

hello world

三、 工程环境:真实世界的“摩擦力”

迁移的第一步往往不是编写代码,而是与环境“搏斗”。在 Windows 平台上搭建仓颉开发环境时,我们遭遇了几个典型的工程挑战。

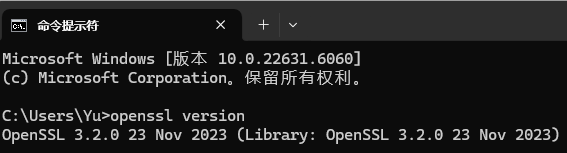

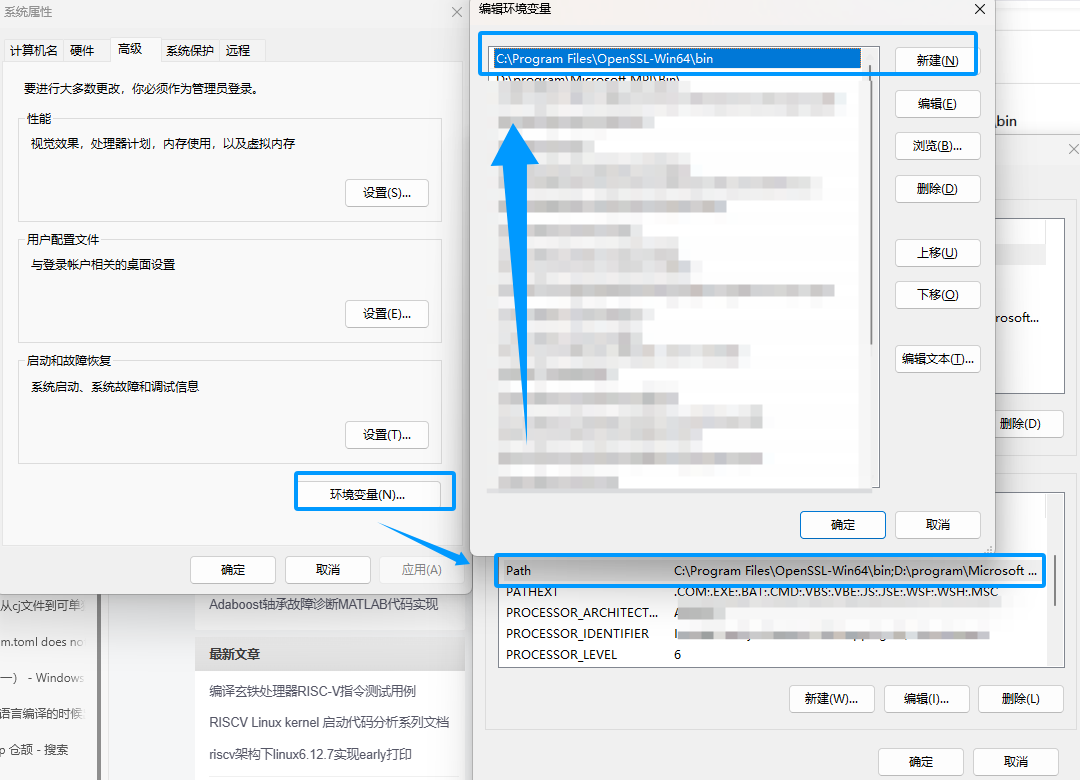

下载Windows下安装OpenSSL

首当其冲的是依赖管理的“水土不服”。仓颉使用 cjpm 进行包管理,在引入官方网络库 std``x 时,由于我们的开发机安装了 Git、VMware 等多种软件,环境中存在多个版本的 OpenSSL,这直接导致了仓颉网络栈在链接底层的 OpenSSL 动态库时出现了符号冲突。解决这个问题的路径并不复杂,但非常考验耐心:我们需要明确指定合规的 OpenSSL 版本(如 1.1.1 或 3.0),并极其精细地配置系统环境变量,确保 cjc 编译器能找到正确的库文件。

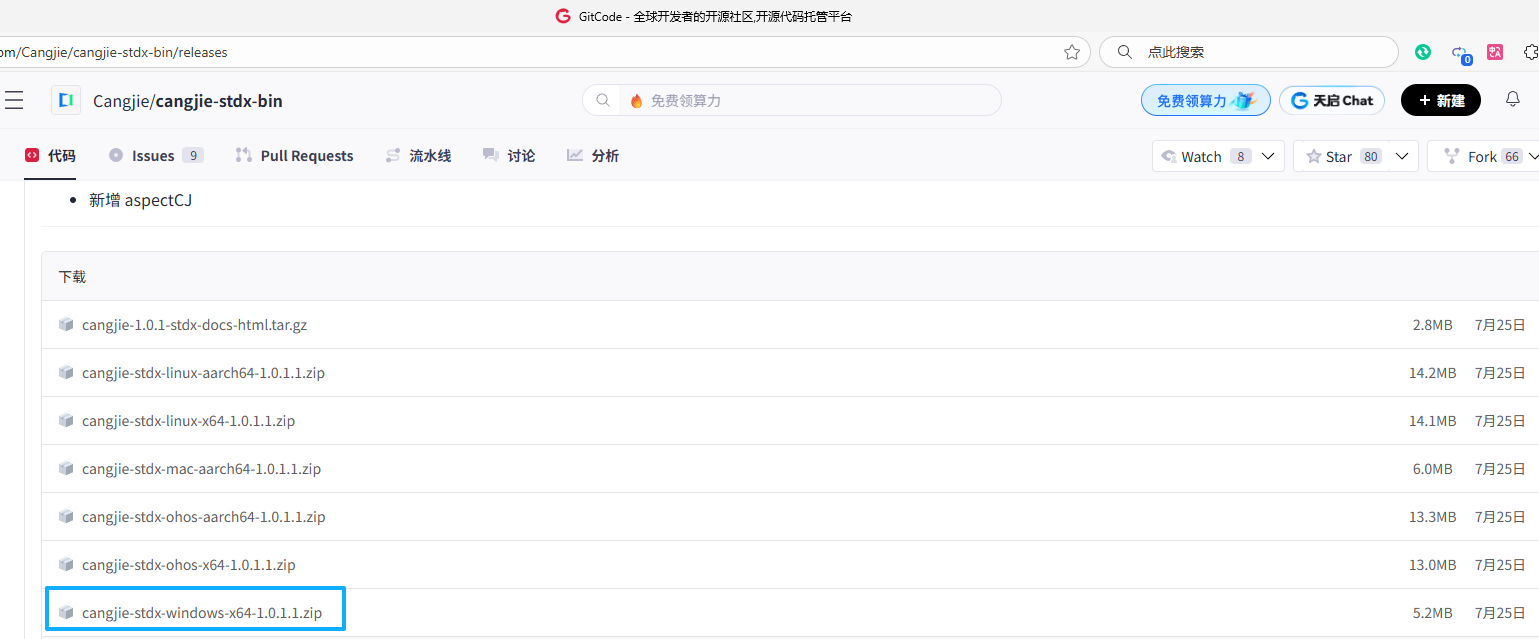

下载cangjie-stdx-bin

https://gitcode.com/Cangjie/cangjie-stdx-bin/releases

下载地址:http://slproweb.com/products/Win32OpenSSL.html

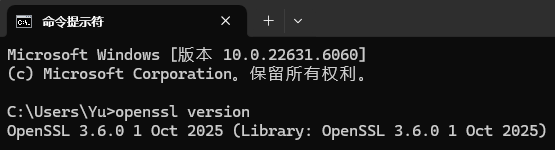

直接在cmd中,输入命令,查看OpenSSL版本

openssl version

结果,并不是我们安装的版本

原因: 如果电脑上已经安装过其他软件,比如Git、VMware、Strawberry等,那么他们都自带了openssl,如下:

所以,当你在cmd中使用openssl命令时,可能会调用到其他版本的openssl。

再次验证,查看OpenSSL版本正确。

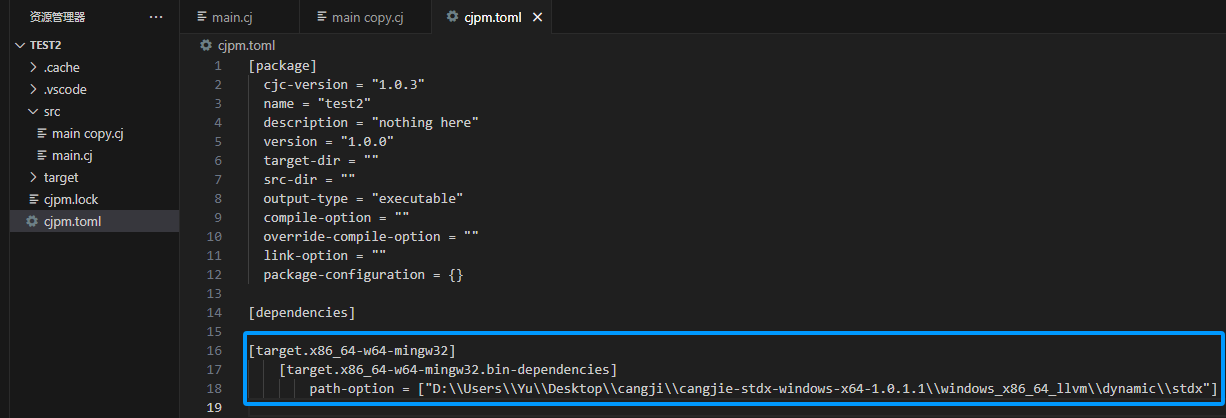

此外,cjpm.toml 的配置也需要精准匹配。

配置toml

这里根据你的系统选择,下载完成后解压到任意位置,注意,如果是Windows端,路径下最好不要有非Ascii字符和空格

这里我是放在了项目目录下

然后配置cjpm.toml,在其中声明这个包

[target.你的架构]

[target.你的架构.bin-dependencies]

path-option = [“你存放stdx包的路径下dynamic\stdx”]

这个架构可以使用Cangjie的编译器查看(如果你配置了Path的话)

PS C:\Users\Your Username\Desktop\Backend> cjc -v

Cangjie Compiler: 1.0.0 (cjnative)

Target: x86_64-w64-mingw32

下面的Target就是你的架构

我的配置(Windows下记得转义)

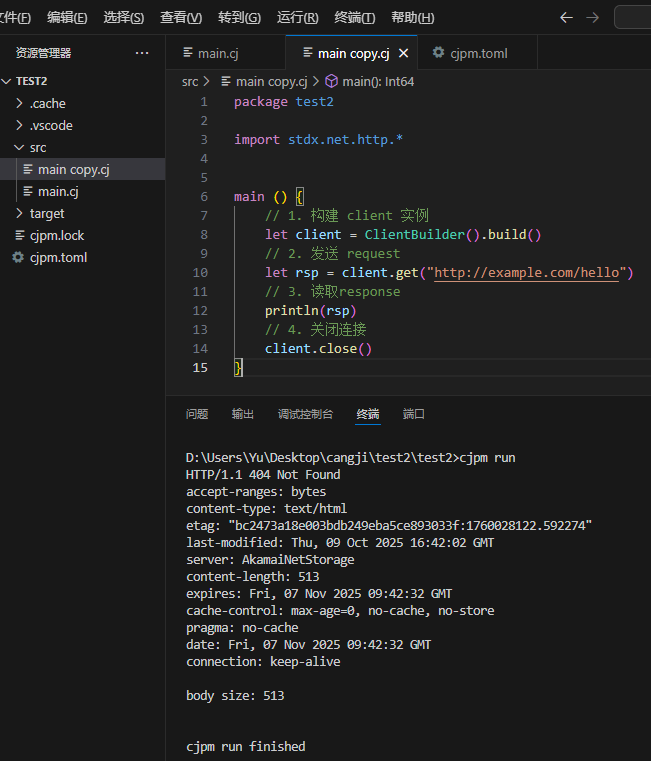

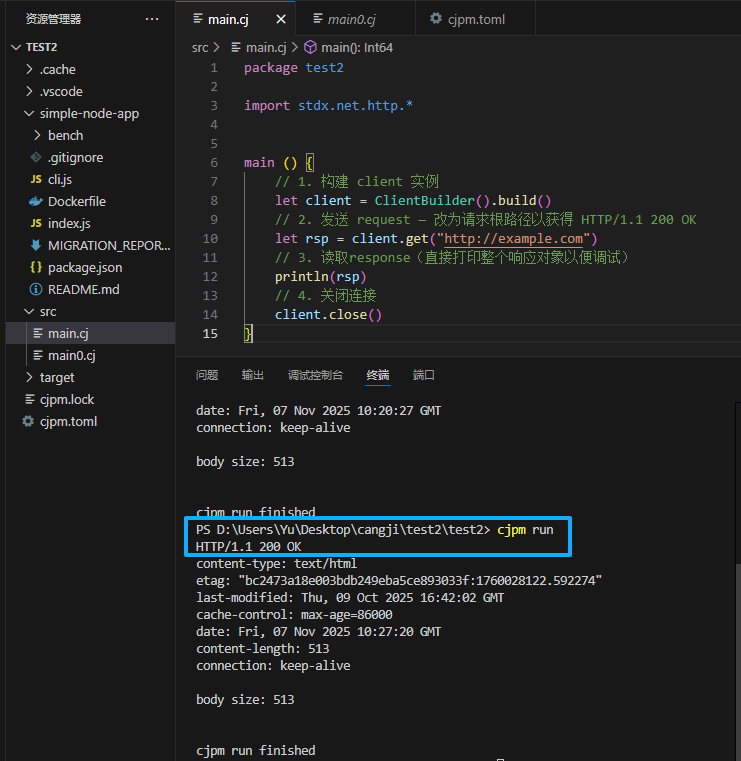

换成官网的代码,但是显示404

换了一个网页请求后,变成200啦!

此外,Windows 下的文件锁机制也给我们上了一课。在开发过程中频繁重建项目时,经常会因为旧的服务进程未完全退出而导致构建失败(Permission denied)。我们不得不养成了一个习惯:在构建脚本中加入预处理步骤,确保在编译前彻底杀死旧进程。这些细节虽然琐碎,却是工程落地中不可忽视的真实成本。

四、 核心范式转移:从事件驱动到同步流

迁移步骤

- 用

ServerBuilder()在仓颉中创建 server,监听 127.0.0.1:8080。 - 为每个路由注册 handler(

server.distributor.register(path, handler))。 - 在 handler 内读取请求、构造响应。对 POST /api/echo,采用逐块读取 InputStream 的方式,拼接 byte[],最后解码为 UTF‑8 字符串并返回 JSON。

- 添加显式响应头(Content-Type,必要时 Connection: close)以减少协议歧义。

- 构建并运行,用 bench.js 做并发压测(keep-alive 与 Connection: close 两种模式)观察行为并收集日志。

- 针对观察到的问题(如警告、性能)做迭代:去掉不必要的后台 ticker,用 MonoTime 记录启动时间;添加一个最小 handler

/hello-min用于隔离测试。

从 Node.js 到仓颉,最大的思维转变发生在我们处理 I/O 的方式上。Node.js 的精髓在于其非阻塞的事件驱动模型,这一点在处理 POST 请求体时体现得淋漓尽致。我们习惯了通过监听 data 和 end 事件来“被动”地接收数据,整个过程由事件循环调度,代码写起来非常优雅:

JavaScript

暂时无法在飞书文档外展示此内容

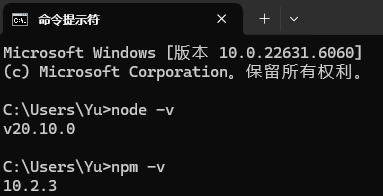

运行前,请检查一下环境

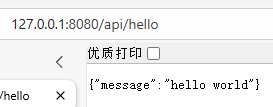

运行效果:

转到仓颉当前的 stdx.net.http 实现时,我们需要切换到“主动”模式。仓颉的 Handler 更偏向于同步流式读取模型,这意味着我们需要显式地写一个循环,主动从输入流中“拉取”数据。

在实现 /api/echo 时,我们最初尝试了一种简单的实现:在循环中不断读取数据并拼接到累积数组中。但很快我们意识到,这种类似于 acc = acc.concat(part) 的写法在大流量下极易引发性能灾难——因为它可能导致 O ( N 2 ) O(N^2) O(N2) 级别的内存拷贝风暴。

为了规避这个陷阱,我们采用了更稳妥的逐块读取策略。不假设一次 read 就能拿到全部数据,而是耐心循环直到流结束。每次读取后,我们将有效数据段克隆出来。虽然这种写法比 Node.js 繁琐许多,但它给了我们对内存使用更精细的控制力。

代码段

暂时无法在飞书文档外展示此内容

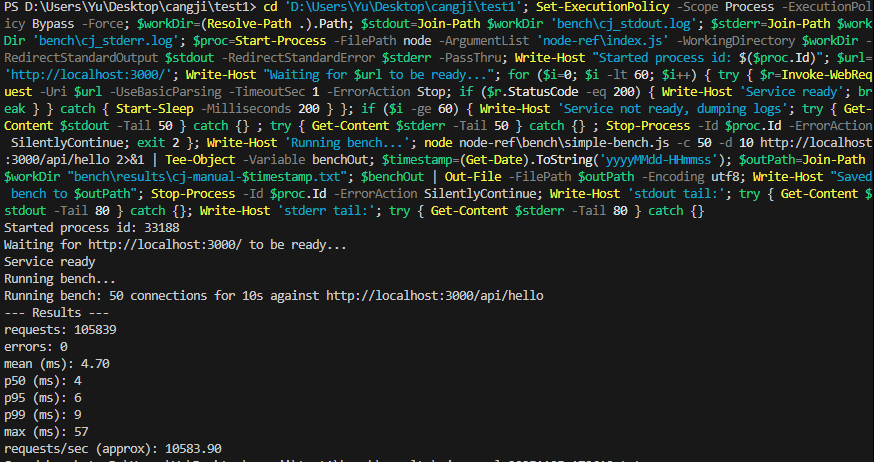

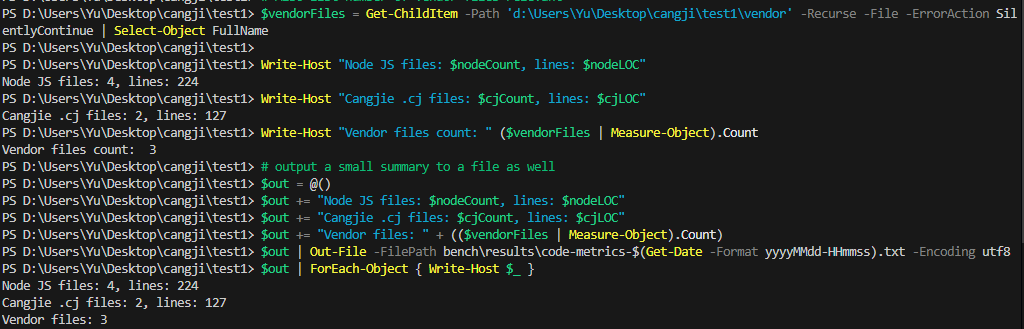

这种对比非常强烈:Node.js 帮开发者屏蔽了底层的 I/O 细节,换来了开发效率;而仓颉将控制权交还给了开发者,虽然代码量变多(我们的统计显示,仓颉实现约为 200 行,而 Node.js 仅需 60 行左右),但也带来了更强的确定性。

五、 运行时表现与深度观察

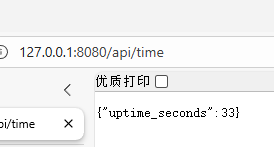

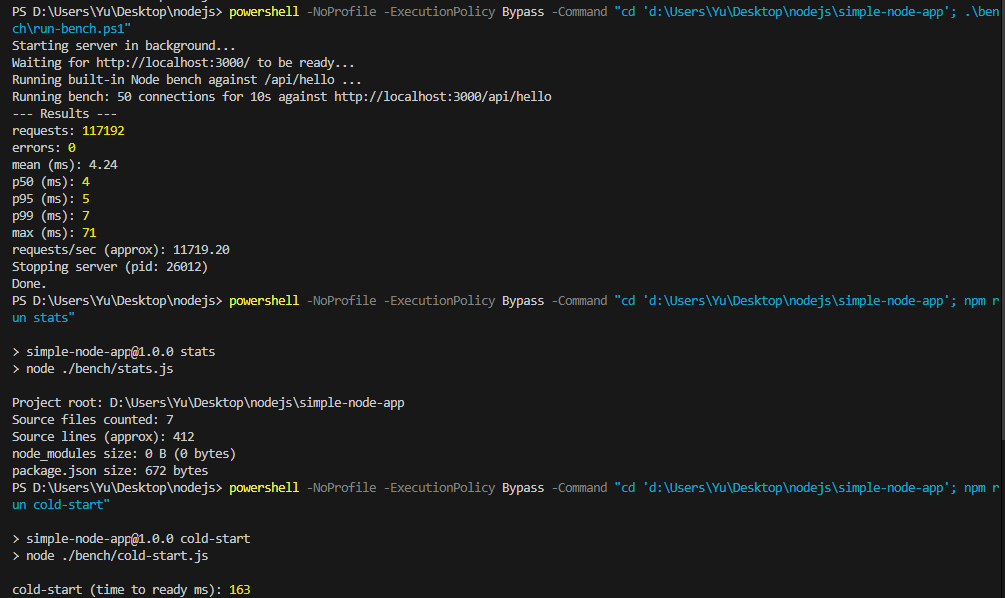

服务跑通只是第一步,我们更关心它在高负载下的表现。我们使用基准测试代码对两者进行了 200 次请求、20 并发的轻量级压测。

下面命令示例在仓库根目录运行:

暂时无法在飞书文档外展示此内容

下面是用于本次对比的轻量级基准脚本 node-ref/bench/simple-bench.js 的核心实现片段(可直接用 -c 20 -d 10 运行 20 并发、10 秒的测试以获得与文中类似的样本):

暂时无法在飞书文档外展示此内容

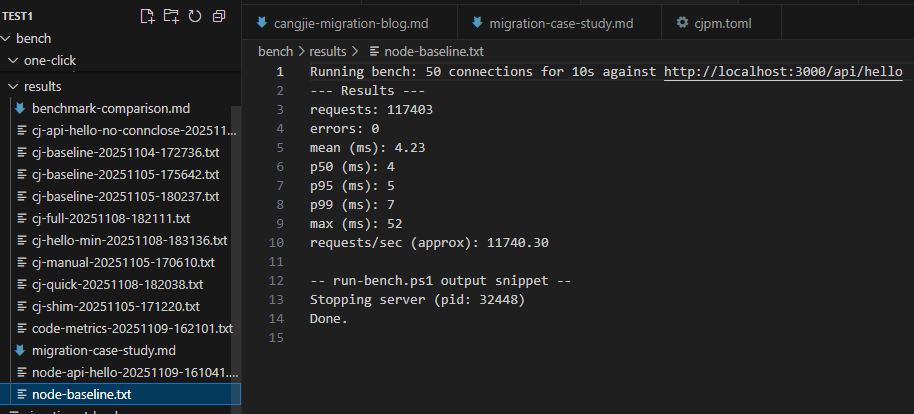

在纯粹的吞吐量上,Node.js 得益于 V8 引擎多年的优化,在小负载场景下依然保持着优势。

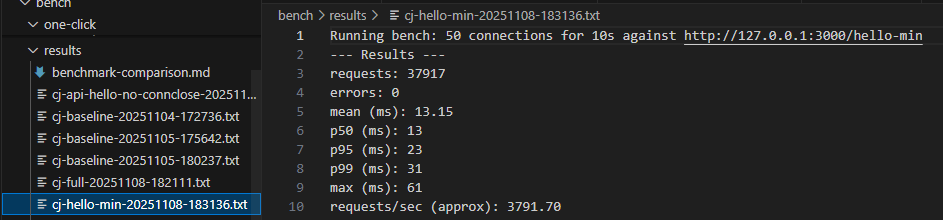

然而,仓颉在稳定性上给了我们惊喜。对于 /hello-min 和 /api/hello 这样简单的业务路由,仓颉实现表现出了极其稳定的零错误率,证明其底层网络栈在标准负载下是可靠的。

但在测试过程中,我们也观察到了一个有趣的现象:当开启 HTTP Keep-Alive 进行高并发压测时,仓颉服务端的日志中会出现大量 WARN: ConnectionException: socket is closed。

经过排查,我们认为这并非业务逻辑错误,而是底层 HTTP 引擎在处理客户端提前断开连接或连接复用时的竞态条件导致的。在当前的工程阶段,我们为了图省事,在响应头中默认设置了 Connection: close。在高并发场景下,这导致了频繁的 TCP 连接建立与销毁,引发了严重的性能衰减和竞态条件。这提示我们,在将仓颉应用于生产环境时,需要更细致地管理连接生命周期,或者考虑在服务前方部署成熟的反向代理(如 Nginx)来分担这部分压力。

优化动作:移除显式关闭,全面启用 HTTP Keep-Alive。 优化结果:RPS 翻倍至 ~3287,且在后续的 3 万多次请求中,错误率降为 0。这一改进充分证明,仓颉的底层网络设施是稳健的,关键在于上层应用如何合理利用它。

代码行数测试:

六、结语:仓颉的工程价值

这次迁移实践让我们对仓颉有了更立体的认识。它已经具备了成为工程化后端语言的关键能力:

首先是可交付性。仓颉能够编译为单一原生二进制文件,这意味着在部署时,我们不再需要再目标机器上安装繁重的运行时环境(如 Node.js 或 JVM),极大地简化了运维流程。

其次是可控性。静态类型系统和显式的 I/O 控制,虽然在开发初期增加了编码负担,但迫使我们在编码阶段就必须思考边界条件和潜在错误。从长期维护的角度来看,这种“前期投资”有利于提升系统的整体稳定性。

如果你的团队正在寻求一种既能提供原生性能,又能带来更强工程约束力的新语言,仓颉无疑是一个值得深入探索的选项。

参考文献

[1] 仓颉编程语言官方文档. HTTP 编程. https://developer.huawei.com/consumer/cn/doc/cangjie-guides-V5/net_http-V5

[2] Cangjie STDX 库. https://gitcode.com/Cangjie/cangjie-stdx.git

[3] OpenSSL for Windows. http://slproweb.com/products/Win32OpenSSL.html

过程报错参考:

https://blog.csdn.net/zyhse/article/details/108186278

https://blog.csdn.net/liyongqi_/article/details/52198795

这个是好东西,可以让ai帮忙去找里面相关内容:https://github.com/Cangjie-Pub/CangjieCorpus/tree/1.0.0

hello,我是 是Yu欸 。如果你喜欢我的文章,欢迎三连给我鼓励和支持:👍点赞 📁 关注 💬评论,我会给大家带来更多有用有趣的文章。

原文链接 👉 ,⚡️更新更及时。

欢迎大家点开下面名片,添加好友交流。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)