运维必知必会AI大模型知识之四:损失函数

损失函数是机器学习模型训练过程中的关键部分,理解其原理对于成功训练和优化模型至关重要。选择合适的损失函数、计算梯度、处理数值稳定性问题以及使用优化算法是提高模型性能的重要步骤。注:实际训练中常联合多种损失(如预训练+对比损失),同时结合分布式训练的梯度聚合策略(如ZeRO、Pipeline并行)。例如:预测下一个词时,模型需捕捉到"苹果"后面更可能接"公司"(实体关联)而非"月亮"(常识错误)。大

声明:让所有运维人一起拥抱AI,拥抱大模型,拥抱变化!公众号全新改版升级【互联网及大模型运维】

大语言模型(LLM)的损失函数是其训练和优化的核心驱动力,不同阶段的损失函数承担着引导模型学习语言规律、对齐人类意图、提升任务性能等多重作用。以下是具体分析:

1. 引导模型学习语言规律

- 预训练阶段:

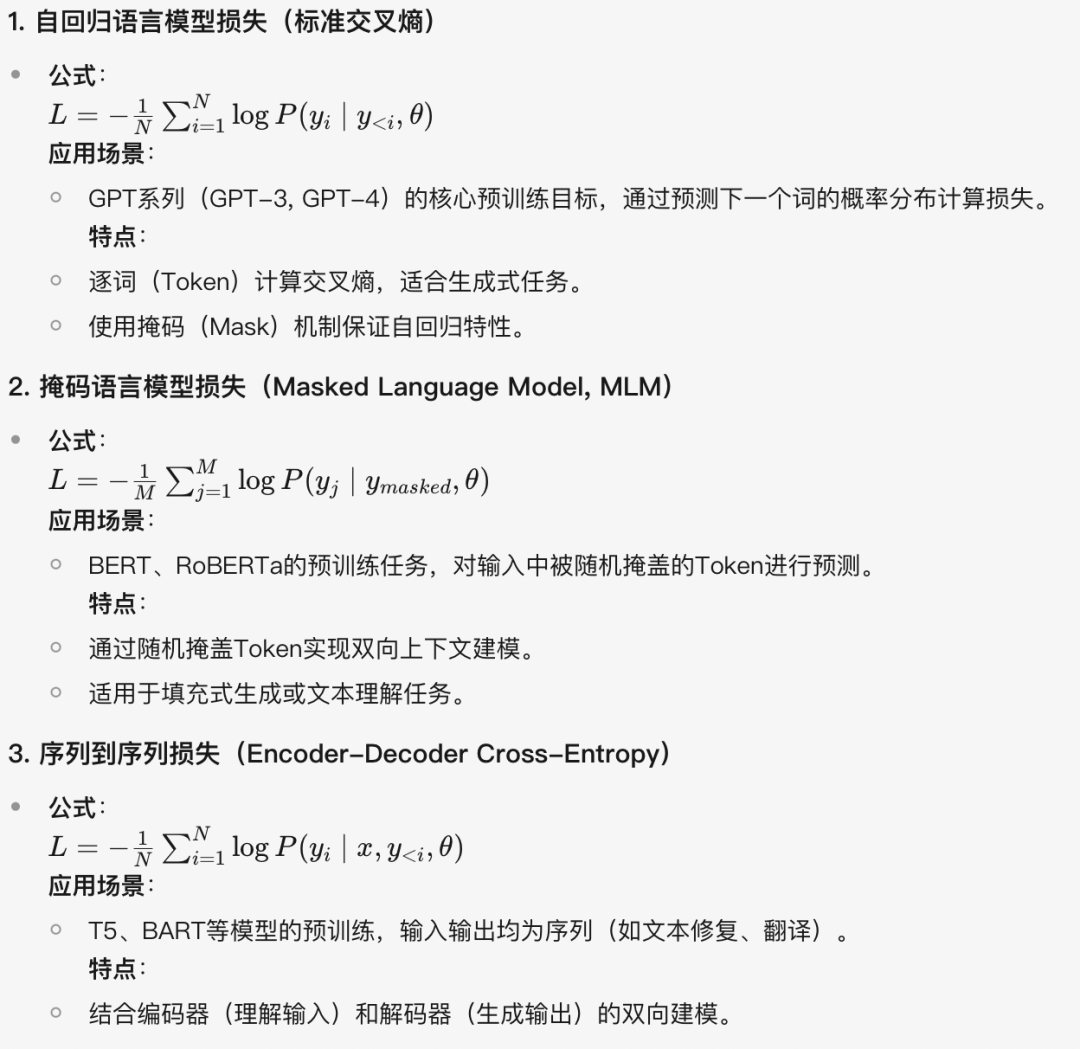

通过自回归交叉熵(如GPT)或掩码语言模型损失(如BERT),迫使模型建模词与词之间的条件概率分布,学习语言的语法、语义和上下文关系。

-

-

例如:预测下一个词时,模型需捕捉到"苹果"后面更可能接"公司"(实体关联)而非"月亮"(常识错误)。

-

本质:让模型从海量文本中压缩并记忆语言统计规律。

-

2. 对齐人类偏好与价值观

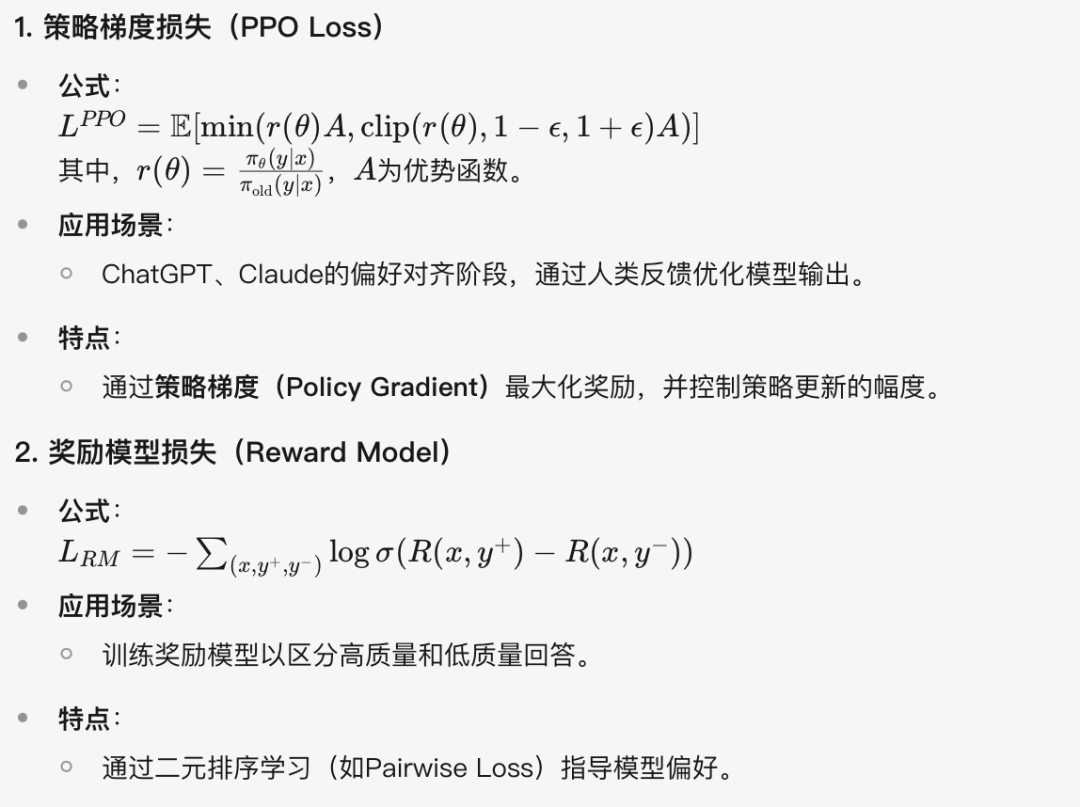

- 强化学习阶段(RLHF):

通过PPO损失和奖励模型损失,将模型输出与人类标注的高质量回答对齐,减少有害、偏见或无意义的生成。

-

-

例如:ChatGPT被设计为拒绝回答如何制造炸弹的问题,这依赖于奖励模型对负面行为的惩罚。

- 本质:将隐式的语言规律转化为显式的价值观约束。

-

3. 提升特定任务性能

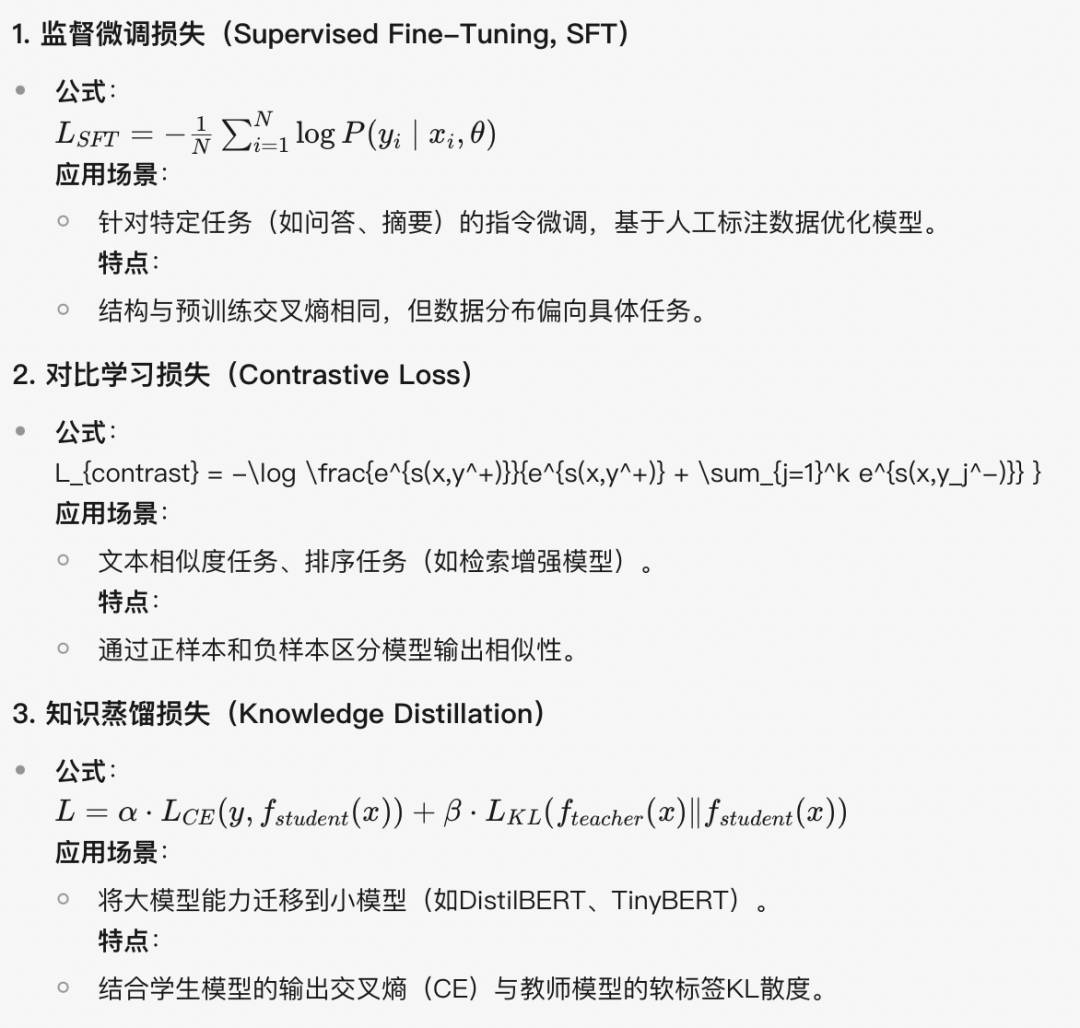

- 监督微调(SFT):

在特定任务(如翻译、摘要)上使用交叉熵损失,缩小预训练通用能力与下游任务需求之间的差距。

-

-

例如:将GPT-3通过指令微调转化为面向客服的模型,使其更擅长生成礼貌且简洁的回答。

- 本质:通过领域数据调整模型参数分布,强化任务相关性。

-

以下是关于大语言模型(LLM)常用的损失函数总结,结合了预训练、微调、强化学习等不同阶段的损失设计(排版考虑直接截图):

一、预训练阶段损失函数

二、微调阶段损失函数

三、强化学习阶段损失(RLHF)

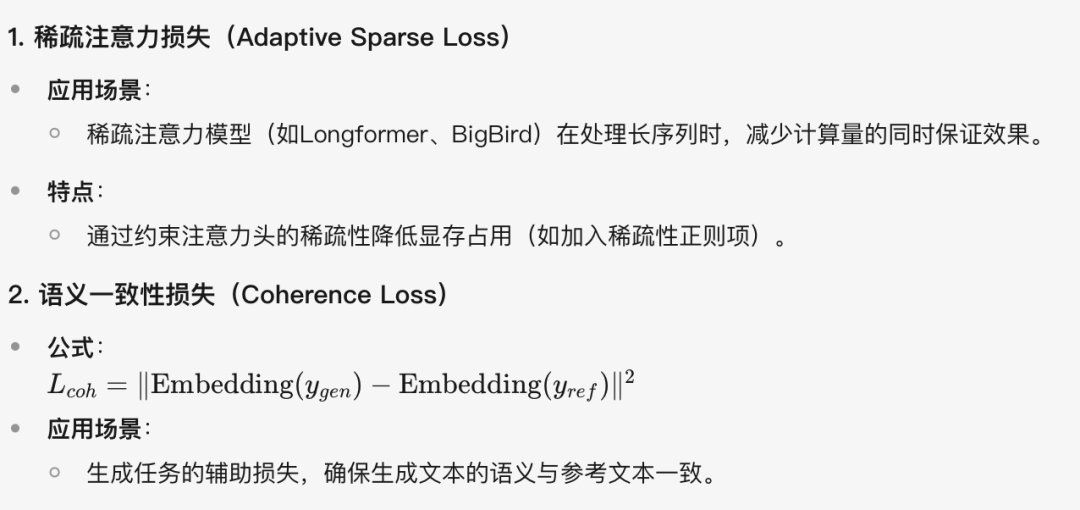

四、其他特殊损失设计

总结

| 阶段 | 损失函数 | 典型模型 | 核心目标 |

|---|---|---|---|

|

预训练 |

自回归/MLM交叉熵 |

GPT、BERT |

通用语言表示学习 |

|

监督微调 |

SFT交叉熵 |

InstructGPT |

任务适应性与指令遵循 |

|

强化学习对齐 |

PPO Loss + 奖励模型 |

ChatGPT、Claude |

输出符合人类偏好 |

|

知识迁移 |

蒸馏损失(KL+CE) |

DistilBERT |

模型压缩与加速 |

注:实际训练中常联合多种损失(如预训练+对比损失),同时结合分布式训练的梯度聚合策略(如ZeRO、Pipeline并行)。

-

总结

损失函数是机器学习模型训练过程中的关键部分,理解其原理对于成功训练和优化模型至关重要。选择合适的损失函数、计算梯度、处理数值稳定性问题以及使用优化算法是提高模型性能的重要步骤。

最终,损失函数的设计直接决定了模型的能力上限(如是否支持多语言、复杂推理)和行为边界(如是否安全可控),是大模型技术栈中最具战略意义的组件之一。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)