决策树(decision tree):机器学习中的经典算法

决策树具有由根节点、分支节点、内部节点和叶节点组成的层次结构,是一种用于分类和回归应用的非参数监督学习方法。它是一种应用于多个不同领域的工具。这些树既可用于分类,也可用于回归问题。从名称本身就可以看出,它使用类似树形结构的流程图来显示一系列基于特征的拆分所产生的预测结果。它以根节点开始,以叶节点做出的决定结束。

决策树(decision tree):机器学习中的经典算法

文章目录

引言

决策树(Decision Tree)作为一种直观、易理解的机器学习算法,广泛应用于分类和回归问题中。它不仅在学术界具有重要的研究价值,也在实际工程应用中得到了广泛的推广与实践。决策树的构建过程能够将复杂的决策问题通过树形结构的方式进行可视化表示,使得模型的解释性大大增强,这也使得决策树成为许多领域中首选的机器学习算法之一。然而,尽管决策树在多种场景中表现优异,但它依然存在过拟合等缺点,这促使了大量的改进算法和集成方法的提出。本文将深入探讨决策树的基本原理、训练过程、评估指标、应用场景及其缺陷,全面分析其优势与局限性。

什么是决策树

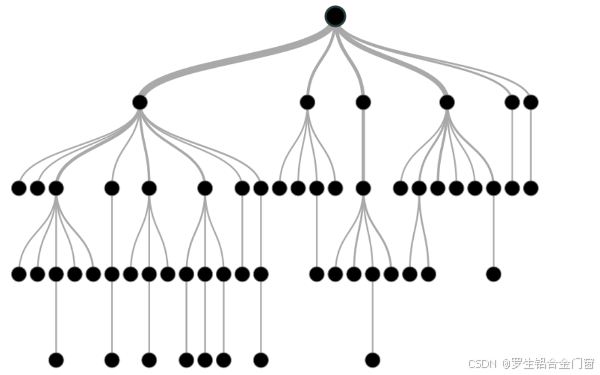

决策树具有由根节点、分支节点、内部节点和叶节点组成的层次结构,是一种用于分类和回归应用的非参数监督学习方法。它是一种应用于多个不同领域的工具。这些树既可用于分类,也可用于回归问题。从名称本身就可以看出,它使用类似树形结构的流程图来显示一系列基于特征的拆分所产生的预测结果。它以根节点开始,以叶节点做出的决定结束。

决策树的数学原理

决策树的构建主要依赖于一种贪心策略,通过选择能够最大化某种“纯度”度量的特征进行划分。在分类问题中,常见的纯度度量包括信息增益、信息增益率以及基尼指数;在回归问题中,常用的度量则是均方误差(MSE)。

信息增益与ID3算法

信息增益是通过计算某一特征对数据集的划分能力来度量该特征的重要性。具体地,信息增益是数据集划分前后的信息熵变化量。信息熵是一个衡量数据纯度的概念,值越小,数据越纯净;反之,值越大,数据越混乱。

对于数据集 D D D,如果我们选择特征 A A A 进行划分,信息增益 I G ( D , A ) IG(D,A) IG(D,A) 的计算公式如下::

I G ( D , A ) = H ( D ) − ∑ v ∈ V a l u e s ( A ) ∣ D v ∣ ∣ D ∣ H ( D v ) IG(D, A) = H(D) - \sum_{v \in Values(A)} \frac{|D_v|}{|D|} H(D_v) IG(D,A)=H(D)−v∈Values(A)∑∣D∣∣Dv∣H(Dv)

其中, H ( D ) H(D) H(D) 表示数据集 D D D 的信息熵, D v D_v Dv 表示在特征 A A A 上取值为 v v v 的数据子集, V a l u e s ( A ) Values(A) Values(A) 是特征 A A A 的所有可能取值。

I D 3 ID3 ID3算法通过计算各个特征的信息增益,选择信息增益最大的特征进行分裂。这个过程会一直持续,直到所有样本都被正确分类,或者没有更多特征可以进一步划分为止。

基尼指数与CART算法

与信息增益不同,CART(Classification and Regression Trees)算法采用基尼指数(Gini Index)作为划分标准。基尼指数是一种衡量数据集纯度的指标,值越小,数据集的纯度越高。

基尼指数的计算公式如下:

G i n i ( D ) = 1 − ∑ i = 1 k p i 2 Gini(D) = 1 - \sum_{i=1}^{k} p_i^2 Gini(D)=1−i=1∑kpi2

其中, p i p_i pi 是数据集中类别 i i i 的概率, k k k 是类别的总数。CART算法通过选择基尼指数最小的特征进行数据划分。对于每个特征,CART计算其所有可能的划分,并选择使得基尼指数最小的划分方式。

递归分割与停止条件

决策树的构建过程是递归的,每次选择一个特征进行数据的划分,直到满足停止条件。常见的停止条件包括:树的深度达到预设的最大值、节点中的样本数小于设定的阈值、节点的纯度达到预定标准(如所有样本属于同一类别)等。

决策树术语

根节点: 决策树开头的初始节点,整个群体或数据集从这里开始根据各种特征或条件进行划分。

决策节点: 根节点拆分后产生的节点称为决策节点。这些节点代表树中的中间决策或条件。

叶节点: 无法进一步拆分的节点,通常表示最终分类或结果。叶节点也被称为终端节点。

子树: 与图形的子部分称为子图形类似,这些树的子部分称为子树。它代表决策树的特定部分。

修剪: 删除或削减树中特定节点的过程,以防止过度拟合并简化模型。

分支/子树: 整个树的一个分节称为分支或子树。它代表树中决策和结果的特定路径。

父节点和子节点: 在决策树中,被划分为子节点的节点称为父节点,从父节点衍生出来的子节点称为子节点。父节点代表一个决策或条件,而子节点则代表基于该条件的潜在结果或进一步决策。

决策树示例

让我们借助一个例子来了解决策树:

决策树是上下颠倒的,这意味着根节点在顶端,然后这个根节点又被分成不同的节点。通俗地说,决策树就是一堆 if-else 语句。它检查条件是否为真,如果为真,则转到与该决策相关的下一个节点。

在下图中,树首先会问天气如何?是晴天、阴天还是雨天?如果是,它就会转到下一个特征,即湿度和风。它将再次检查是强风还是弱风,如果是弱风且下雨,那么这个人就可以去玩了。

在上面的流程图中,你注意到什么了吗?我们看到,如果天气是阴天,我们就必须去玩。为什么没有分得更多?它为什么停在那里?

要回答这个问题,我们还需要了解一些概念,比如熵、信息增益和基尼指数。但简单来说,我可以说,训练数据集的输出总是 “是”,因为这里没有无序性,所以我们不需要进一步拆分节点。

机器学习的目标是减少数据集的不确定性或混乱,为此,我们使用了这些树。

现在你一定在想,我怎么知道什么应该是根节点,什么应该是决策节点,什么时候应该停止拆分?要确定这一点,有一个叫做 "熵 "的指标,它是数据集中不确定性的大小。

如何训练决策树模型

训练决策树的过程可以分为以下几个步骤:

- 选择分裂特征:首先,通过计算每个特征的纯度度量(如信息增益或基尼指数),选择最优的特征进行数据划分。

- 递归划分:对于每个分支,通过递归的方式继续选择最佳特征进行进一步划分。每次递归划分会生成一个新的节点,直到达到停止条件。

- 构建树结构:通过不断选择特征进行分裂,最终构建出完整的树结构。每个叶子节点表示最终的分类或回归结果。

- 剪枝(可选):为了避免过拟合,决策树可能需要进行剪枝操作。剪枝可以通过合并某些分支或者删除过深的子树来简化模型,从而提高其泛化能力。

代码块:

# 导入所需的库

import numpy as np

import pandas as pd

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.tree import DecisionTreeClassifier

from sklearn.metrics import classification_report, accuracy_score

from sklearn import tree

import matplotlib.pyplot as plt

# 加载鸢尾花数据集

iris = load_iris()

X = iris.data # 特征矩阵

y = iris.target # 标签

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 初始化决策树分类器

dt_classifier = DecisionTreeClassifier(criterion='gini', max_depth=5, random_state=42)

# 训练决策树模型

dt_classifier.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = dt_classifier.predict(X_test)

# 输出分类报告

print("分类报告:")

print(classification_report(y_test, y_pred))

# 输出准确率

print("准确率:")

print(f"{accuracy_score(y_test, y_pred) * 100:.2f}%")

# 绘制决策树

plt.figure(figsize=(12, 8))

tree.plot_tree(dt_classifier, filled=True, feature_names=iris.feature_names, class_names=iris.target_names, rounded=True)

plt.title("Decision Tree Visualization")

plt.show()

决策树的评估指标

评估决策树模型的性能通常依赖于以下几个常见的指标:

- 准确率(Accuracy):准确率是最常用的分类模型评估指标之一,表示模型预测正确的样本占总样本的比例。尽管准确率简单易懂,但在数据不平衡的情况下,可能不能反映模型的真实性能。

- 精确度、召回率与F1-score:精确度(Precision)表示正类预测为正类的样本占所有预测为正类样本的比例;召回率(Recall)表示正类预测为正类的样本占所有实际正类样本的比例。F1-score是精确度和召回率的调和平均数,常用于处理类别不平衡问题。

- 混淆矩阵(Confusion Matrix):混淆矩阵通过对比真实标签和预测标签,全面展示分类模型的性能,包含了四个主要指标:真阳性(TP)、假阳性(FP)、真阴性(TN)和假阴性(FN)。

- 均方误差(MSE):对于回归问题,决策树的评估通常使用均方误差来度量预测值与实际值之间的差距。MSE越小,模型的预测能力越强。

决策树的应用场景

决策树具有很强的解释性和直观性,广泛应用于多个领域,特别是在需要清晰决策逻辑的场景中。以下是一些典型的应用场景:

- 金融风控:决策树在银行、保险等金融行业中广泛应用于信用评分和风险评估。例如,通过客户的信用历史、收入水平等特征,决策树可以帮助金融机构评估客户的违约风险。

- 医学诊断:在医学领域,决策树被用于疾病预测与诊断。通过患者的症状、体检结果等特征,决策树可以帮助医生判断疾病类型或做出治疗建议。

- 市场营销:决策树可以帮助公司分析客户数据,制定精准的营销策略。通过对客户行为、购买历史等数据进行分析,决策树能够识别出潜在的目标客户群体。

- 智能推荐:在推荐系统中,决策树被用来根据用户的历史行为和兴趣数据,预测用户可能感兴趣的产品或服务。

决策树的缺点

尽管决策树在许多领域表现出色,但它仍然存在一定的局限性。主要缺点包括:

- 过拟合:决策树模型容易在训练数据上表现过于优异,导致在新数据上的泛化能力较差。过拟合通常发生在决策树过深或树结构过于复杂时,捕捉到数据中的噪声和细节。

- 不稳定性:决策树对数据的变化较为敏感,训练过程中一个小的变化可能导致树结构发生较大的变化。这使得决策树在处理噪声数据时不够稳定。

- 处理高维数据能力差:当特征空间非常大时,决策树的训练和预测效率会下降,且容易受到“维度灾难”的影响。

复杂时,捕捉到数据中的噪声和细节。 - 不稳定性:决策树对数据的变化较为敏感,训练过程中一个小的变化可能导致树结构发生较大的变化。这使得决策树在处理噪声数据时不够稳定。

- 处理高维数据能力差:当特征空间非常大时,决策树的训练和预测效率会下降,且容易受到“维度灾难”的影响。

- 偏向于具有更多类别的特征:决策树的构建过程中,可能会偏向于选择那些拥有更多取值的特征(例如类别数较多的特征),这可能导致模型的偏差。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)