ollama在mac系统上的安装

最近我在学习大模型相关的知识,因此想通过本地运行一些离线大模型来观察效果。经过了解,我发现Ollama可以运行离线模型,于是决定记录一下Ollama的安装过程。

·

1、背景

最近我在学习大模型相关的知识,因此想通过本地运行一些离线大模型来观察效果。经过了解,我发现Ollama可以运行离线模型,于是决定记录一下Ollama的安装过程。

2、Ollama是什么

Ollama 是一个开源工具,旨在帮助用户轻松地在本地运行和管理大型语言模型(LLMs)。它提供了一个简单的命令行界面,使用户能够下载、部署和运行各种开源的大模型(如 LLaMA、GPT-J 等),而无需依赖云服务或互联网连接。

2.1 Ollama 的核心功能:

本地运行:Ollama 允许用户在本地计算机上运行大模型,适合对数据隐私或网络环境有要求的场景。模型管理:通过 Ollama,用户可以轻松下载、更新和管理不同的模型。简单易用:Ollama 提供了直观的命令行工具,用户只需几条命令即可启动和运行模型。跨平台支持:Ollama 支持 macOS、Linux 和 Windows 等主流操作系统。多种模型支持:Ollama 支持多种开源大模型,用户可以根据需求选择合适的模型。

2.2 典型使用场景:

离线推理:在没有互联网连接的环境中运行大模型。隐私保护:在本地处理敏感数据,避免将数据上传到云端。开发与测试:开发者可以在本地测试和调试大模型,而无需依赖外部服务。

3、安装步骤

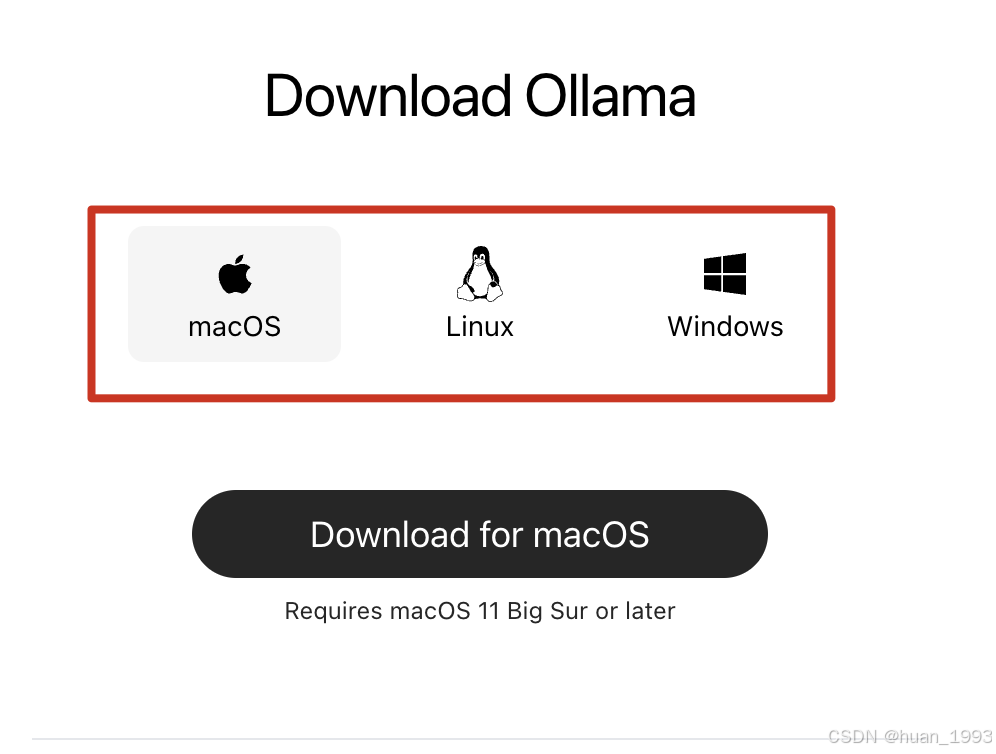

这里以Mac下载安装为例

3.1 进入Ollama的下载界面

3.2 安装

将下载下来的 zip包进行解压,然后放入到应用程序中。

3.3 Ollama默认模型目录

在mac系统中,模型的默认目录为~/.ollama/models,日志目录为~/.ollama/logs。

修改模型的默认目录,通过设置环境变量OLLAMA_MODELS=具体的路径来进行修改。

4、运行一个本地模型

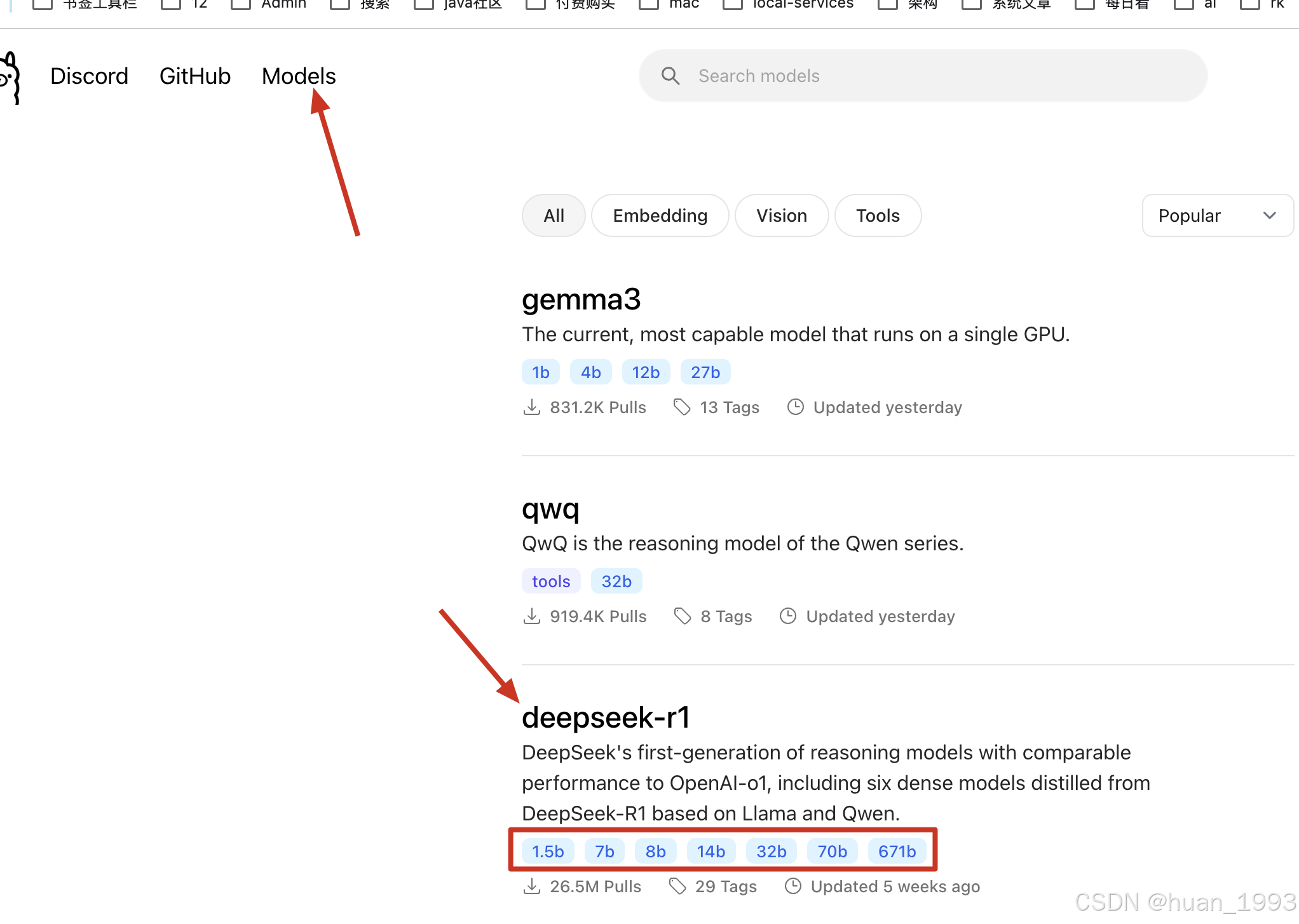

4.1 选择一个模型

在Ollama的模型页面进行搜索并选择一个合适的模型。

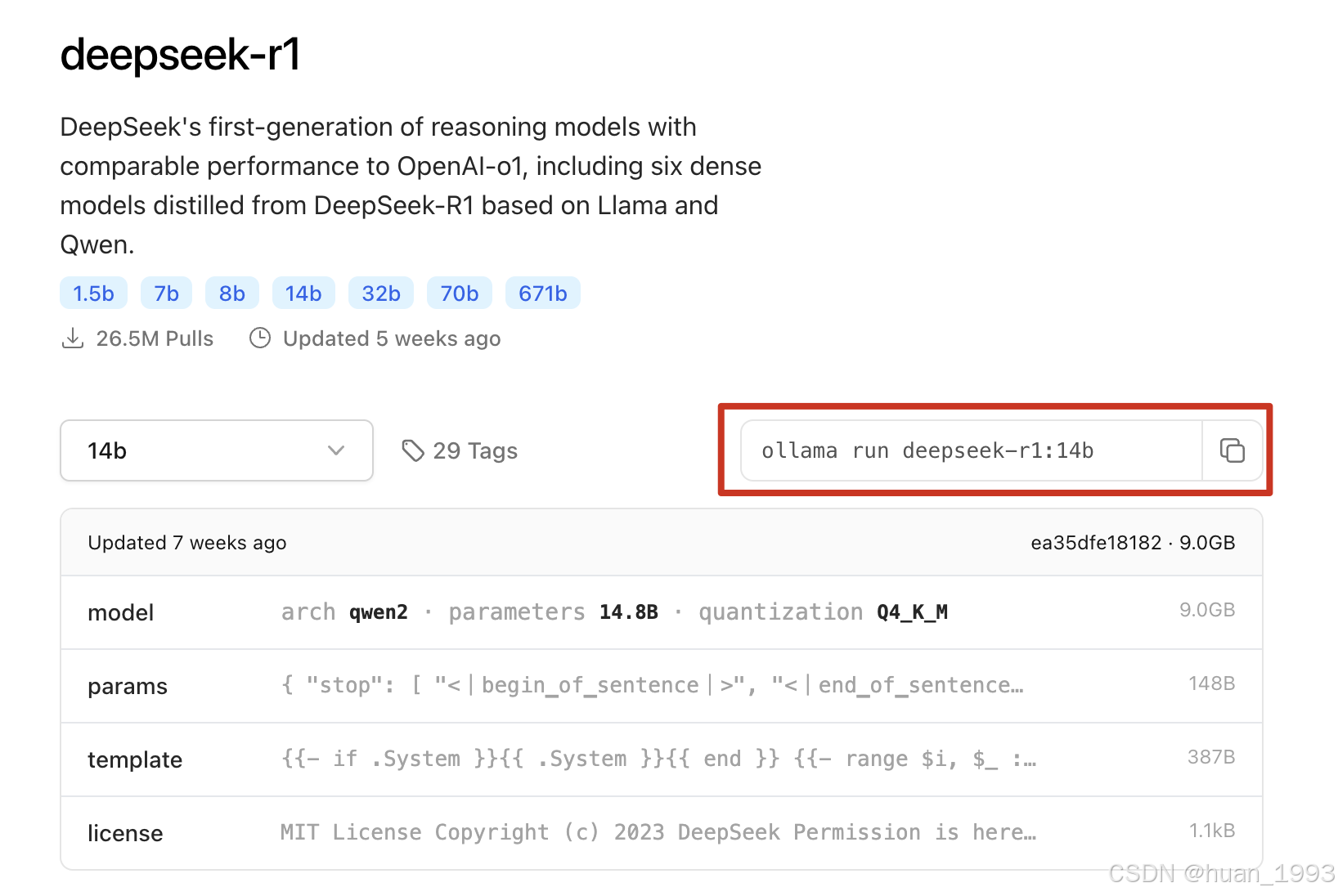

4.2 安装模型

此处以安装deepseek-r1-14b模型为例。 b表示10亿模型参数,b的值越小,需要的资源越小。

➜ ~ ollama pull deepseek-r1:14b

pulling manifest

pulling 6e9f90f02bb3... 100% ▕████████████████▏ 9.0 GB

pulling 369ca498f347... 100% ▕████████████████▏ 387 B

pulling 6e4c38e1172f... 100% ▕████████████████▏ 1.1 KB

pulling f4d24e9138dd... 100% ▕████████████████▏ 148 B

pulling 3c24b0c80794... 100% ▕████████████████▏ 488 B

verifying sha256 digest

writing manifest

success

➜ ~ ollama run deepseek-r1:14b

>>> Send a message (/? for help)

ollama run 如果这个模型在本地不存在的话,会先拉取模型,然后在运行模型。

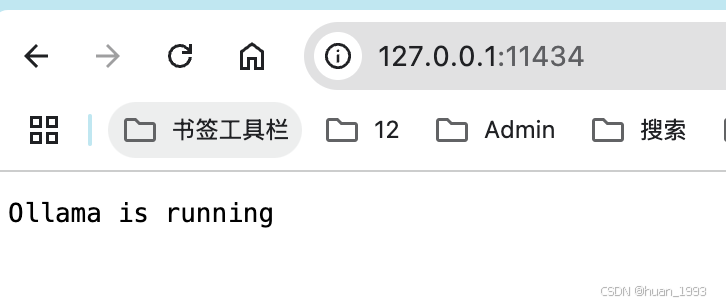

4.3 启动Ollama服务

在电脑中找到Ollama图标或在命令行中执行ollama server命令进行启动ollama服务。

修改ollama的运行端口: OLLAMA_HOST=0.0.0.0:11434 .

通过设置环境变量来解决。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)