ollama本地部署DeepSeek教程

本文主要介绍如何使用ollama本地部署deepseek大模型,以及使用WebUI工具界面进行交互

一、下载安装ollama

前往ollama官网Download Ollama on Windows进行下载,根据自己电脑系统(macOS、Linux、Windows)自行下载。

下载完成后进行安装,安装步骤比较简单这里不再赘述。(建议电脑内存至少留下4G的存储空间,因为后续还要下载模型!)

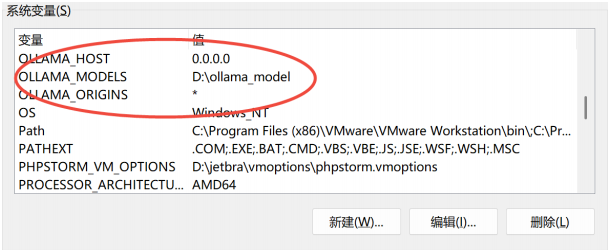

安装完成后,需要配置相关环境变量,在系统环境变量中添加以下三个变量:

OLLAMA_HOST:该变量用于指定 Ollama 服务的主机地址和端口。借助设置这个变量,你可以让 Ollama 客户端知晓连接到哪个 Ollama 服务实例。默认情况下,Ollama 服务会监听 127.0.0.1:11434。要是你更改了服务监听的地址和端口,就需要设置 OLLAMA_HOST 来确保客户端能正确连接。这里将 OLLAMA_HOST 环境变量设置为 0.0.0.0 时,意味着 Ollama 服务将监听服务器上所有可用的网络接口。

OLLAMA_MODELS:此变量用于指定存储模型的目录。Ollama 会在这个目录里存储和管理下载的模型。默认情形下,模型会被存于系统的用户数据目录。若想要把模型存到别的位置,就可以通过设置这个变量来达成。

OLLAMA_ORIGINS:该变量用于指定允许访问 Ollama API 的来源。在跨域请求时,Ollama 会依据这个变量来决定是否允许特定来源的请求。你可以设置多个来源,用逗号分隔。例如,设置为 http://example.com,https://another-example.com 就能允许这两个域名的请求访问 Ollama API。这里将 OLLAMA_ORIGINS 设置为 * ,表示允许来自任何来源的请求访问 Ollama API。也就是说,任何域名、IP 地址或者端口的客户端都可以向 Ollama 服务发送请求。这种设置在开发和测试环境中比较方便,因为你可以快速验证不同来源的客户端是否能够正常与 Ollama 服务进行交互。在生产环境中,将 OLLAMA_ORIGINS 设置为 * 存在一定的安全风险,因为它可能会导致未经授权的访问。建议在生产环境中,只允许特定的、受信任的来源访问 Ollama API,例如将 OLLAMA_ORIGINS 设置为你的应用程序的域名或 IP 地址。

二、下载deepseek模型

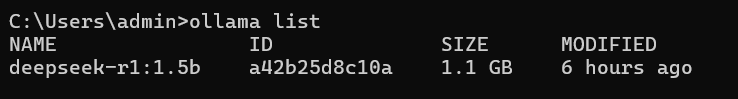

1.查看ollama中有哪些模型

ollama list

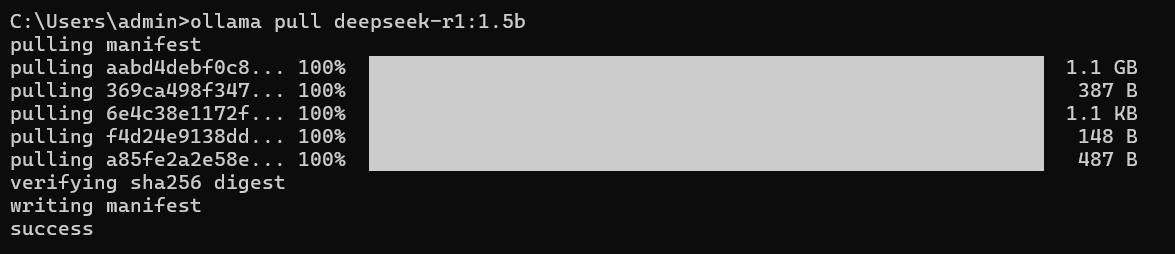

2.下载deepseek模型到本地,可根据自己电脑配置选择下载不同大小的模型,这里以deepseek-r1:1.5b为例

ollama pull deepseek-r1:1.5b

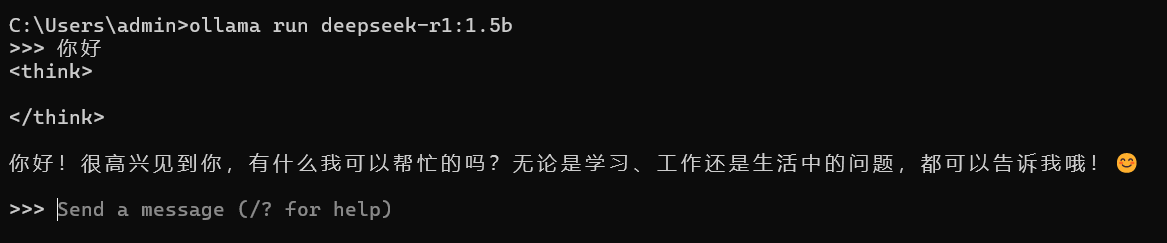

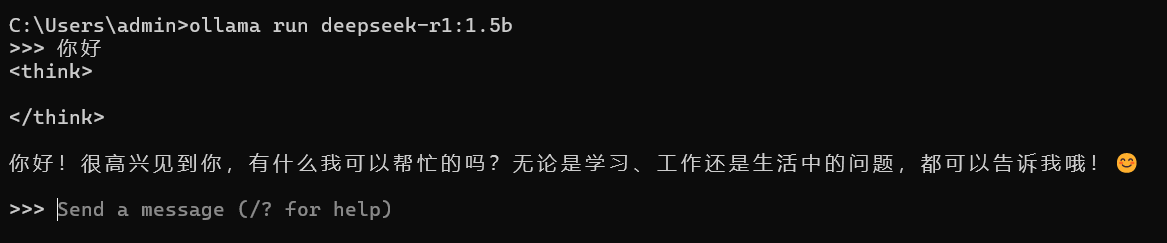

3.运行deepseek模型

ollama run deepseek-r1:1.5b

执行上述指令后即可运行与deepseek模型进行交互。

但是,上述交互界面是在cmd窗口下,为了能够更方便的进行交互,这里我们选择安装Open WebUI开源工具。

三、使用WebUI工具进行交互

1.安装Open WebUI

需要注意的是,安装Open WebUI之前需要先安装Docker!!!

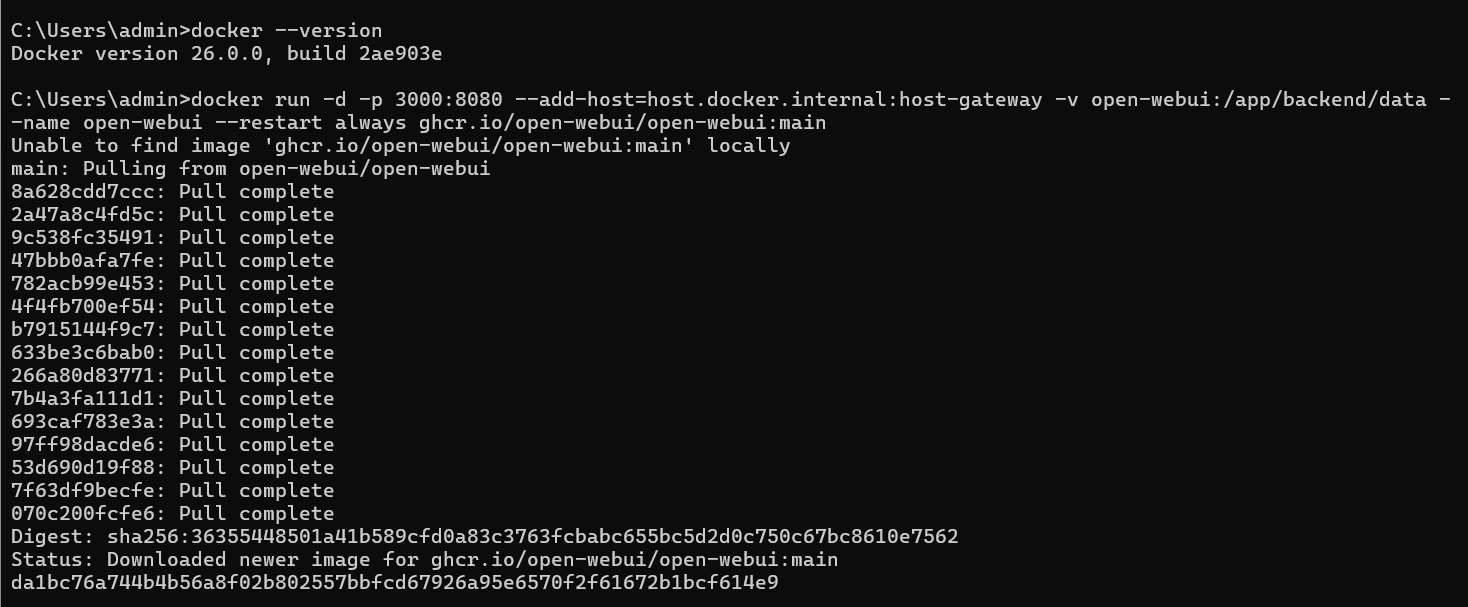

Open WebUI安装指令

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

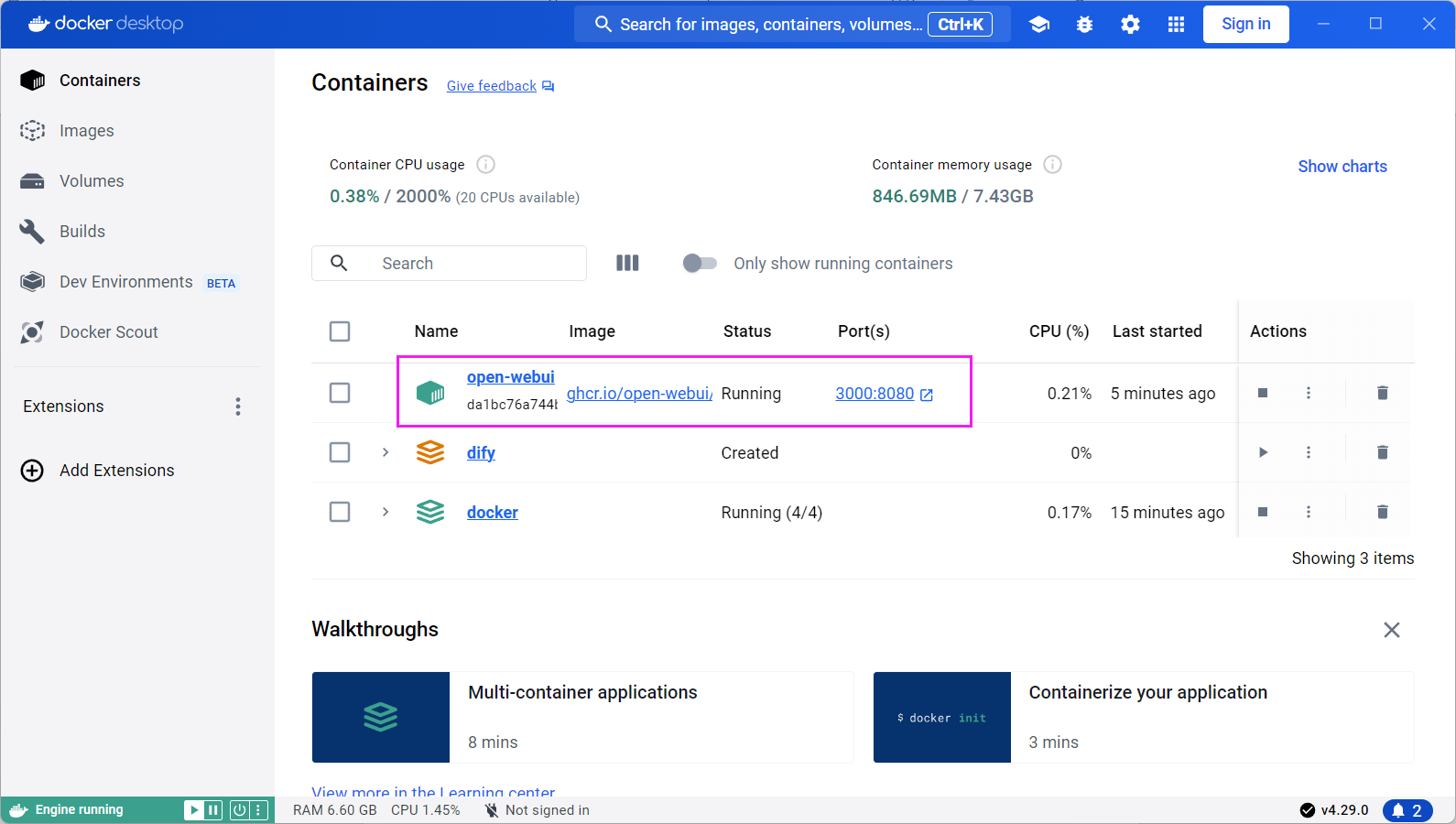

安装完成后,打开Docker应用界面即可发现出现了Open WebUI

2.在WebUI图形化界面使用本地部署的deepseek

首先要确保之前ollama中的deepseek处于开启状态,不要关闭运行界面。Docker也要开启。

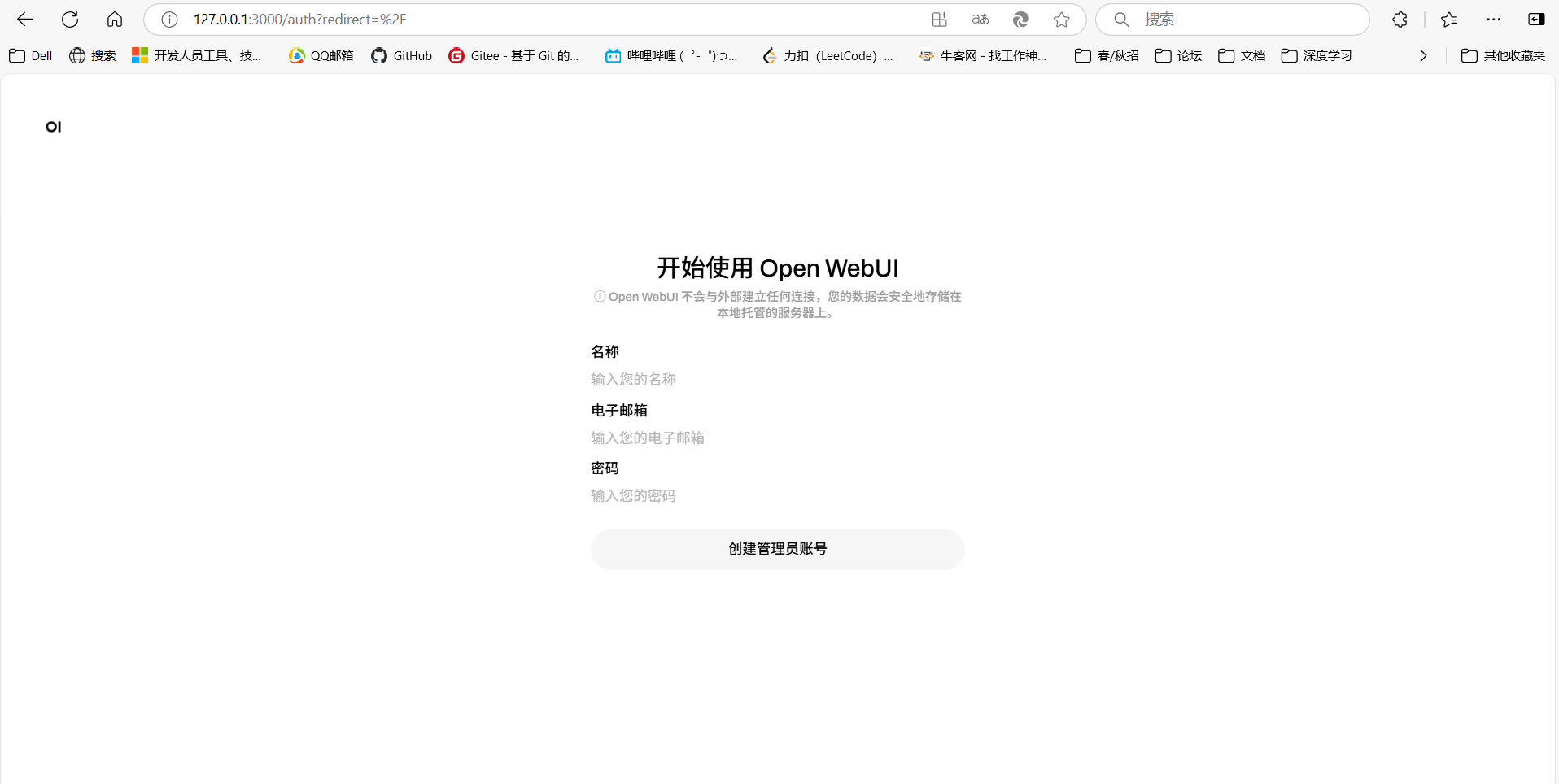

然后打开浏览器,输入127.0.0.1:3000出现如下界面:

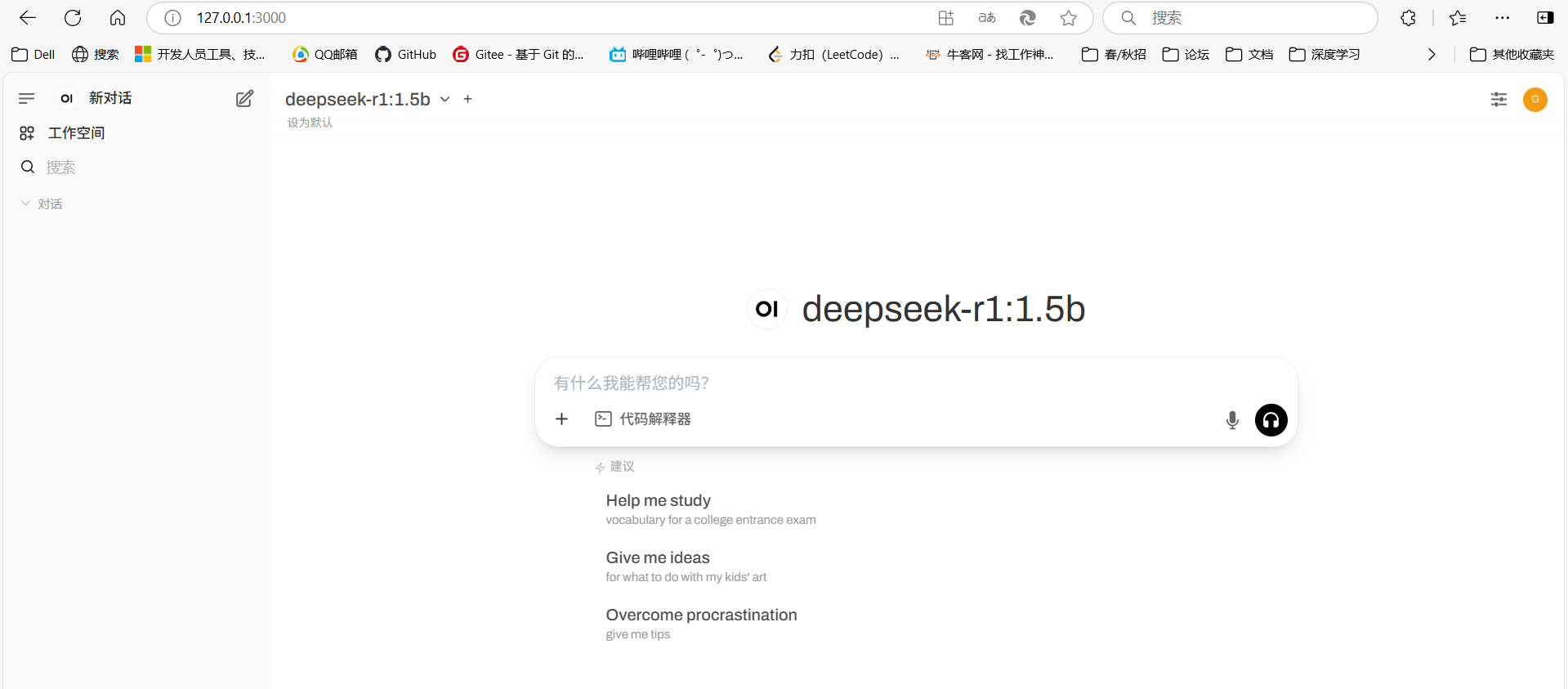

首次使用需要创建管理员账号,这里我们按照提示进行创建即可,创建完成后登录进入WebUI页面如下所示:

我们选择本地部署的deepseek-r1:1.5b模型,即可进行交互问答。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)