深度学习知识点4-Coordinate Attention(CA注意力机制)

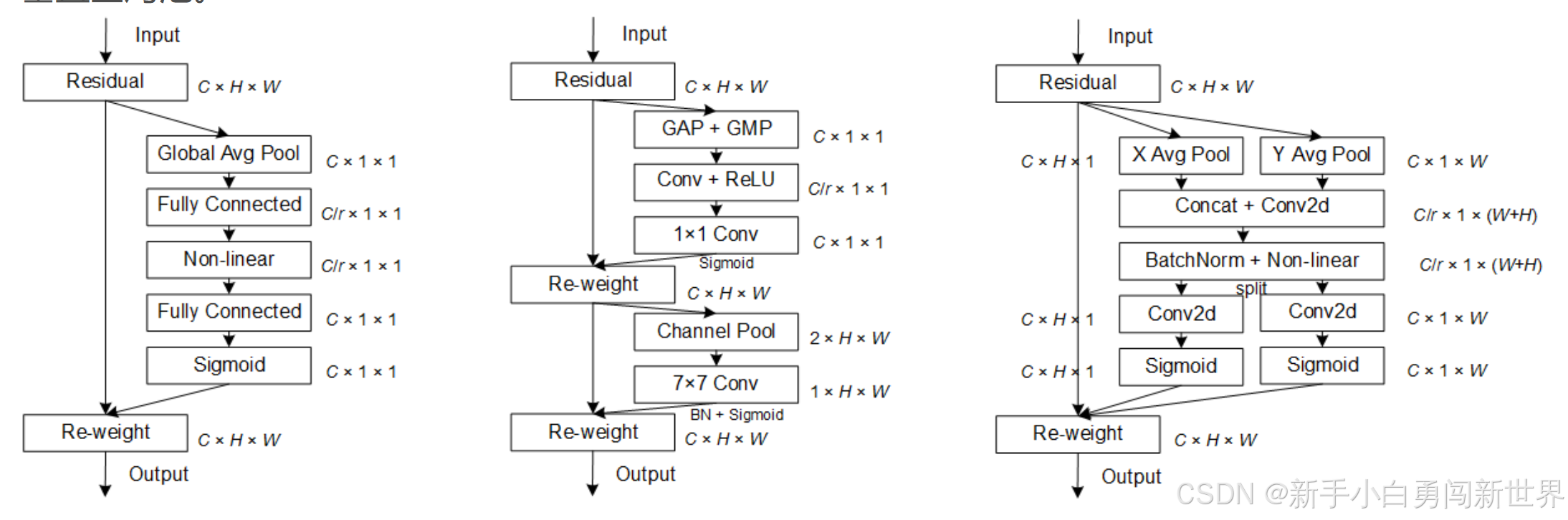

CA通过将2D通道注意力分解为两个1D编码过程,分别沿垂直和水平方向聚合特征。这样一来,模型不仅能捕获。,帮助模型在需要定位物体结构的任务中表现更优。如图为:SE、CBAM、CA。

·

如图为:SE、CBAM、CA

CA创新点:CA通过将2D通道注意力分解为两个1D编码过程,分别沿垂直和水平方向聚合特征。这样一来,模型不仅能捕获长距离的空间依赖关系,还能保留细粒度的位置信息,帮助模型在需要定位物体结构的任务中表现更优。

CA的结构和工作流程:

- CA通过1D池化操作将输入特征图分别在水平方向和垂直方向上进行池化(X Avg Pool和Y Avg Pool),生成两个方向上的特征图(C×1×W和C×H×1),保留了空间位置信息。

- 然后,这两个特征图被连接(concat)后,通过卷积操作提取特征,进一步生成两个方向上的注意力权重。

- 最终,CA将这两个权重分别应用在输入特征图的水平方向和垂直方向,实现方向感知和位置敏感的注意力增强。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)