深度学习保姆级教学

本章主要介绍深度学习基础。

文章目录

前言

本章主要介绍深度学习基础

AI深度学习-卷积神经网络000

1.深度学习概论

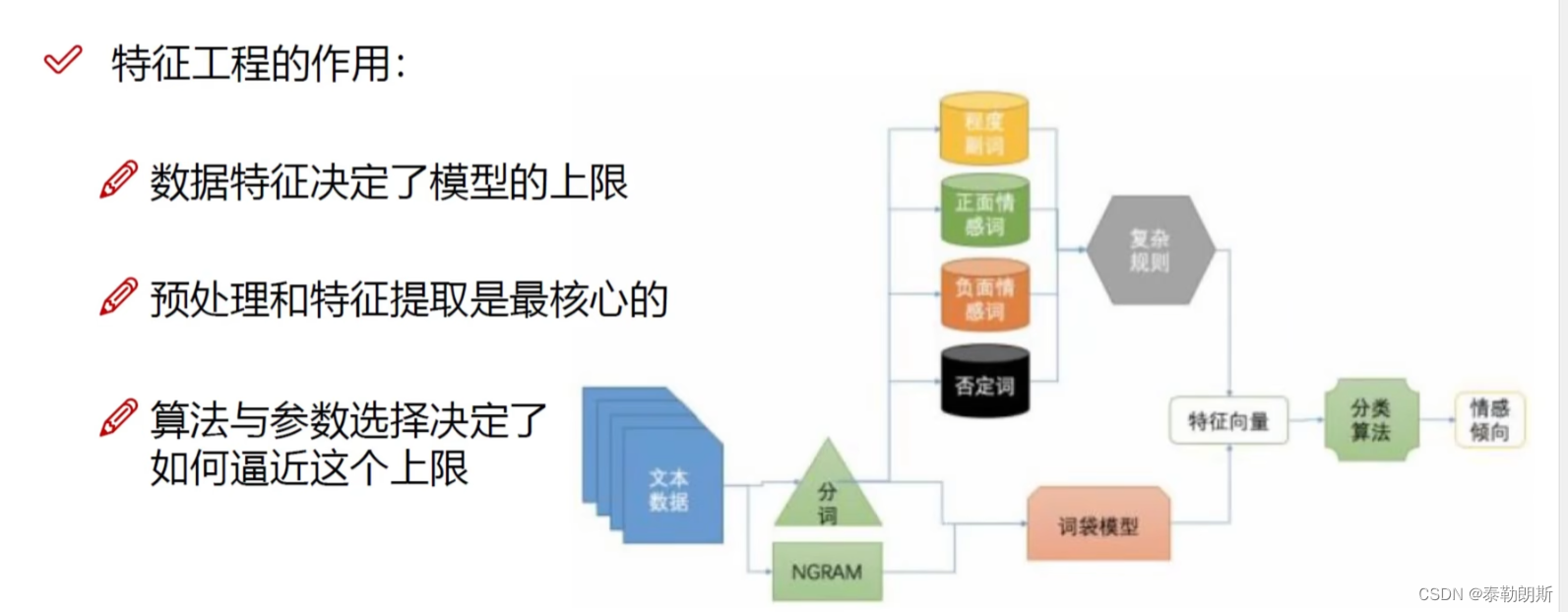

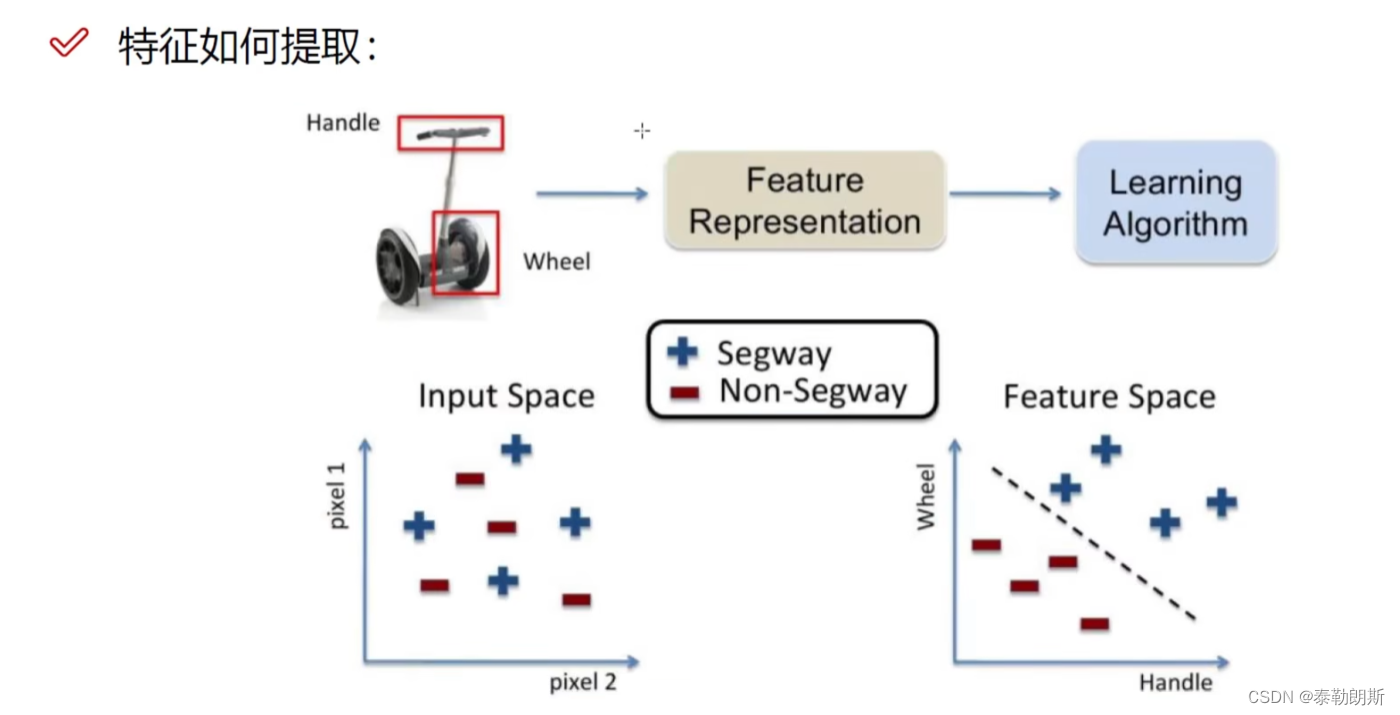

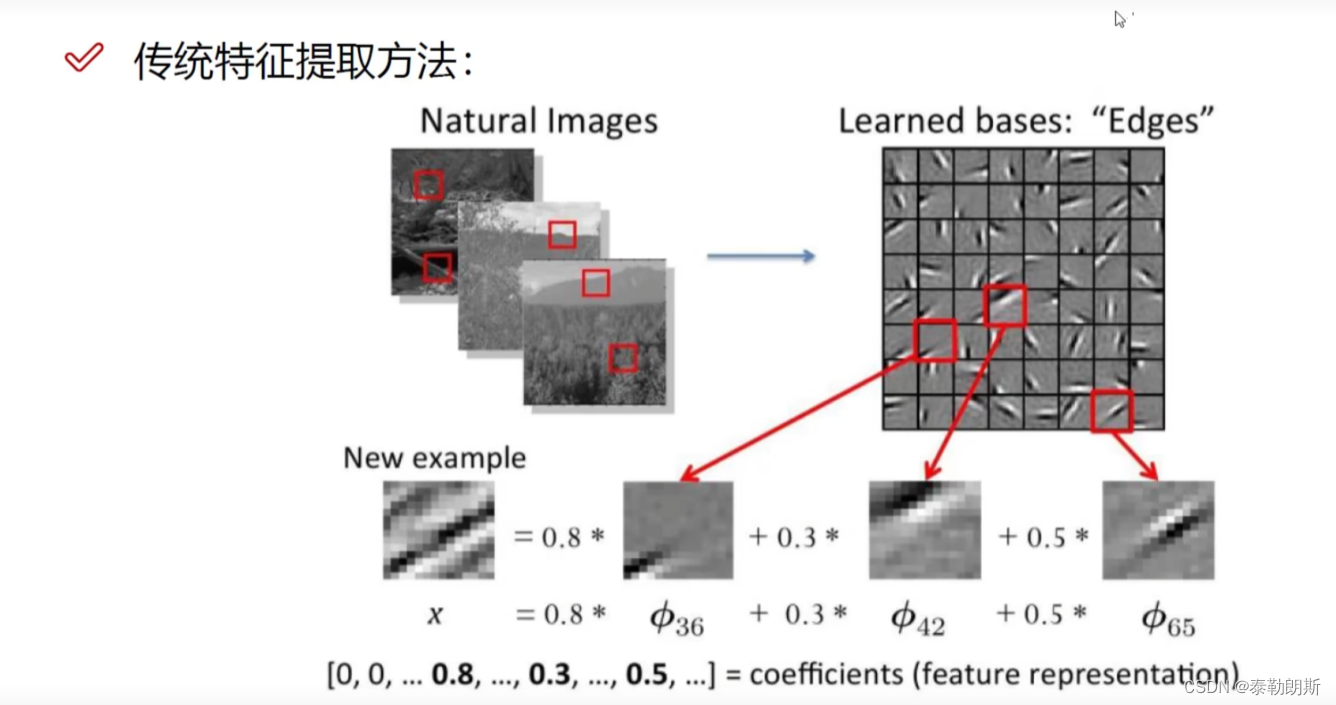

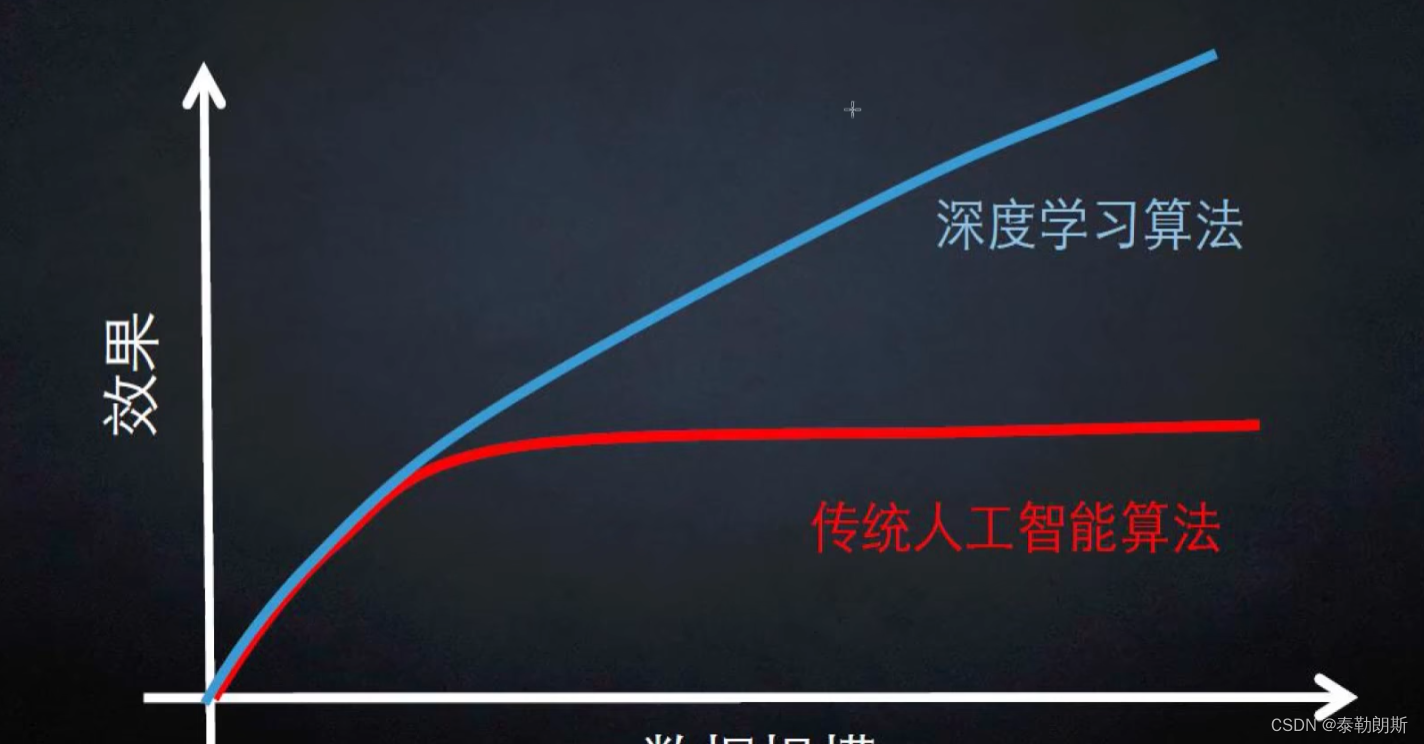

深度学习是真正能学习什么样的特征是最重要的,它解决了怎么样提取特征。

特征是非常重要的,特征的数量级决定了结果。

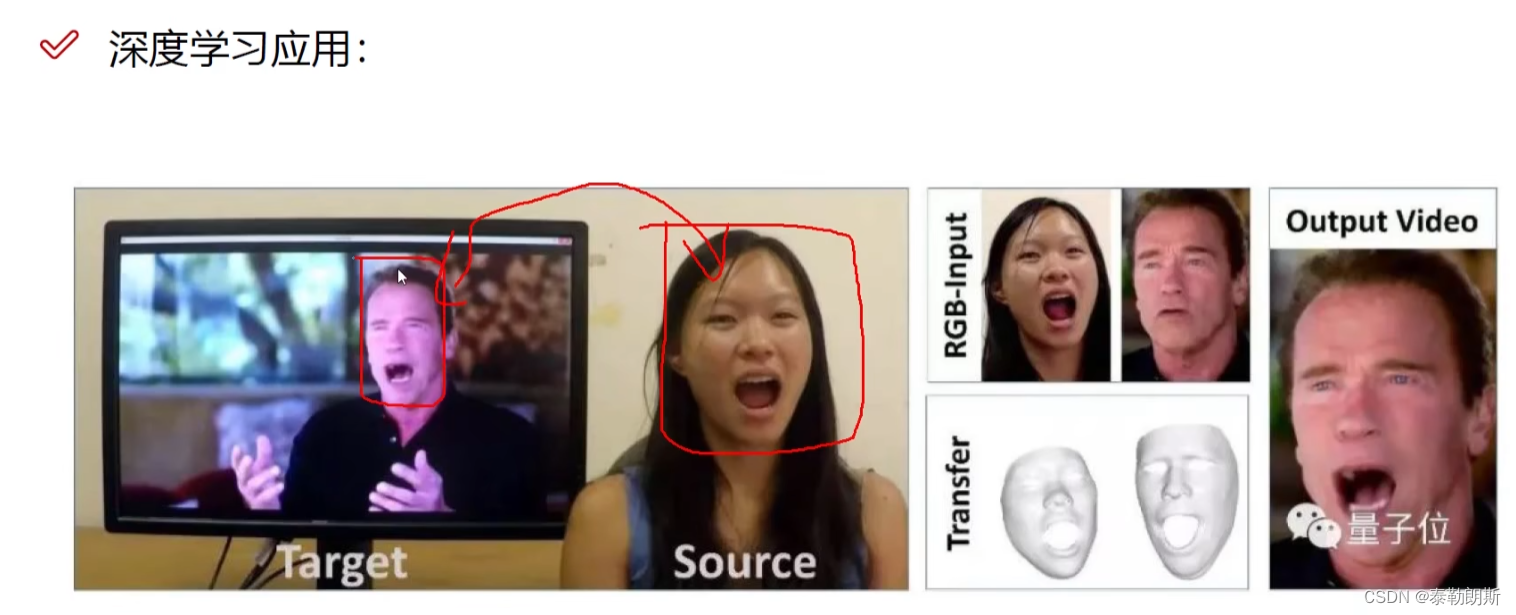

换脸对于神经网络很简单

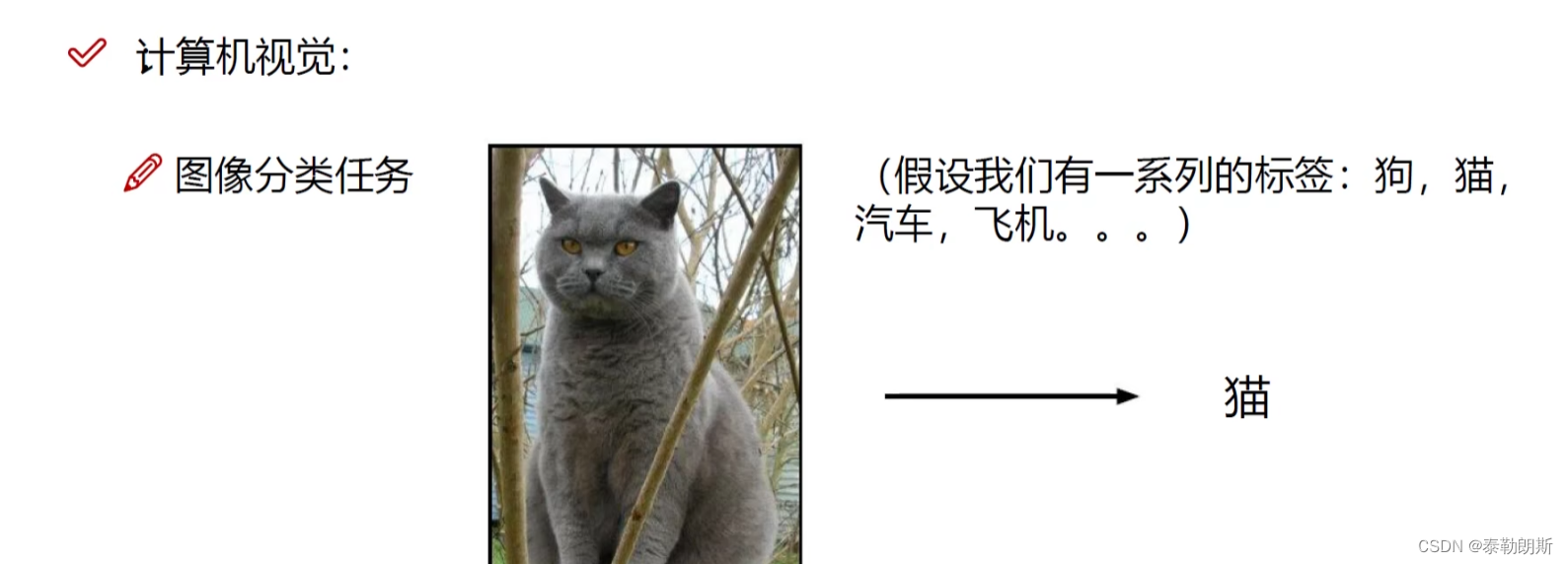

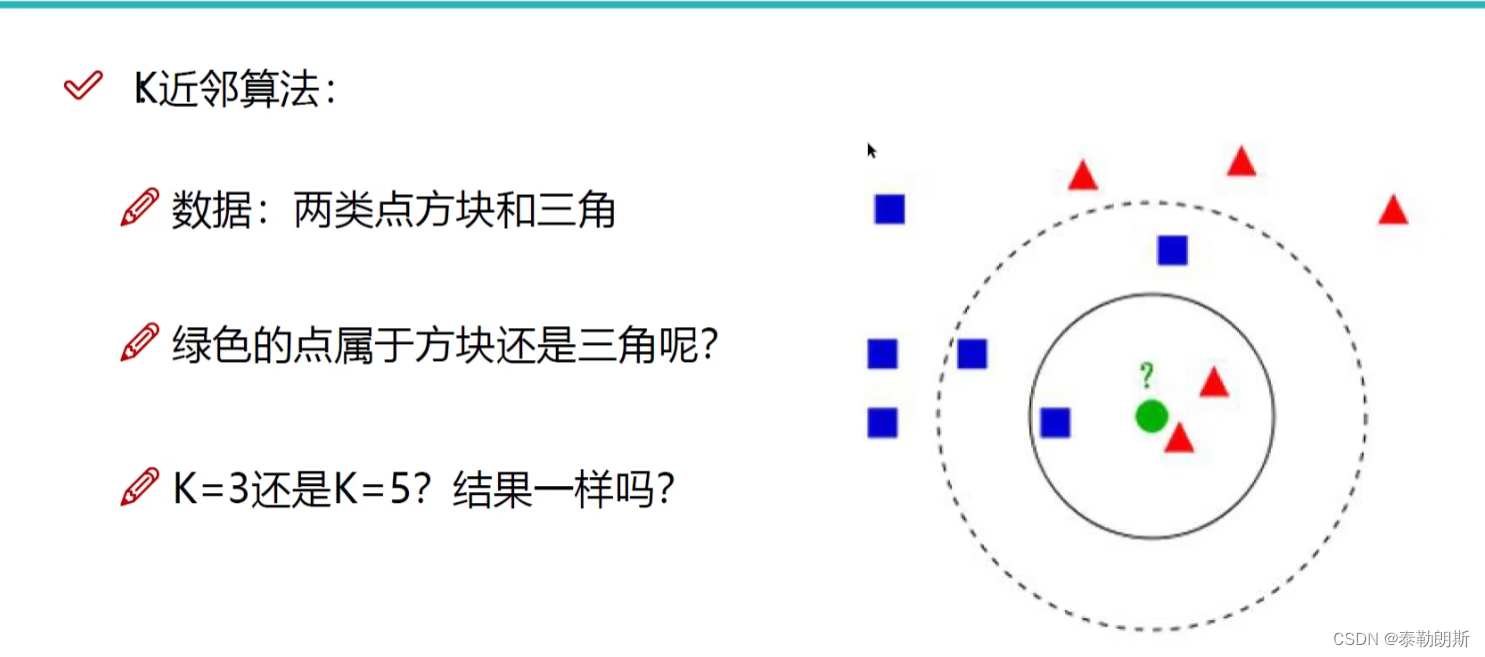

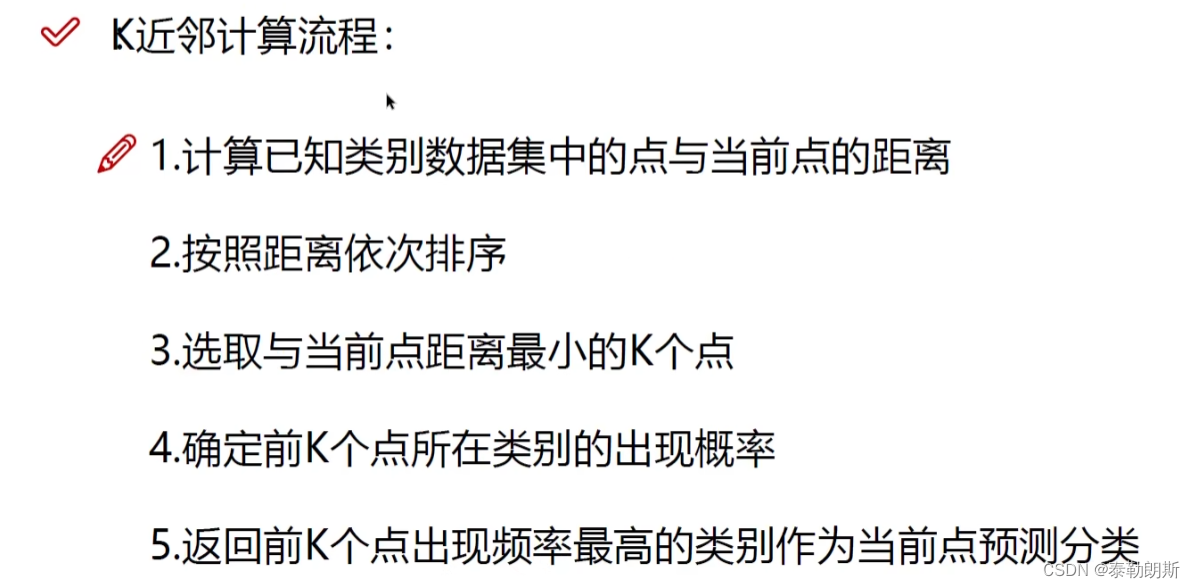

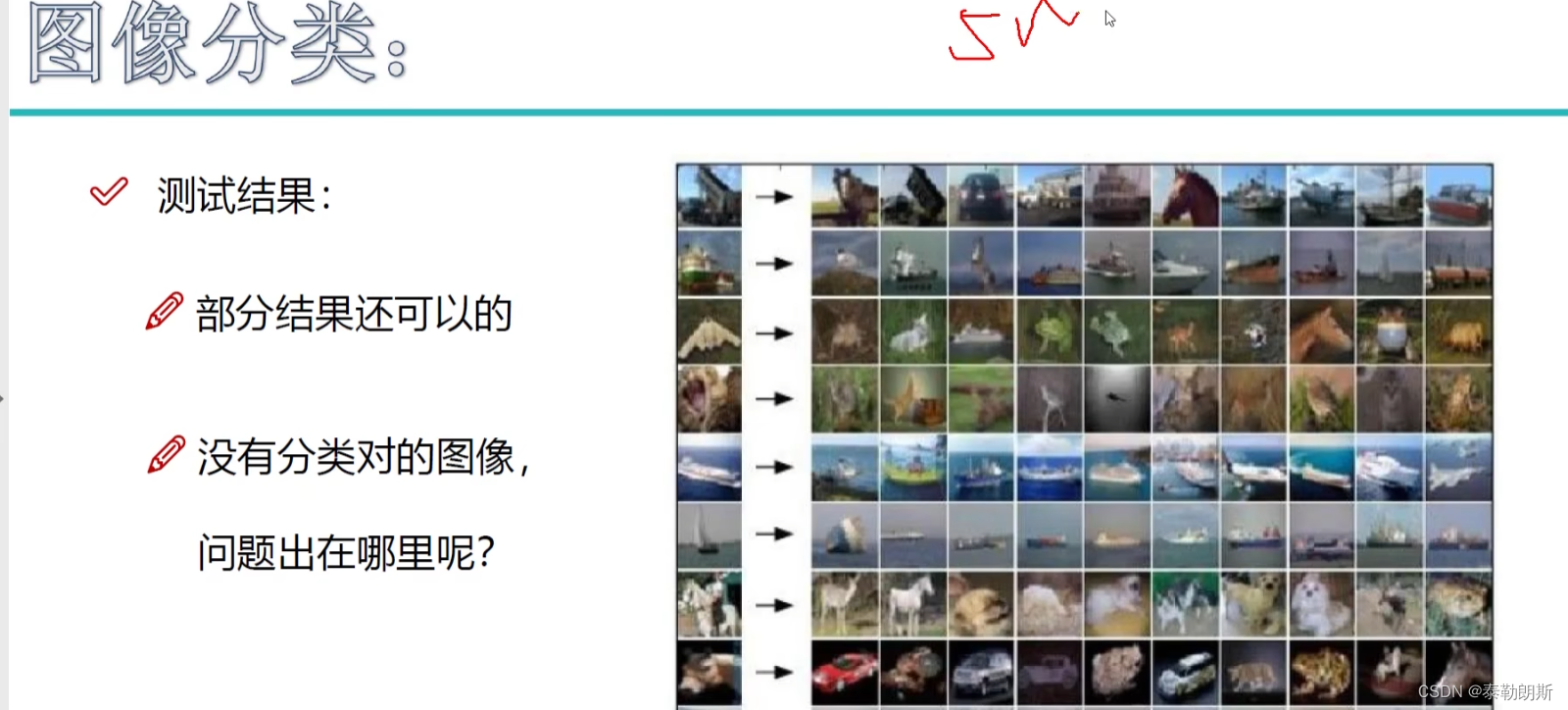

识别绿色圆圈属于什么类别。

它周围什么多,就属于什么。

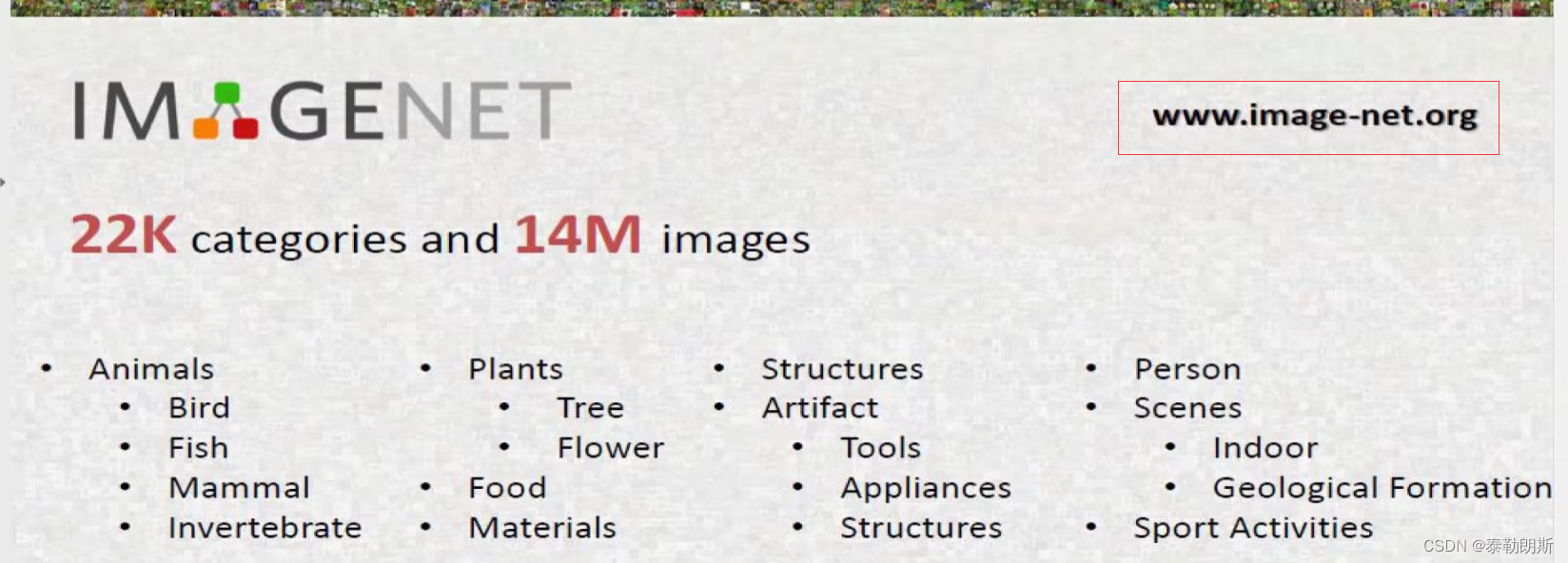

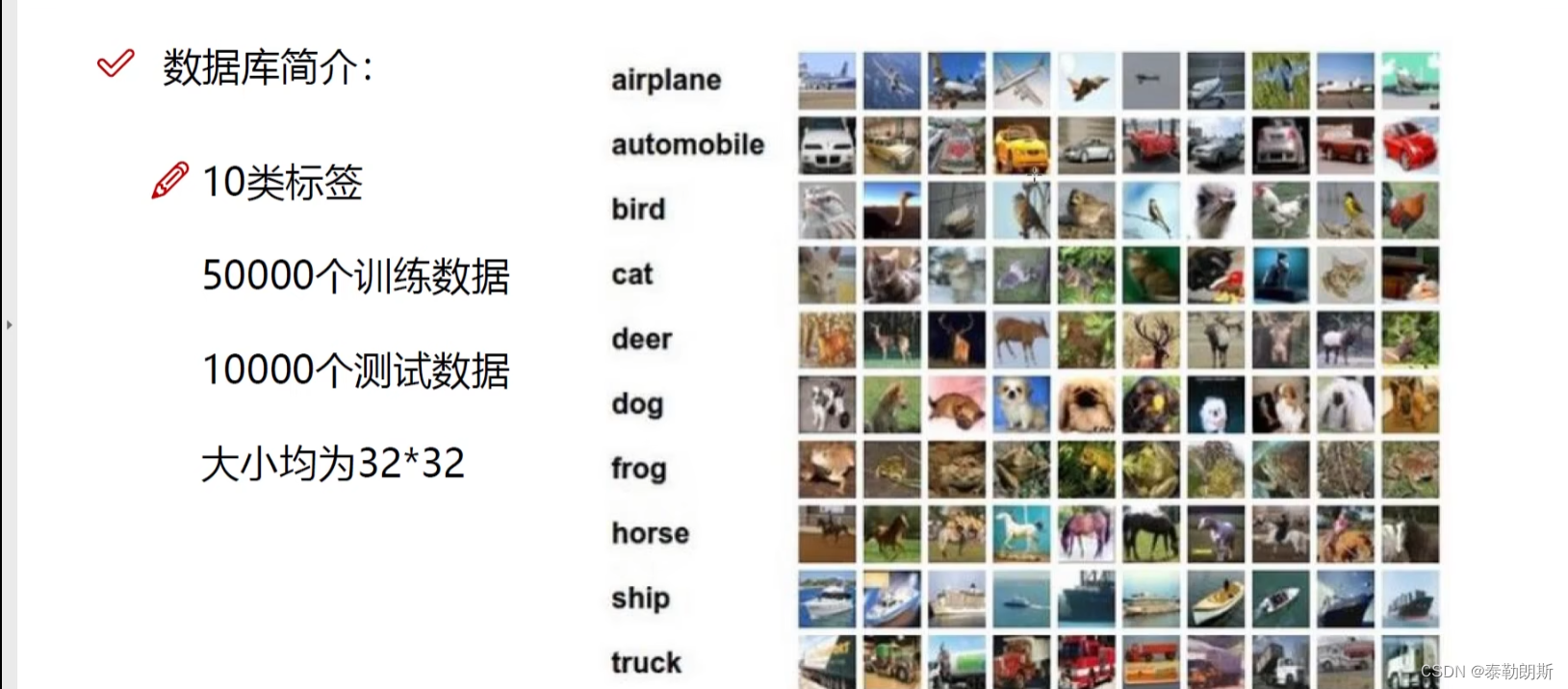

CIFAR-10数据集

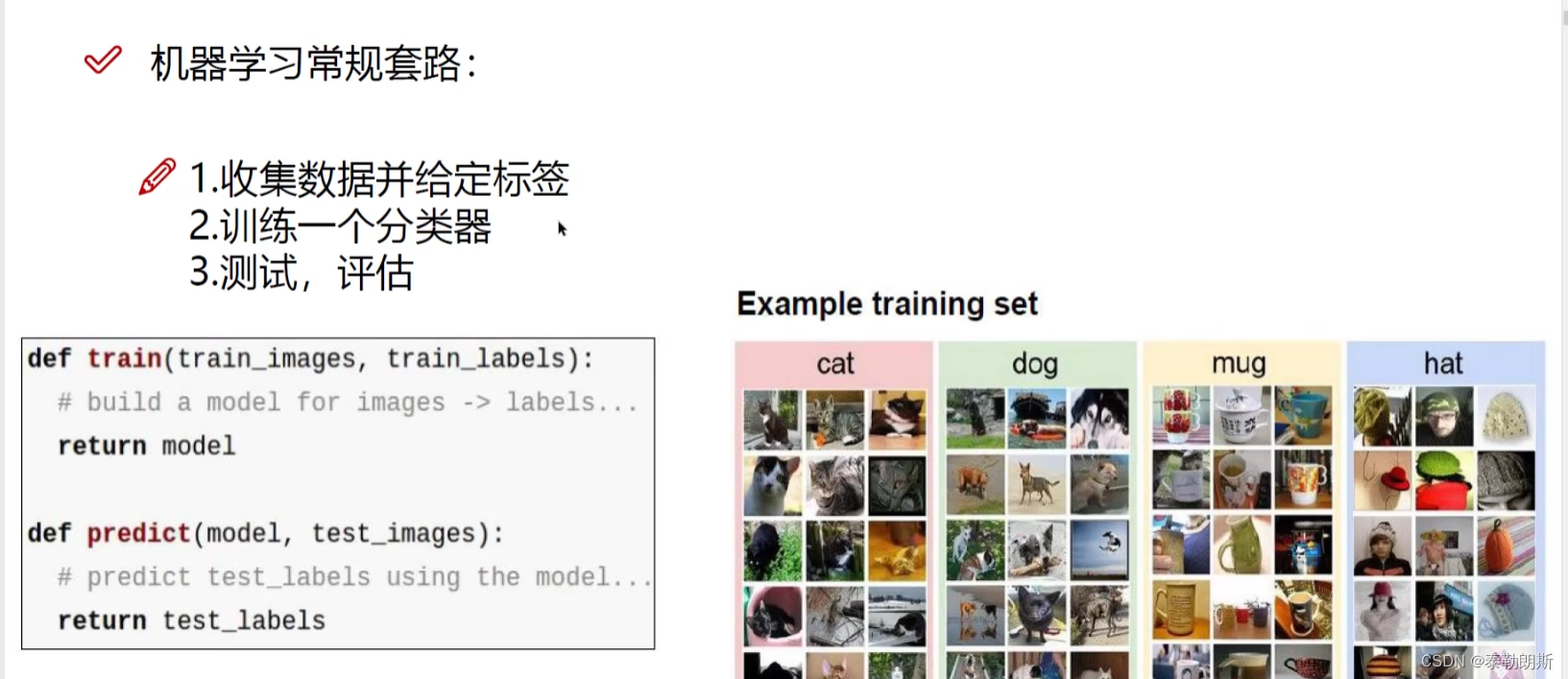

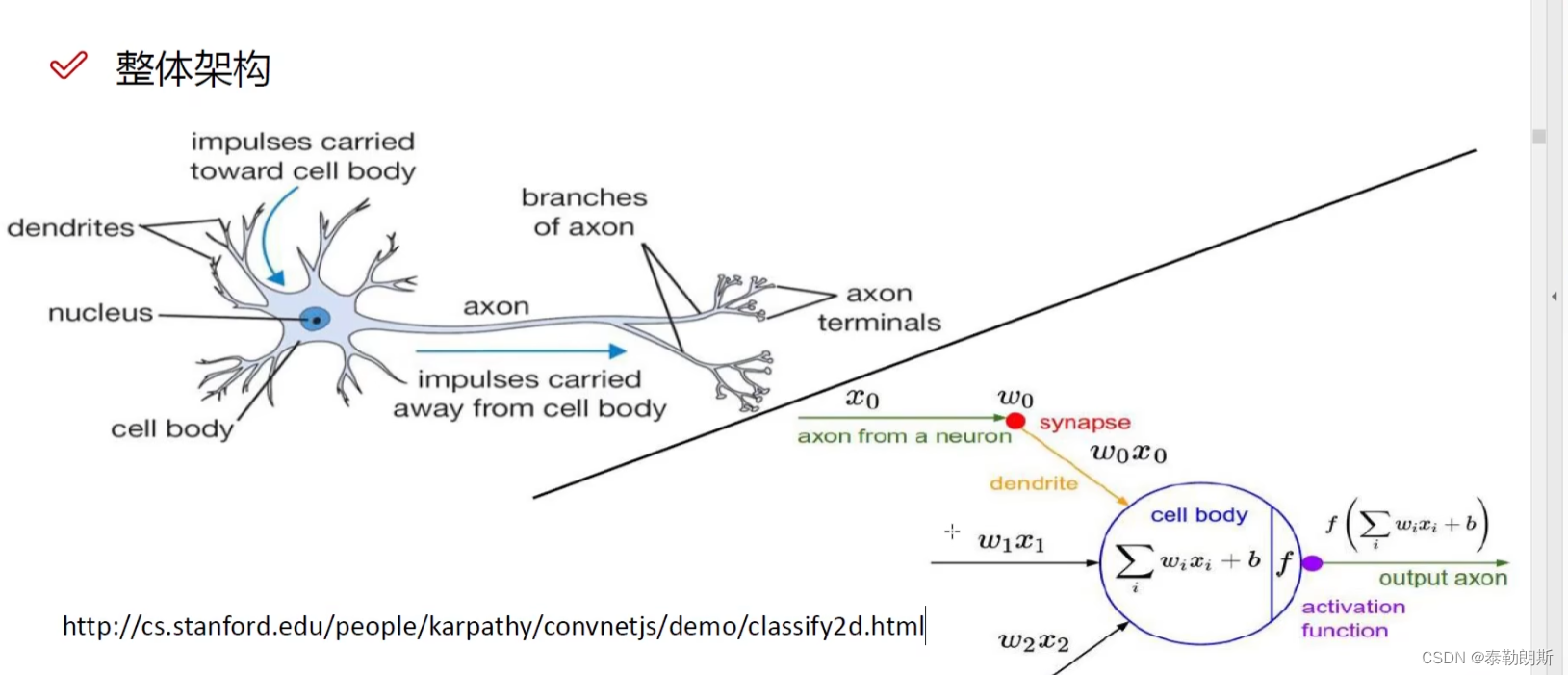

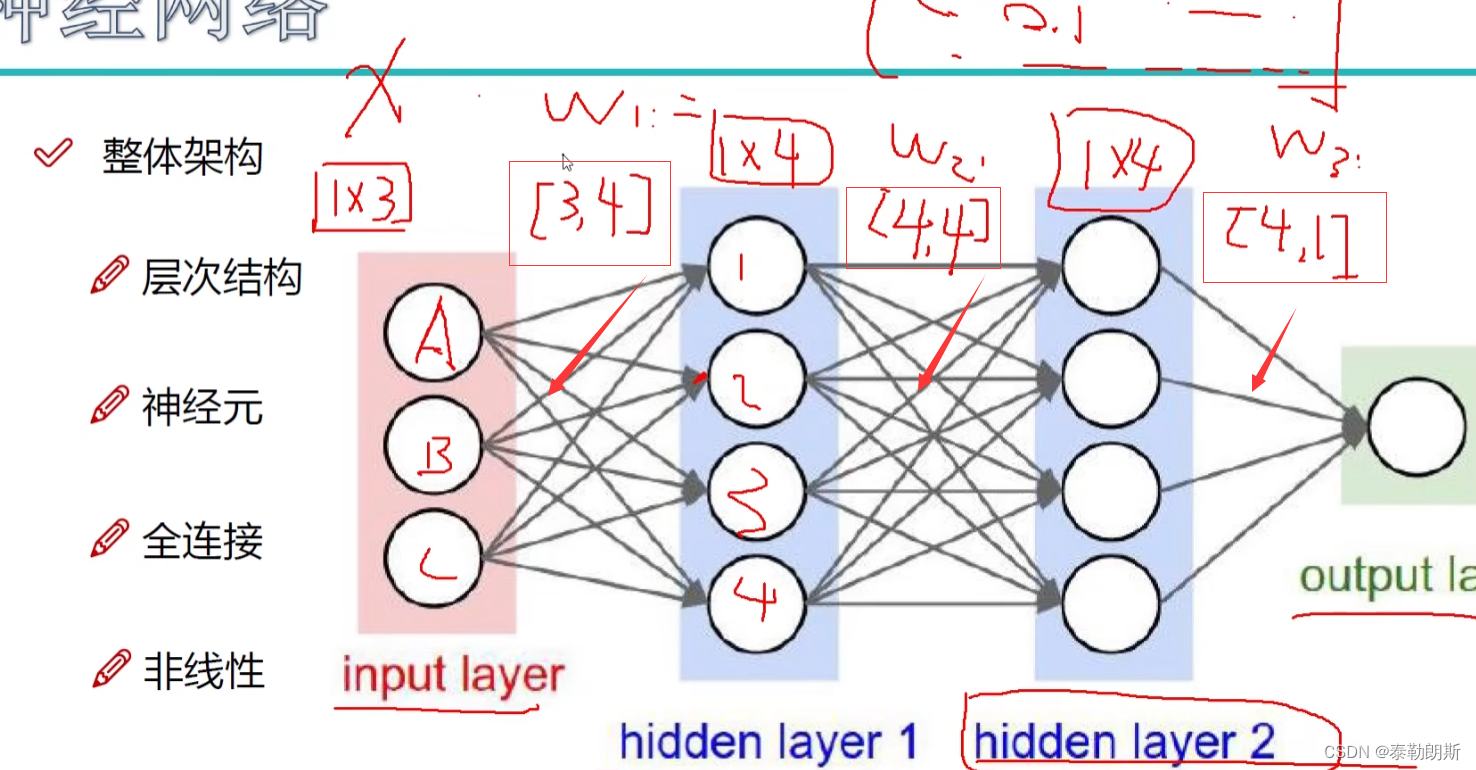

2.神经网络

1.基础原理

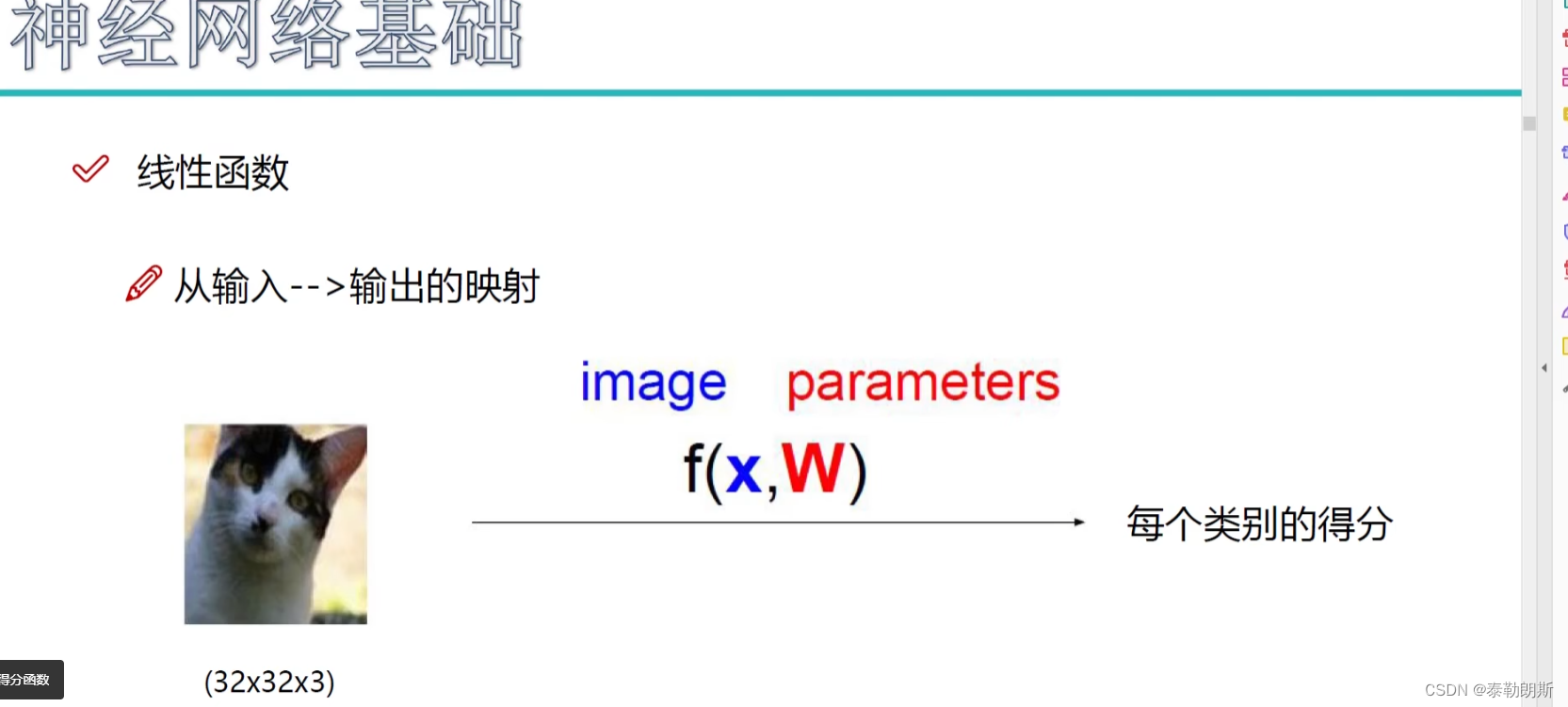

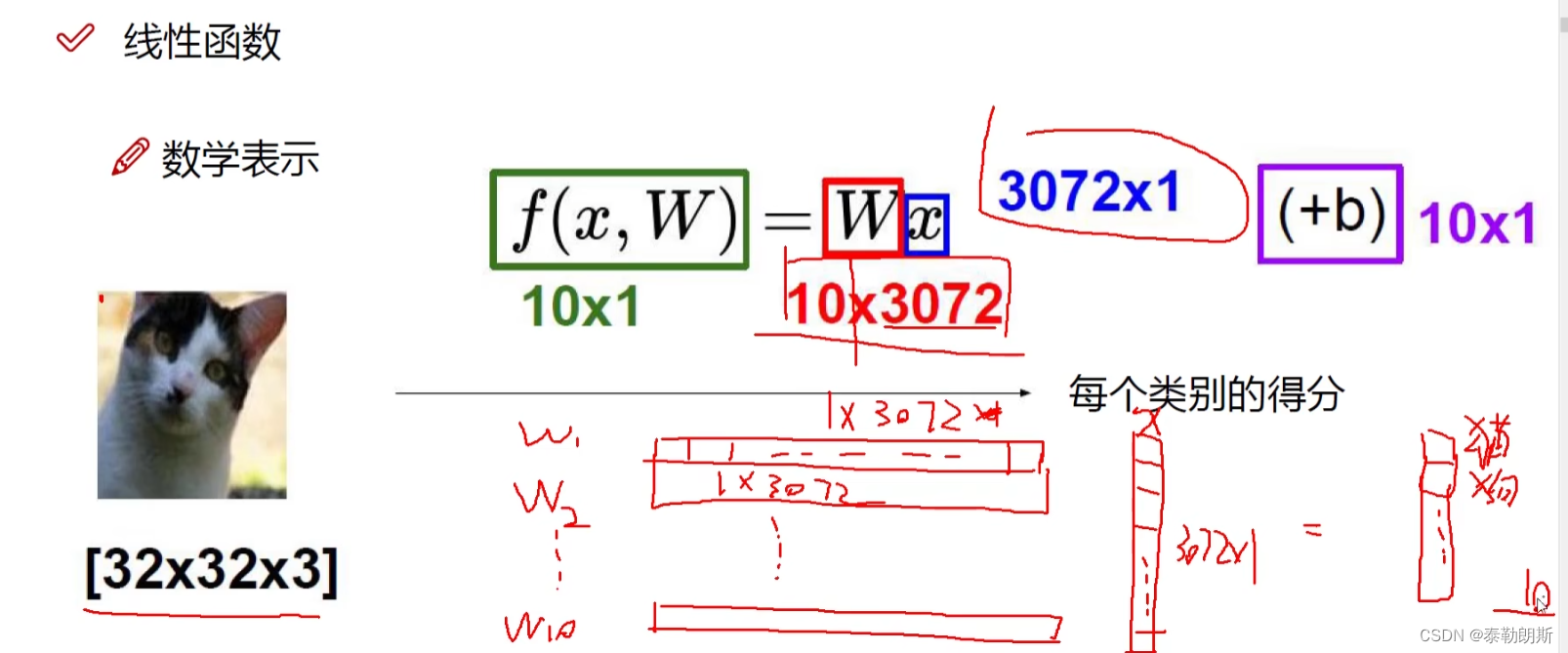

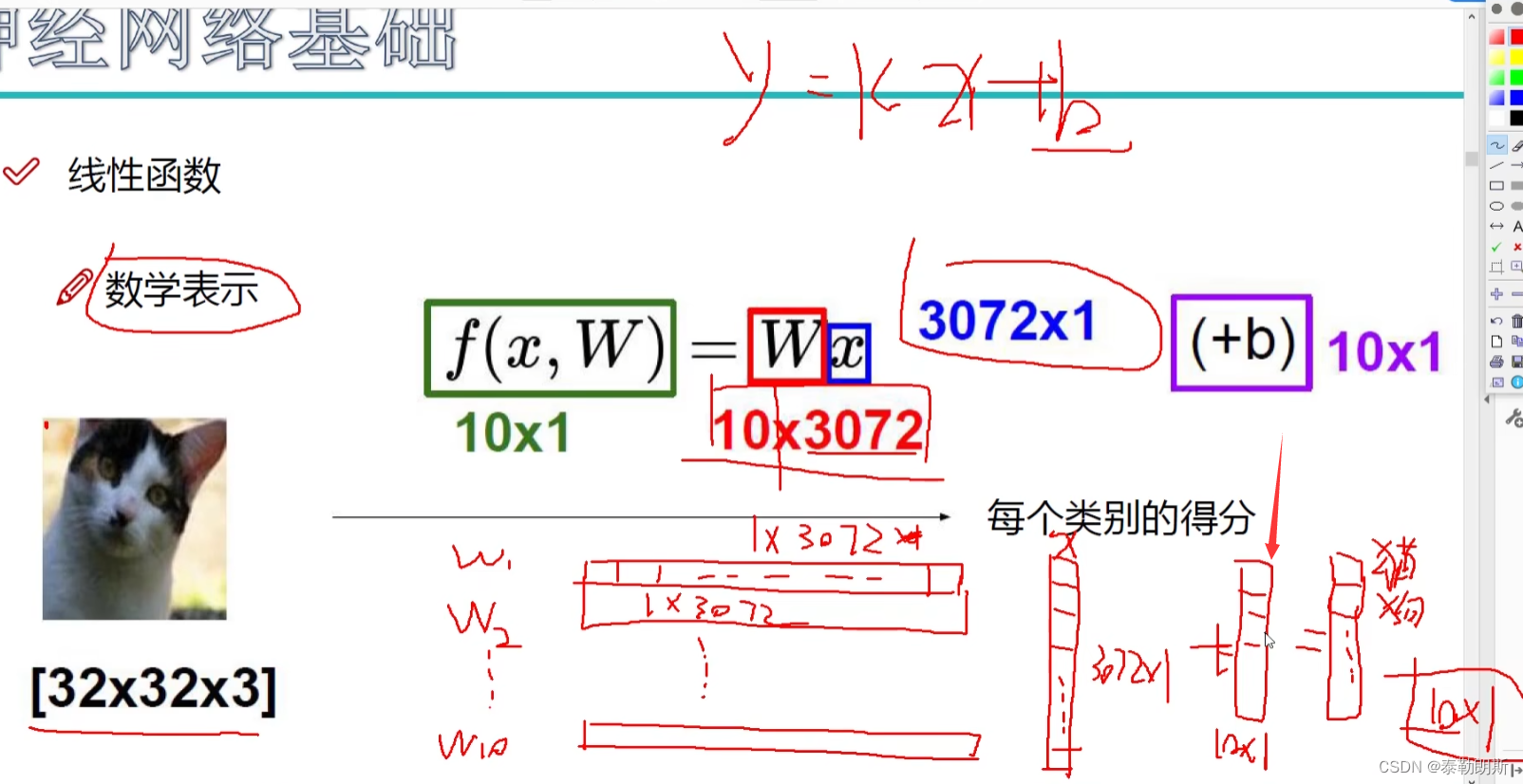

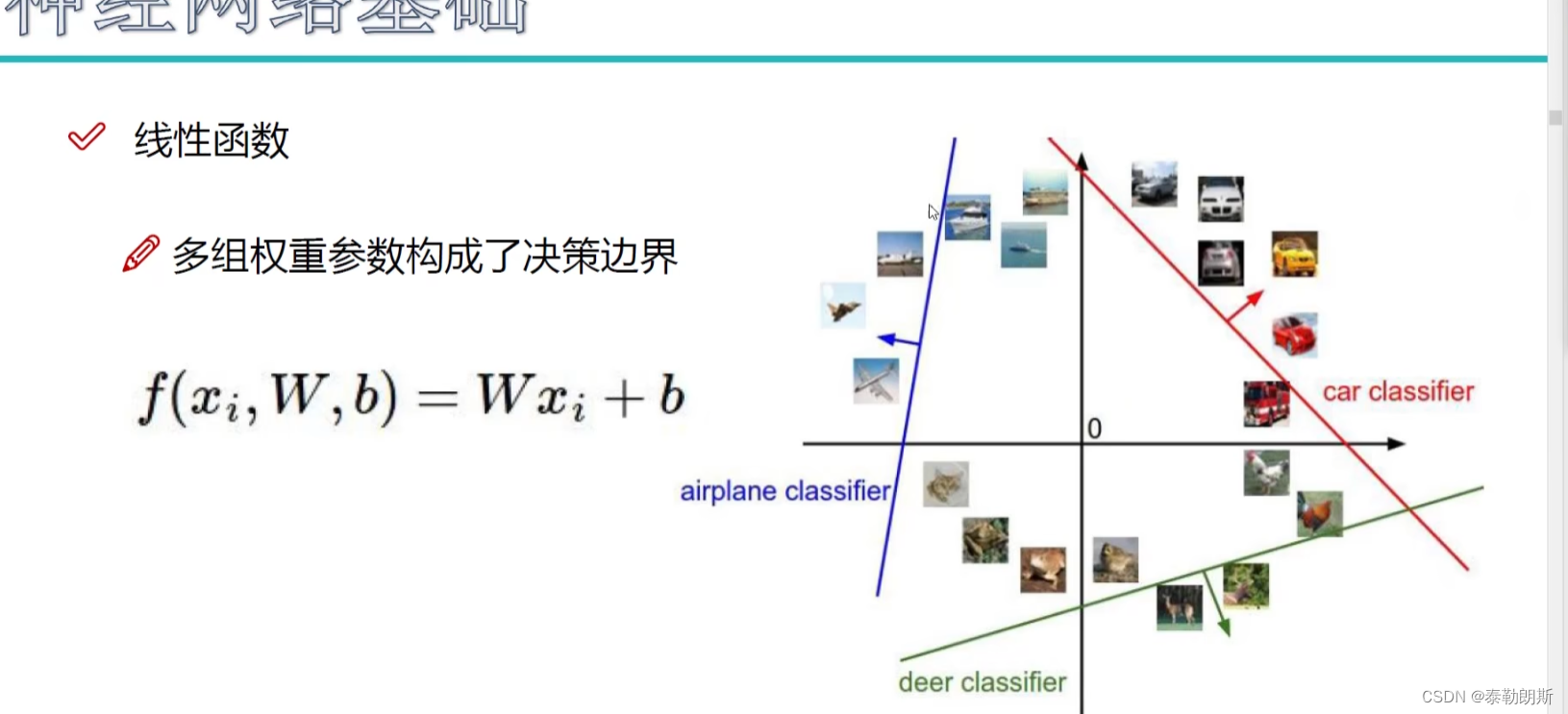

f(x,W),其中x是像素点

<img src="https://img-blog.csdnimg.cn/f8f92629c526460c8fc40c3f0588822e.png width=700>

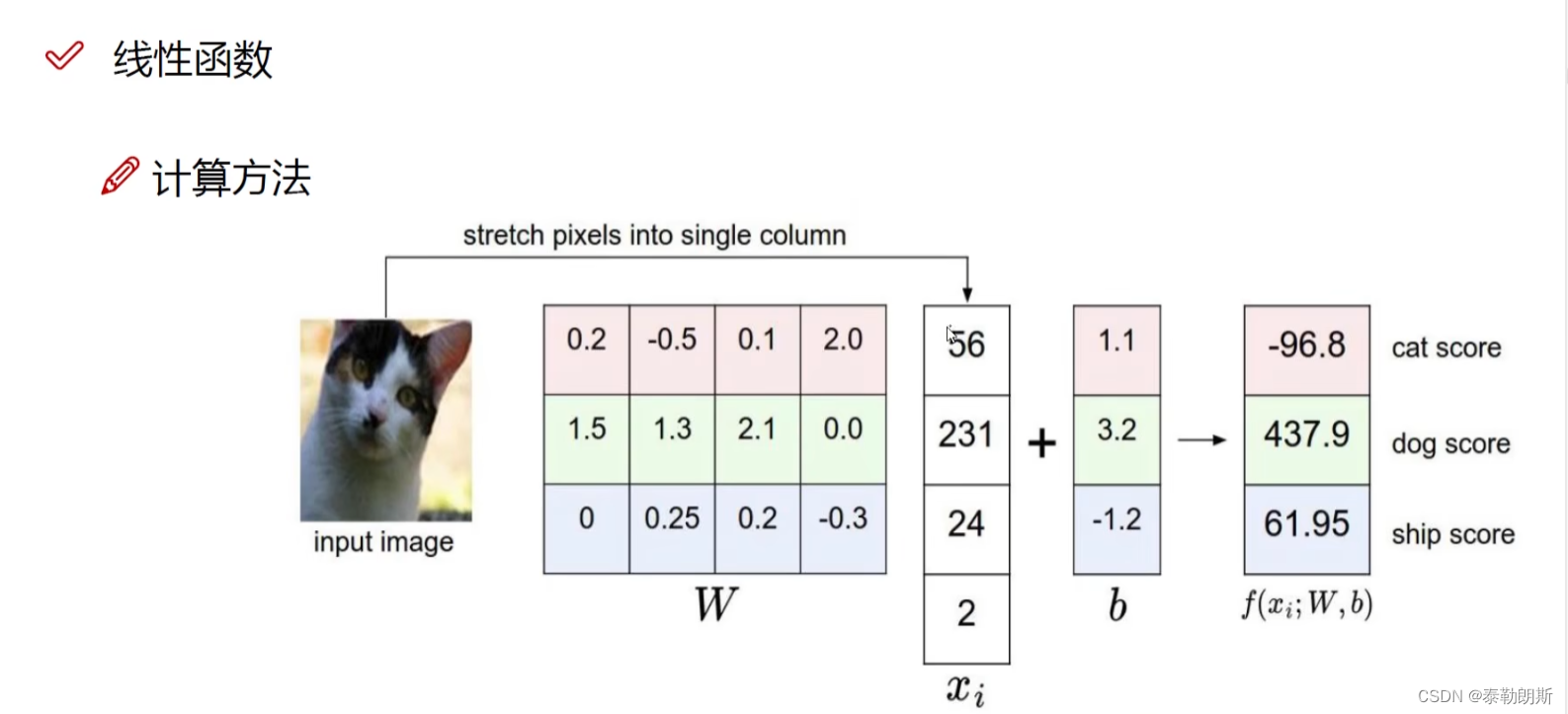

W是权重,X是像素,每个像素有一个权重,因为不同像素对结果影响不一样,一个类别一类权重。

还要加上一个偏置,每个类别

下图是三个类别,四个像素点,w正值代表促进,负值代表抑制作用。

W矩阵最开始是随机值,迭代过程中不断改进这些参数,最后

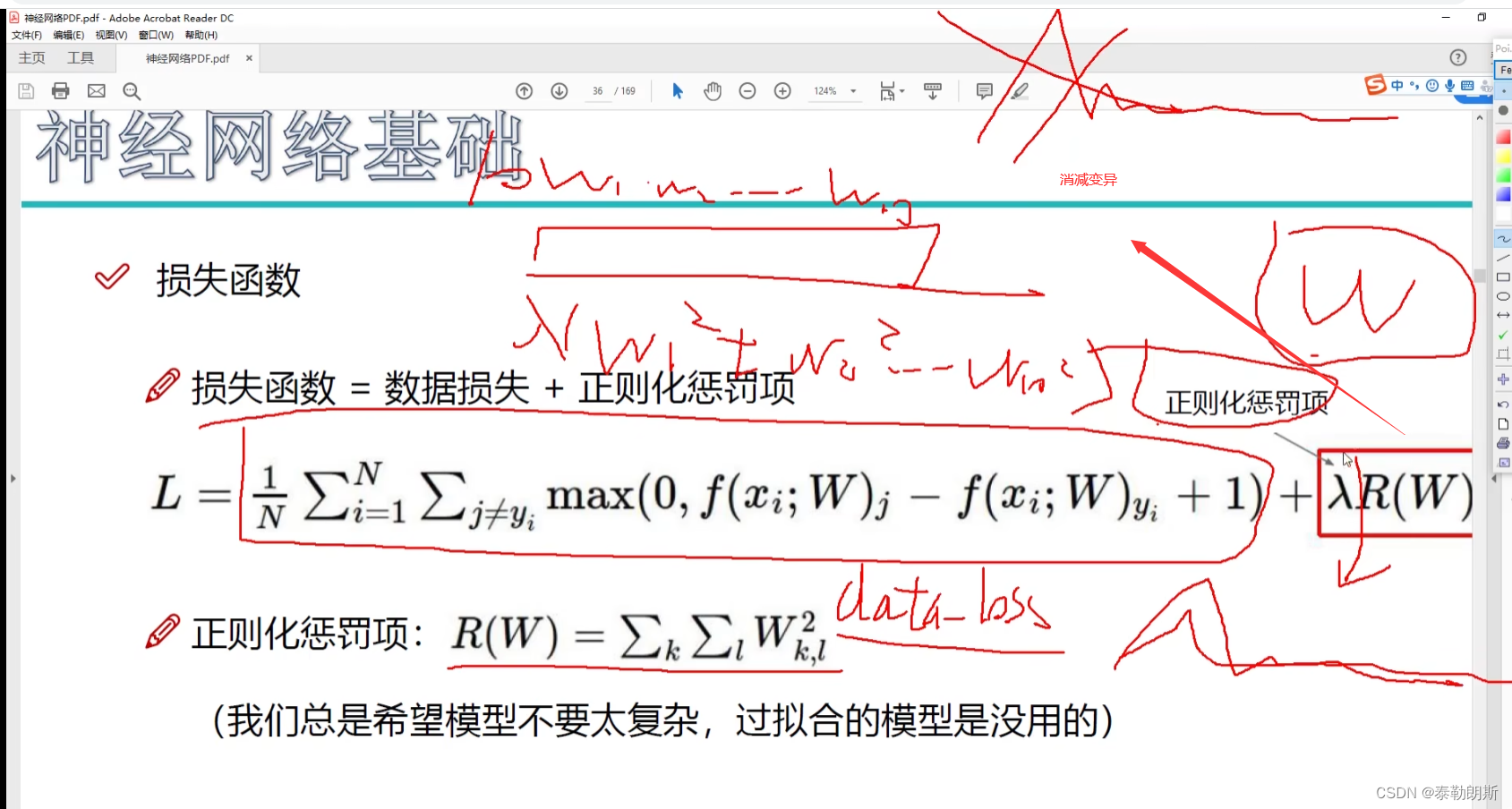

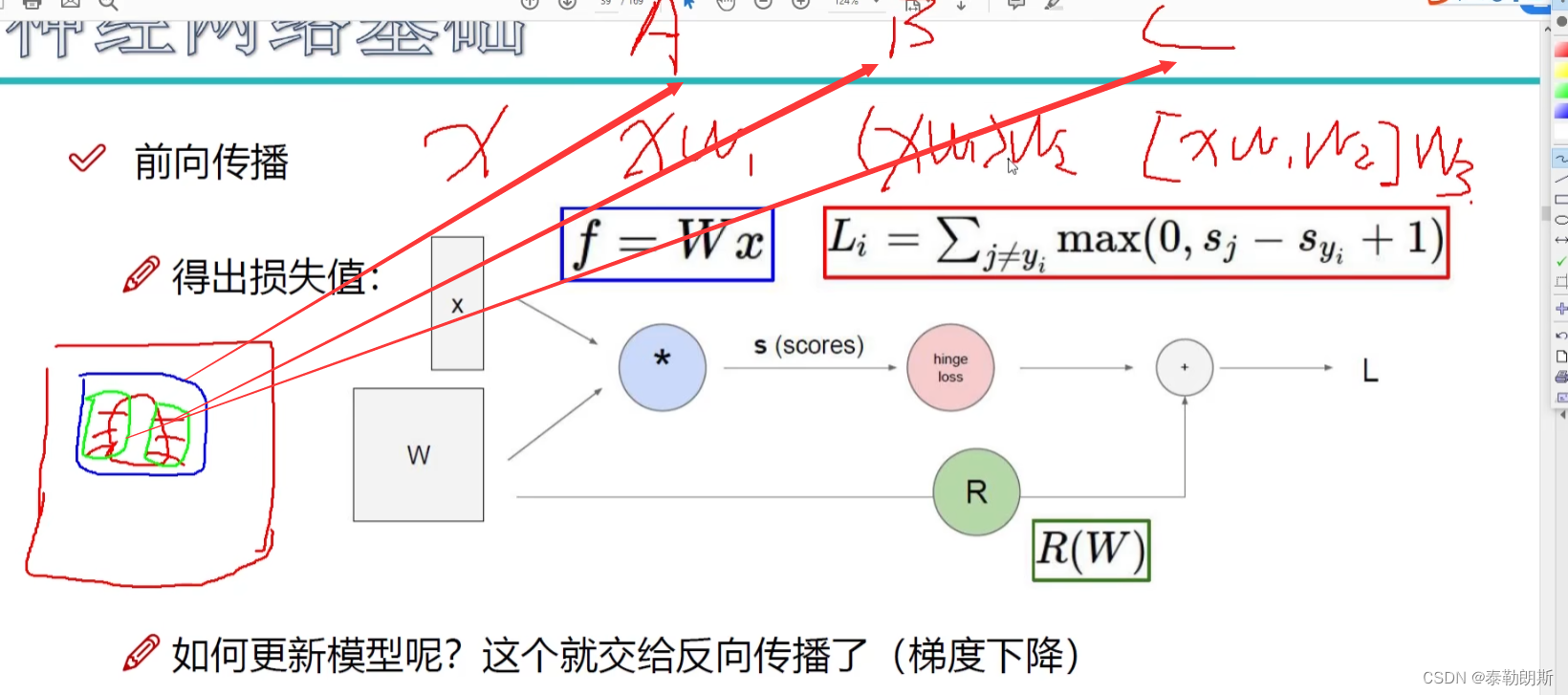

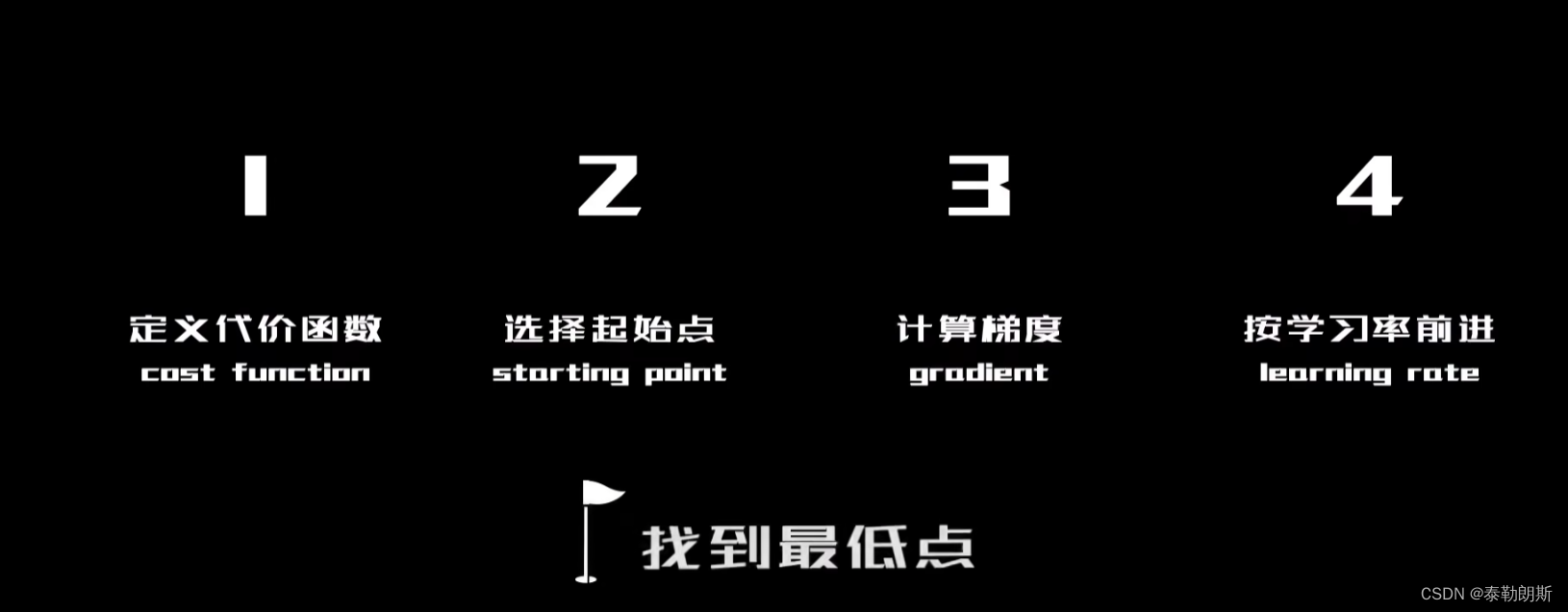

2.损失函数

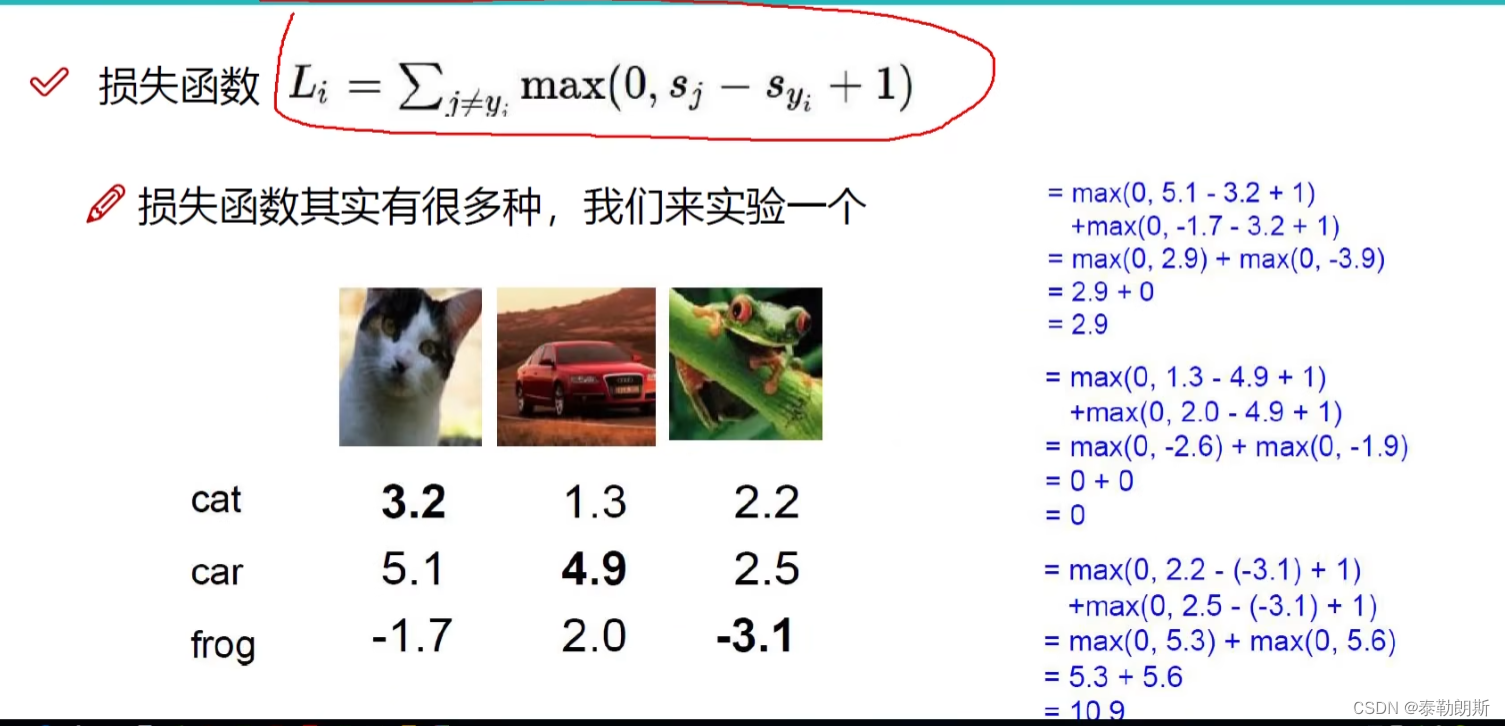

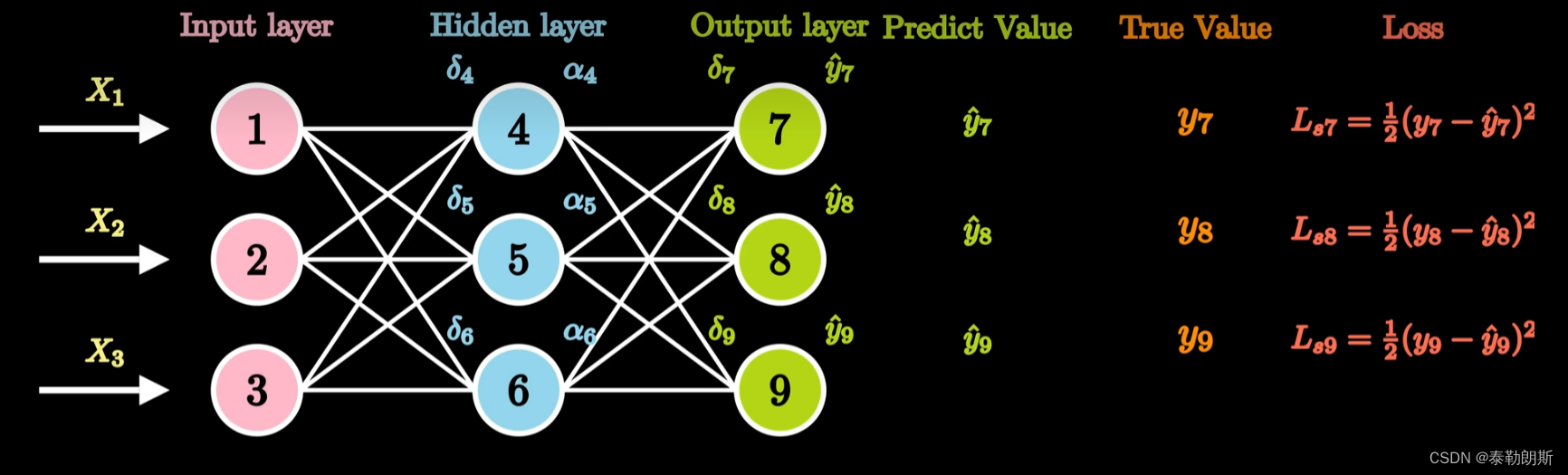

损失函数用来衡量当前你的权重矩阵的好坏,如果损失函数值越大,代表权重矩阵不好,越小,代表好。

图片下面的数字是得分。

Sj-Sy=其它类别减去正确类别,+1 代表加了一个偏置,正确类别至少比错误类别高1以上,才是没有损失的。

损失函数为0的时候,代表没有损失。

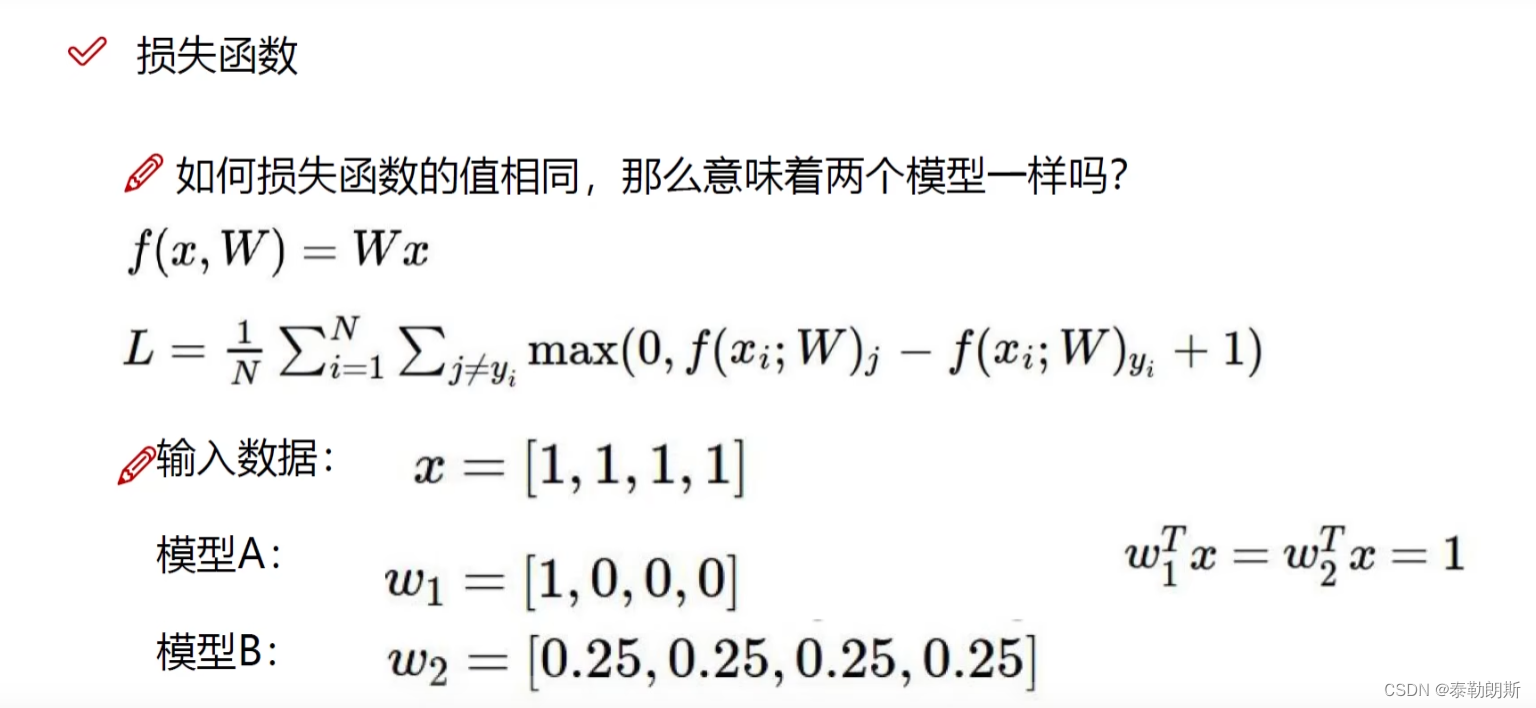

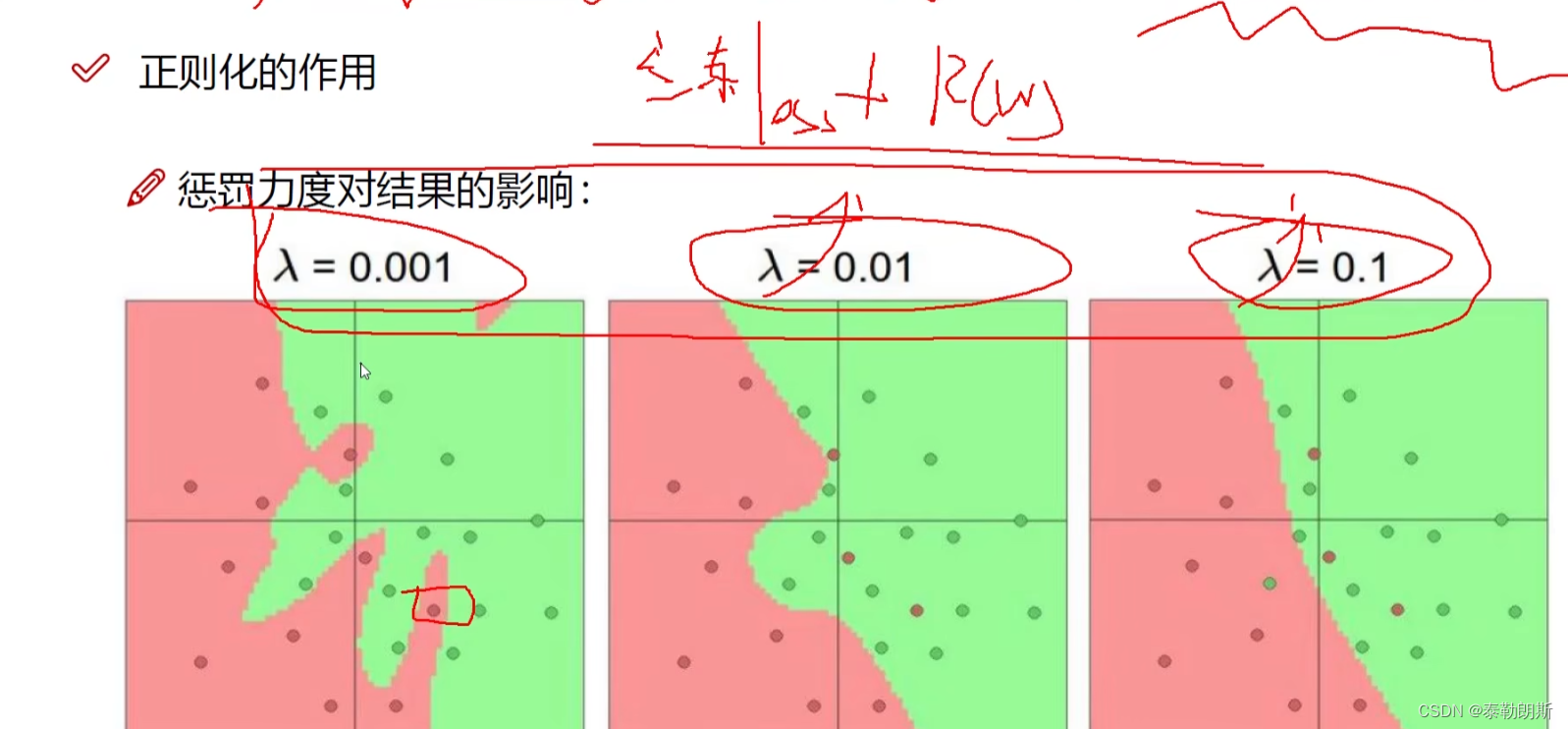

权重参数会不会产生过拟合。

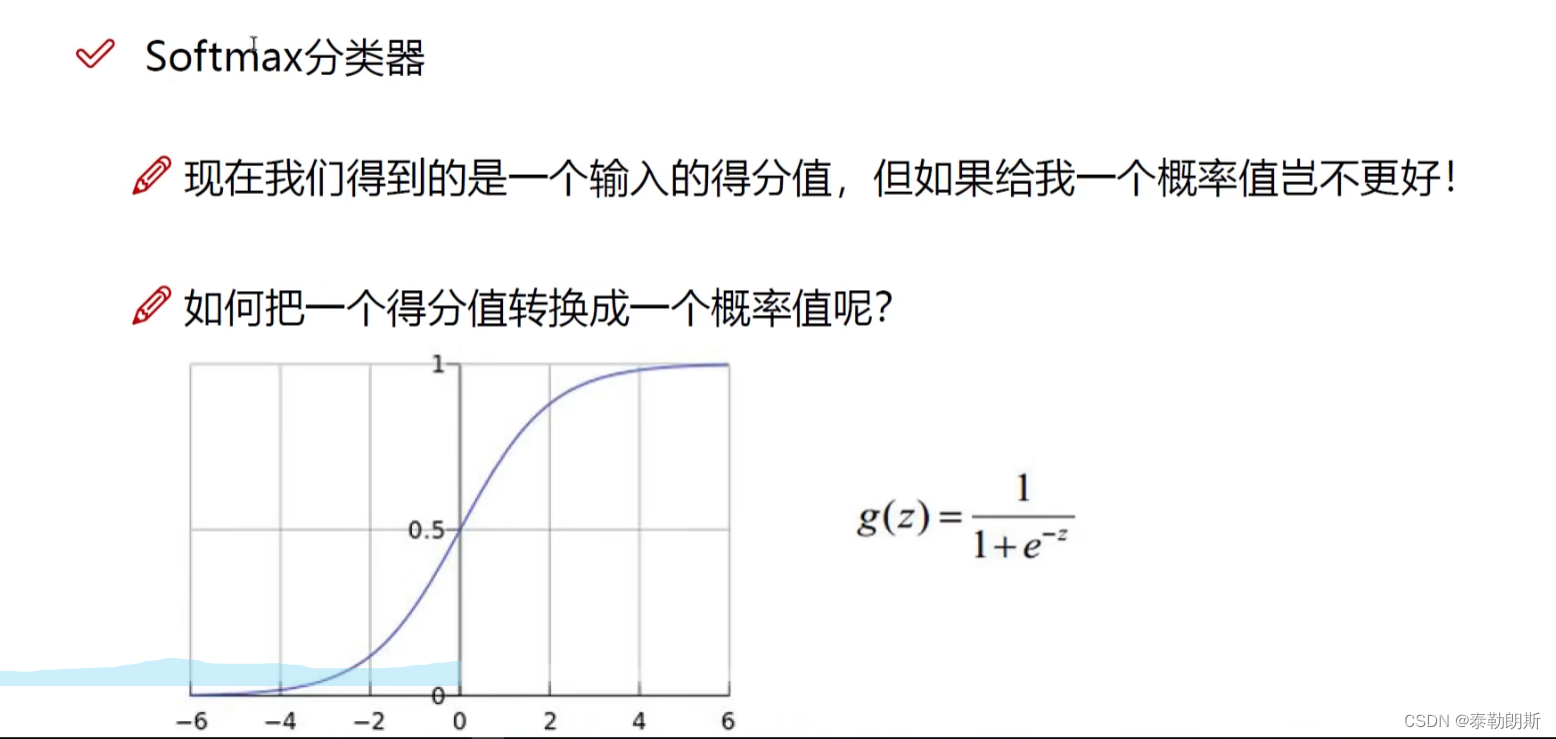

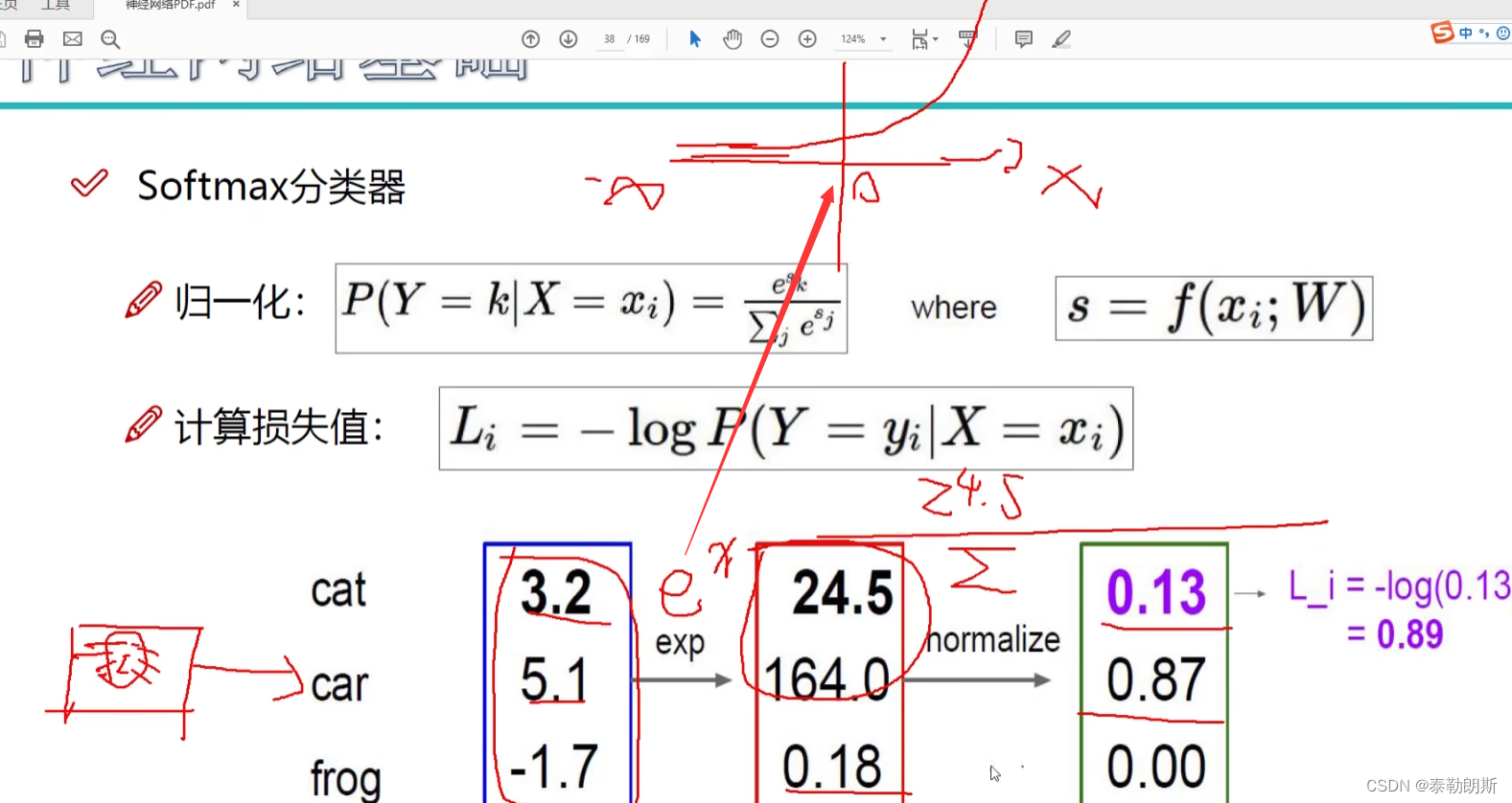

3.SoftMax

把得分转换成一个概率值,把所有值都压缩到0-1

如何理解这个公式?

为什么要使用log,数字越接近1,损失越小,其余越来越大

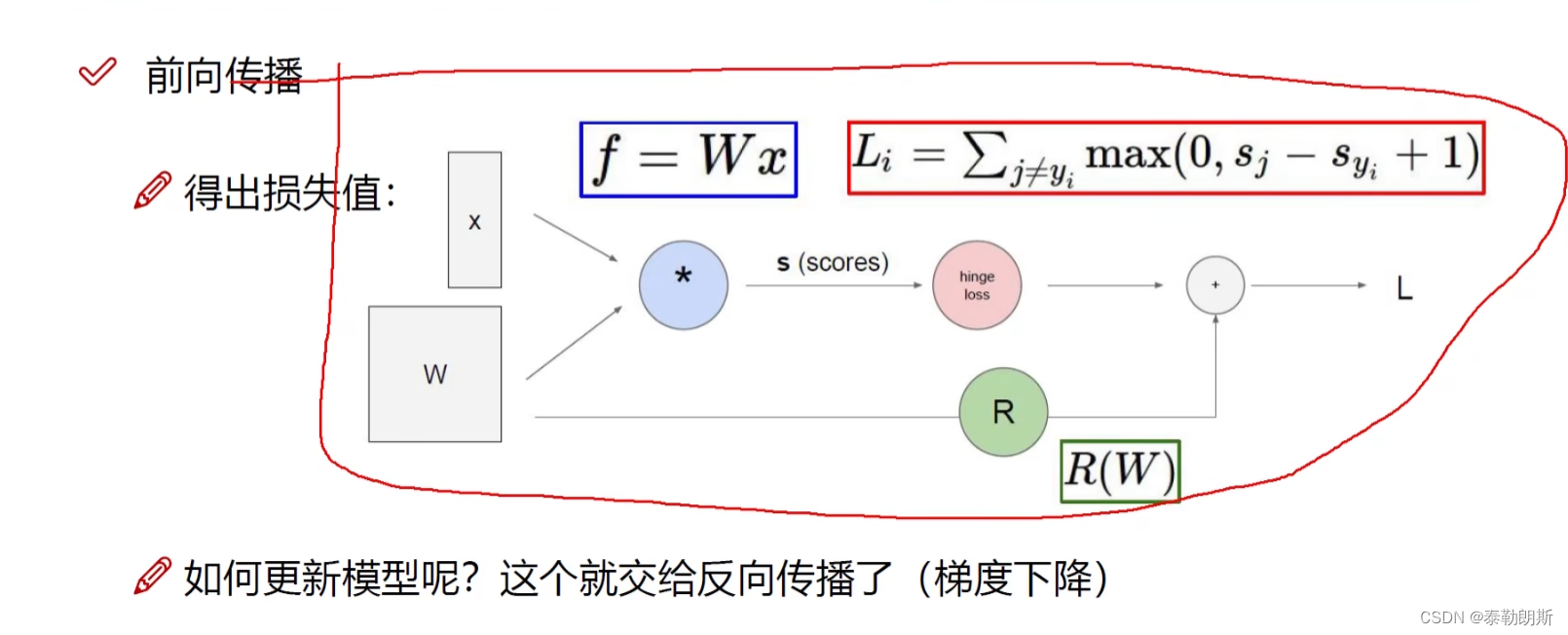

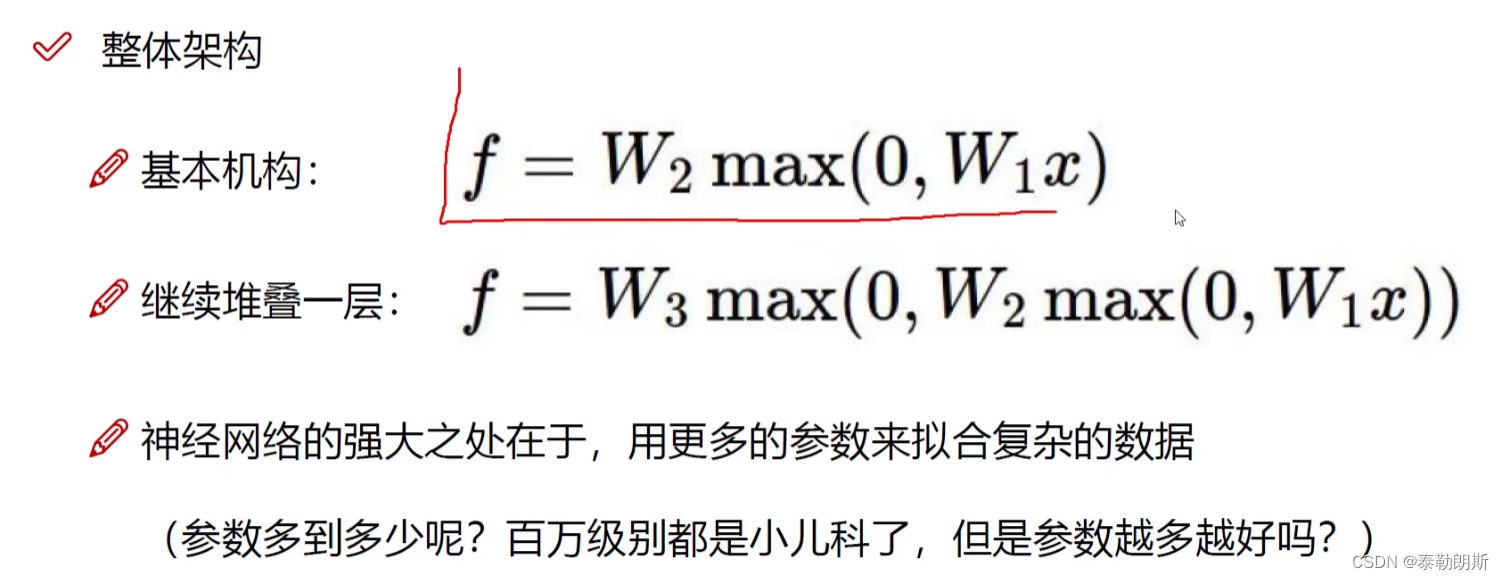

4.前向传播

回归任务(预测一个得分,计算损失)

多次变换,增加了多层,每一层关注不同的点

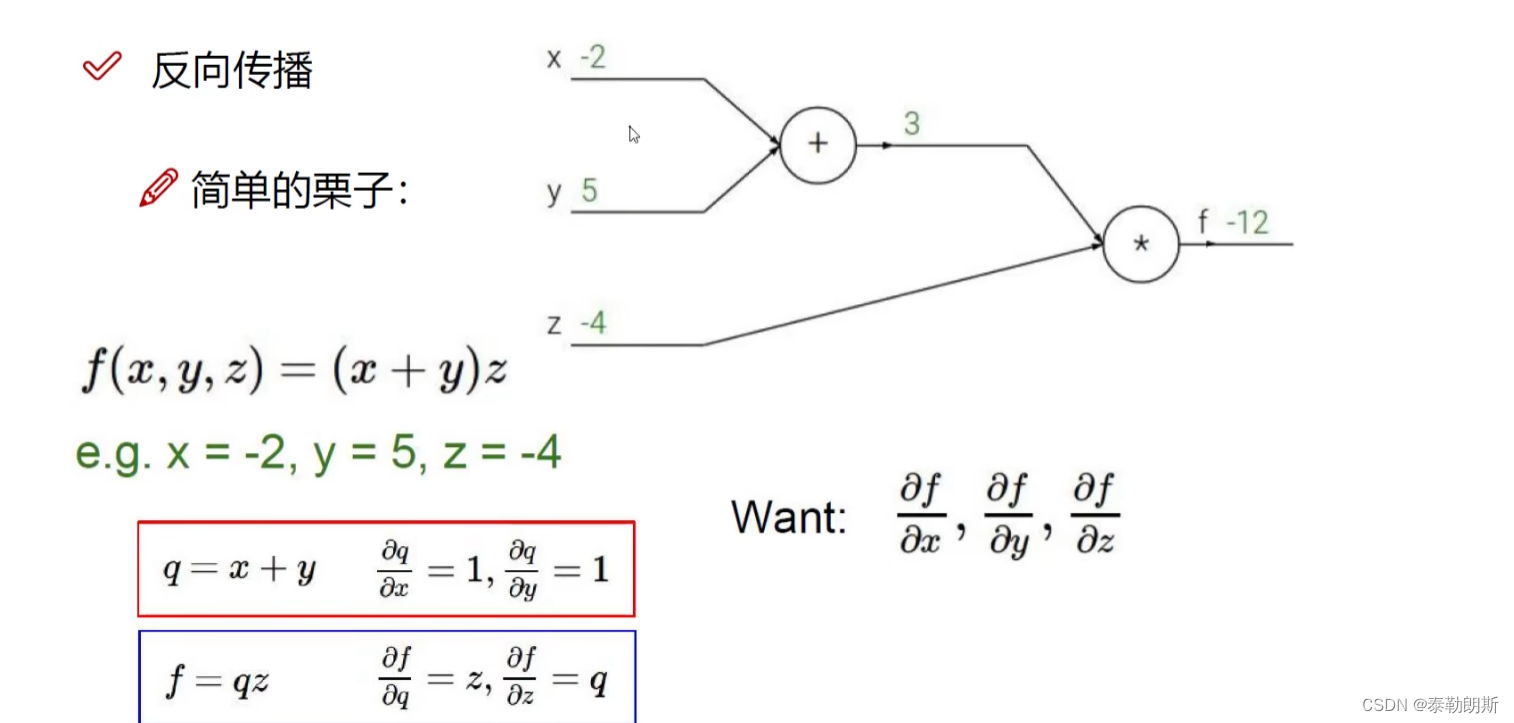

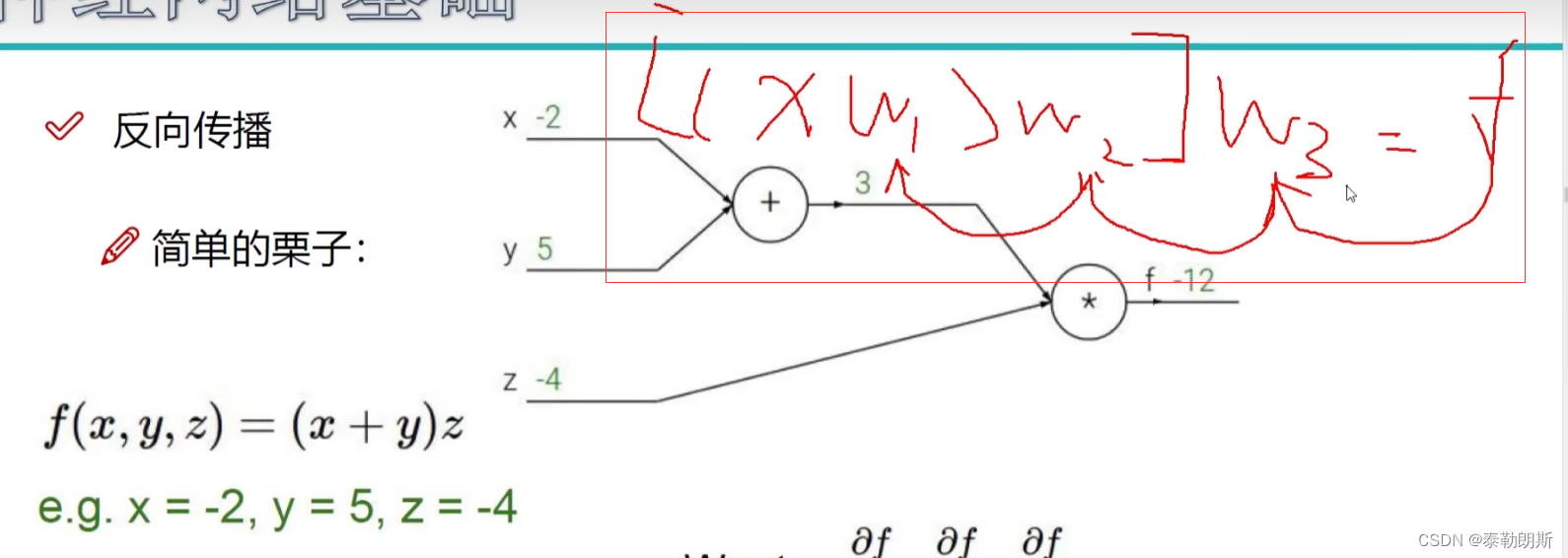

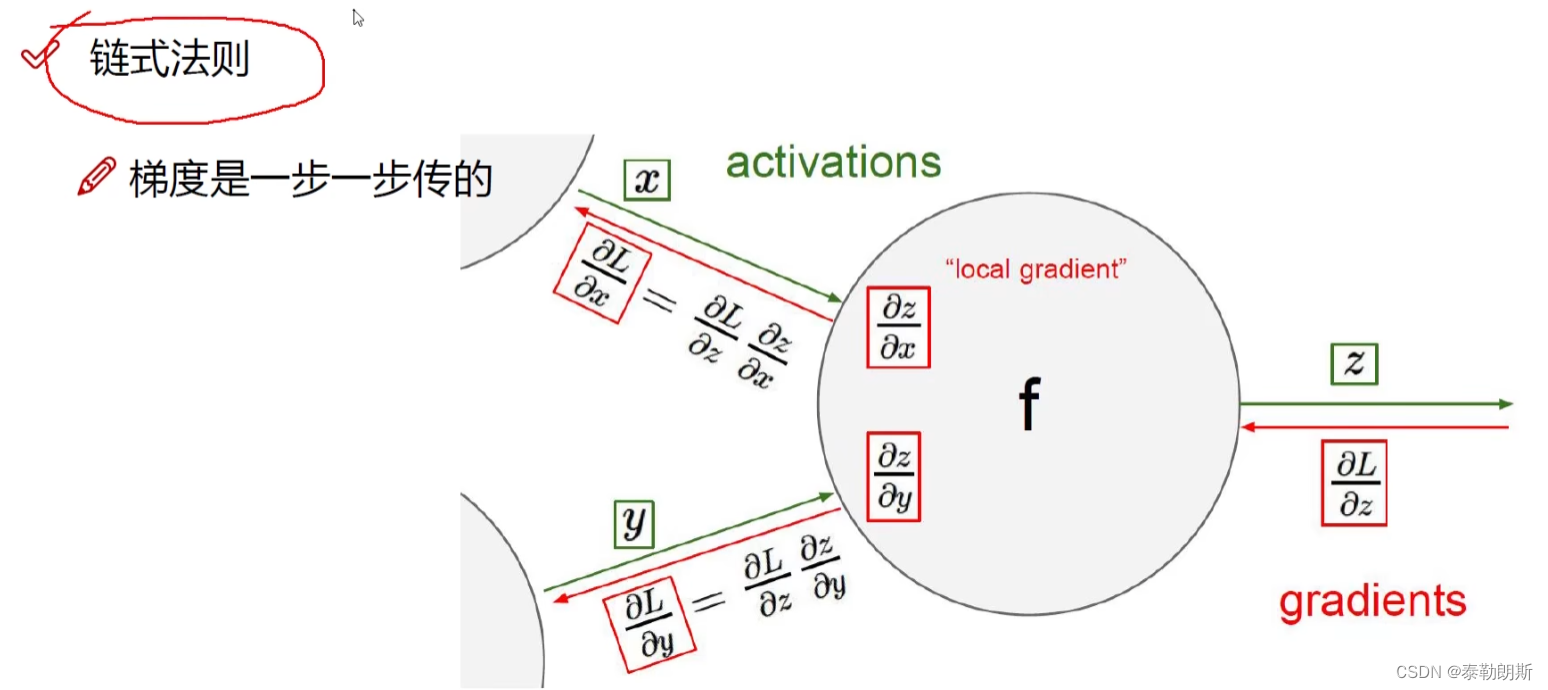

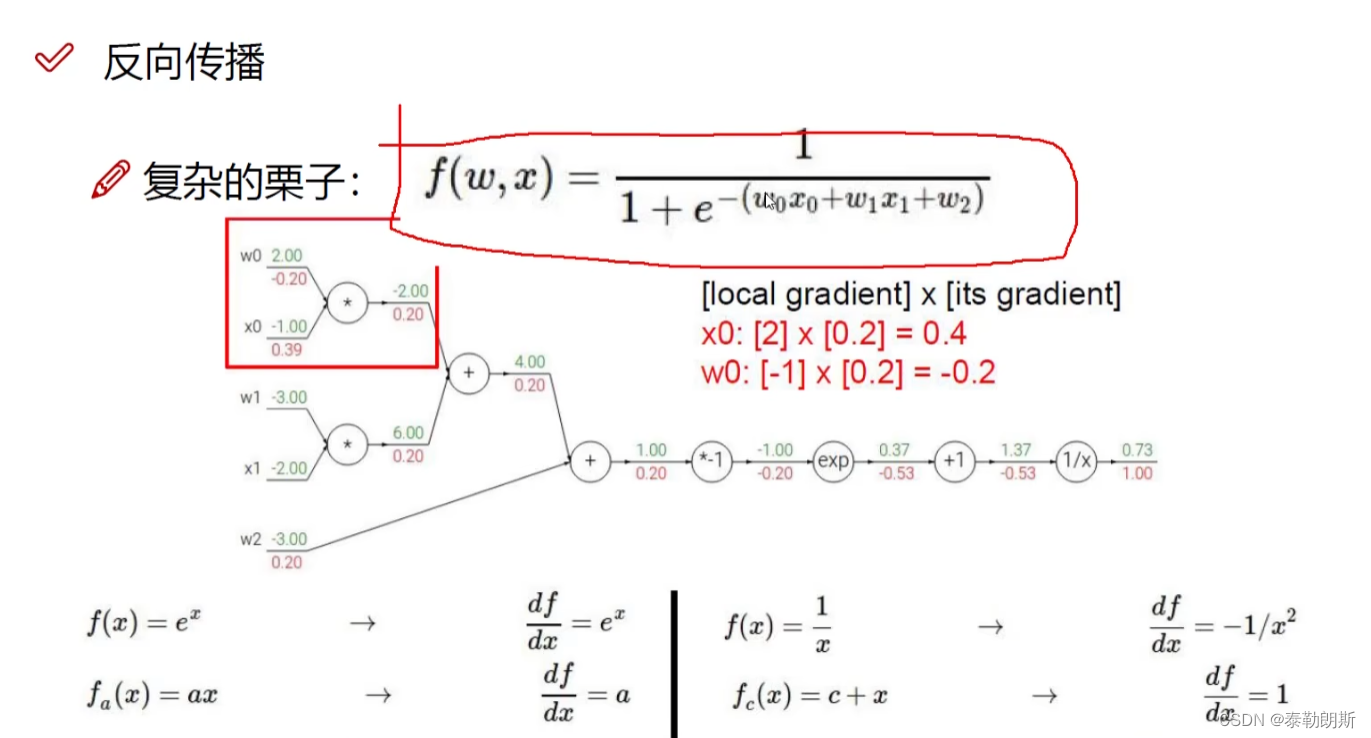

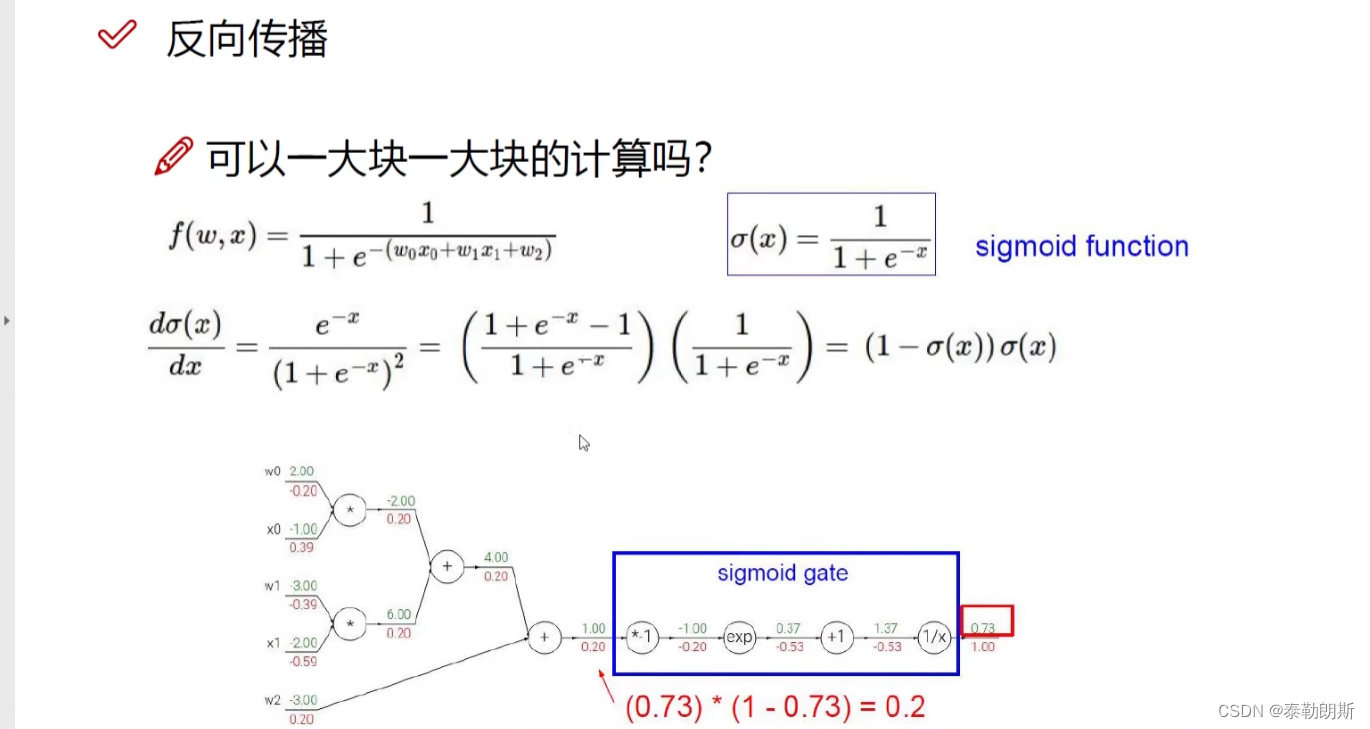

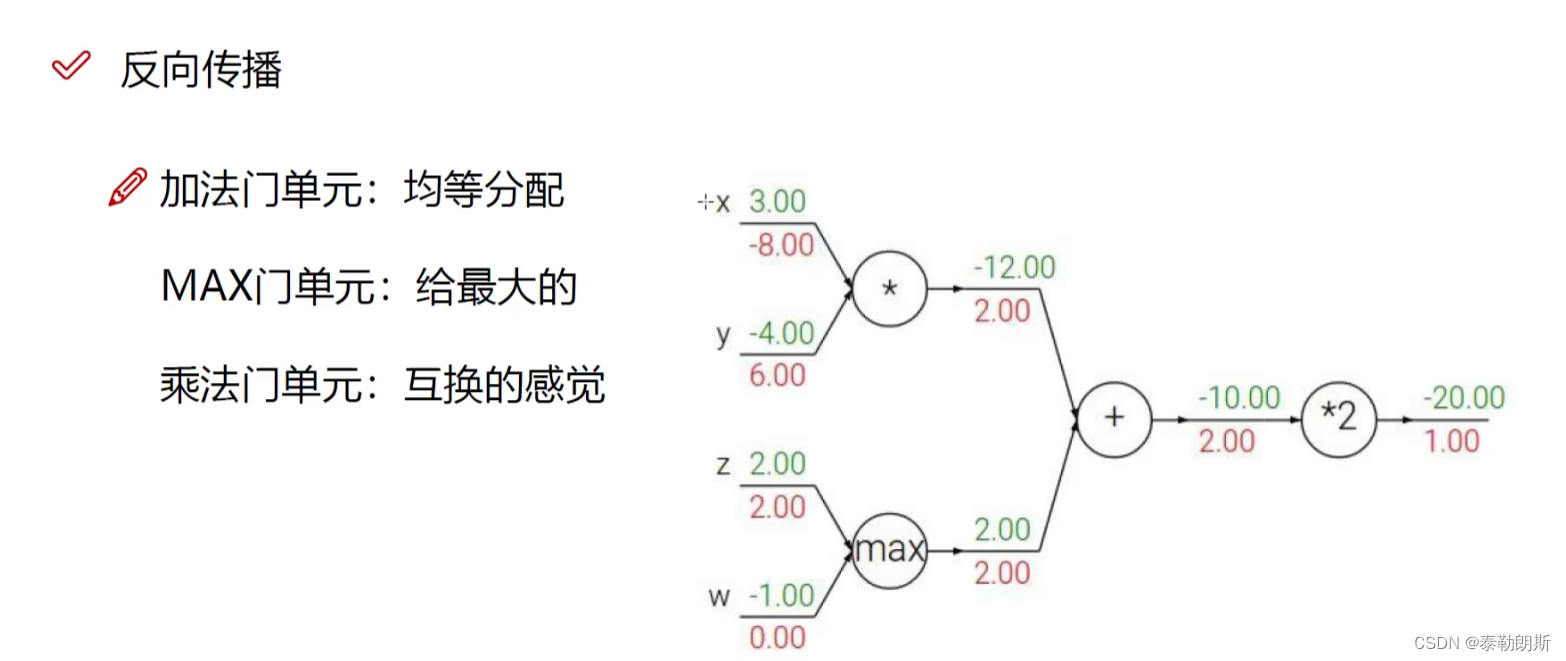

5.反向传播

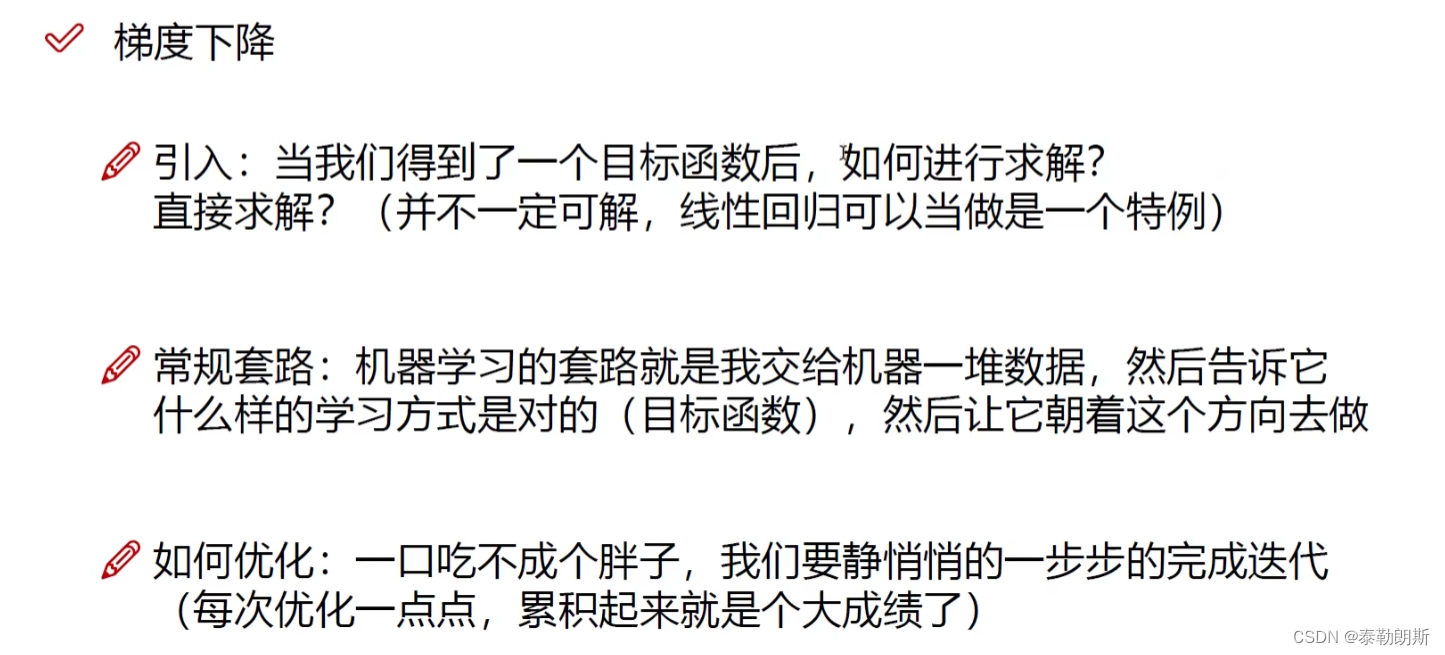

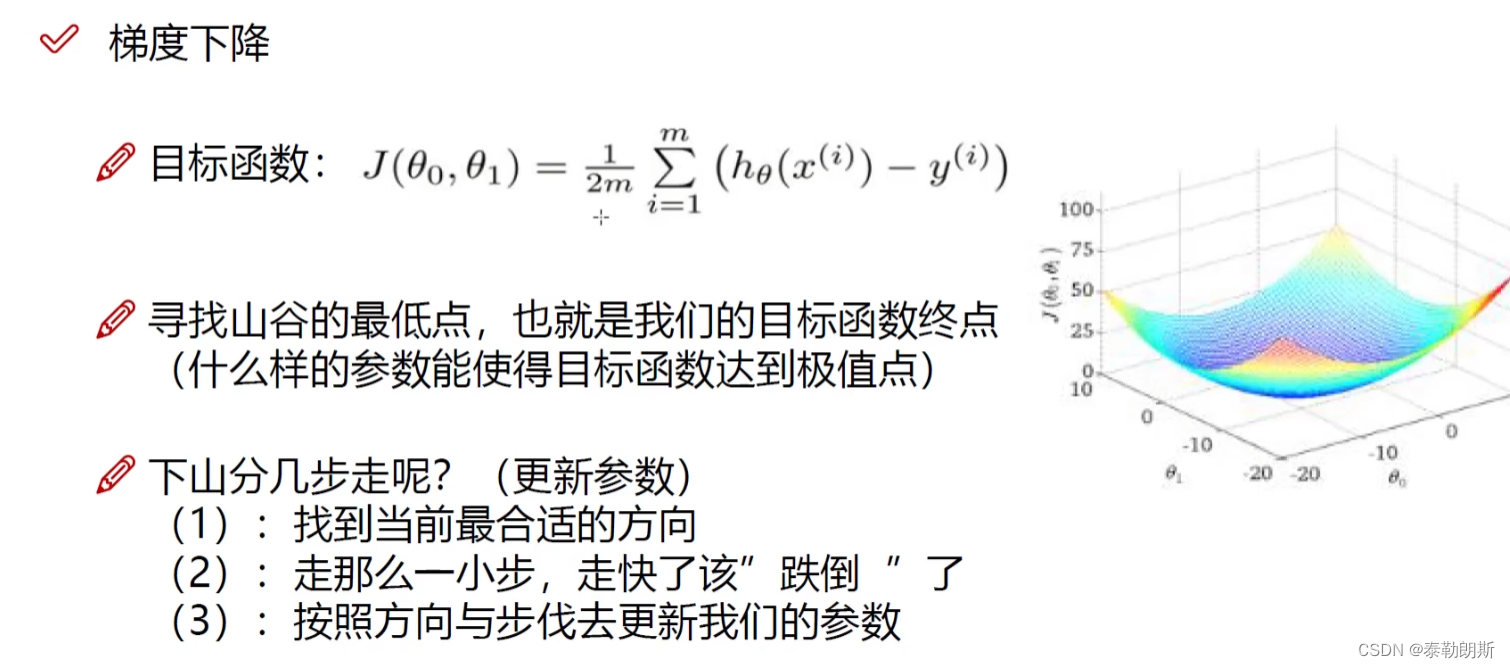

加入,结果变小,改那个之最好?

w让损失函数变换最快。

求偏导数,发现z的变换能让整个函数变换最大

实际神经网络中,从后往前传播

逐层,从后往前传播

下图中x就是我们的像素点,绿色的是我们的输入值,红色的是梯度值

门单元介绍

训练的过程就是求权重

解决过拟合是随机的杀死一些神经元

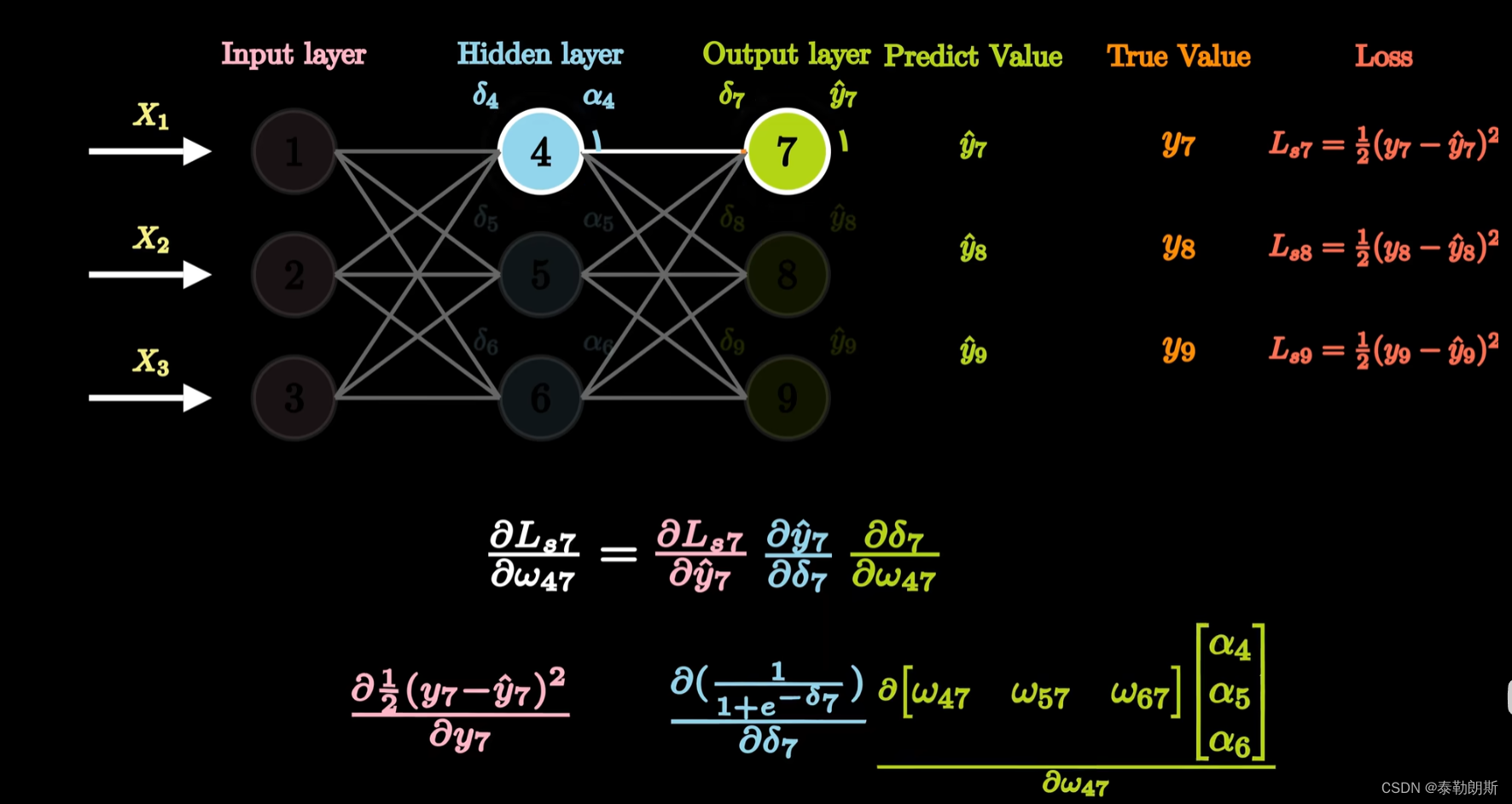

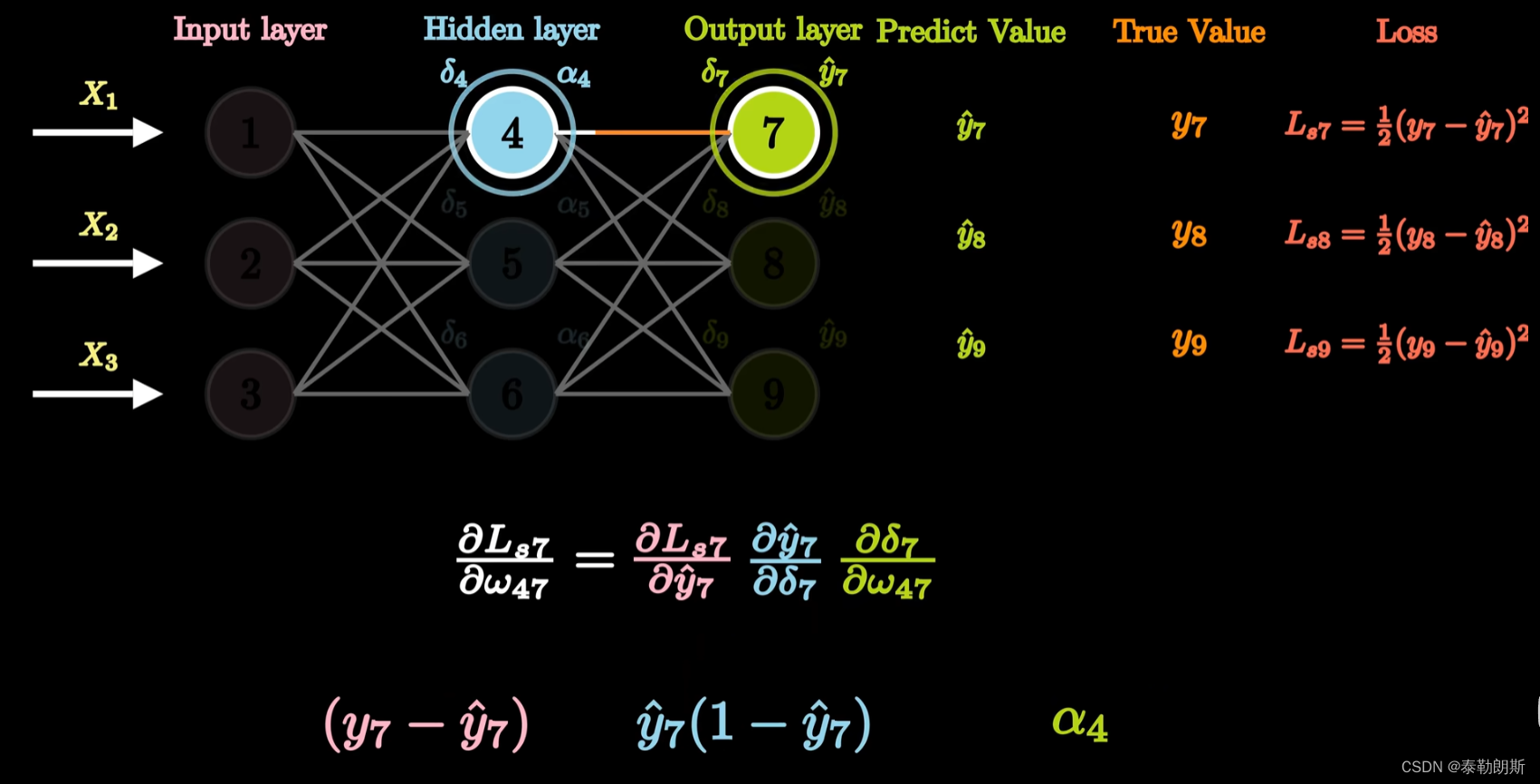

1.反向传播介绍

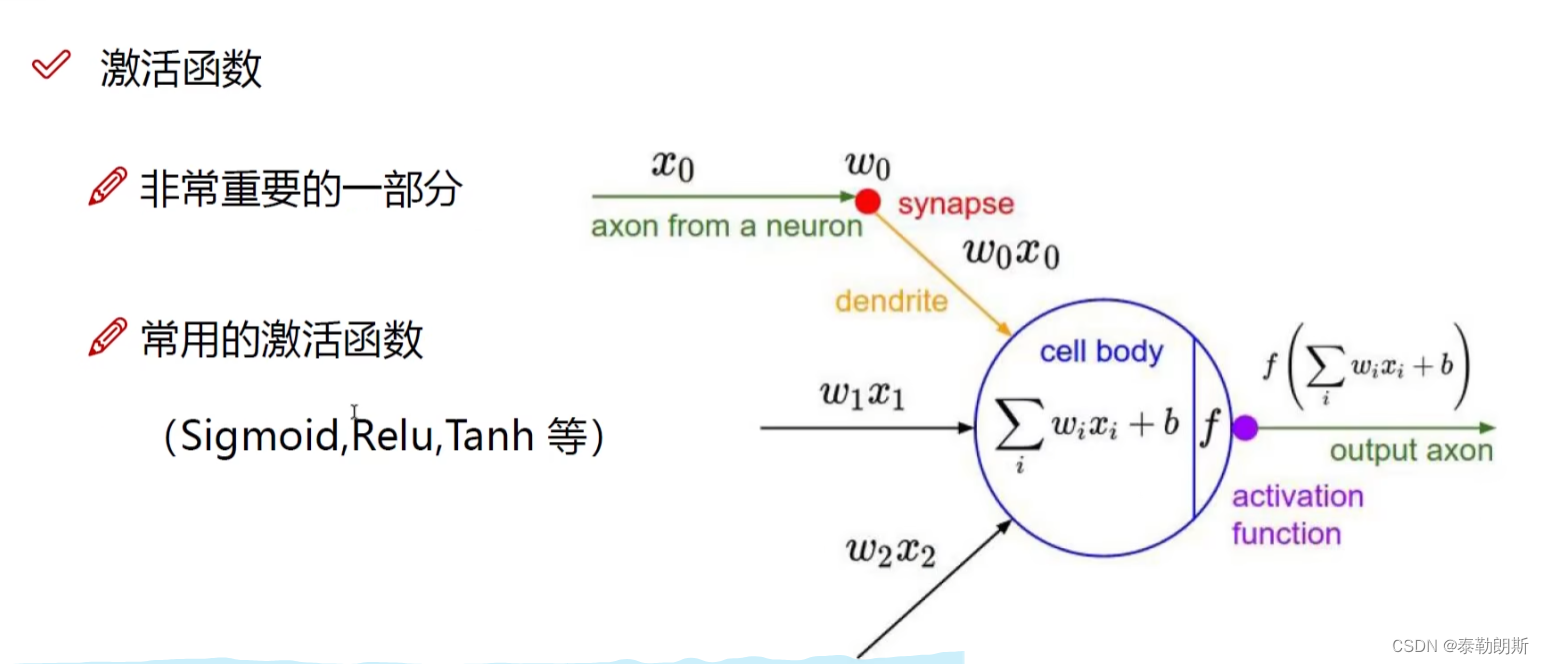

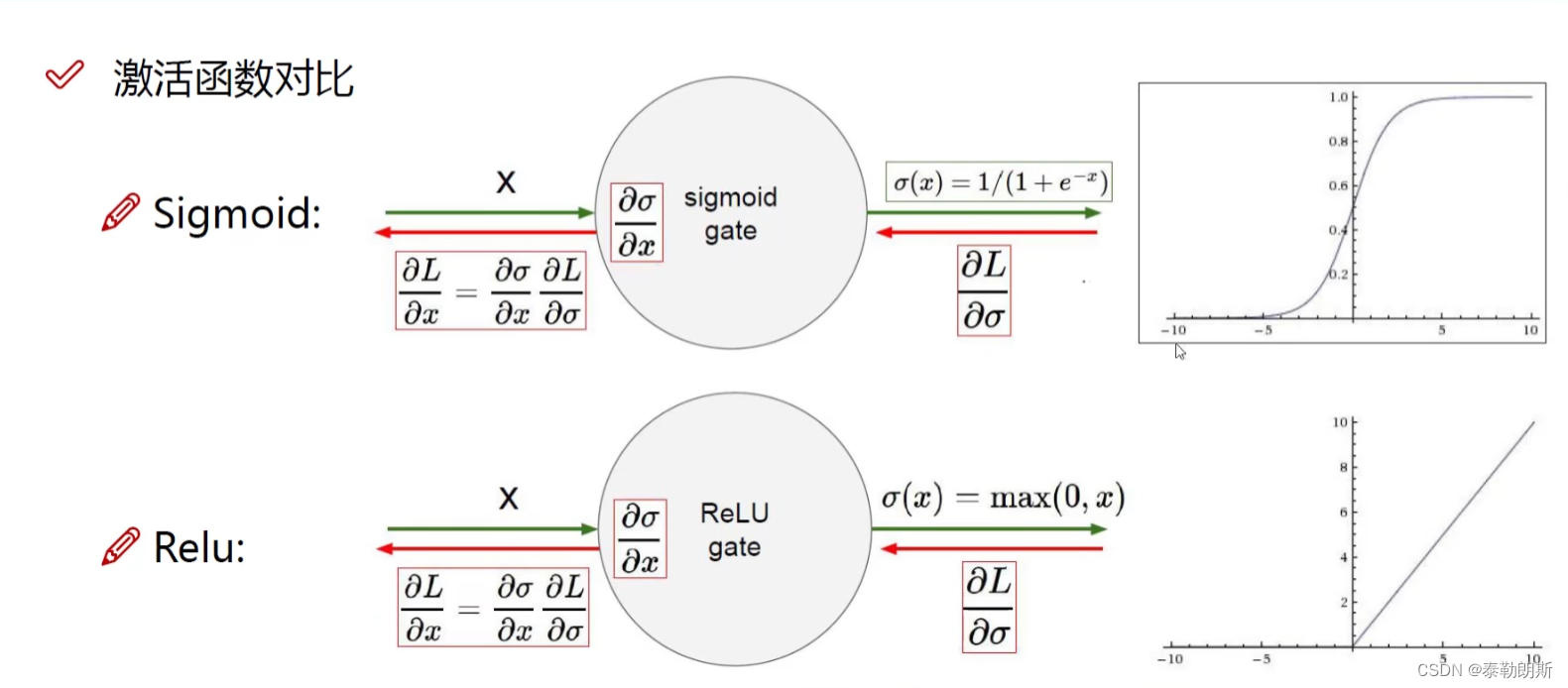

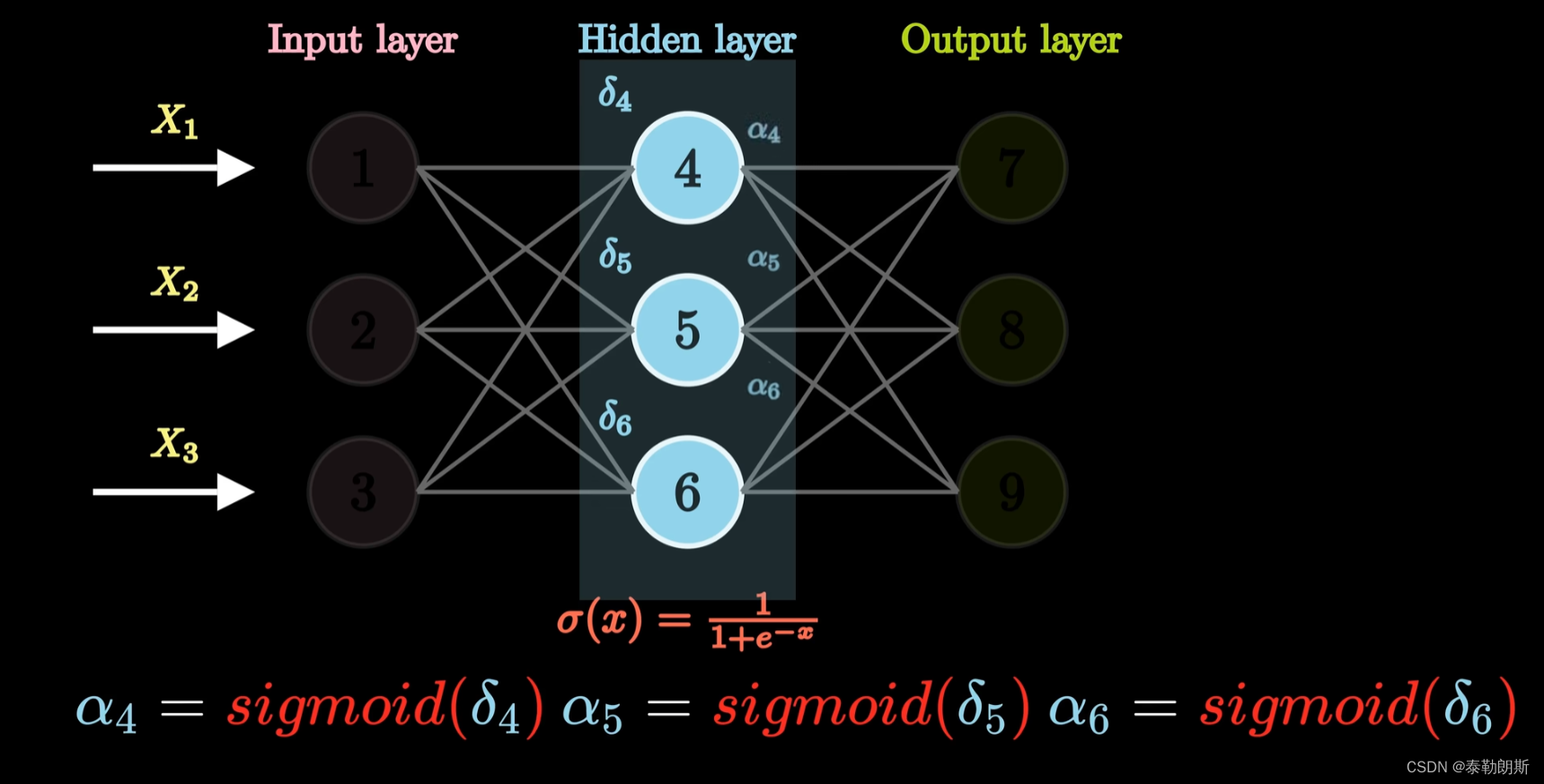

下面是激活函数

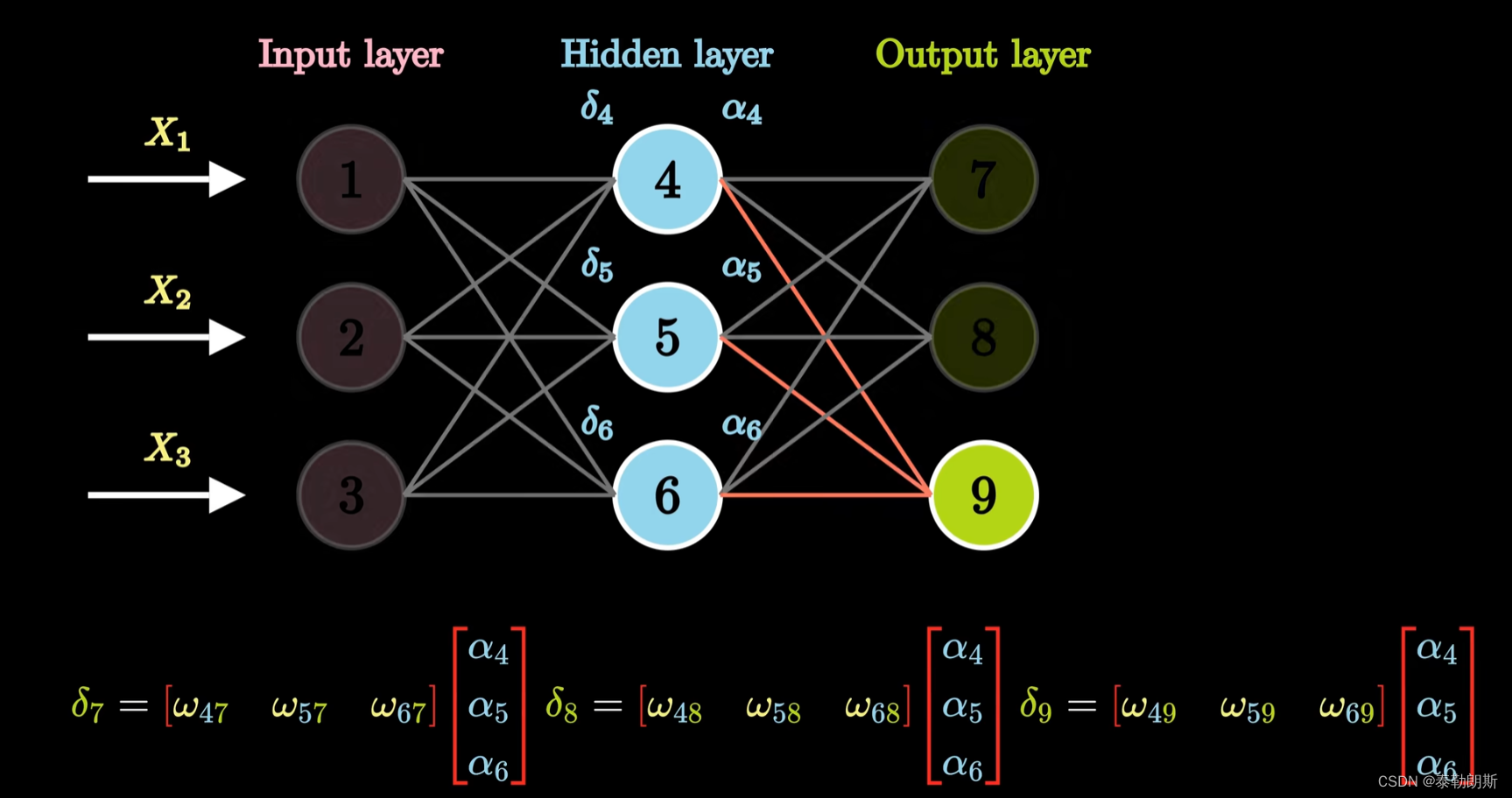

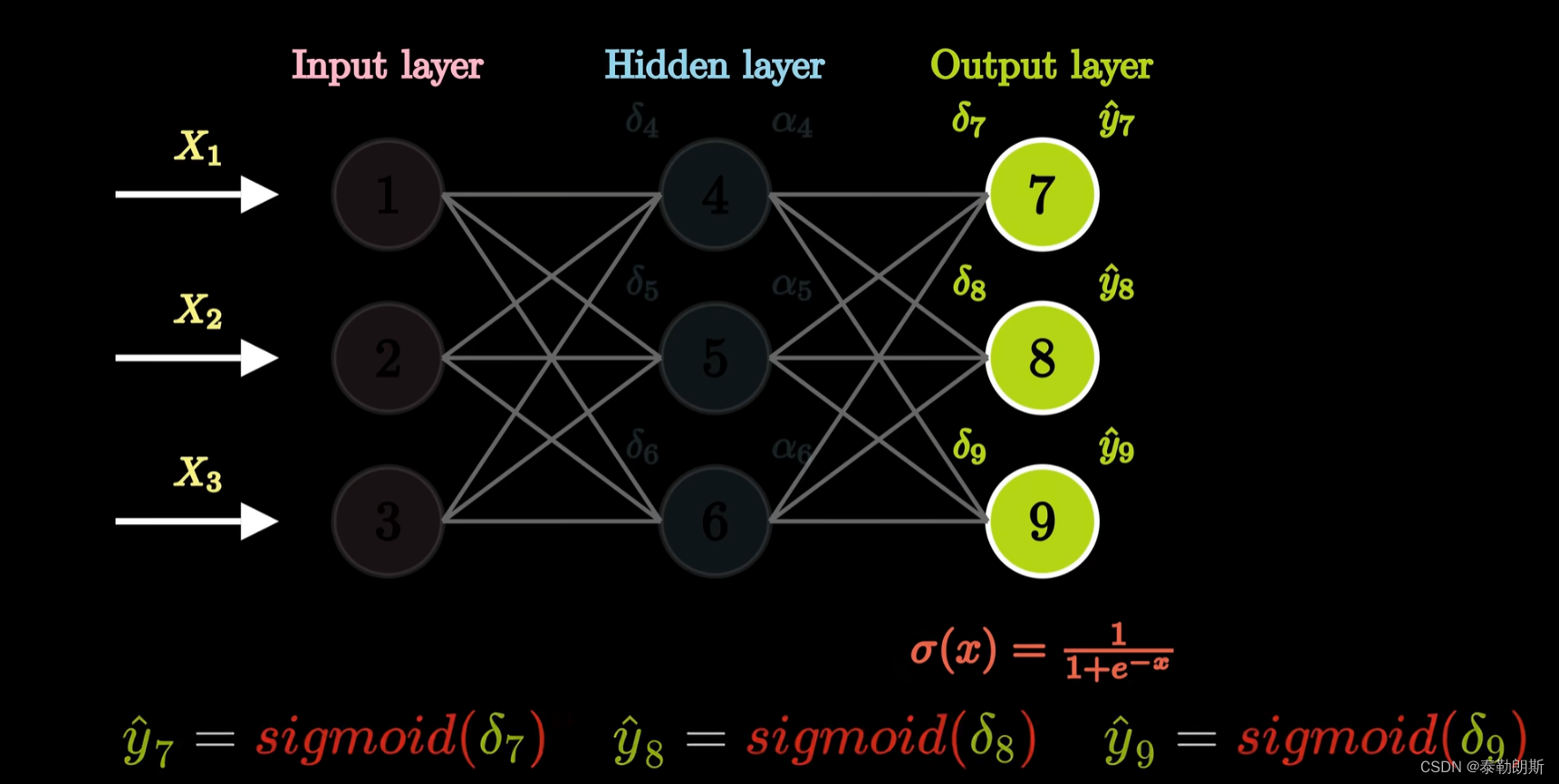

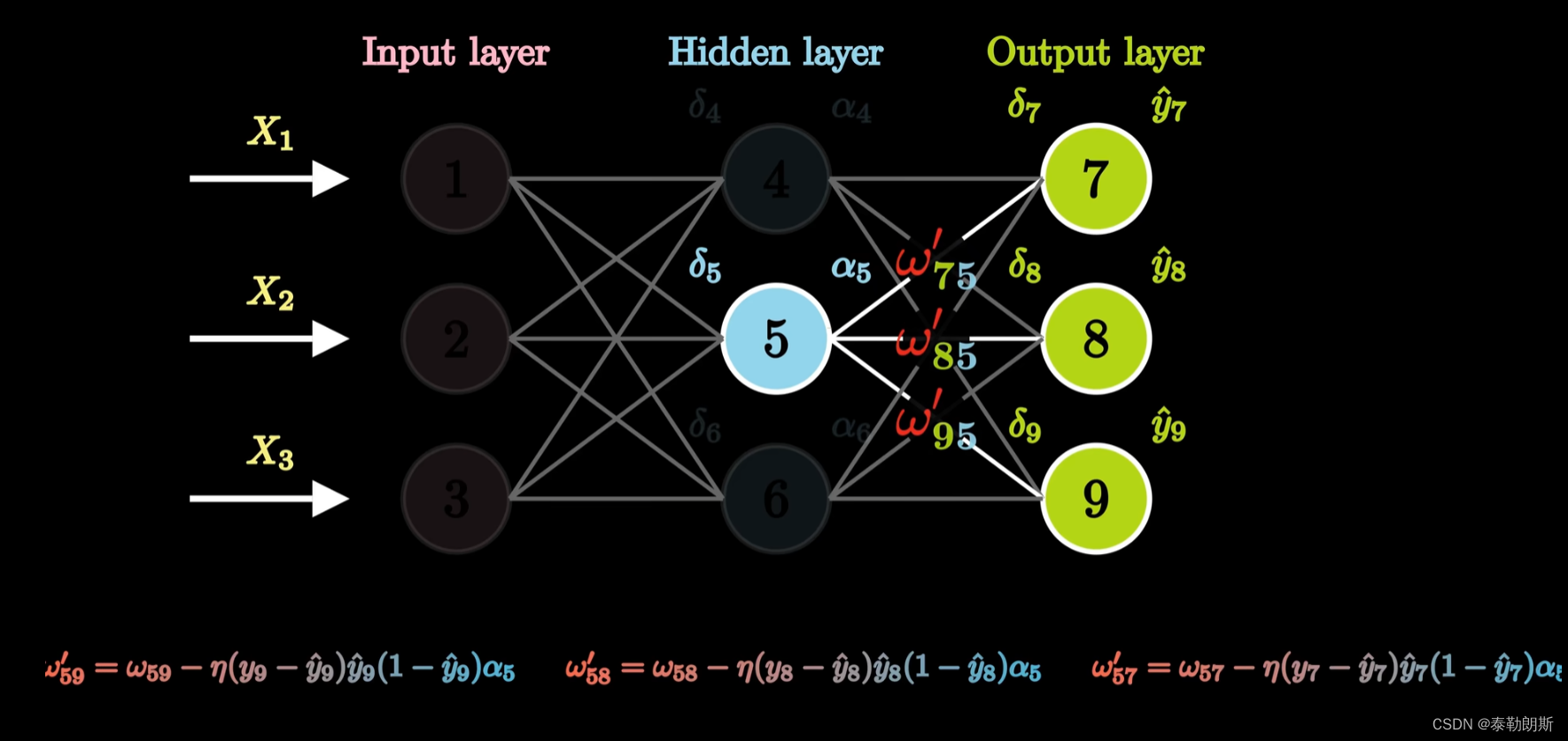

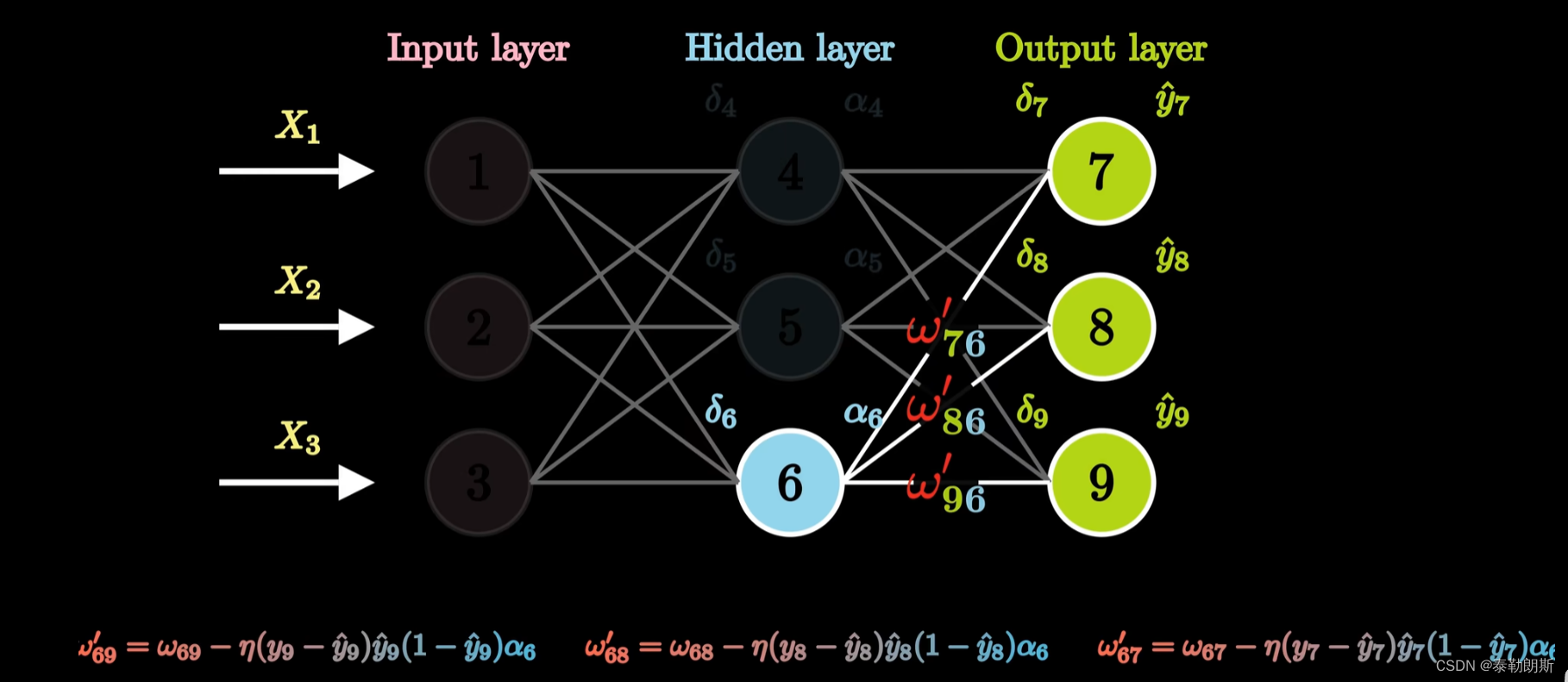

继续求输出层

继续求输出层

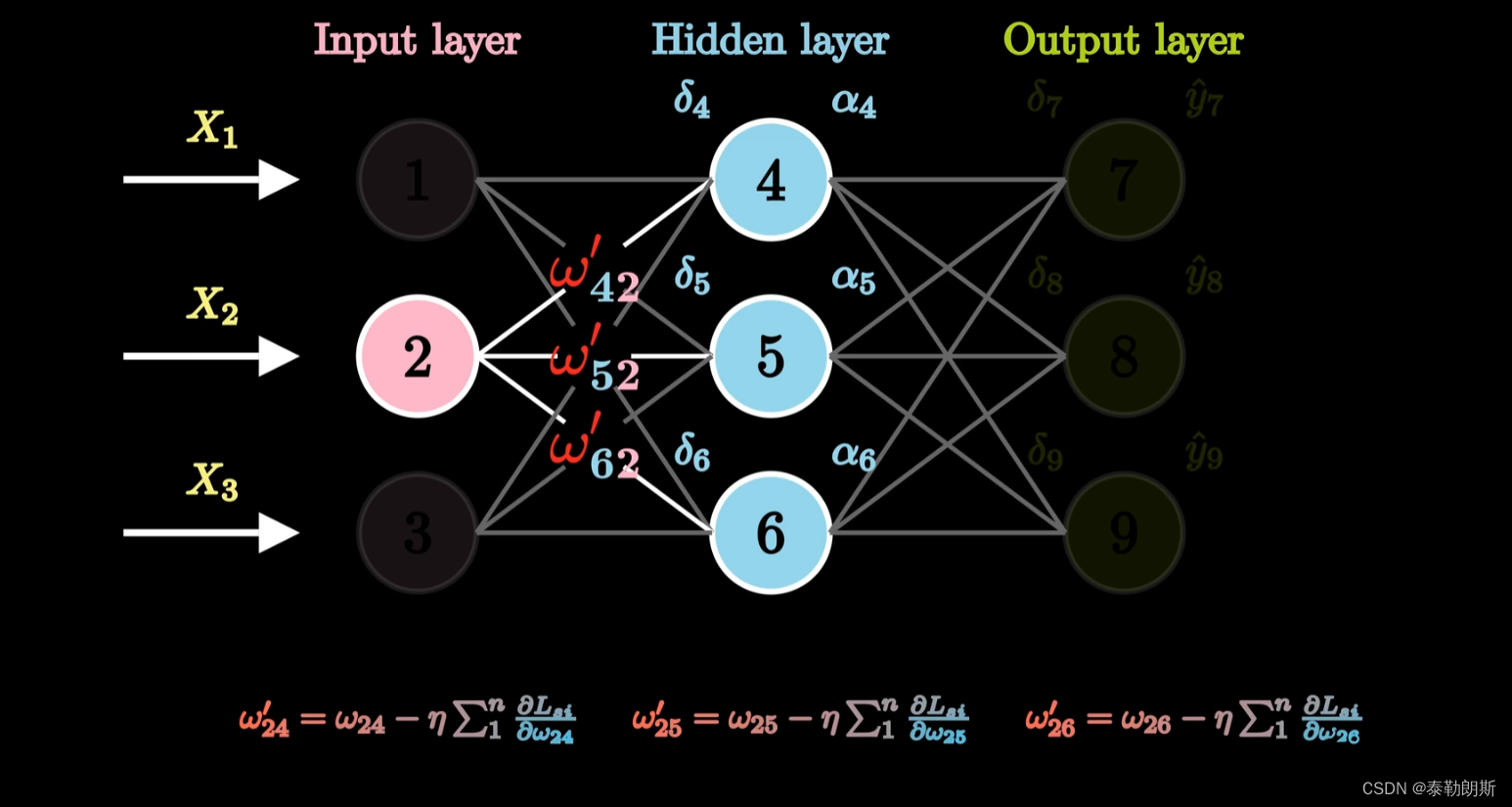

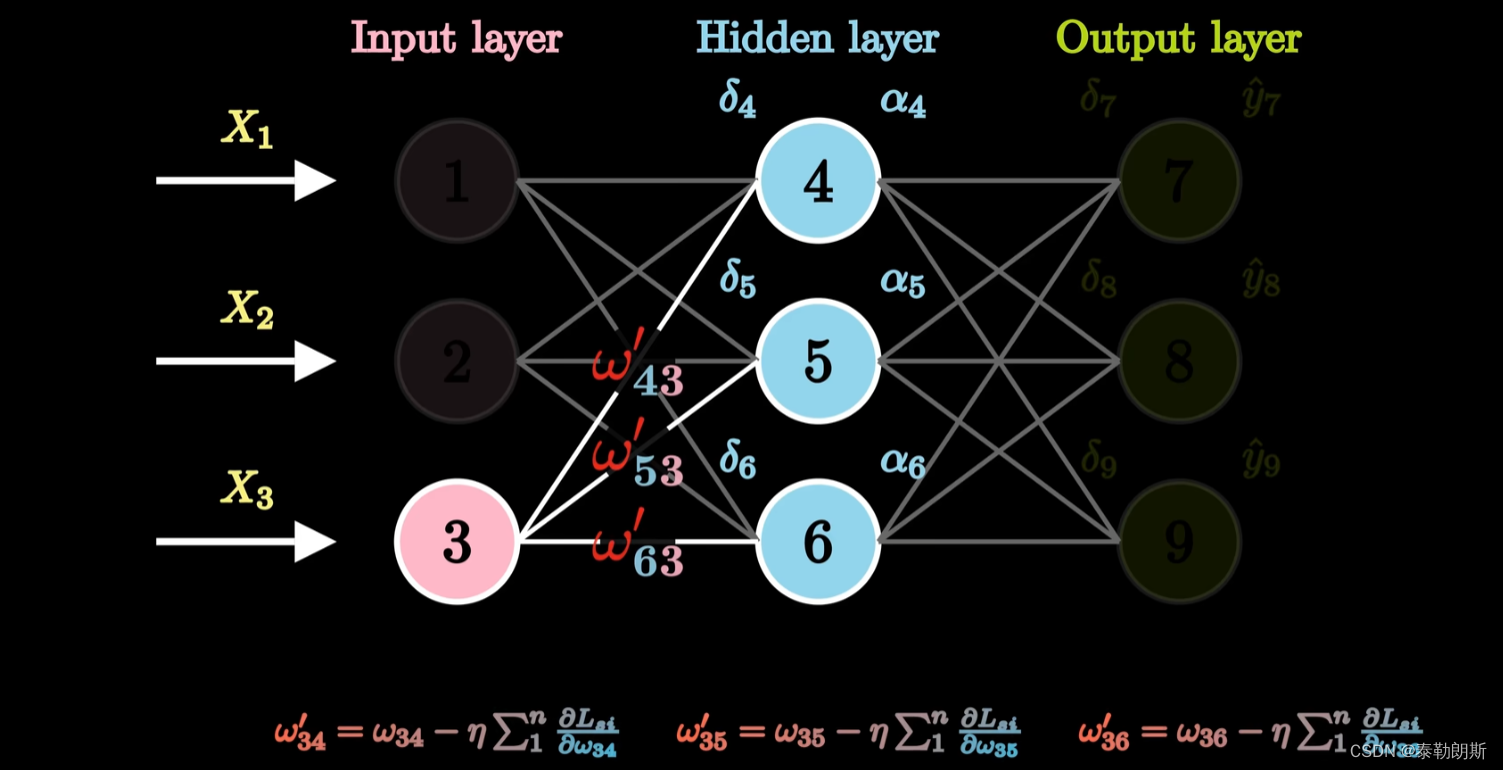

反向求导

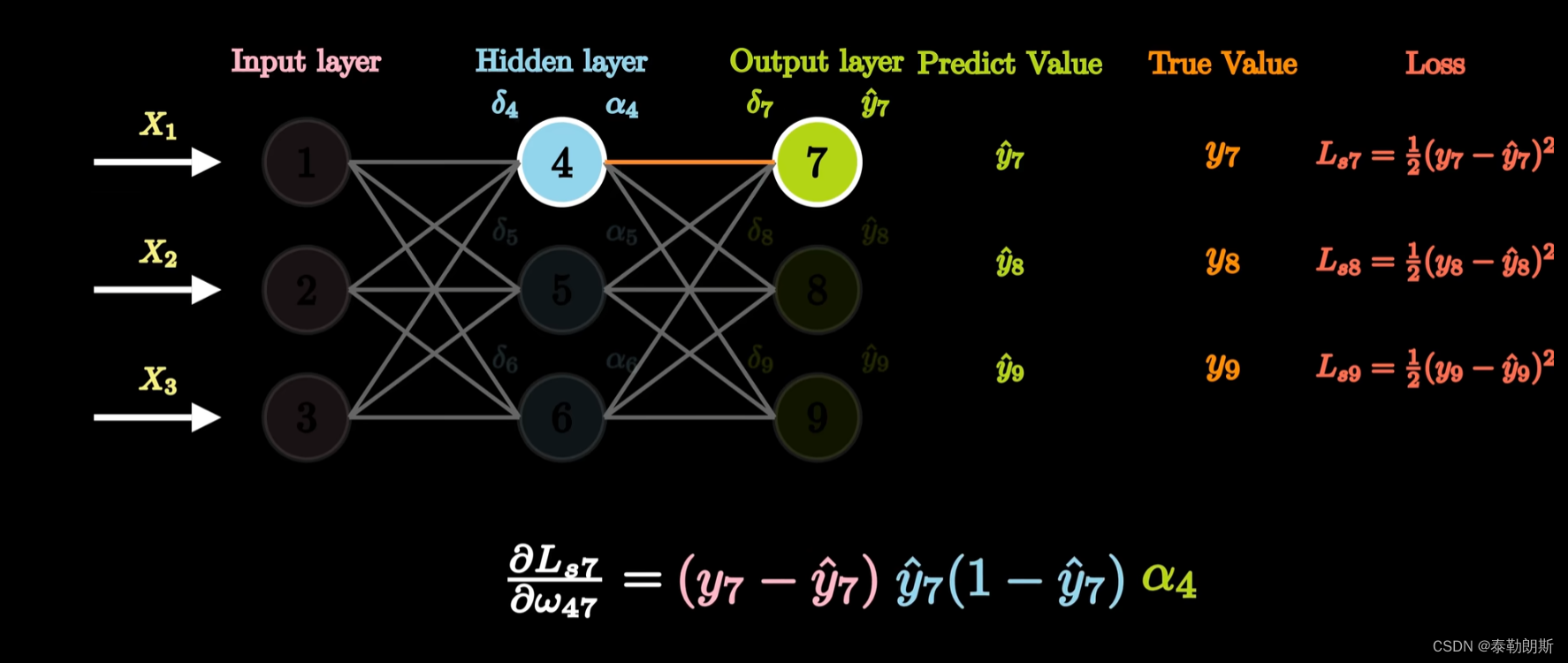

求导后结果

换算后

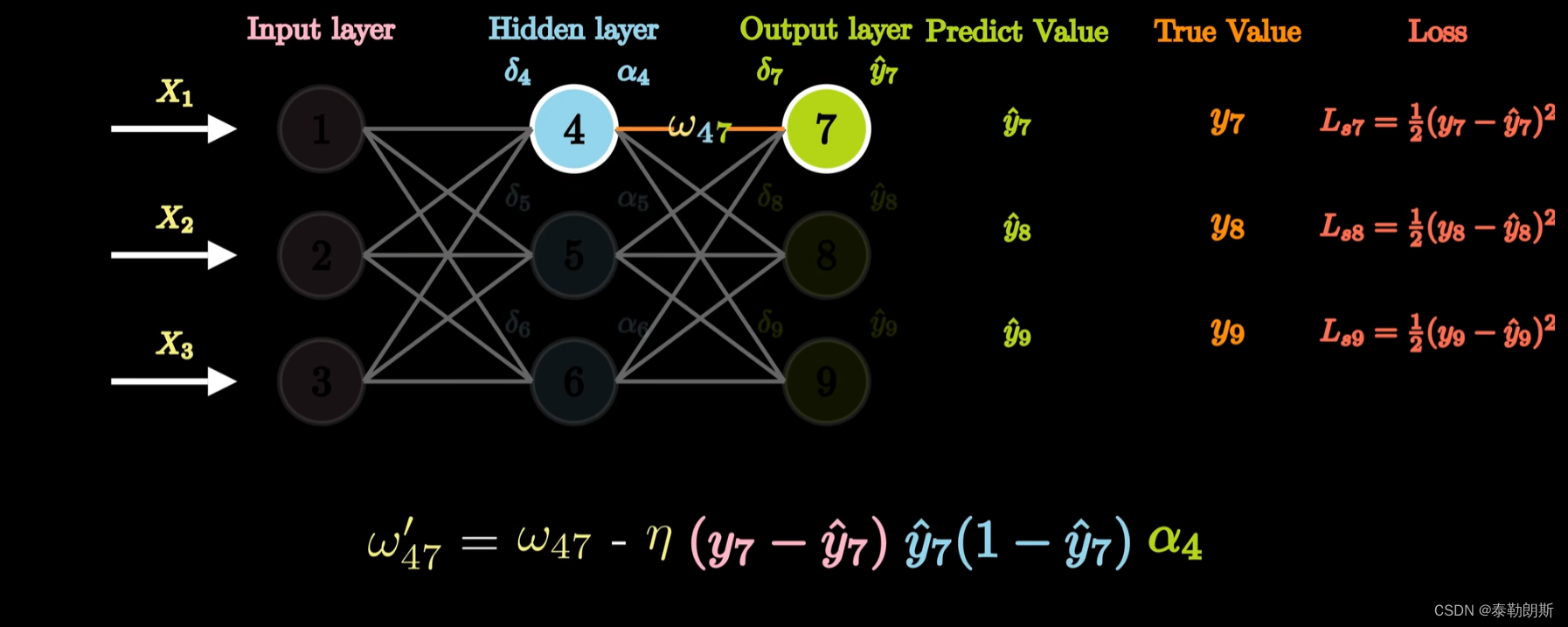

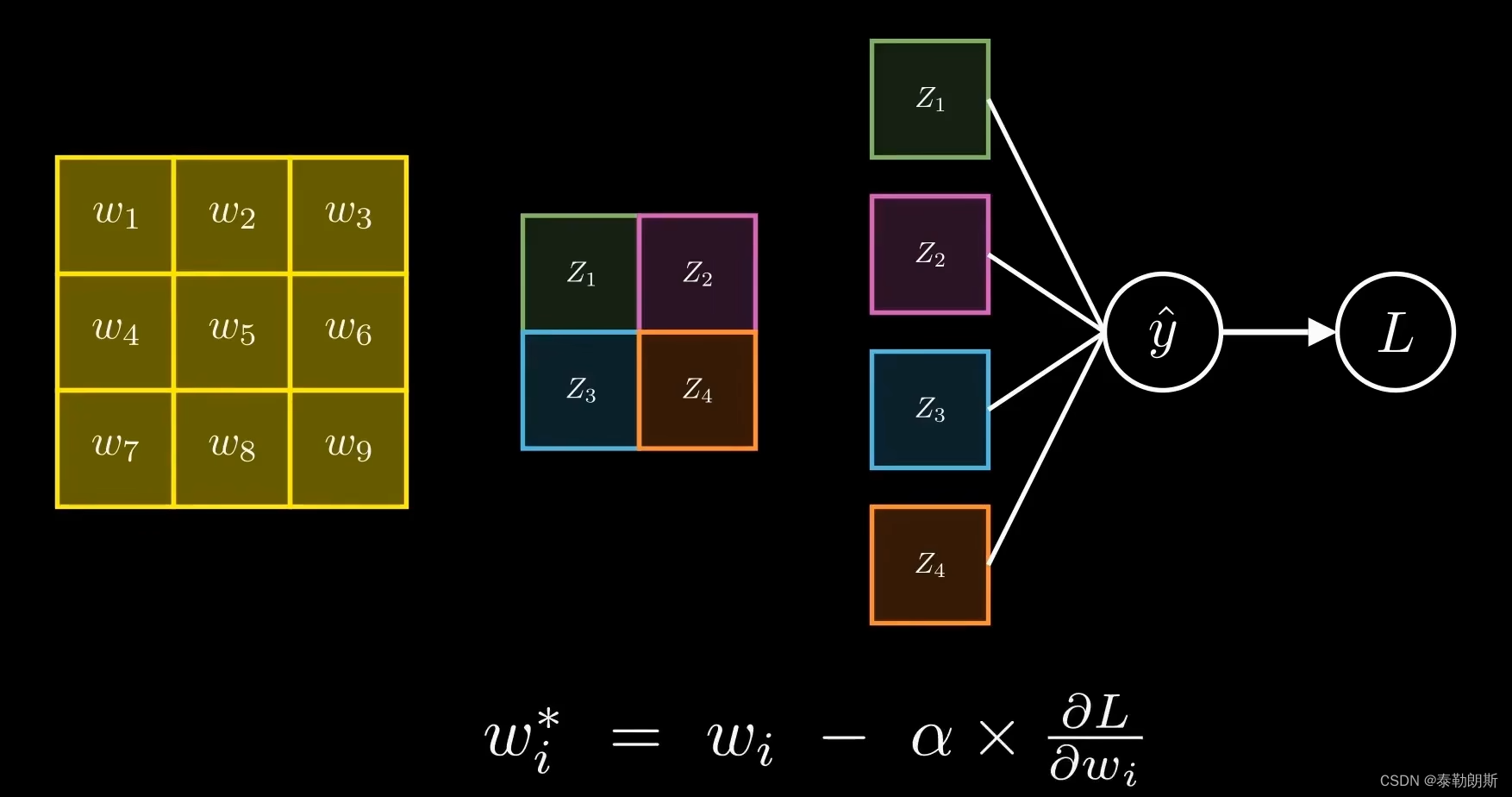

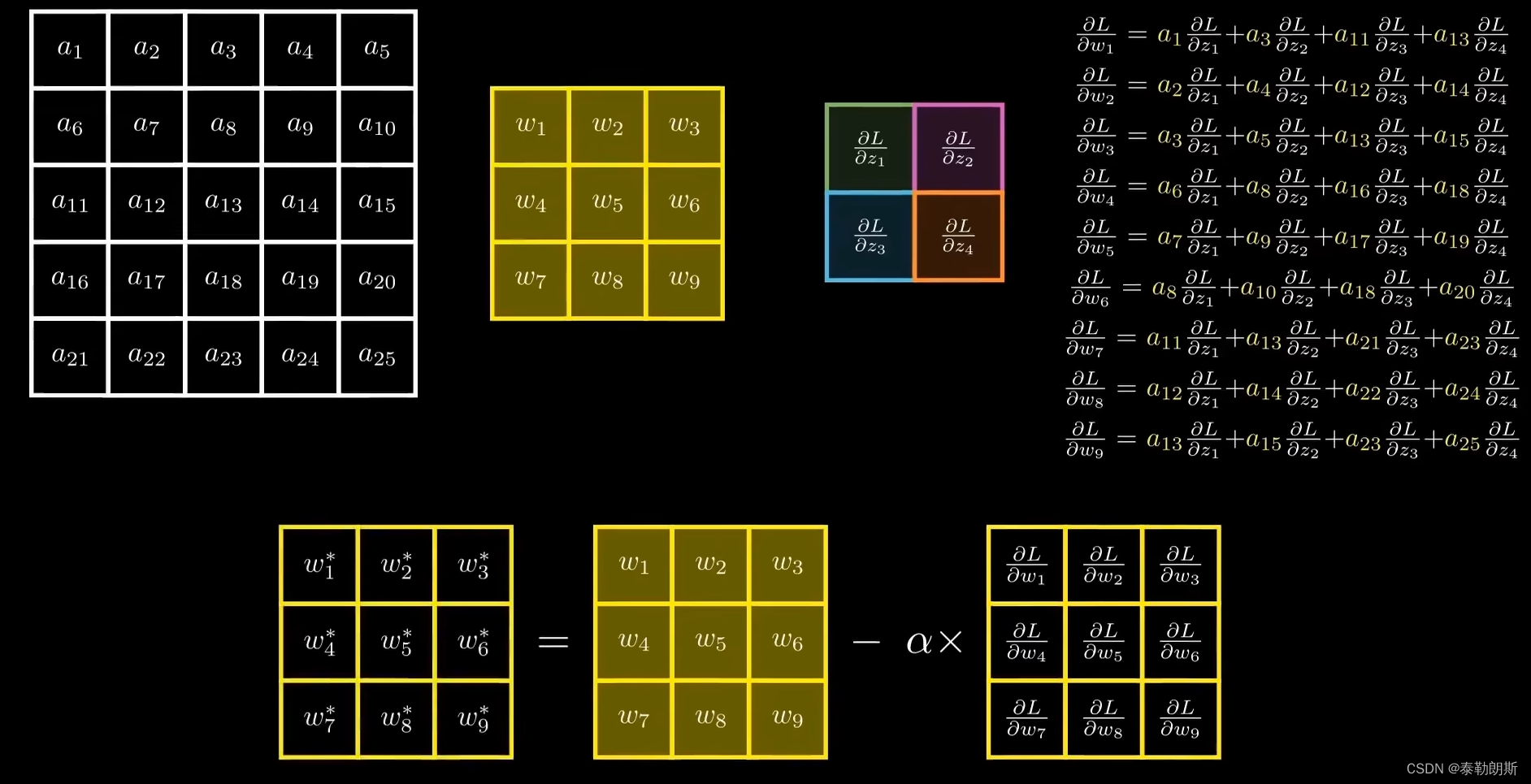

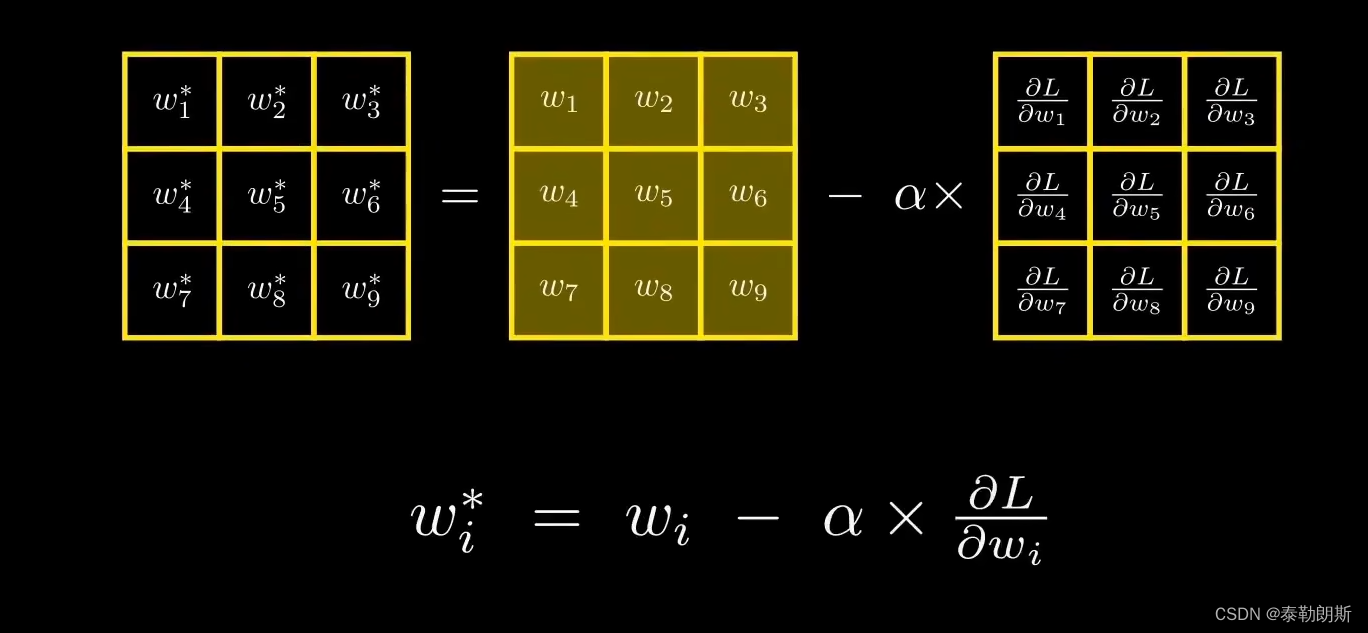

最后求出新的权重,下面参数是学习率也就是步长

我们通过一个线性

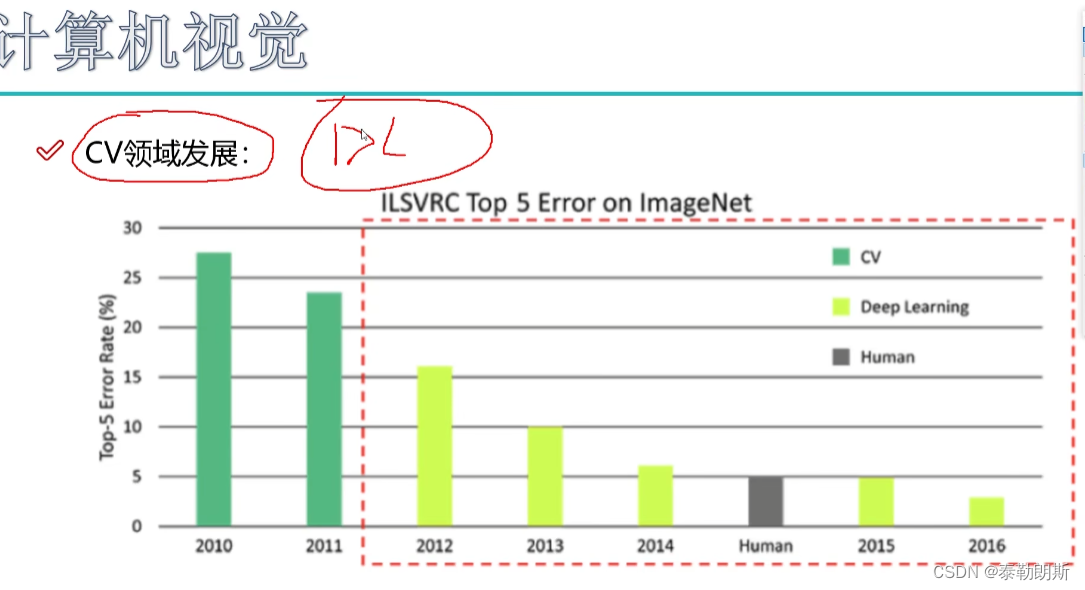

6 卷积神经网络应用

Y轴是错误率

1.检测任务

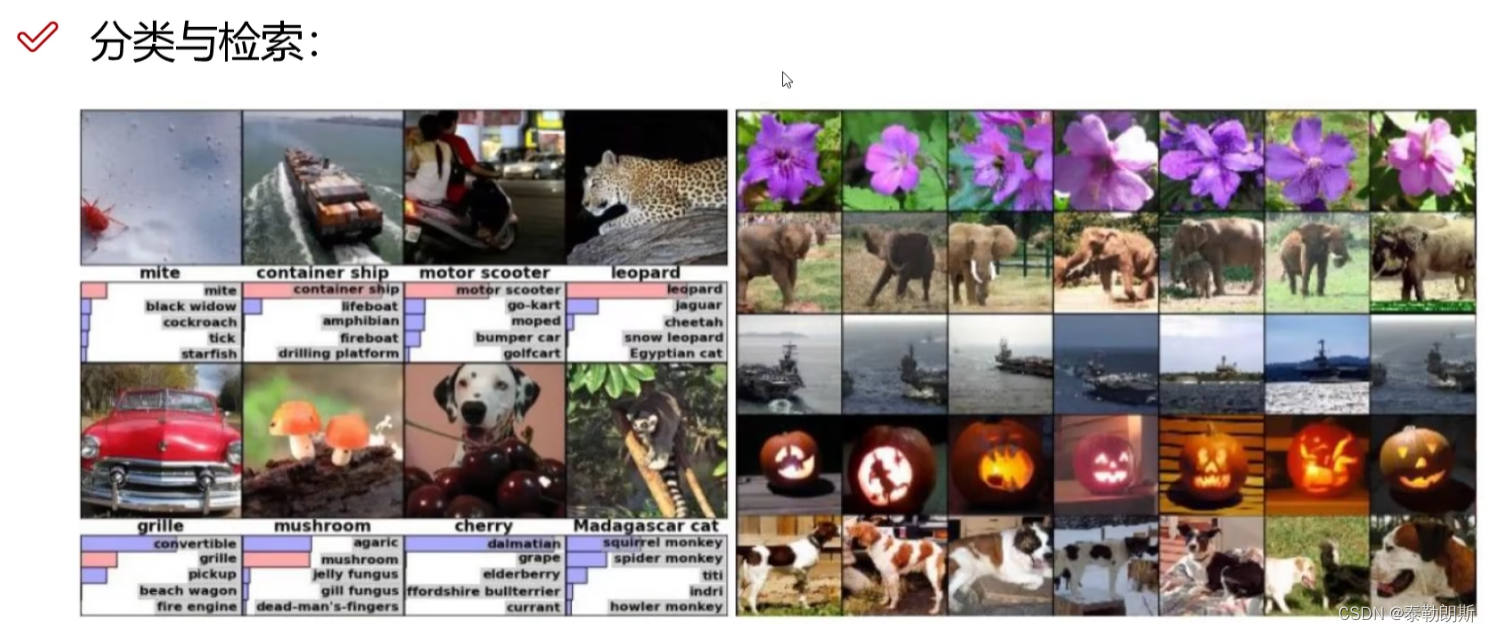

分类与检索,淘宝图片同类查找

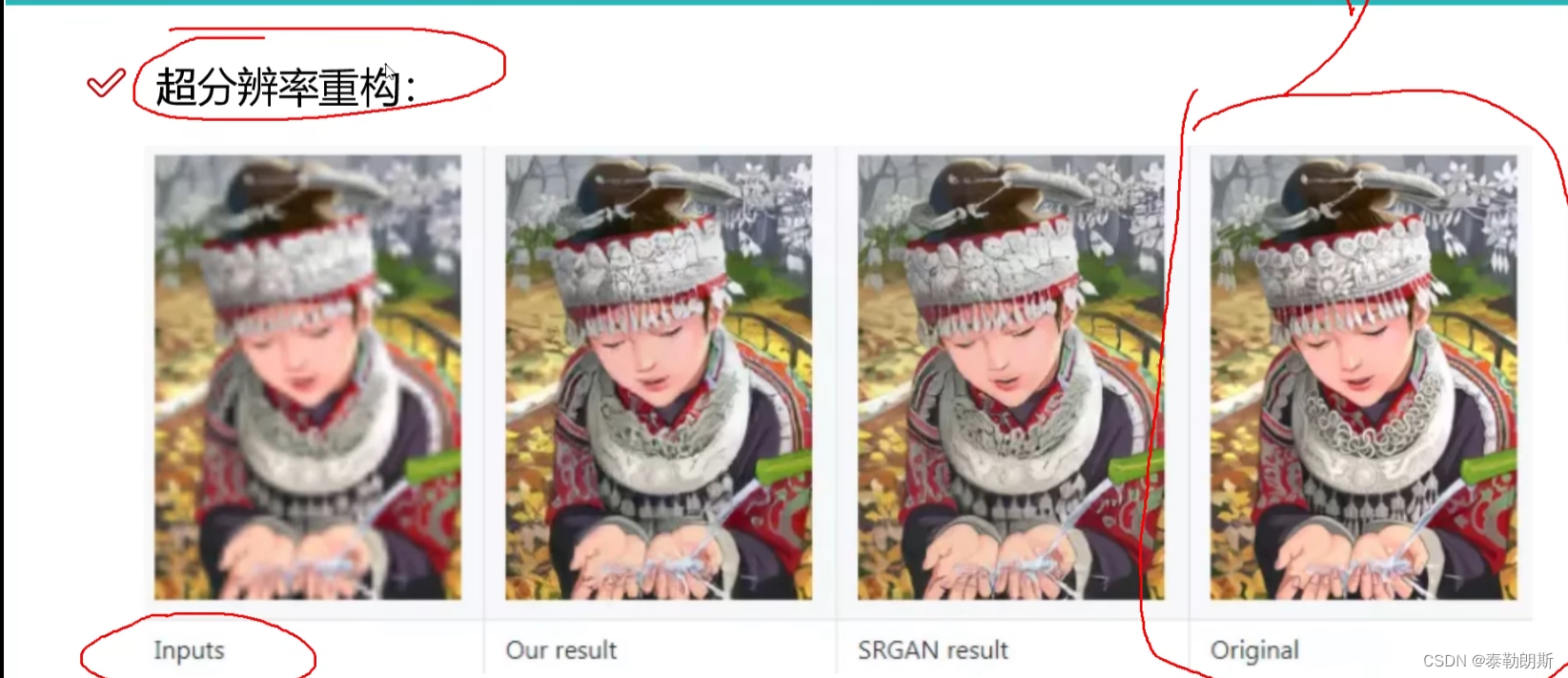

2.超分辨率重构

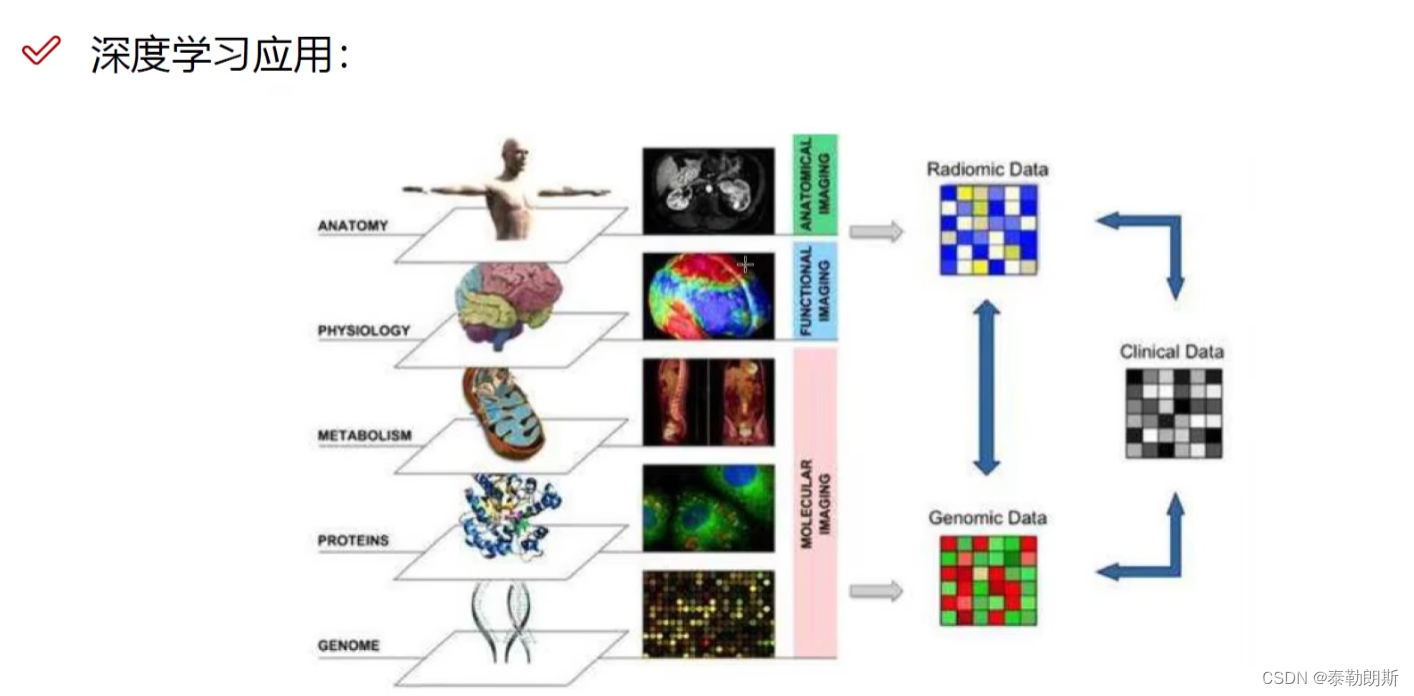

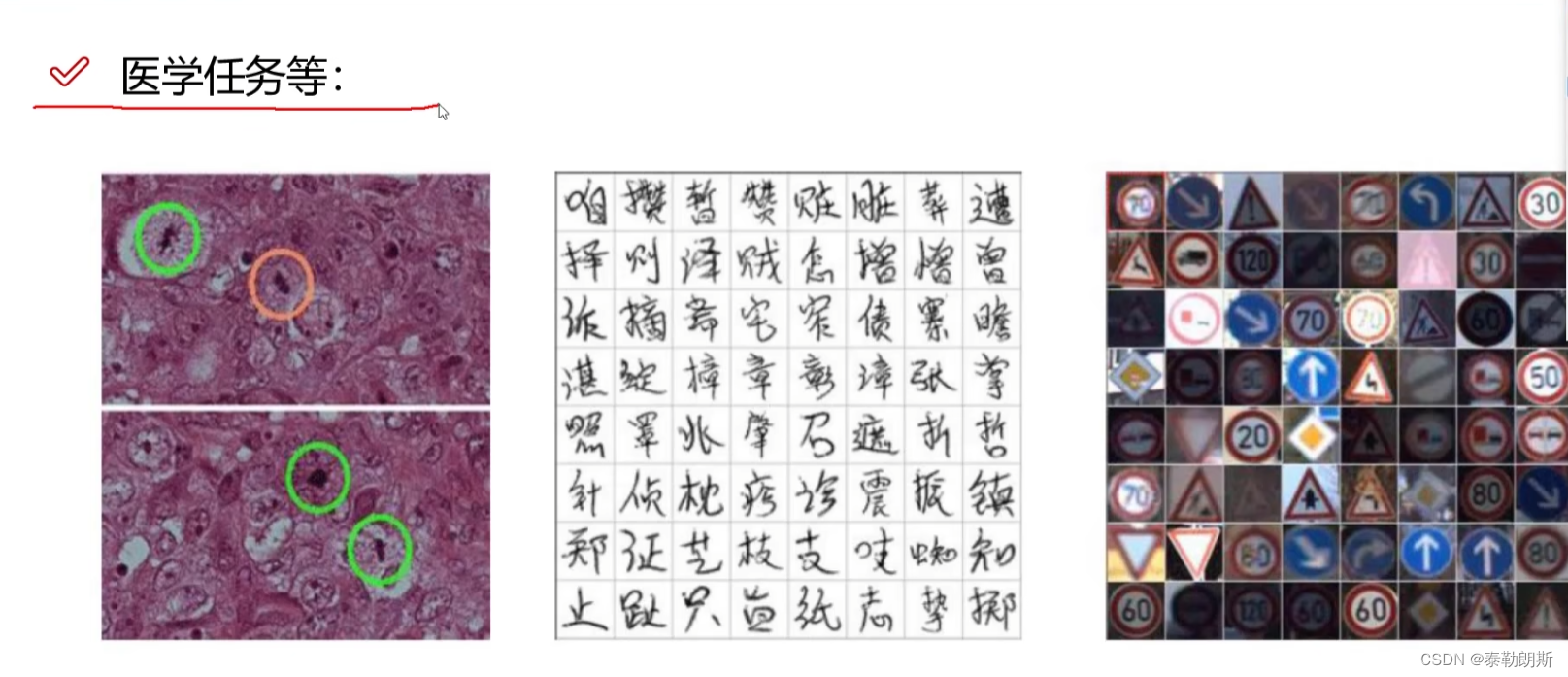

3.医学检测

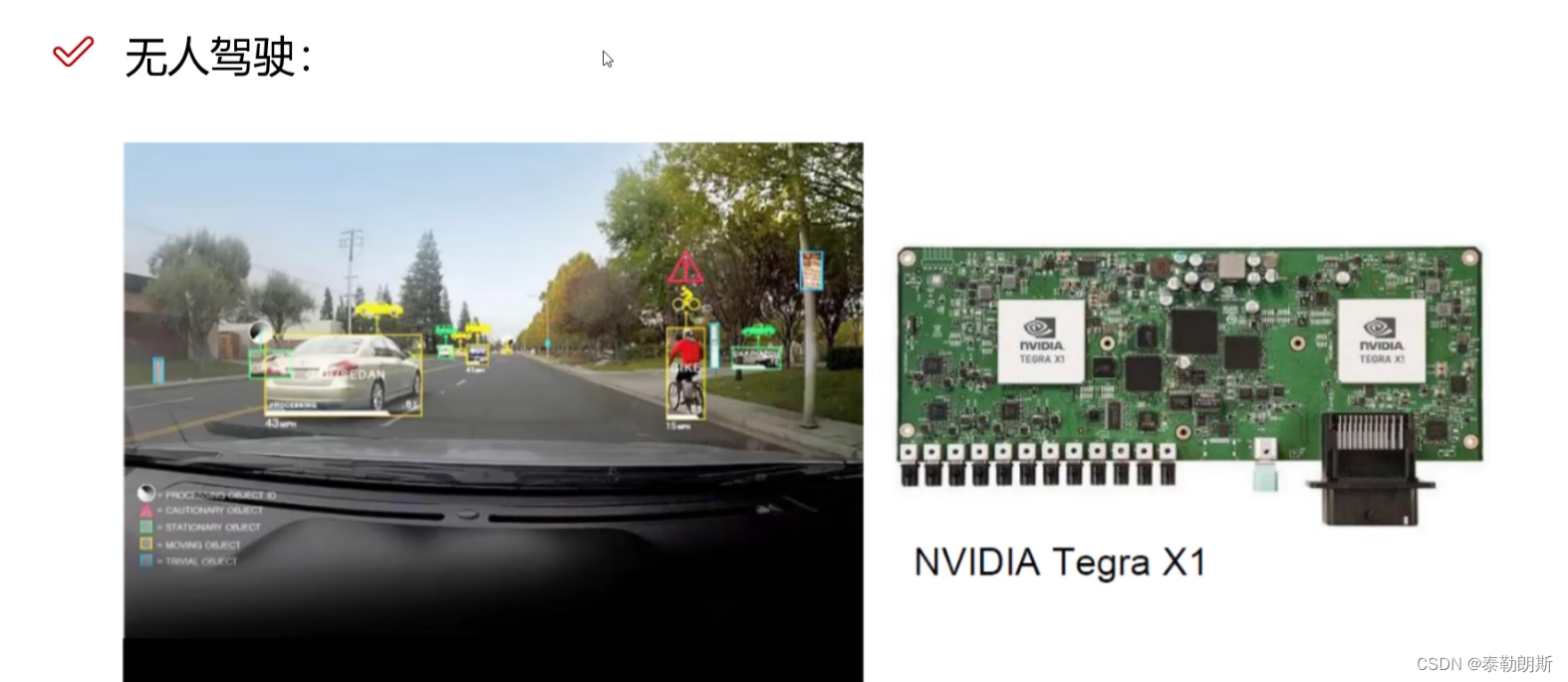

4.无人驾驶

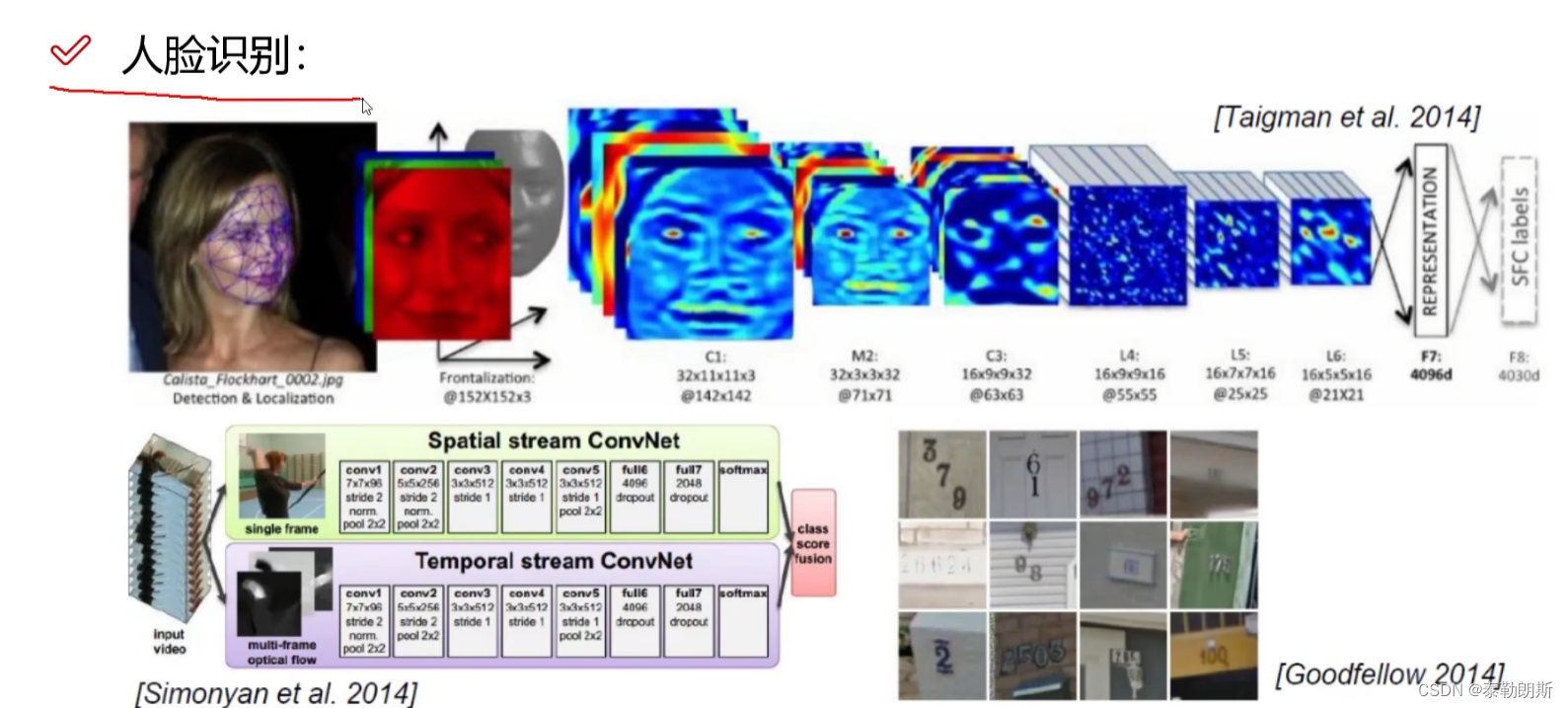

5. 人脸识别

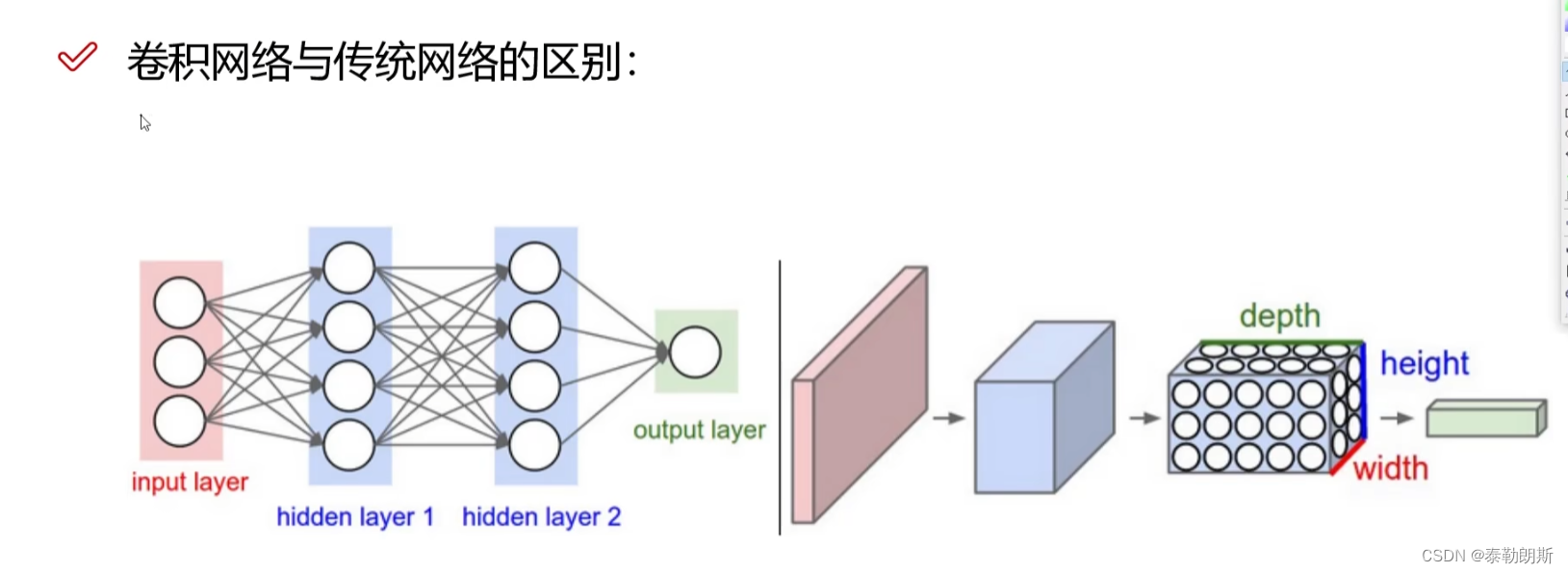

6.卷积网络和传统区别

左边传统网络,右边卷积网络

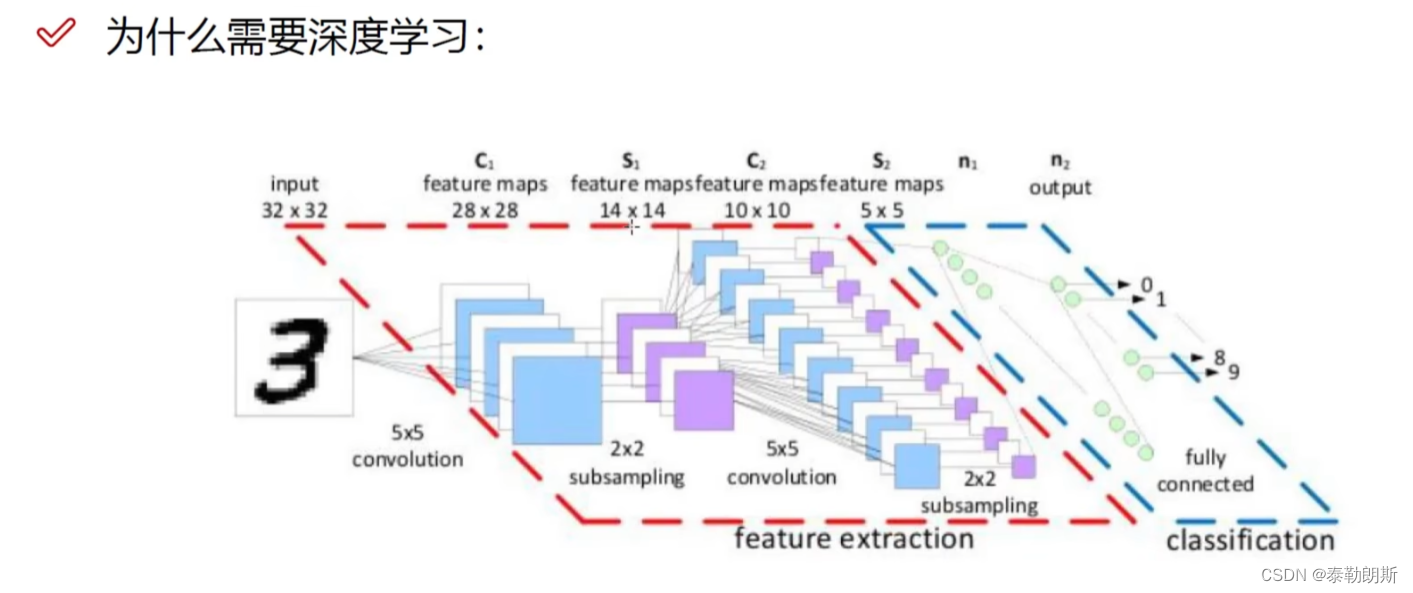

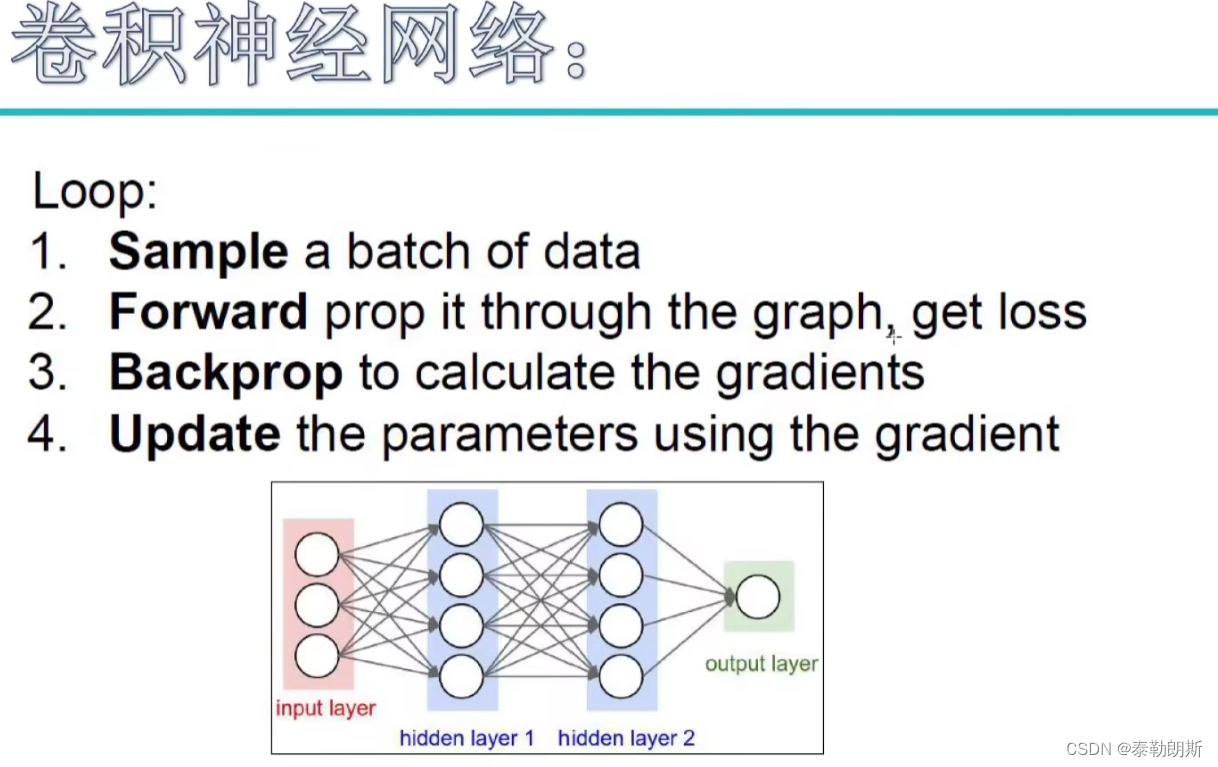

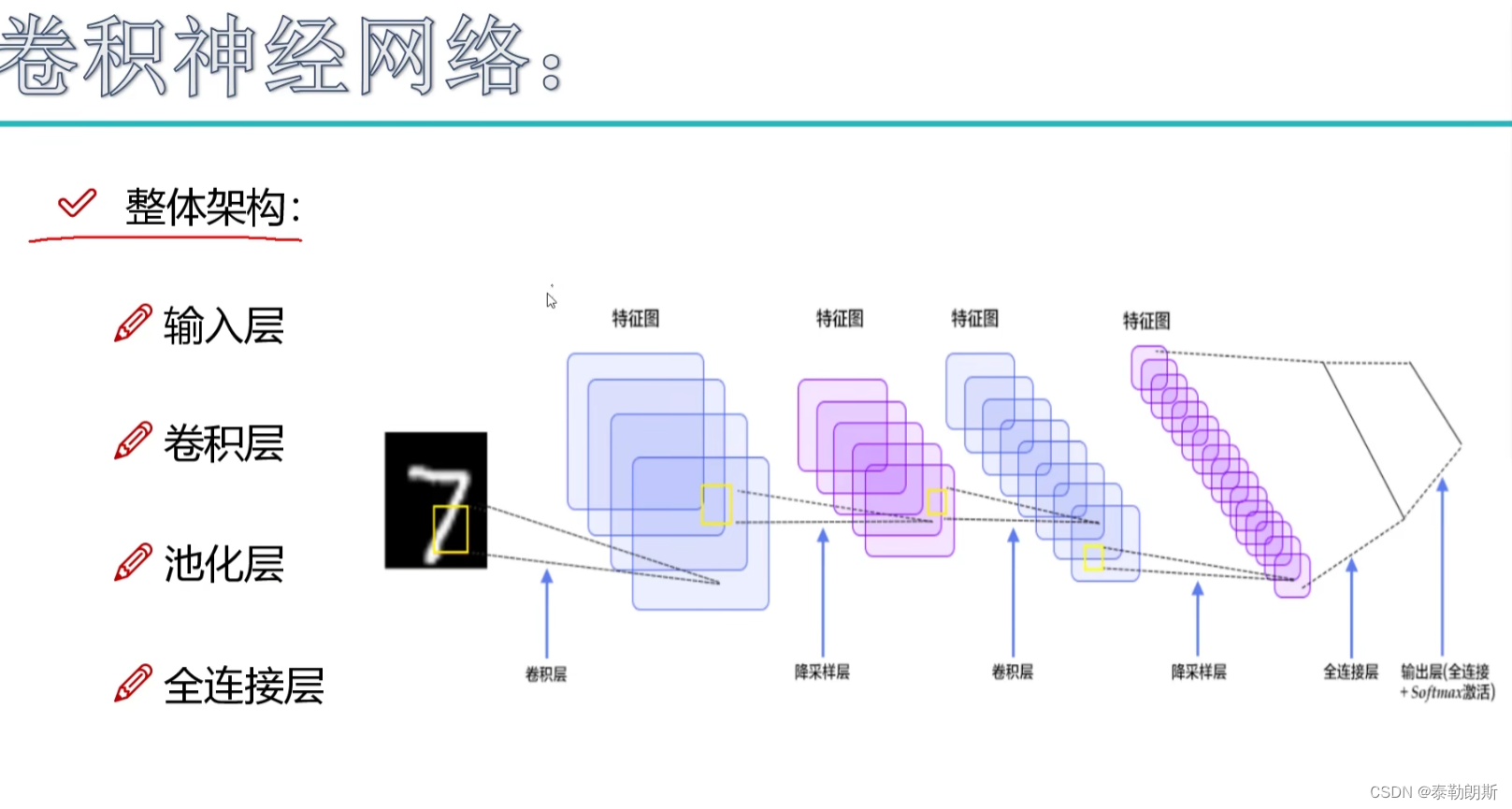

7.卷积神经网络

下面注意全连接层,全连接就是全部链接的层

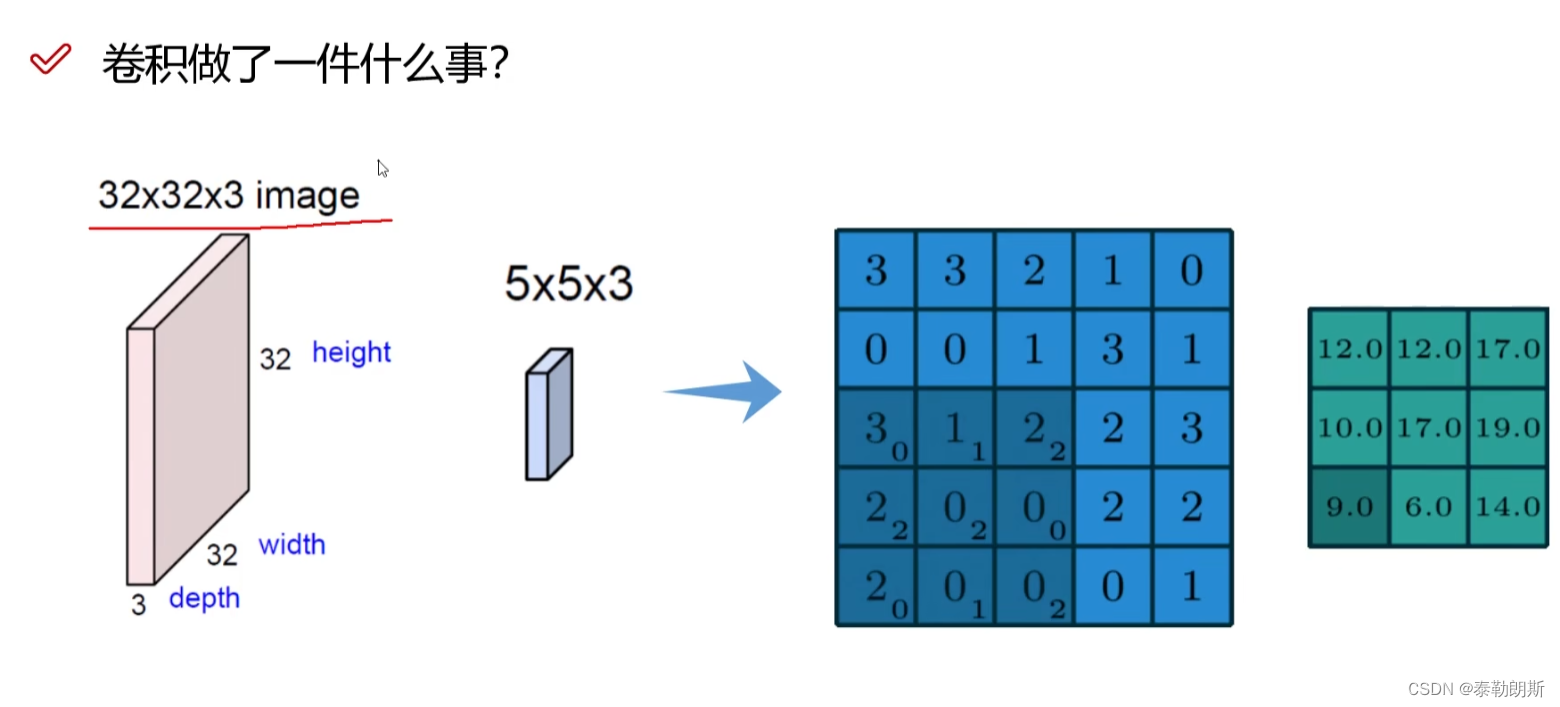

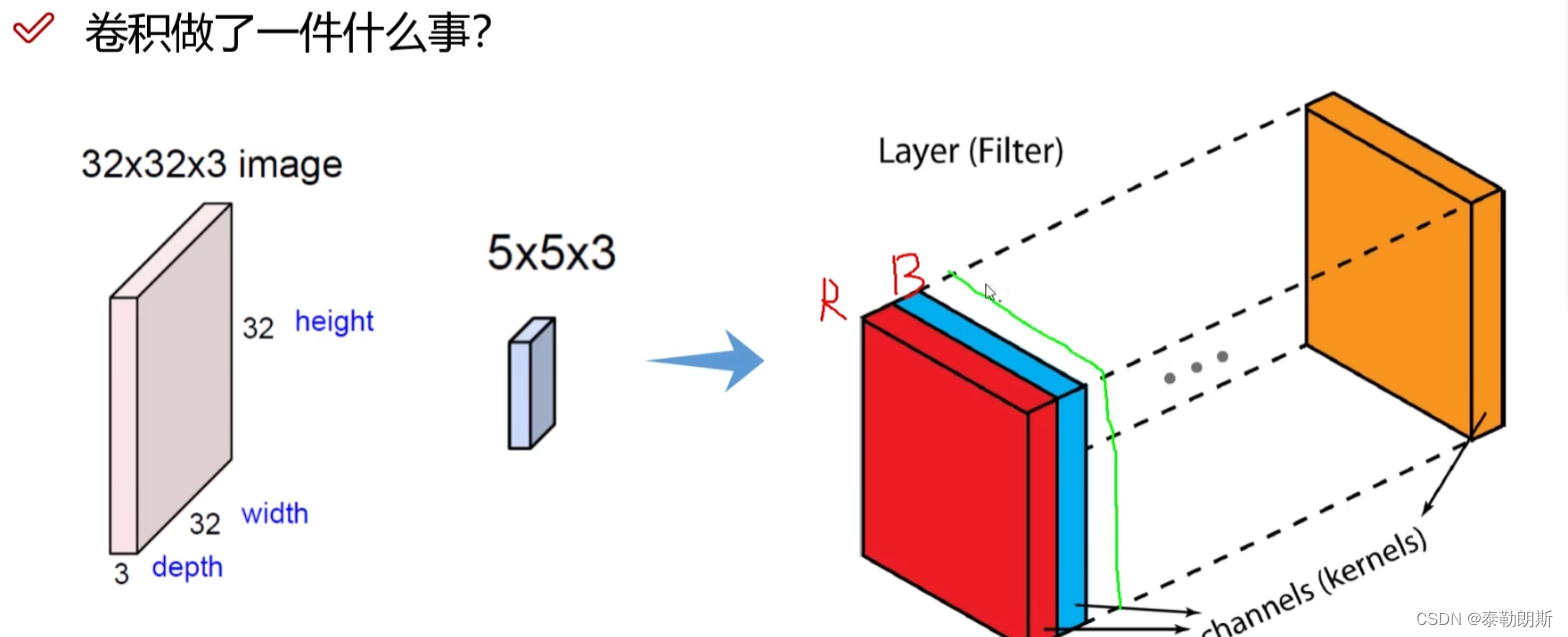

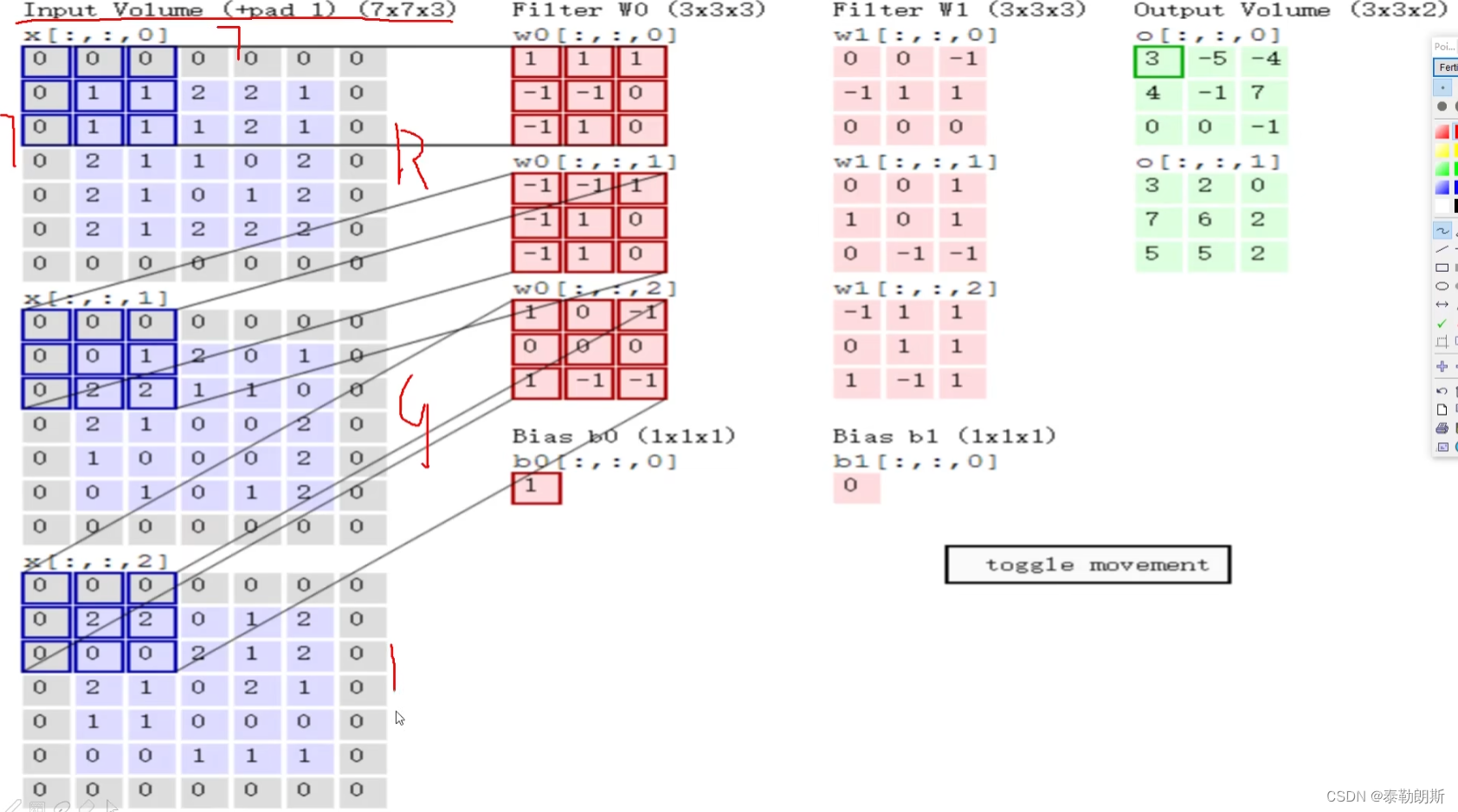

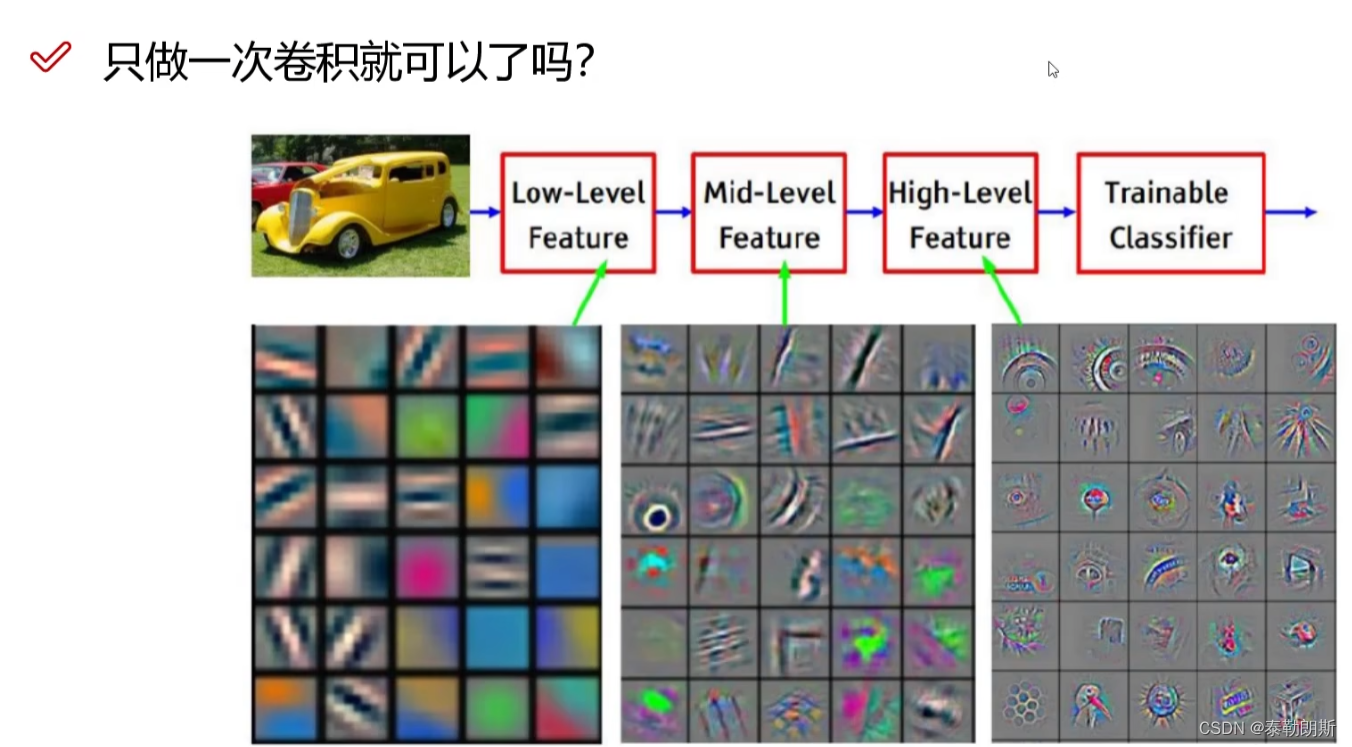

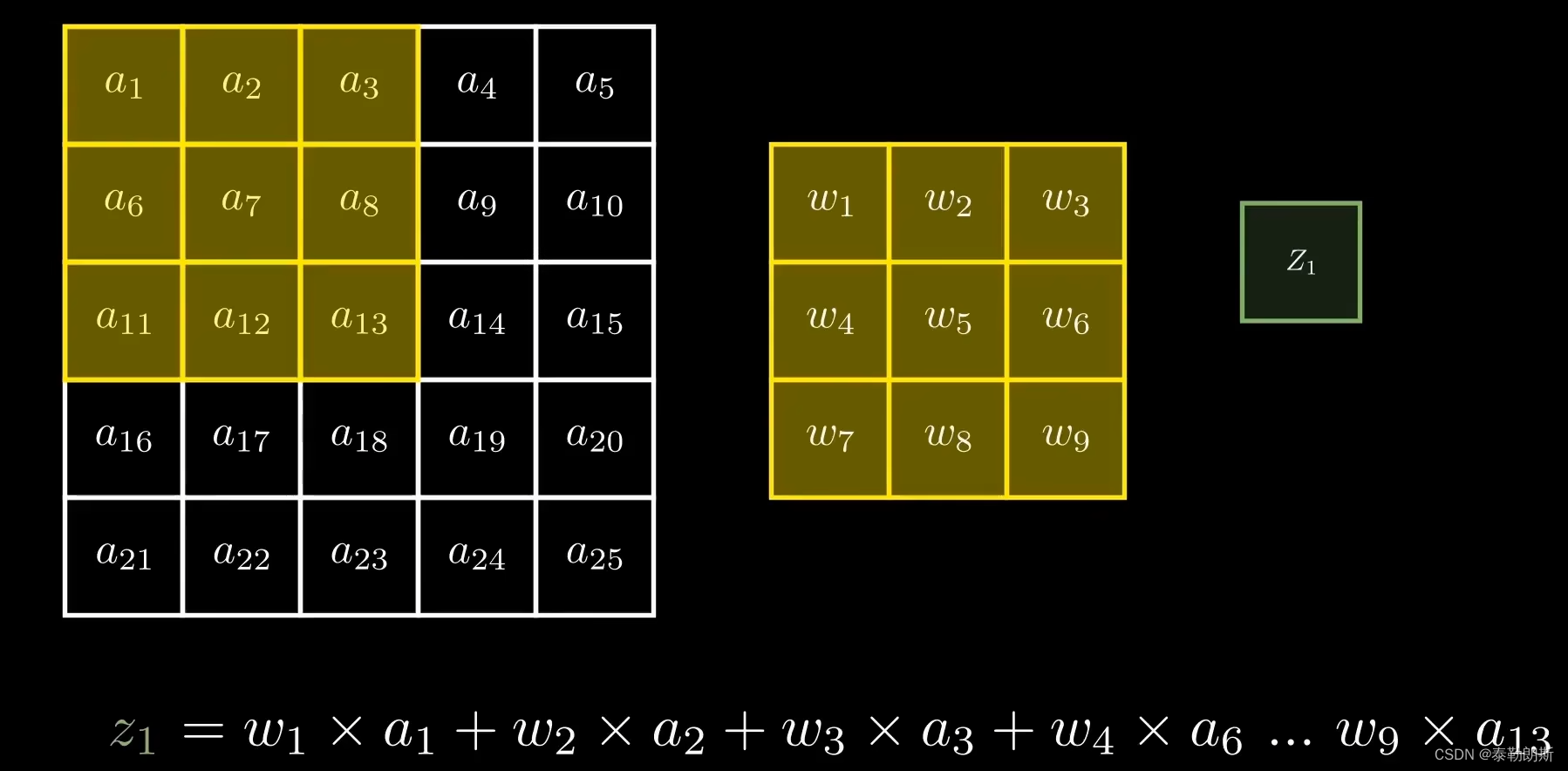

1.卷积做了什么?

卷积做特征提取

不要忘了偏置项1

需要做多次卷积

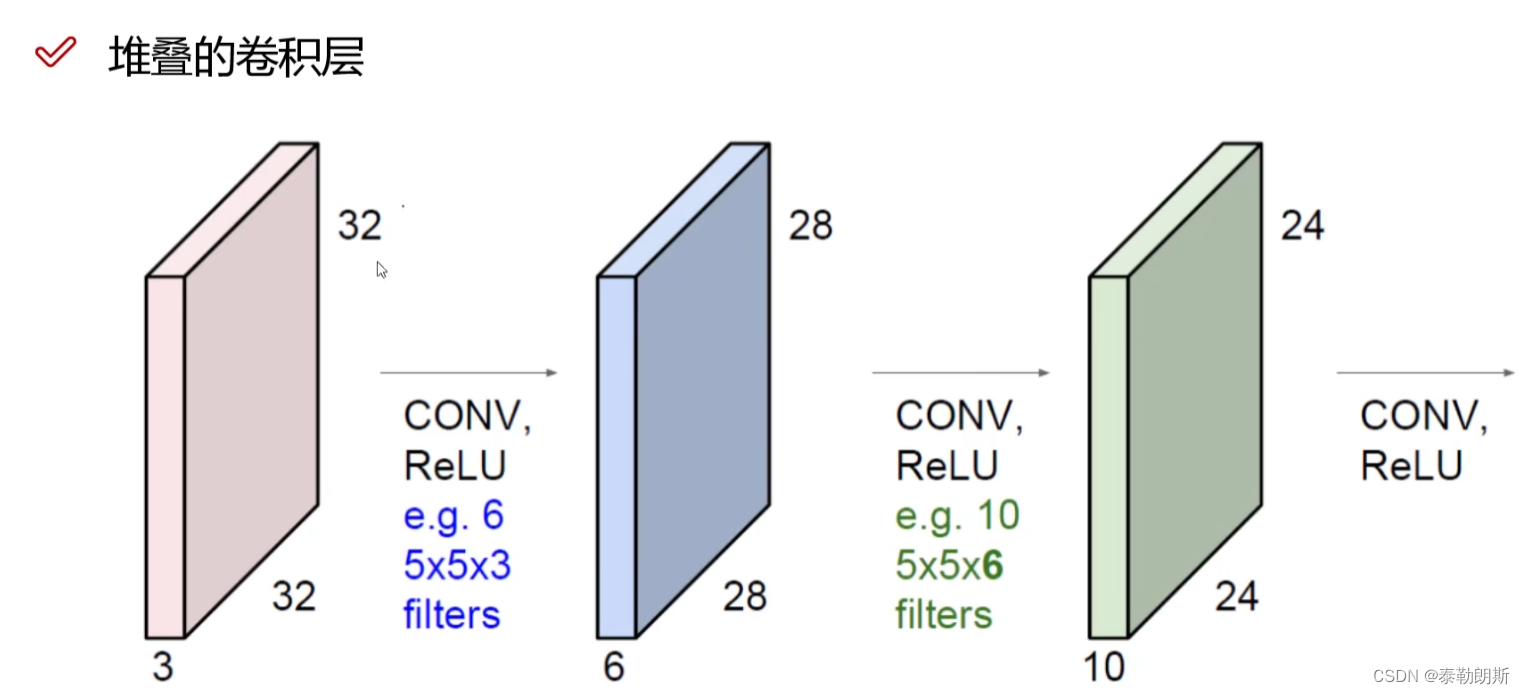

堆叠的卷积

常规卷积网络

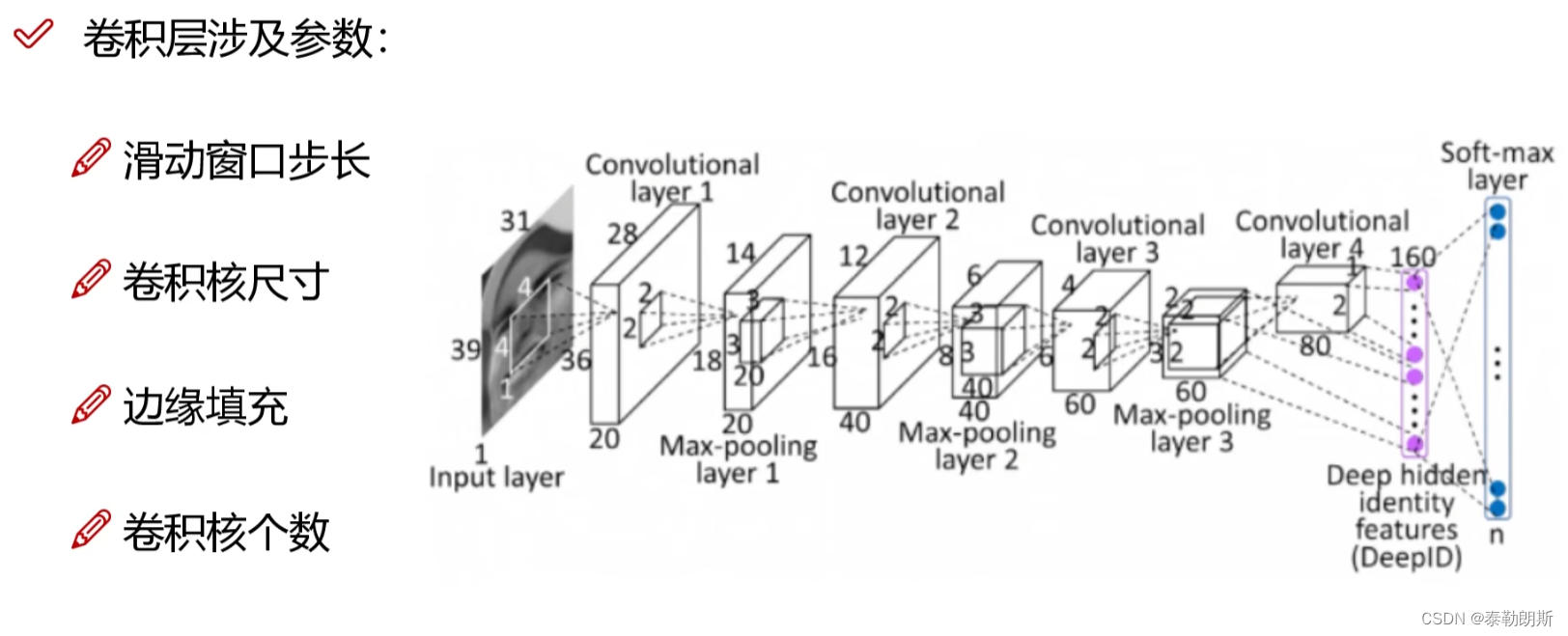

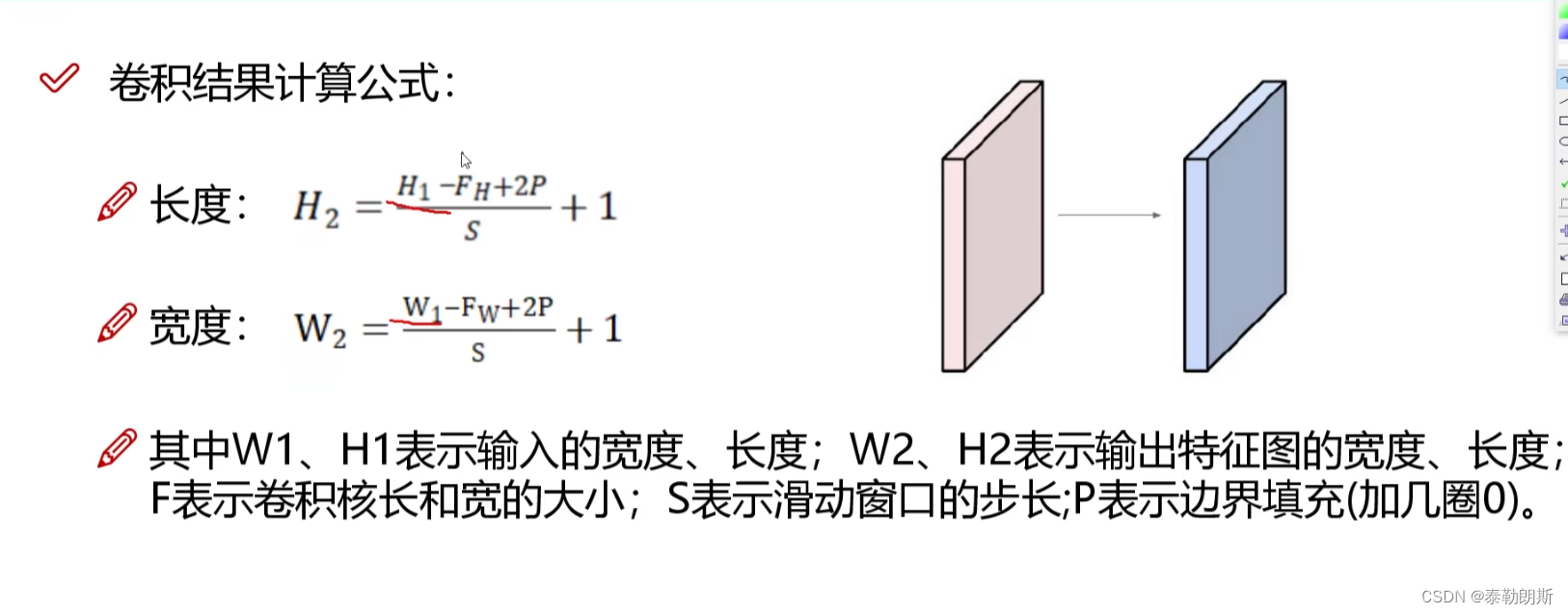

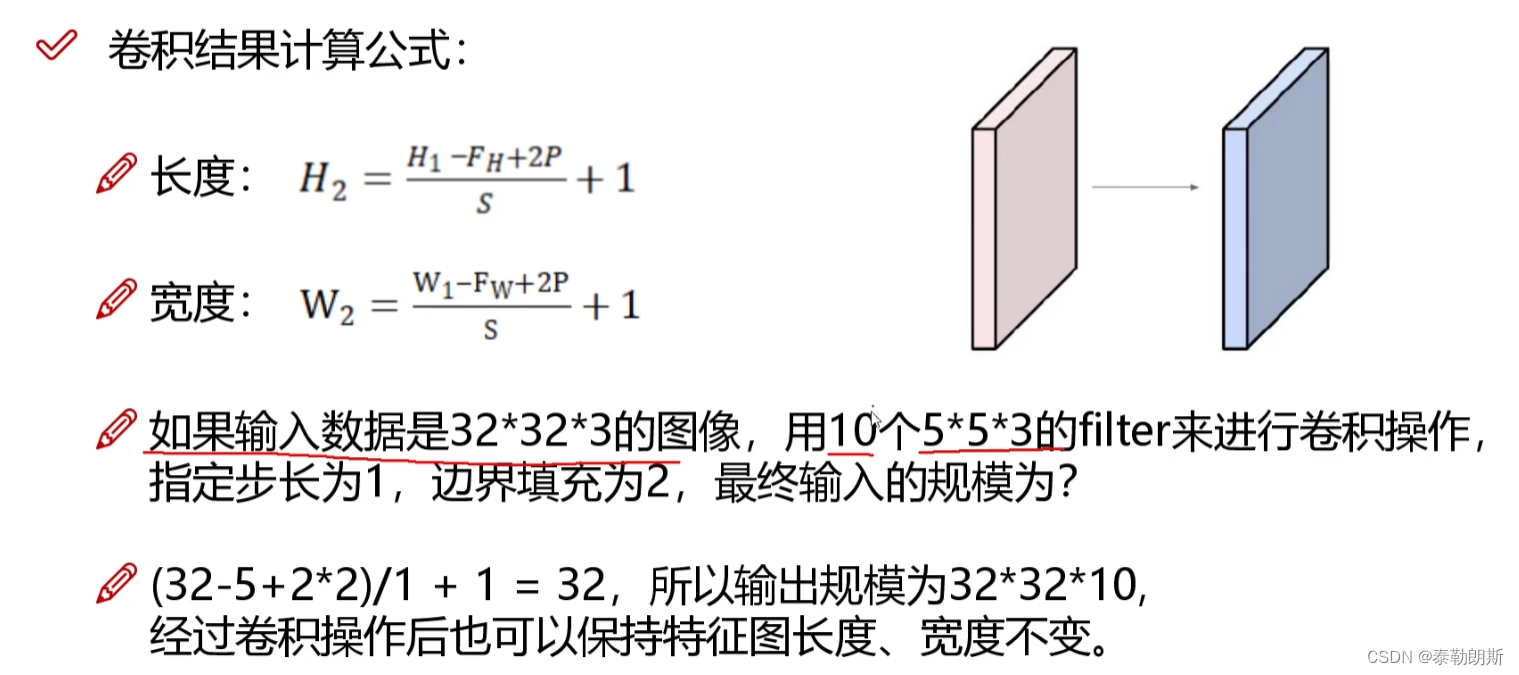

卷积计算结果

计算案例

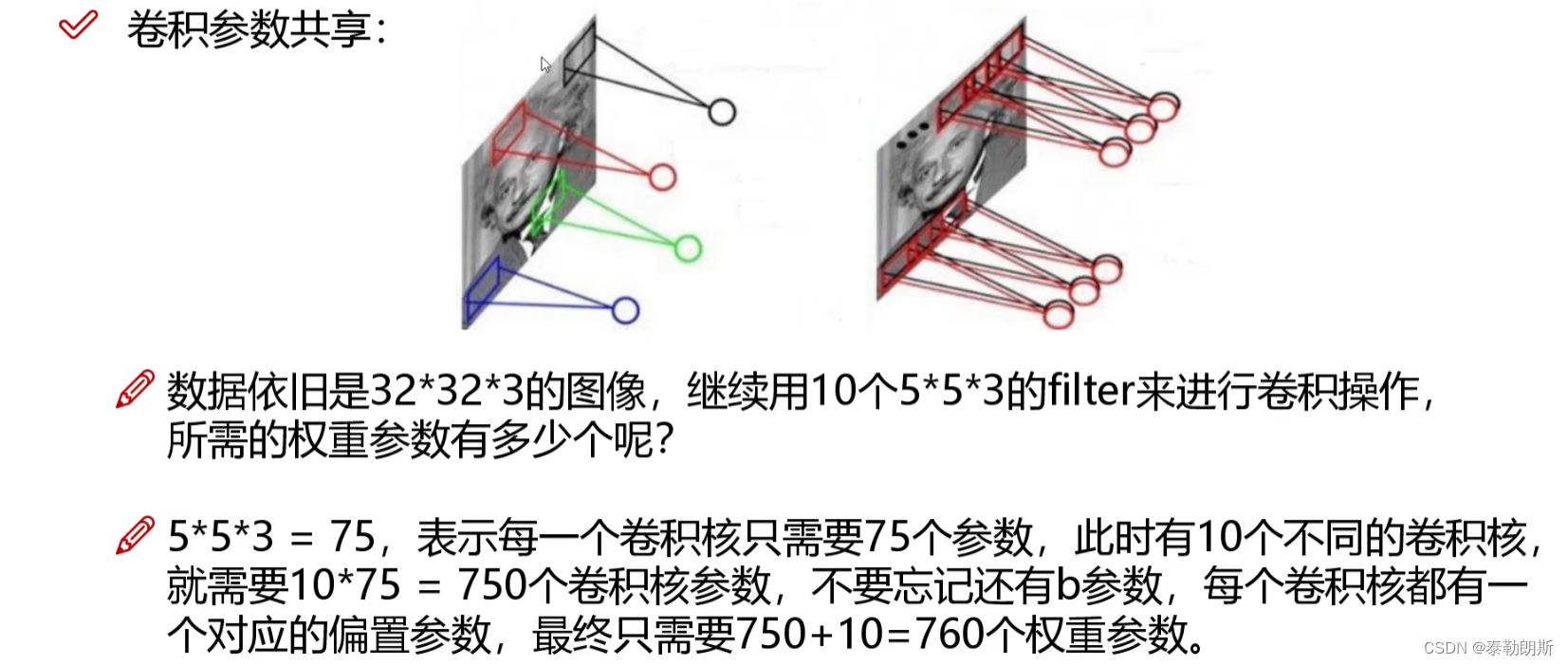

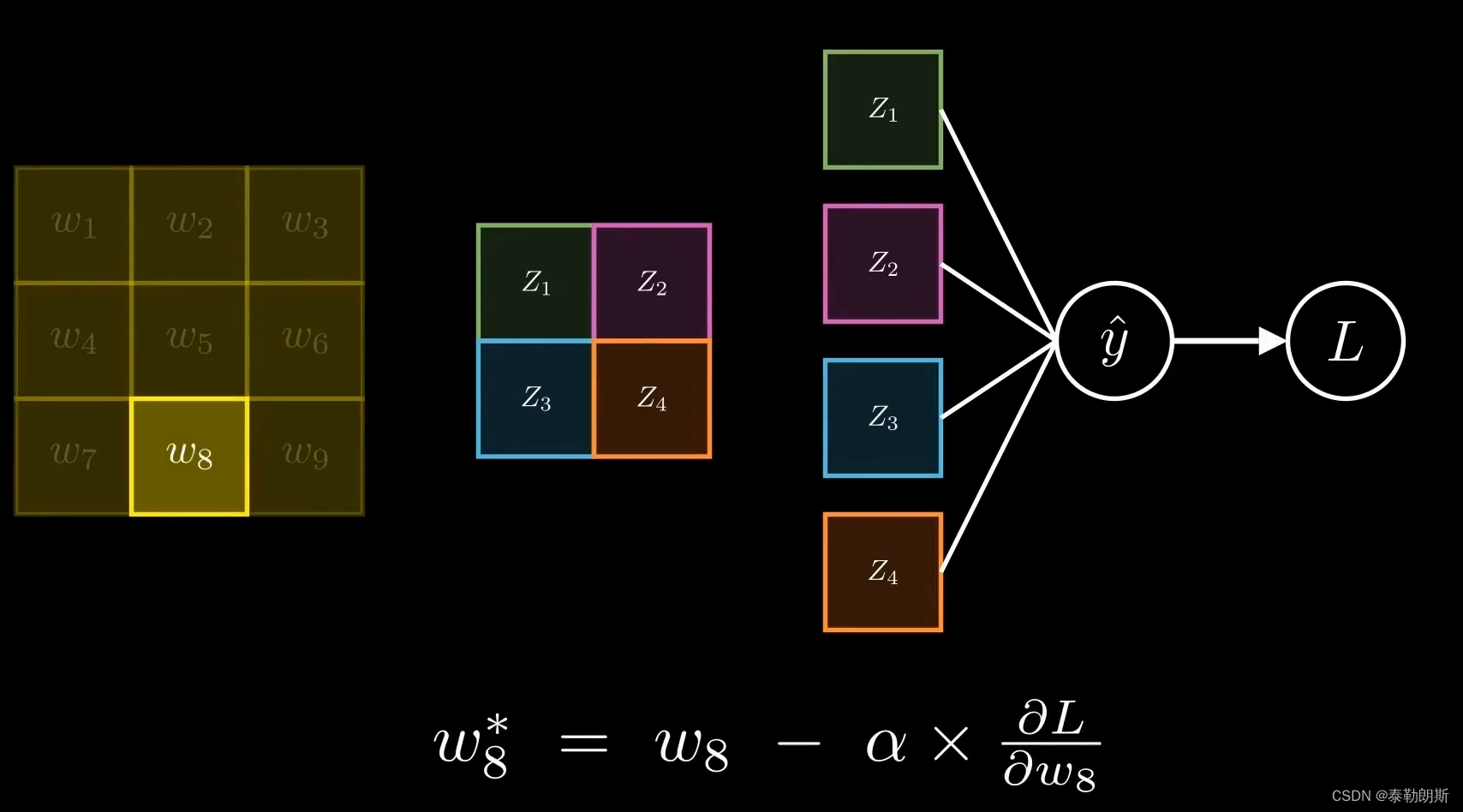

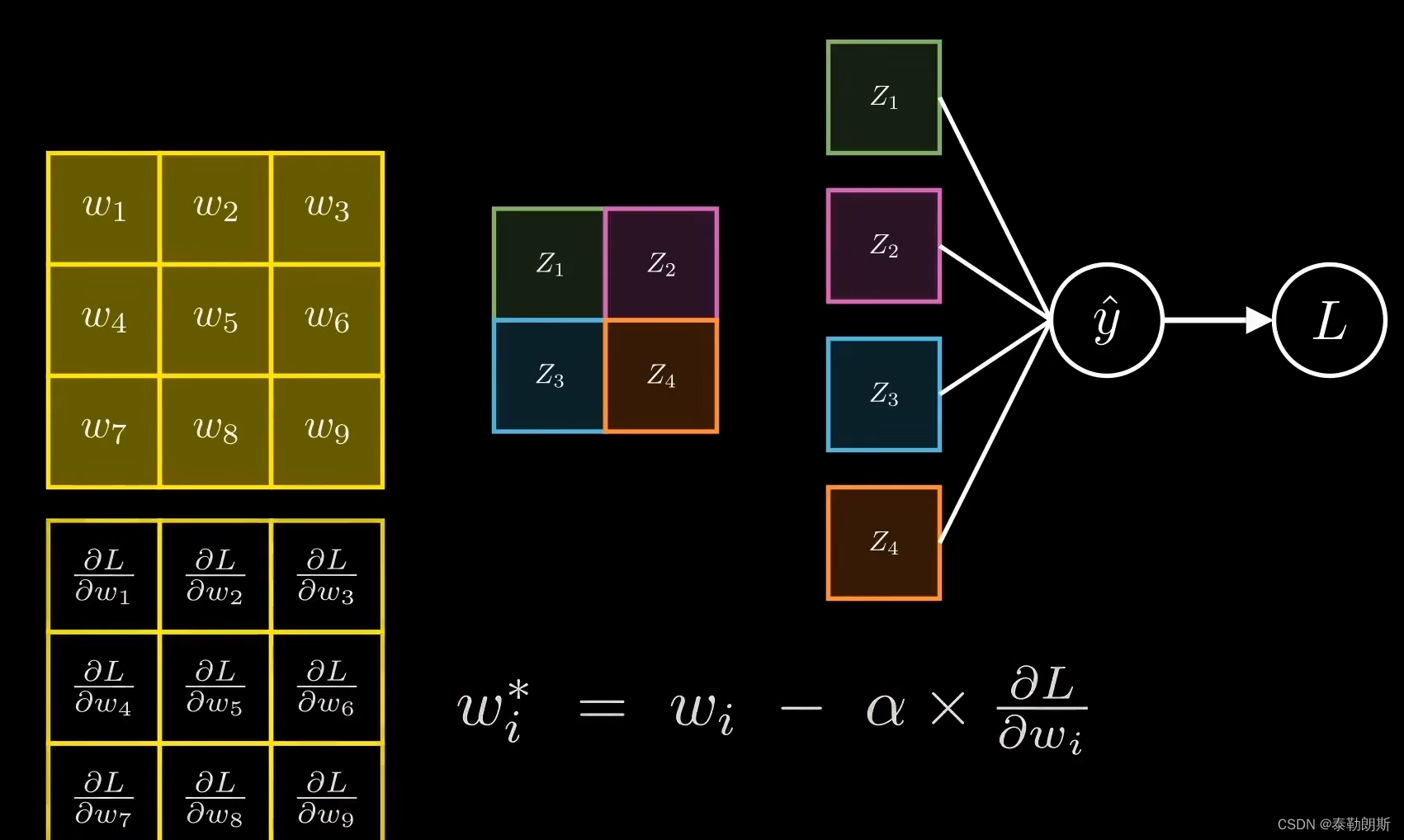

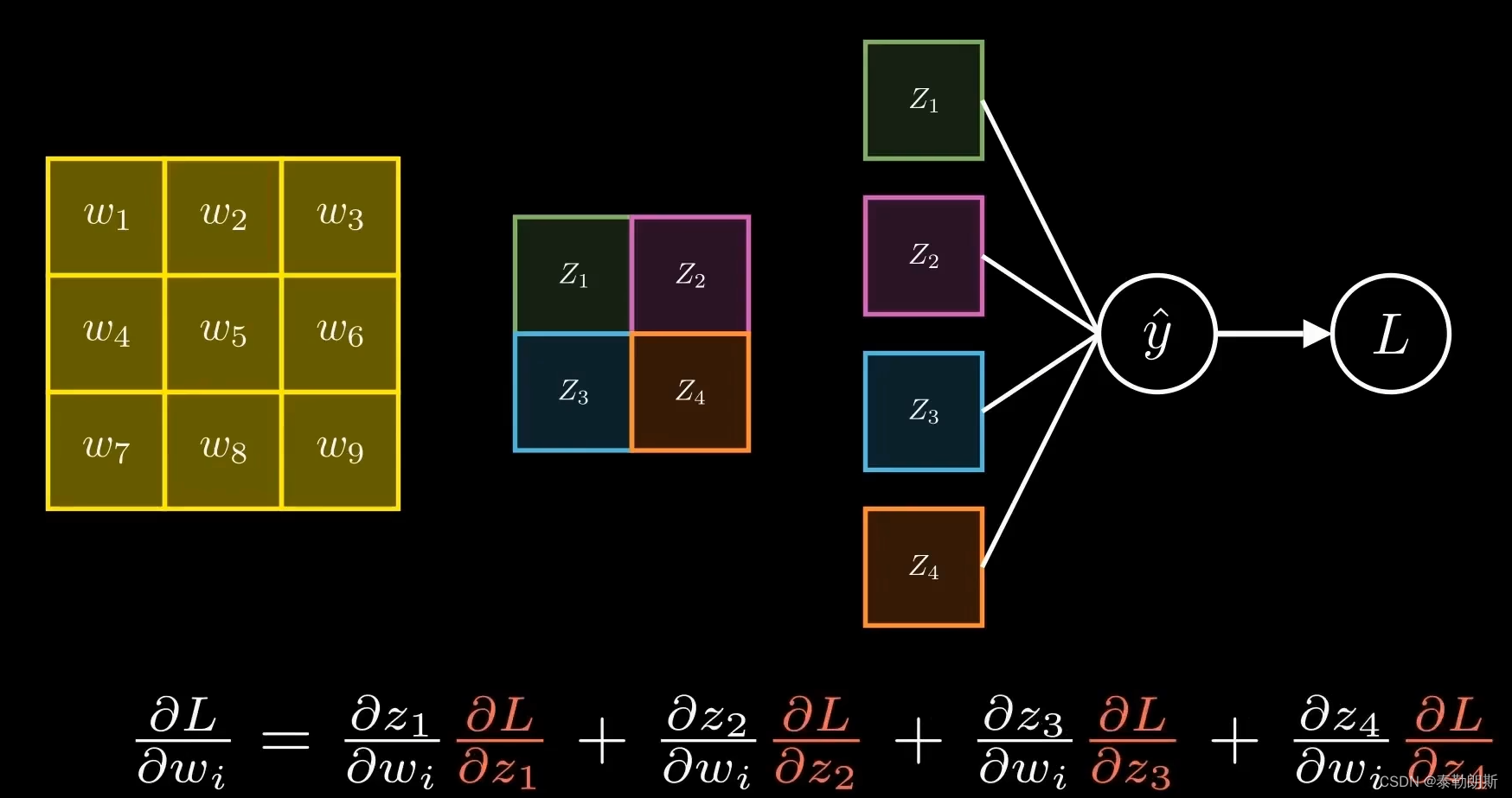

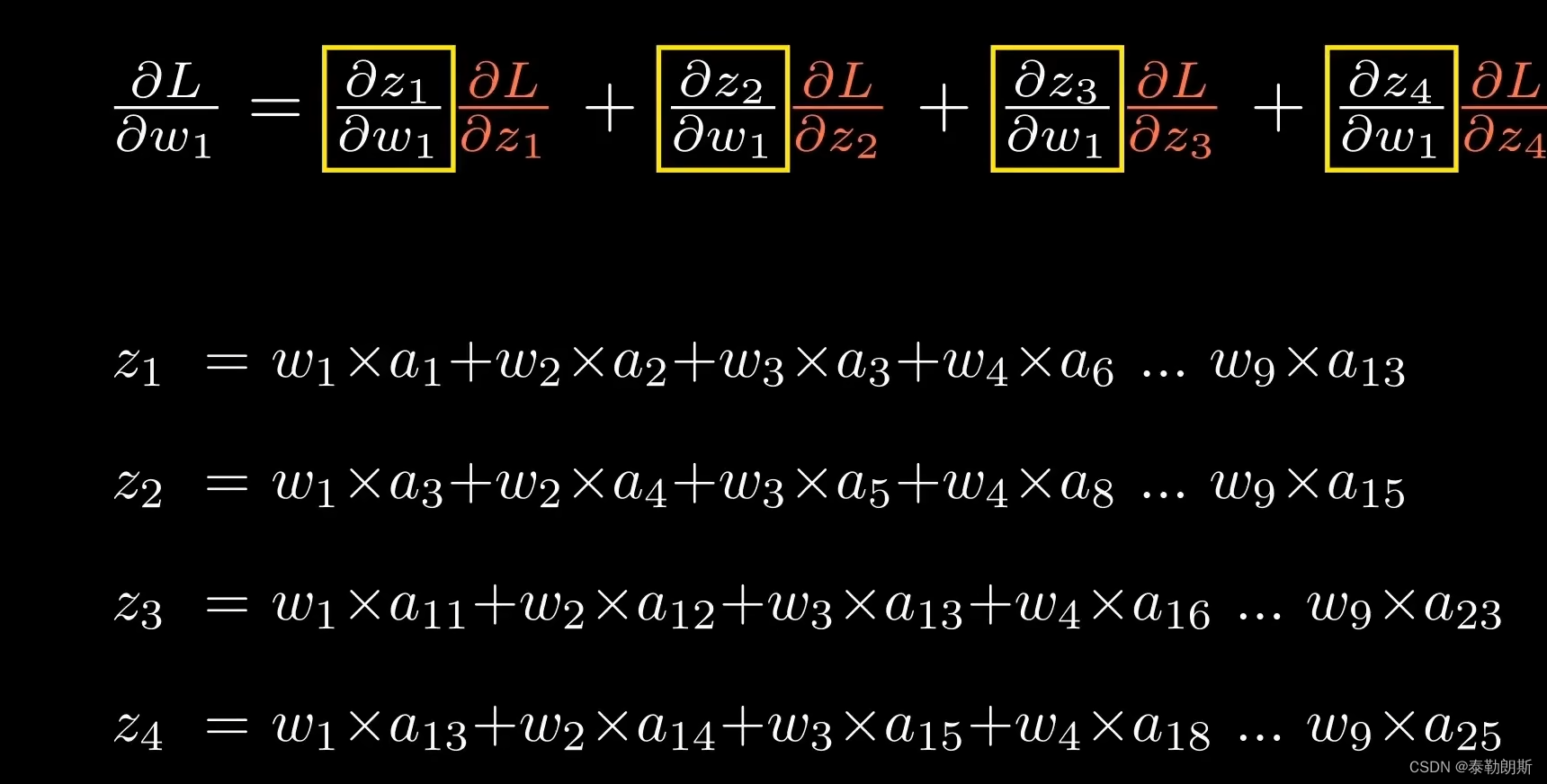

卷积参数共享

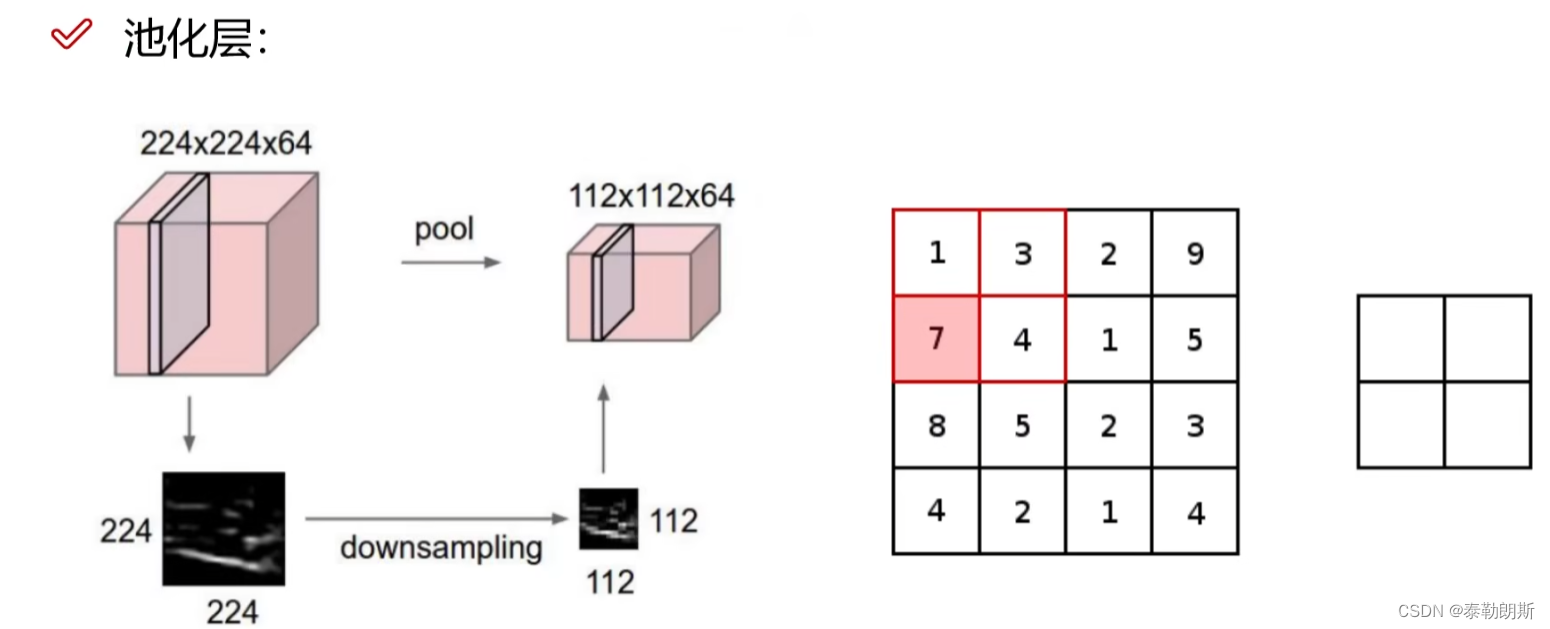

池化层,下采样

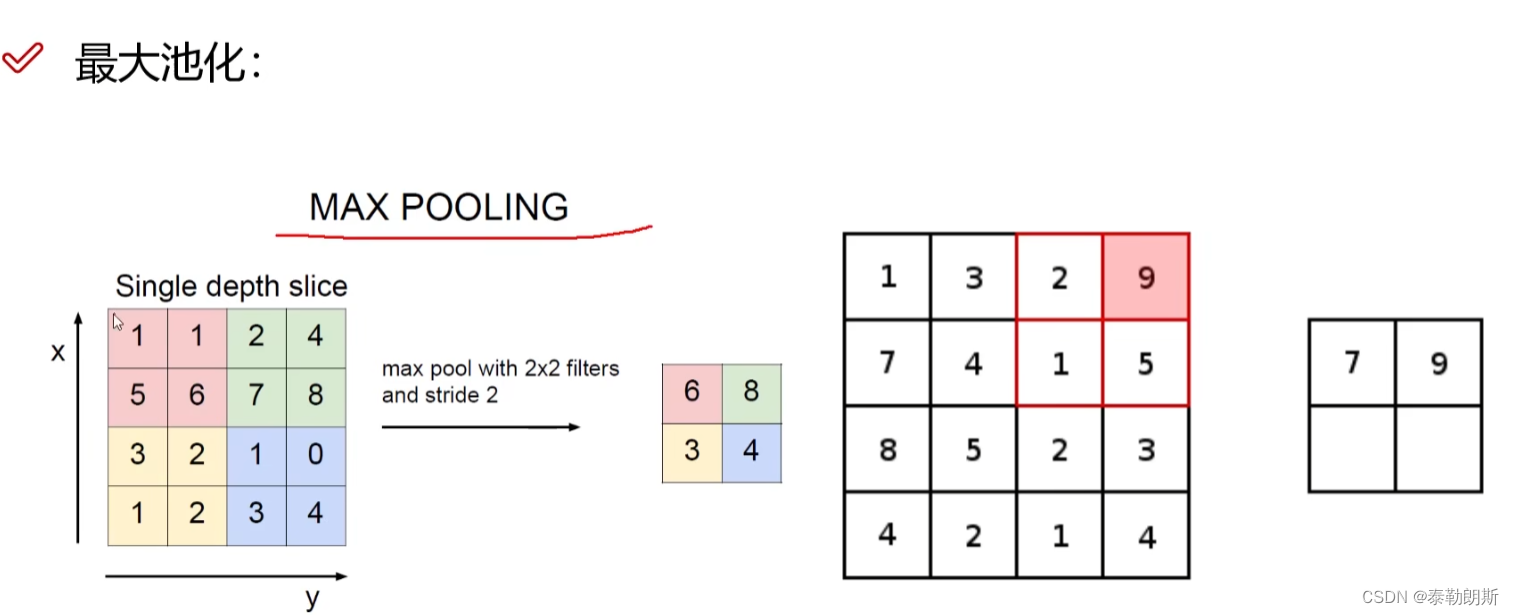

最大池化

有多少层,7层。

想要得到结果,还是要全连接层,

需要把323210拉成一维向量,110240,拉长操作其实还是卷积,比如323210拉长,那么就需要32321010240个权重

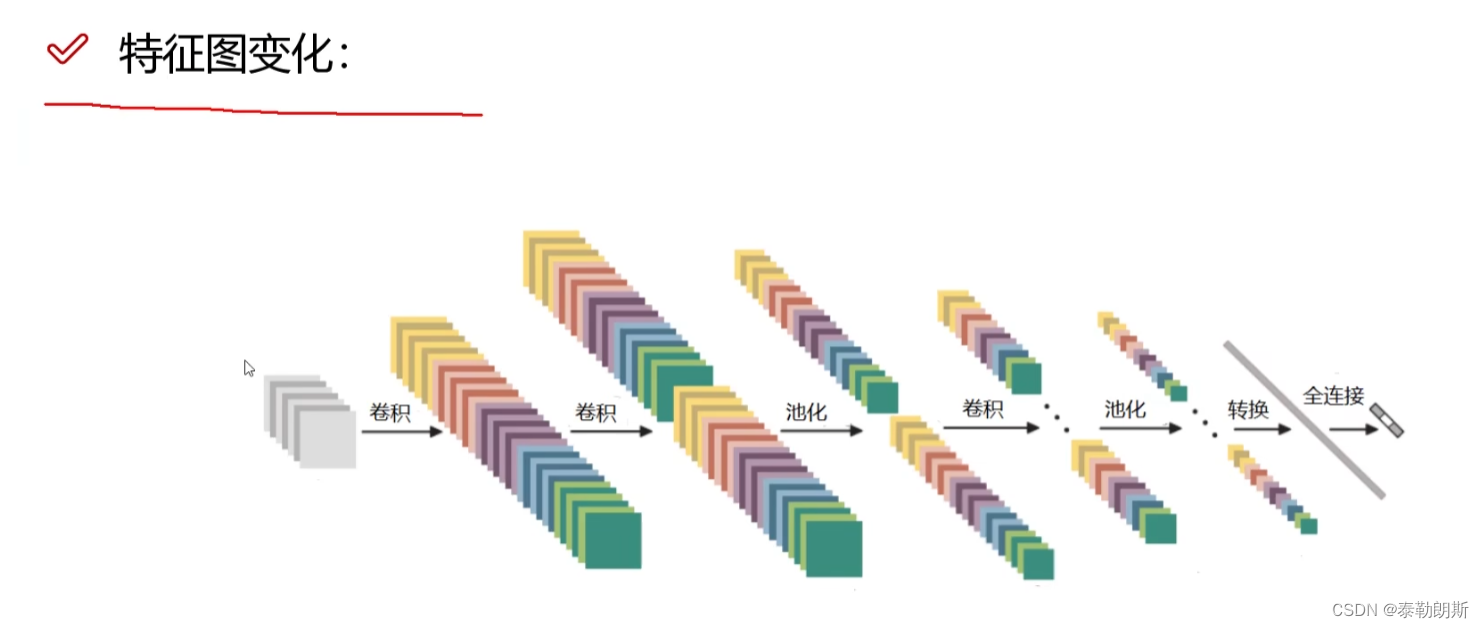

特征图变换

2.节点网络

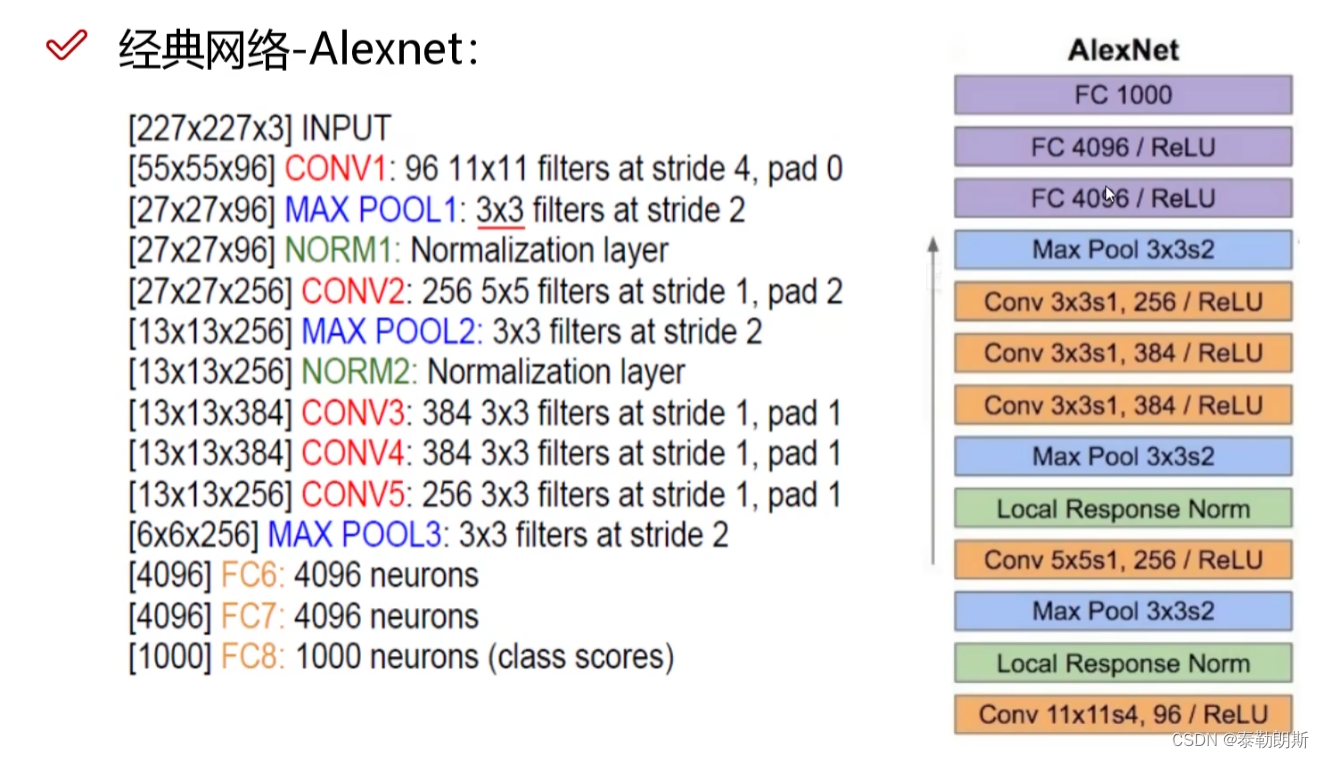

1.Alexnet

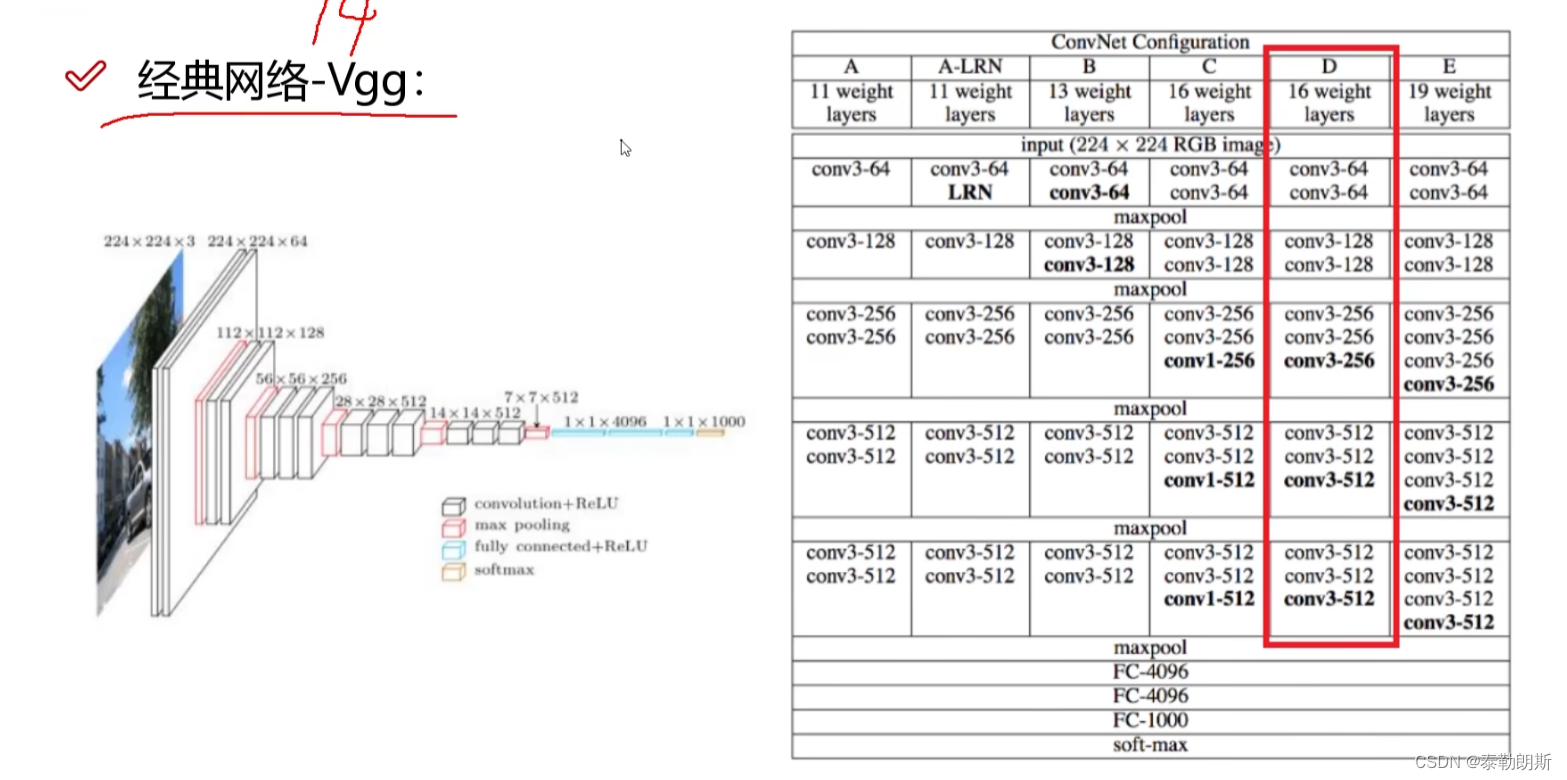

2.Vgg

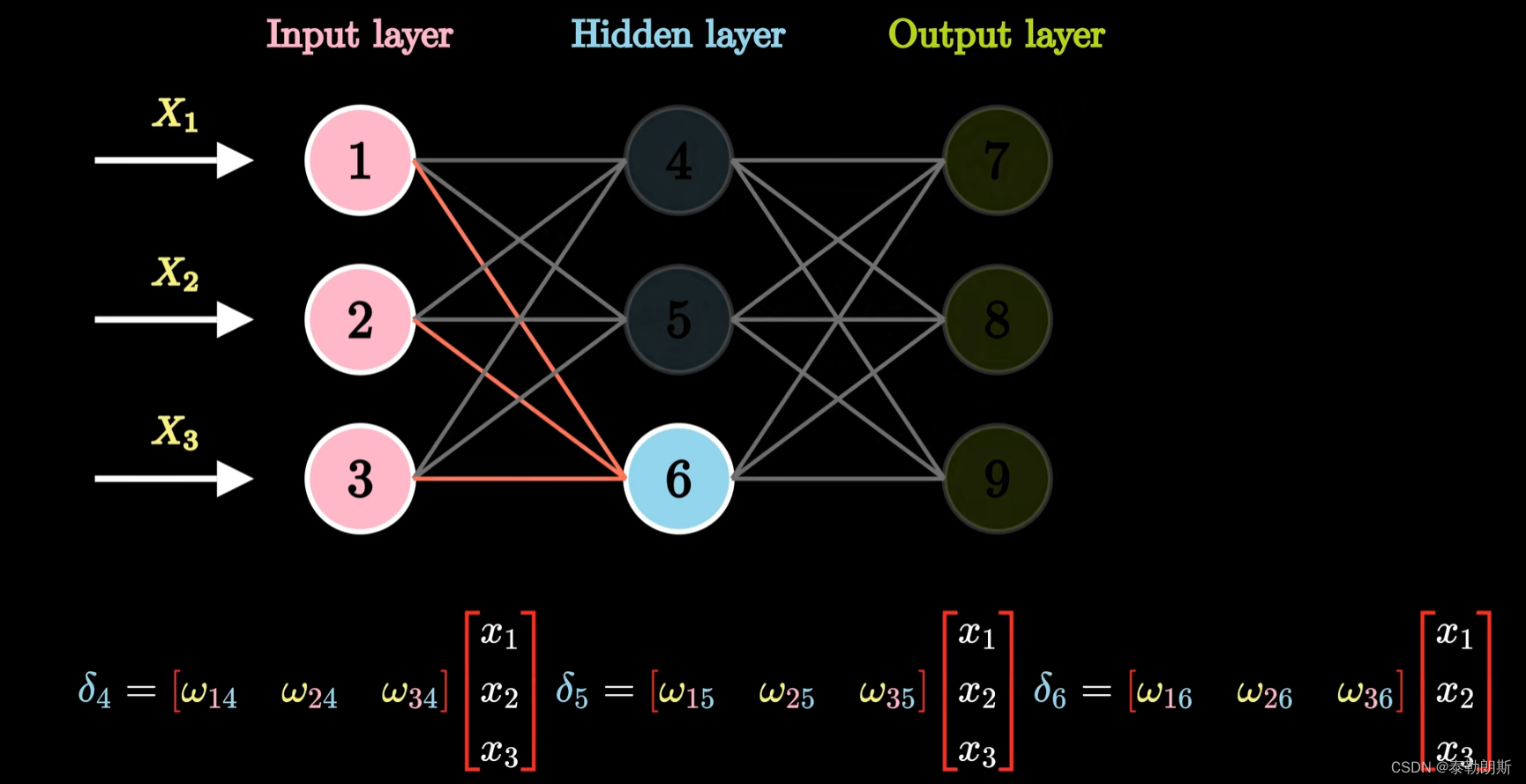

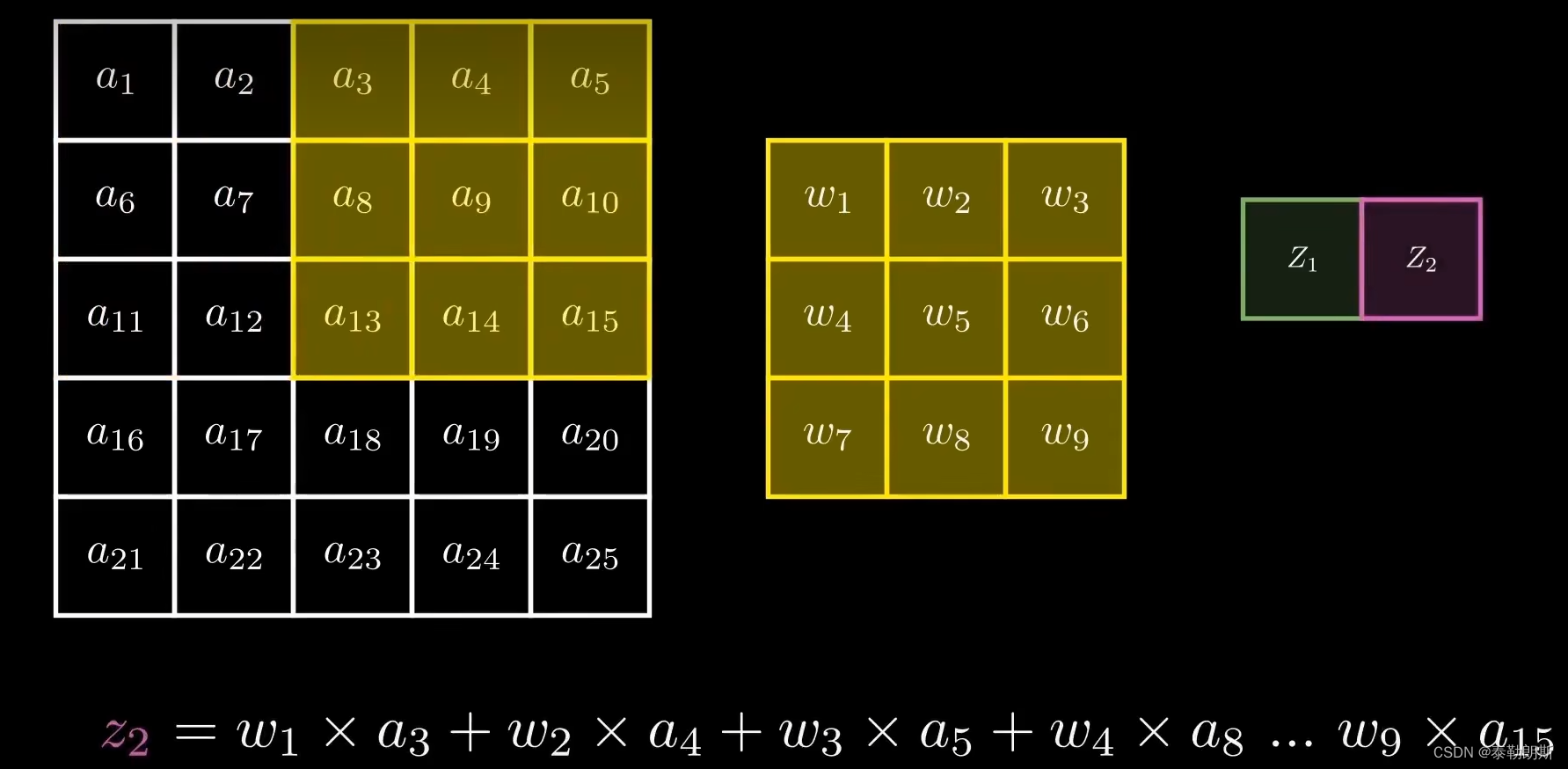

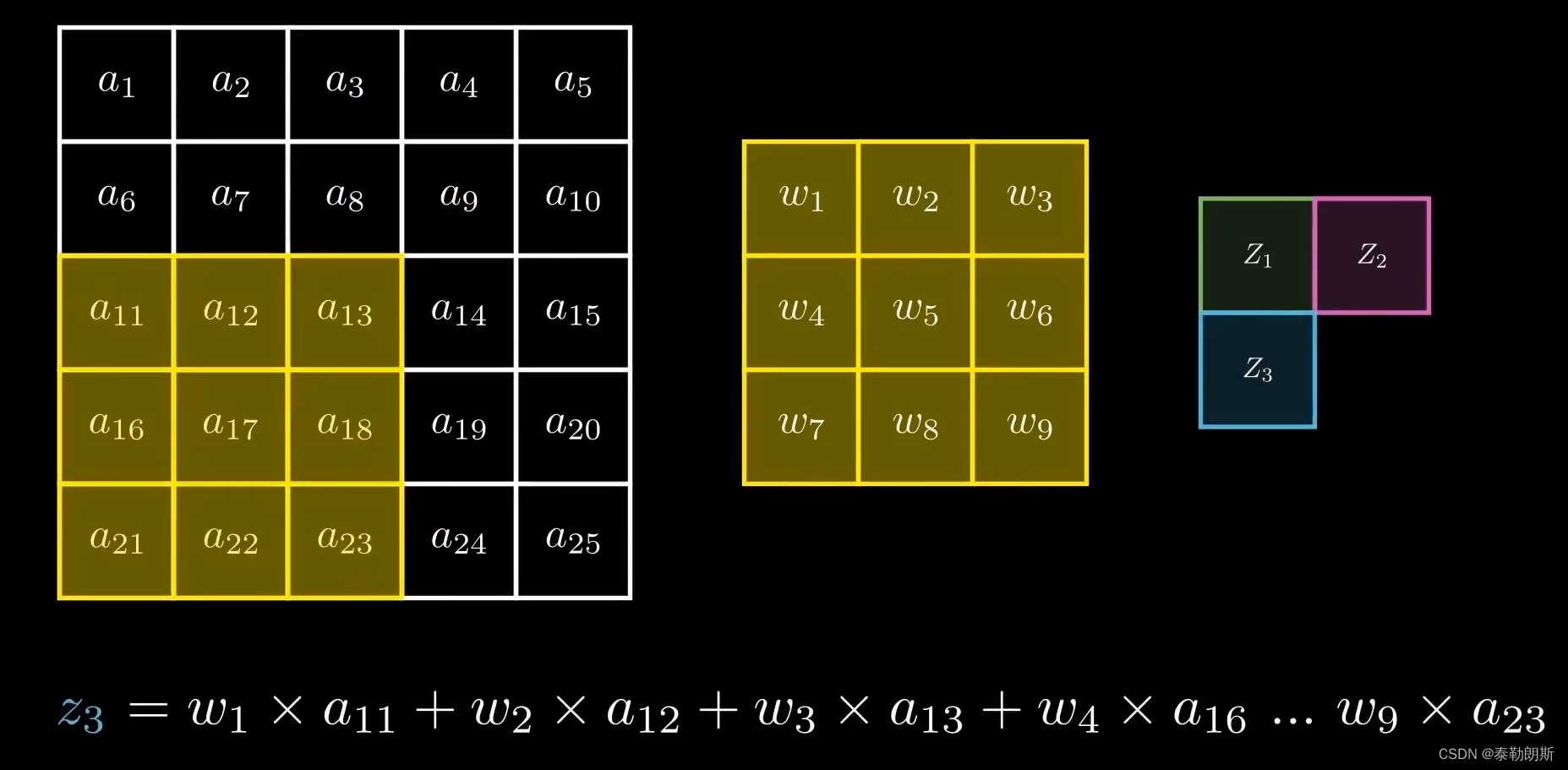

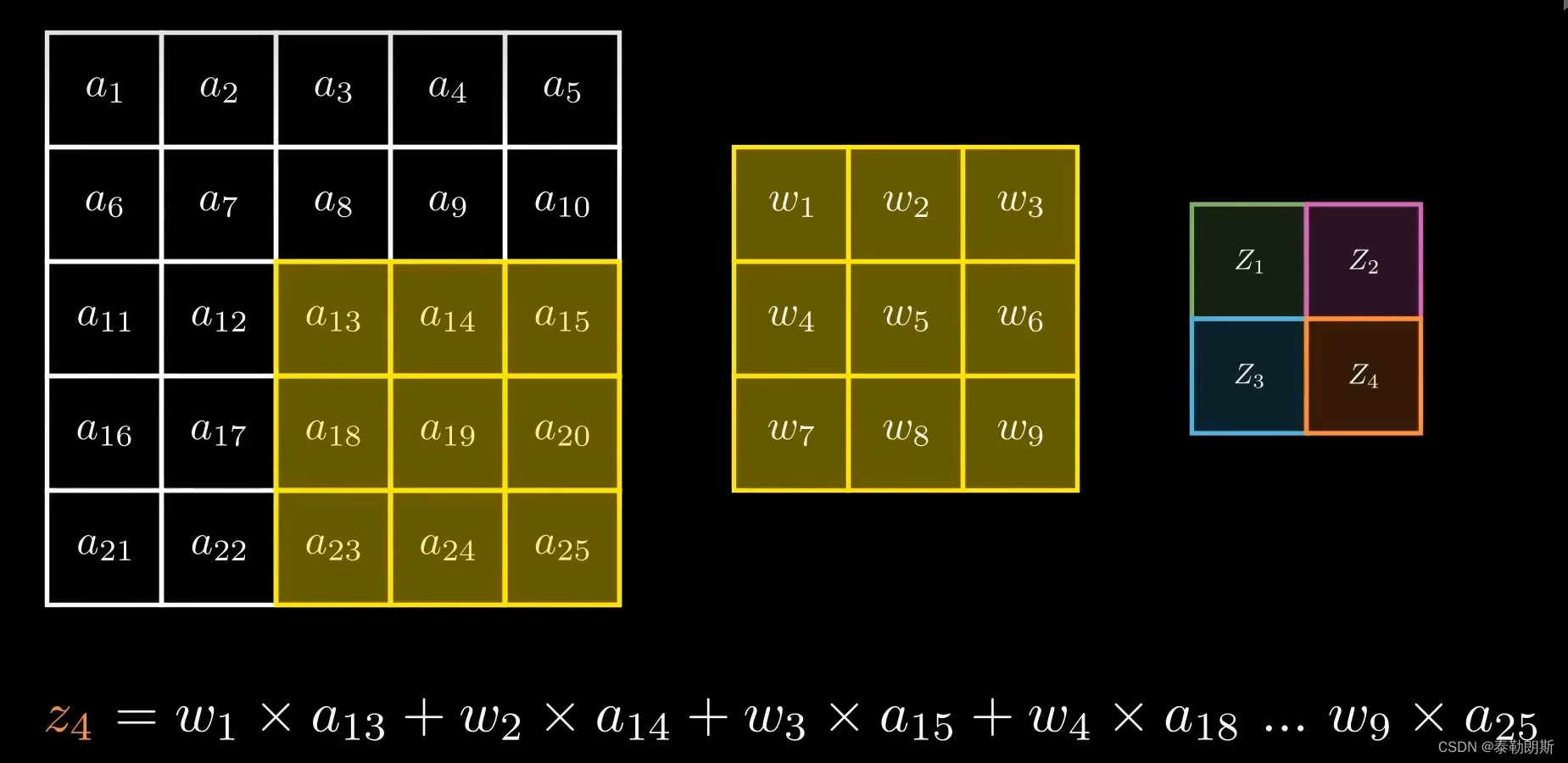

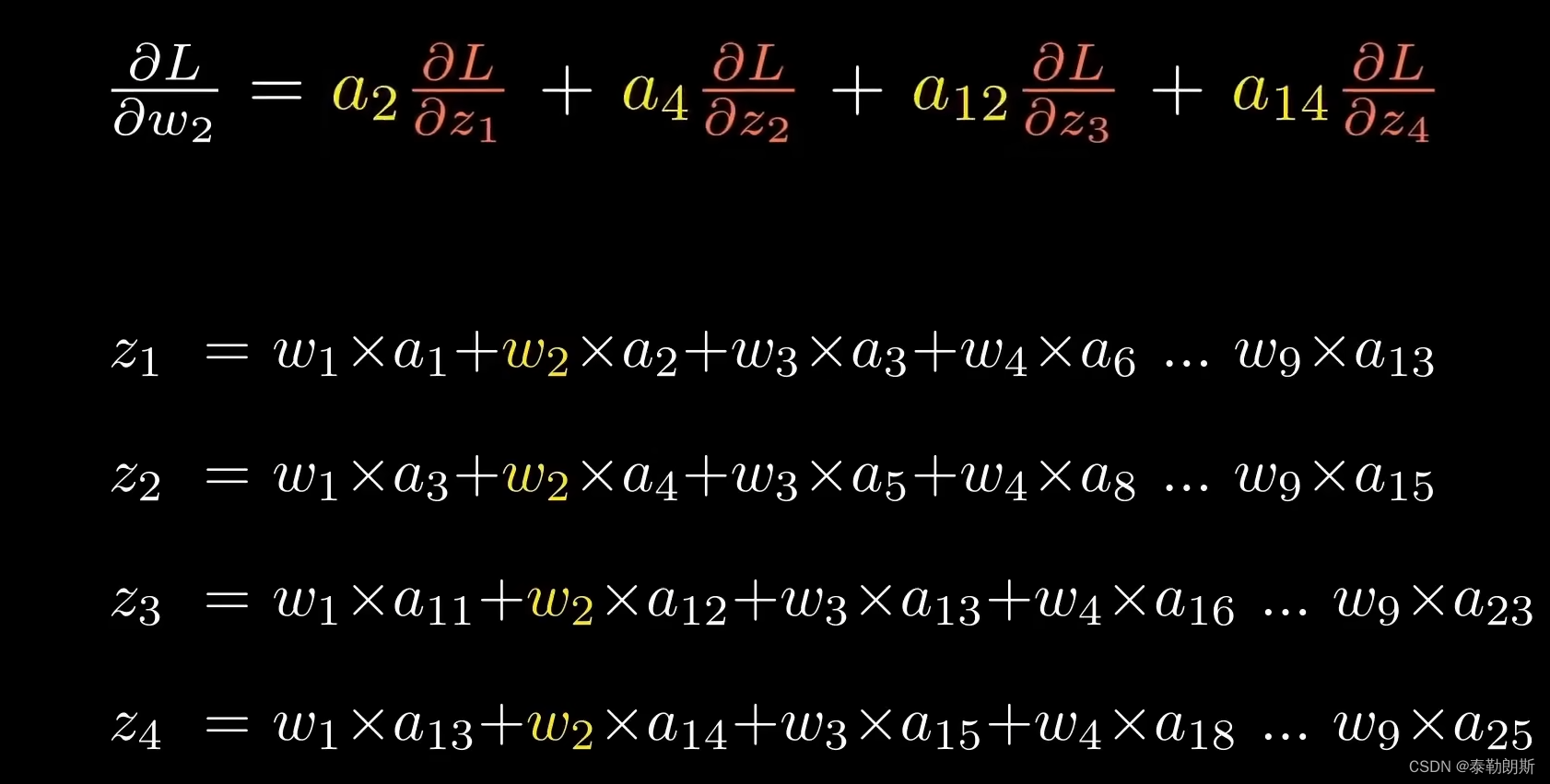

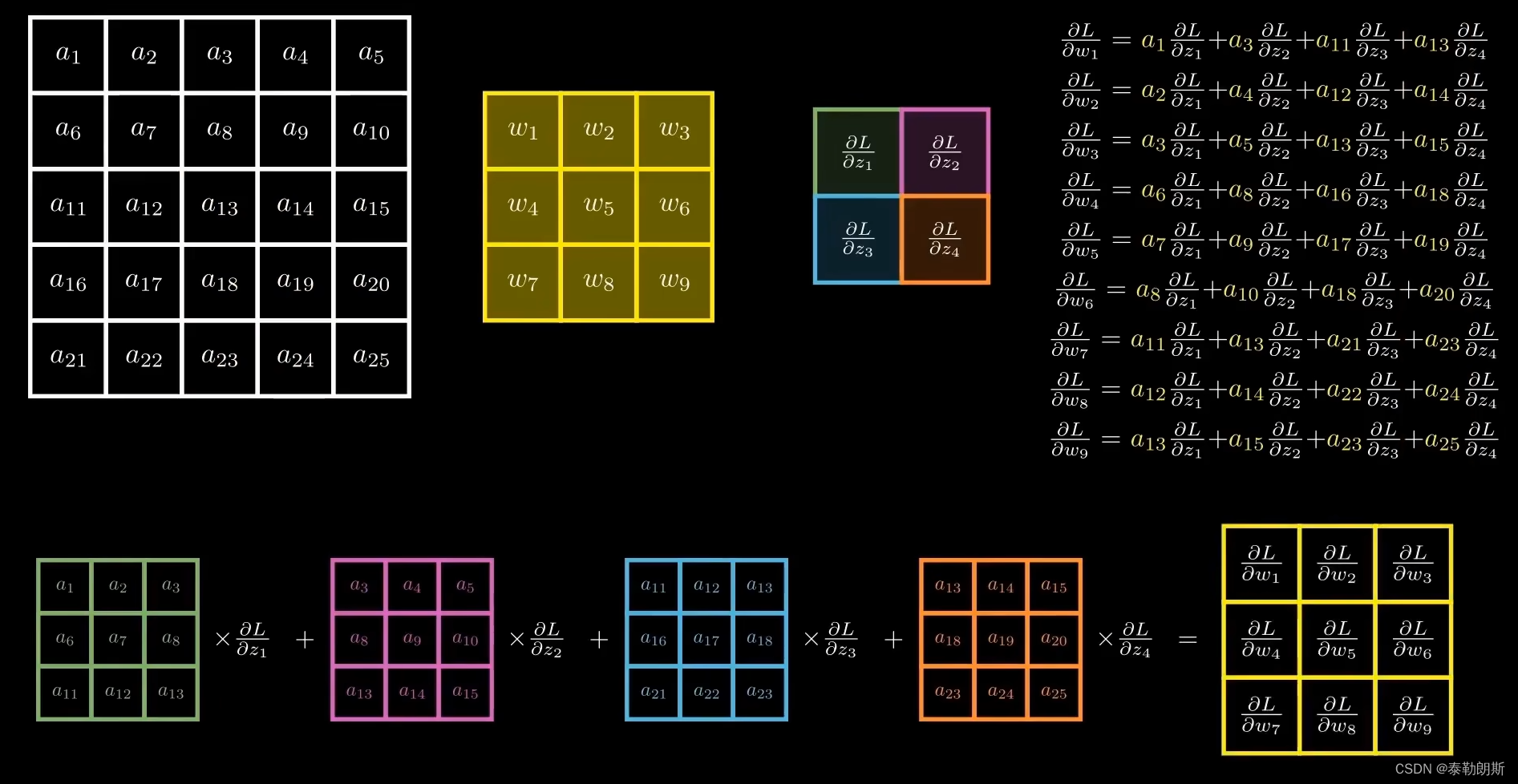

2.卷积网络反向传播详细介绍

相比传统神经网络,卷积神经网络,特征图就是卷积核了

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)