配置ollama使用GPU

本文介绍了在Windows系统上配置Ollama使用GPU加速的步骤

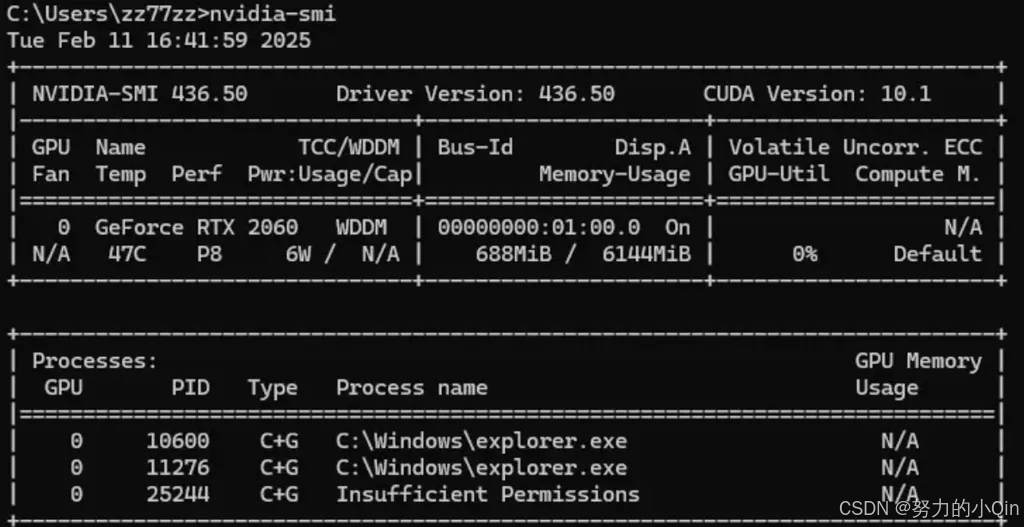

第一步:查看自己显卡是否支持

第二步:查看本机显卡参数

命令:nvidia-smi

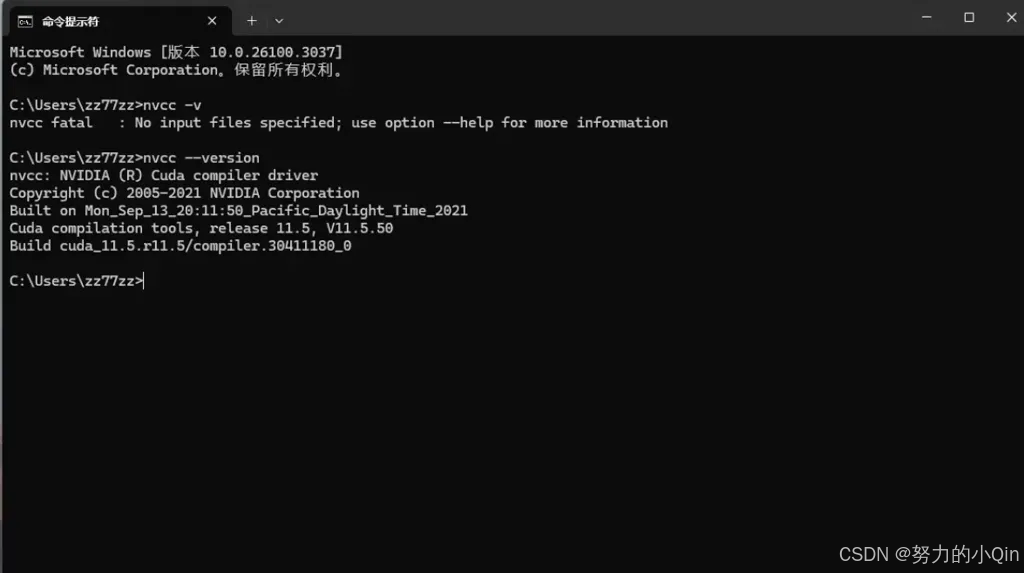

第三步:安装cuda toolkit

cuda toolkit下载地址:https://developer.nvidia.com/cuda-toolkit-archive

请记住流程安装选local而非network

安装完后验证是否安装成功,命令:nvcc --version

第四步:设置ollama 环境变量

● 添加以下环境变量:

○ 变量名:OLLAMA_GPU_LAYER

○ 变量值:cuda

● 指定特定的 GPU,可以添加以下环境变量:

○ 变量名:CUDA_VISIBLE_DEVICES

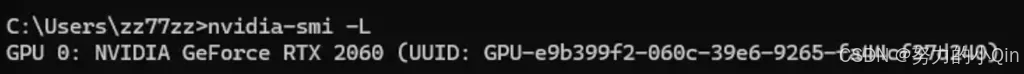

○ 变量值:GPU的UUID(方法如下)

GPU的UUID查看命令: nvidia-smi -L

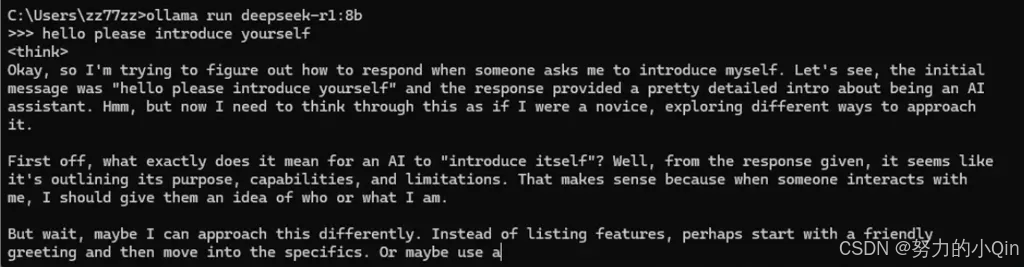

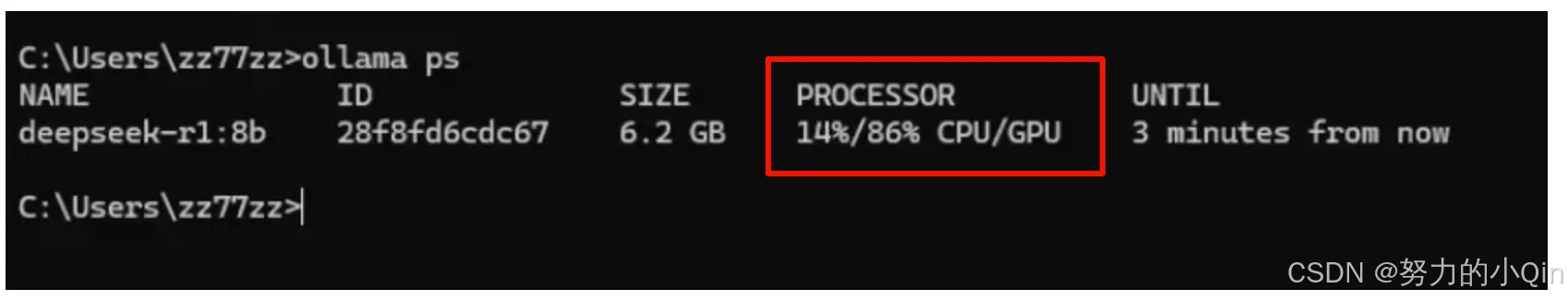

第五步:验证是否使用gpu

运行大模型

然后再起一个命令行 输入 ollama ps 就可以看到 processor里面有cpu与gpu运行百分比

Ollama可配置环境变量

● OLLAMA_DEBUG: 显示额外的调试信息(例如:OLLAMA_DEBUG=1)。

● OLLAMA_HOST: Ollama 服务器的 IP 地址(默认值:127.0.0.1:11434)。

● OLLAMA_KEEP_ALIVE: 模型在内存中保持加载的时长(默认值:“5m”),设置为-1表示常驻内存运行。

● OLLAMA_MAX_LOADED_MODELS: 每个 GPU 上最大加载模型数量。

● OLLAMA_MAX_QUEUE: 请求队列的最大长度。

● OLLAMA_MODELS: 模型目录的路径。

● OLLAMA_NUM_PARALLEL: 最大并行请求数。

● OLLAMA_NOPRUNE: 启动时不修剪模型 blob。

● OLLAMA_ORIGINS: 允许的源列表,使用逗号分隔。

● OLLAMA_SCHED_SPREAD: 始终跨所有 GPU 调度模型。

● OLLAMA_TMPDIR: 临时文件的位置。

● OLLAMA_FLASH_ATTENTION: 启用 Flash Attention。

● OLLAMA_LLM_LIBRARY: 设置 LLM 库以绕过自动检测。

windows系统上设置直接在环境变量中设置即可。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)