告别Ollama,Java开发者专属LLM引擎来了

目前 Jlama 虽然提供的都是些小模型,适用于边缘设备应用场景 ,但 Jlama 让在 Java 生态中使用 LLM 变得更加简单和高效。无论是构建企业级应用还是开发创新项目,Jlama 都是一个值得关注的选择。

DeepSeek R1 集成难题完美解决:deepseek4j 已开源](https://mp.weixin.qq.com/s?__biz=MjM5MzEwODY4Mw==&mid=2257490224&idx=1&sn=83b6771bf276c82df1b90df0bbc4721b&scene=21#wechat_redirect)

DeepSeek R1 集成难题完美解决:deepseek4j 已开源](https://mp.weixin.qq.com/s?__biz=MjM5MzEwODY4Mw==&mid=2257490224&idx=1&sn=83b6771bf276c82df1b90df0bbc4721b&scene=21#wechat_redirect)

随着大语言模型(LLM)的蓬勃发展,Java 开发者一直在寻找合适的工具来将 LLM 能力集成到自己的应用中。今天为大家介绍一个重量级开源项目 - Jlama,这是一个专为 Java 设计的现代化 LLM 推理引擎。

Jlama 是什么?

Jlama 是一个开源的大型语言模型推理引擎,专门为 Java 生态系统打造。它允许开发者直接在 Java 应用中直接运行 LLM 推理,无需依赖外部服务(比如 ollama 、vllm 等)。

核心特点:

- 支持多种主流模型:Gemma、Llama、Mistral、Mixtral、Qwen2 等

- 基于 Java 20+ 构建,利用 Vector API 实现高性能推理

快速上手

1. 命令行使用

# 安装 jbang

curl -Ls https://sh.jbang.dev | bash -s - app setup

# 安装 Jlama CLI

jbang app install --force jlama@tjake

# 运行模型(支持 Web UI)

jlama restapi tjake/Llama-3.2-1B-Instruct-JQ4 --auto-download

2. Java 项目集成

在 pom.xml 中添加依赖

<dependency>

<groupId>com.github.tjake</groupId>

<artifactId>jlama-core</artifactId>

<version>${jlama.version}</version>

</dependency>

<dependency>

<groupId>com.github.tjake</groupId>

<artifactId>jlama-native</artifactId>

<!-- 这里不需要改,自动获取OS 架构 -->

<classifier>${os.detected.name}-${os.detected.arch}</classifier>

<version>${jlama.version}</version>

</dependency>

<!-- 本文使用 langchain4j 作为调用框架,所以需要添加以下依赖 -->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j</artifactId>

<version>1.0.0-beta1</version>

</dependency>

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-jlama</artifactId>

<version>1.0.0-beta1</version>

</dependency>

代码示例

ChatLanguageModel model = JlamaChatModel.builder()

.modelName("tjake/Llama-3.2-1B-Instruct-JQ4")

.temperature(0.7f)

.build();

ChatResponse response = model.chat(

UserMessage.from("Help me write a java version of the palindromic algorithm")

);

System.out.println("\n" + response.aiMessage().text());

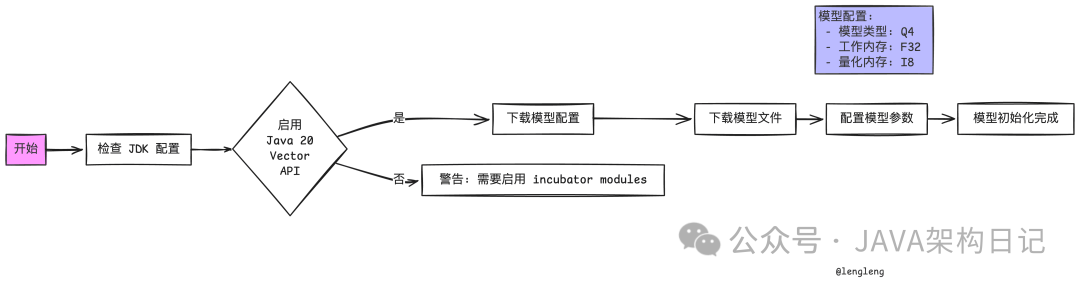

运行日志分享

INFO c.g.tjake.jlama.util.HttpSupport - Downloaded file: /Users/lengleng/.jlama/models/tjake_Llama-3.2-1B-Instruct-JQ4/config.json

INFO c.g.tjake.jlama.util.HttpSupport - Downloading file: /Users/lengleng/.jlama/models/tjake_Llama-3.2-1B-Instruct-JQ4/model.safetensors

WARNING: Using incubator modules: jdk.incubator.vector

INFO c.g.t.j.t.o.TensorOperationsProvider - Using Native SIMD Operations (OffHeap)

INFO c.g.tjake.jlama.model.AbstractModel - Model type = Q4, Working memory type = F32, Quantized memory type = I8

Here's a Java implementation of the Palindromic Algorithm:

...

执行过程流程图

特别说明

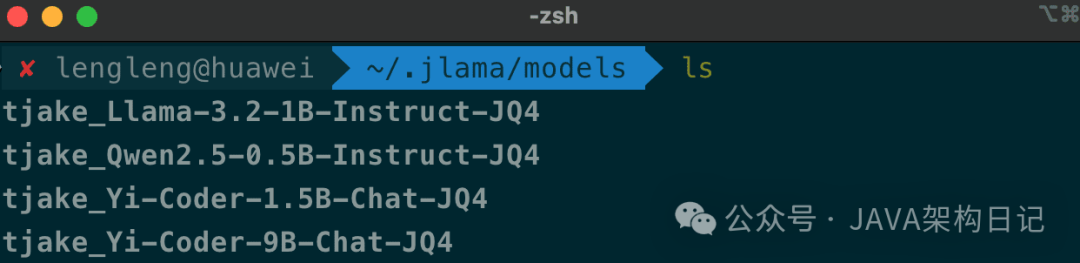

这里会实时去 huggingface 的下载模型文件 (需要魔法),如果下载失败,可以手动下载,然后放到 ~/.jlama/models 目录下。

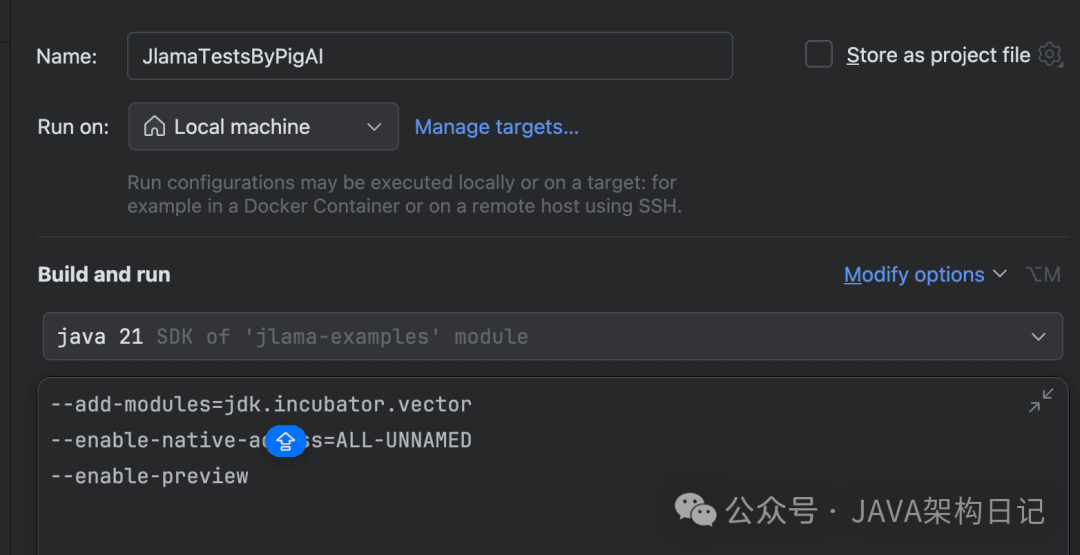

因为需要 jdk.incubator.vector 模块,所以需要使用 JDK20 及以上版本,并显示启用 jdk.incubator.vector 模块。

--add-modules=jdk.incubator.vector

--enable-native-access=ALL-UNNAMED

--enable-preview

总结

目前 Jlama 虽然提供的都是些小模型,适用于边缘设备应用场景 ,但 Jlama 让在 Java 生态中使用 LLM 变得更加简单和高效。无论是构建企业级应用还是开发创新项目,Jlama 都是一个值得关注的选择。

零基础入门AI大模型

今天贴心为大家准备好了一系列AI大模型资源,包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

有需要的小伙伴,可以点击下方链接免费领取【保证100%免费】

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

5.免费获取

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码或者点击以下链接都可以免费领取【保证100%免费】

更多推荐

已为社区贡献32条内容

已为社区贡献32条内容

所有评论(0)