深度学习-----缺乏可解释性

以下是张玉宏的《深度学习之美》阅读笔记.在深度学习中,经常有“end-to-end(端到端)”学习的提法,与之相对应的传统机器学习是“Divide and Conquer”(分而治之)。这些都是什么意思呢?“end-to-end”(端到端)“end-to-end”(端到端)说的是,输入的是原始数据(始端),然后输出的直接就是最终目标(末端),中间过程不可知,也难以知。比如,基于深度学习的...

以下是张玉宏的《深度学习之美》阅读笔记.

在深度学习中,经常有“end-to-end(端到端)”学习的提法,与之相对应的传统机器学习是“Divide and Conquer”(分而治之)。这些都是什么意思呢?

“end-to-end”(端到端)

“end-to-end”(端到端)说的是,输入的是原始数据(始端),然后输出的直接就是最终目标(末端),中间过程不可知,也难以知。

比如,基于深度学习的图像识别系统,输入端是图片的像素数据,而输出端直接就是或猫或狗的判定这个端到端就是,像素判定。

再比如,“end-to-end”的自动驾驶系统,输入的是前置摄像头的视频信号(其实也就是像素),而输出的直接就是控制车辆行驶的指令(方向盘的旋转角度)。这个端到端就是,像素-指令。

就此,有人批评深度学习就是一个黑箱(BlackBox)系统,其性能很好,却不知道为何好,也就是说,缺乏解释性。

深度学习在本质上属于可统计不可推理的范“可统计”是很容易理解的,就是说,对于同类数据,它具有一定的统计规律,这是一切统计学习的基本假设那“不可推理”又是什么意思?其实就是“剪不断、理还乱”的非线性状态。

从哲学上讲,这种非线性状态是具备了整体性的“复杂系统”,属于复杂性科学范畴。复杂性科认为构成复杂系统的各个要素自成体系,但阡陌纵横,其内部结构难以分割。简单来说,对于复杂系统,1+12,也就是说,一个简单系统加上另外一个简单系统,其效果绝不是两个系统的简单累加效应,因此,我们必须从整体上认识这样的复杂系统。

于是,在认知上,就有了从一个系统或状态(end)直接整体变迁到另外一个系统或状态(end)的形态。这就是深度学习背后的方法论。

“Divide and Conquer(分而治之)”

与之对应的是“Divide and Conquer(分而治之)”,其理念正好相反,在哲学中它属于“还原主义(Reduction,或称还原论)”。在这种方法论中,有一种“追本溯源”的蕴意包含于其内,即一个系统(或理论)无论多复杂,都可以分解分解再分解,直到能够还原到逻辑原点。

在还原主义中就是“1+1=2”,也就是说,一个复杂的系统,都可以由简单的系统叠加而成(可以理解为线性系统),如果各个简单系统的问题解决了,那么体的问题也就得以解决。

如,很多的经典力学问题,不论形式有多复杂,通过不断分解和还原,最后都可以通过牛顿的大定律得以解决。

从传统的“还原论”出发,单纯的线性组合思维,势必会导致在人工智能系统的设计上功能过于简单。如果我们希望模拟的是一个“类人”的复杂系统(即人工智能系统),自然就无法有效达到目的,具体来说,有如下两个方面的原因:

- 这个世界(特别是有关人的世界)本身是个纷繁复杂的系统,问题之间互相影响,形成复杂的网络,这样的复杂系统很难用个或几个简单的公式、定理来描述和界定。

- 在很多场景下,受现有测量和认知工具的局限,很多问题在认识上根本不具有完备性。因此,难以从一个“残缺”的认知中,提取适用于全局视角的公式和定理。

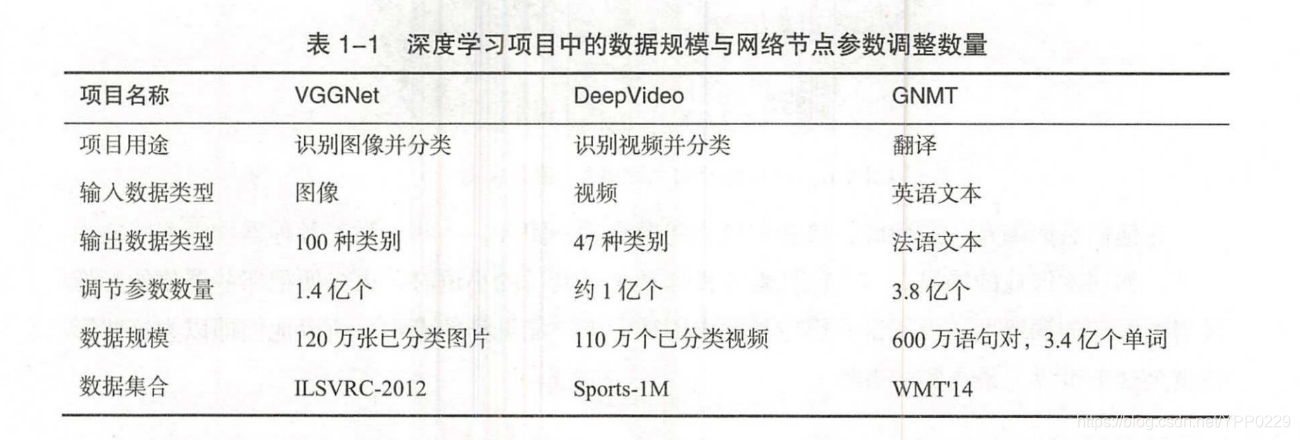

几个流行的深度学习项目中的参数细节,可以看到,深度学习网络本身就是一个训练数据巨大、调节参数数量巨多的复杂网络。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)