机器学习 监督学习论文_机器学习-无监督学习概论

无监督学习1 无监督学习基本原理无监督学习:从无标注的数据中学习数据的统计规律或者说内在结构的机器学习,主要包括聚类、降维、概率估计,对应的输出是类别,转换,概率无监督学习的模型:函数(硬聚类),条件概率分布(软聚类)或条件概率分布(概率模型估计)定义训练数据集:其中,表示第个向量的第维;;;训练数据可以用矩阵表示,矩阵的每一行对应特征,每一列对应一个样本2 聚类发现数据集中的纵向结构,输入空间为

无监督学习

1 无监督学习基本原理

无监督学习:从无标注的数据中学习数据的统计规律或者说内在结构的机器学习,主要包括聚类、降维、概率估计,对应的输出是类别,转换,概率

无监督学习的模型:函数

(硬聚类),条件概率分布

(硬聚类),条件概率分布

(软聚类)或条件概率分布

(软聚类)或条件概率分布

(概率模型估计)

(概率模型估计)

定义训练数据集

:

:

其中,

表示第

表示第

个向量的第

个向量的第

维;

维;

;

;

;

;

训练数据可以用

矩阵表示,矩阵的每一行对应特征,每一列对应一个样本

矩阵表示,矩阵的每一行对应特征,每一列对应一个样本

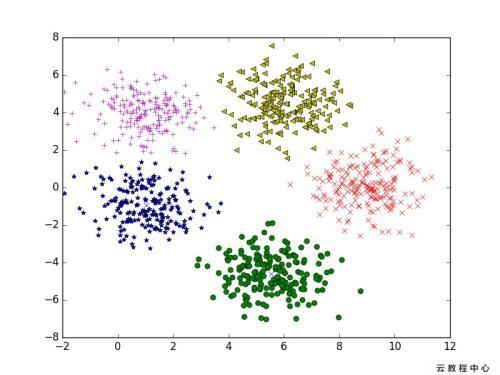

2 聚类

发现数据集

中的

中的

,输出空间为类别集合

,输出空间为类别集合

硬聚类:一个样本只能属于一个类,

软聚类:一个样本可以属于多个类,

3 降维

发现数据中的横向结构,输入空间为欧式空间

,输出空间同为欧式空间

,输出空间同为欧式空间

降维:

是样本的高维向量

是样本的高维向量

是样本的低维向量

是样本的低维向量

是参数

是参数

可以是线性函数,也可以是非线性函数

可以是线性函数,也可以是非线性函数

4 概率模型估计

训练数据由一个概率模型生成,由训练数据学习模型的结构和参数

概率模型包括混合模型(高斯混合模型等)和概率图模型(有向图模型、无向图模型)等

概率模型可以表示为

其中

表示观测数据,可以是连续变量也可以是离散变量;

表示观测数据,可以是连续变量也可以是离散变量;

表示隐式结构,是离散变量;当模型是混合模型时,

表示隐式结构,是离散变量;当模型是混合模型时,

表示成分的个数,当模型是概率图模型时,

表示成分的个数,当模型是概率图模型时,

表示图的结构;随机变量

表示图的结构;随机变量

表示参数;

表示参数;

软聚类也可以看作概率估计的问题,根据贝叶斯公式:

其中,先验

服从均匀分布,故只需估计出条件概率

服从均匀分布,故只需估计出条件概率

进行软聚类

进行软聚类

5 聚类算法三要素

- 模型:

函数 (硬聚类),条件概率分布

(硬聚类),条件概率分布

(软聚类)或条件概率分布

(软聚类)或条件概率分布

(概率模型估计)

(概率模型估计)

- 策略聚类样本与所属类别中心距离的最小化,降维过程信息损失的最小化,概率模型估计过程中生成数据概率的最大化

- 算法

通常是迭代算法,如梯度下降

无监督分类:

硬聚类:层次聚类法、k均值聚类

软聚类:高斯混合模型EM算法

降维:主成分分析、奇异值分解、潜在语义分析

概率模型估计方法:概率潜在语义分析、潜在狄利克雷分配

话题分析:

话题分析是文本分析的一种技术。给定一个文本集合,话题分析旨在发现文本集合中每个文本的话题,而话题由单词的集合表示。前提是有足够数量的文本。

话题分析可以形式化为:概率模型估计问题和降维问题。

话题分析方法:潜在语义分析、概率潜在语义分析、潜在狄利克雷分配、马尔可夫链蒙特卡罗法。

话题表示为单词的概率分布,文本表示为话题的概率分布。直观上,一个话题包含语义相似的单词,一个文本表示若干个话题。

图分析:

图数据表示实体之间的关系,图分析目的是发掘隐藏在图中的统计规律和潜在结构,链接分析是图分析的一种,如Pagerank算法。

Pagerank算法是求解马尔可夫链(在图上的随机游走)的平稳分布。一个节点的平稳分布(节点的Pagerank值)表示该节点的重要性。

参考

- 李航-统计学习方法

- 李航-统计学习方法笔记:https://github.com/SmirkCao/Lihang

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)